系列文章目录

【模型部署】人脸检测模型DBFace C++ ONNXRuntime推理部署(0)

【模型部署】人脸检测模型DBFace C++ ONNXRuntime推理部署(1)

【模型部署】人脸检测模型DBFace C++ ONNXRuntime推理部署(2)

1 背景

目前,随着应用场景不断丰富、算法部署技术成熟、计算平台算力增长,深度学习模型工程落地需求巨大,模型的端侧部署很有必要。

DBFace官方给出了Pytorch训练以及NCNN移动端部署的代码,所以我在此基础上使用ONNXRuntime (ORT)推理引擎进行部署。

1.1 ONNXRuntime简介

ONNX Runtime是一个开源项目,旨在跨广泛的框架、操作系统和硬件平台加速机器学习。它可以使用一组API加速跨所有部署目标的机器学习推断。ONNX Runtime会自动解析您的模型,以确定优化方式,并提供对可用最佳硬件加速的访问。它适用于Linux,Windows和Mac上ONNX格式的机器学习模型的高性能推理引擎。ONNX Runtime在设计上是轻量级和模块化的,CPU的构建只有几M字节。可扩展架构、优化硬件加速器,降低计算延时,提升计算效率。

ONNX是一种针对机器学习所设计的开放式的文件格式,用于存储训练好的模型。它使得不同的人工智能框架(如Pytorch, MXNet)可以采用相同格式存储模型数据并交互。 ONNX的规范及代码主要由微软,亚马逊 ,Facebook 和 IBM 等公司共同开发,以开放源代码的方式托管在Github上。目前官方支持加载ONNX模型并进行推理的深度学习框架有: Caffe2, PyTorch, MXNet,ML.NET,TensorRT 和 Microsoft CNTK,并且 TensorFlow 也非官方的支持ONNX。

1.2 DBFace介绍

DBFace模型出自国内人工智能公司深兰科技(DeepBlue)下属深兰科学院算法研究所 。DBFace的初衷是设计成一款轻量级的人脸检测器,能够在边缘计算上有效的使用,而疫情时期的特殊需求,也使得对于hard类(例如戴上口罩)人脸检测势在必行。因为CenterNet具有后处理的简洁高效性,以及对小目标友好等特点,在综合性能和速度的考虑下,我们选择了CenterNet结构做检测任务,采用MoblienetV3做Backbone。相较于MobilenetV2,MobilenetV3在其基础上新增了 SE 、Hard-Swish Activation等模块,在兼顾Infernce速度的同时提升网络性能 。官方文档说明:https://github.com/dlunion/DBFace。

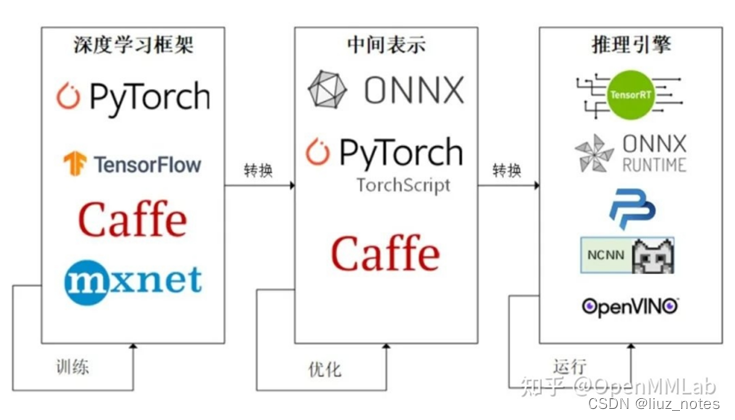

2 模型部署基本流程

1、使用某种深度学习框架训练模型,目前pytorch支持的算子更多一些,所以一般建议用pytorch训练模型,省得自己手捏算子。

2、导出模型为中间表示,pytorch有torch.onnx.export()直接转为ONNX,其本身也有TorchScript表示形式。

3、用ORT载入onnx模型并推理。ORT提供了多种语言接口,如python、java、C++。本系列博客将介绍用python和C++ API进行推理的基本操作。

3 推理结果

3.1 可视化检测结果

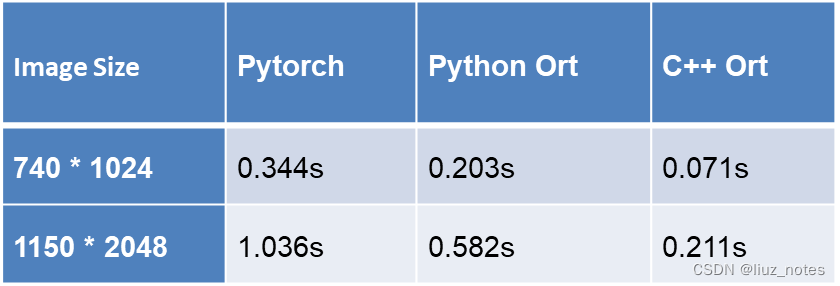

3.2 推理时间

不同尺度输入图像推理时间比较:

参考资料

- ONNXRuntime官方网站及文档:https://onnxruntime.ai/

- DBFace官方开源代码:https://github.com/dlunion/DBFace

- 模型部署入门教程:https://zhuanlan.zhihu.com/p/477743341

- ONNX官方算子支持查询文档:https://github.com/onnx/onnx/blob/main/docs/Operators.md ------ 重要

- Pytorch对ONNX的算子支持查询文档:https://github.com/pytorch/pytorch/tree/master/torch/onnx ------ 重要

- ONNX对python的api文档:https://github.com/onnx/onnx/blob/main/docs/PythonAPIOverview.md

- torch.onnx教程:https://github.com/pytorch/pytorch/blob/onnx_ms_1/docs/source/onnx.rst

- onnxruntime对C/C++和移动端部署的官方例程:https://github.com/microsoft/onnxruntime-inference-examples

- ONNXRuntime C++/Java/Python 项目实操资料:https://zhuanlan.zhihu.com/p/414317269 ------ 重要

- 深度学习模型部署资料汇总:https://www.zhihu.com/question/447224038/answer/2343992948

- ONNX模型结构定义与存储格式:https://zhuanlan.zhihu.com/p/371177698

- MMDeploy官方文档:https://mmdeploy.readthedocs.io/zh_CN/latest/

- lite.ai.toolkit中文文档:https://github.com/DefTruth/lite.ai.toolkit/blob/main/README.zh.md

- lite.ai.toolkit代码结构介绍https://github.com/DefTruth/lite.ai.toolkit/blob/main/docs/contrib/CONTRIBUTING.zh.md

- ONNXRuntime基础系列博客:https://www.zhihu.com/column/c_1465386797895593984

- NCNN资料合计:https://zhuanlan.zhihu.com/p/449765328 --------- 重要

1673

1673

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?