一、简述

本文主要介绍FFmpeg 编程中用到的基础知识,包含常见音视频概念,常用API函数,常用结构体,解封装流程,解复用器流程以及注册等。

二、常见音视频概念

-

容器/文件( Conainer/File):特定格式的多媒体文件,比如mp4、 flv、 mkv等。

-

媒体流( Stream):表示时间轴上的一段连续数据,比如一段声音、一段视频或一段字幕;数据可以是压缩的,也可以是非压缩的,其中压缩的数据需要关联特定的编解码器。

-

数据帧/数据包(Frame/Packet):一般一个媒体流是由大量的数据帧组成的,对于压缩数据,帧对应着编解码器的最小处理单元,分属于不同媒体流的数据帧交错存储于容器之中。

-

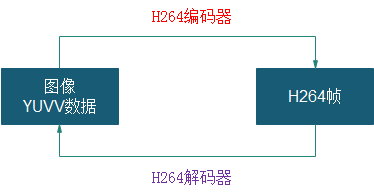

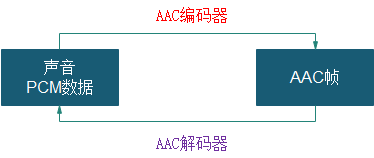

编解码器:编解码器是以帧为单位实现压缩数据和原始数据之间相互转换的。

-

复用器:音频流、视频流、字母流以及其他成分,按照一定的规则组合成视频文件(MP4/flv)。

-

解复用器:视频文件(MP4/flv)按照一定的规则拆分成,音频流、视频流、字母流以及其他成分。

-

视频编解码器 【示意 图1】

-

音频编解码器 【示意 图2】

三、常见库

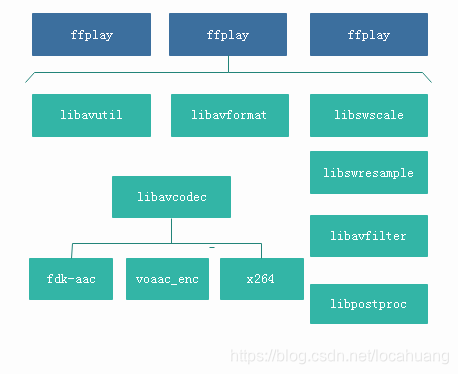

1、ffmpeg整体结构【示意 图3】

2、常用库

-

AVUtil:核心工具库,下面的许多其他模块都会依赖该库做一些基本的音视频处理操作。

-

AVFormat:文件格式和协议库,该模块是最重要的模块之一,封装了Protocol层和Demuxer、 Muxer层,使得协议和格式对于开发者来说是透明的。

-

AVCodec:编解码库,封装了Codec层,但是有一些Codec是具备自己的License的, FFmpeg是不会默认添加像libx264、 FDK-AAC等库的,但是FFmpeg就像一个平台一样,可以将其他的第三方的Codec以插件的方式添加进来,然后为开发者提供统一的接口。

-

AVFilter:音视频滤镜库,该模块提供了包括音频特效和视频特效的处理,在使用FFmpeg的API进行编解码的过程中,直接使用该模块为音视频数据做特效处理是非常方便同时也非常高效的一种方式。

-

AVDevice:输入输出设备库,比如,需要编译出播放声音或者视频的工具ffplay,就需要确保该模块是打开的,同时也需要SDL的预先编译,因为该设备模块播放声音与播放视频使用的都是SDL库。

-

SwrRessample:该模块可用于音频重采样,可以对数字音频进行声道数、数据格式、采样率等多种基本信息的转换。

-

SWScale:该模块是将图像进行格式转换的模块,比如,可以将YUV的数据转换为RGB的数据,缩放尺寸由1280720变为800480。

-

PostProc:该模块可用于进行后期处理,当我们使用AVFilter的时候需要打开该模块的开关,因为Filter中会使用到该模块的一些基础函数。

四、常用API函数

1、注册、初始化相关函数

-

avdevice_register_all():对设备进行注册,如V4L2。

-

avformat_network_init():初始化网络库,以及网络加密协议相关的库,如openSSL。

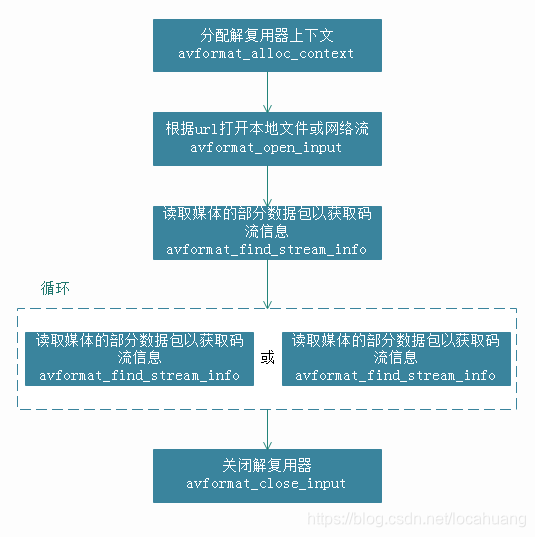

2、封装格式相关函数

-

avformat_alloc_context():申请一个AVFormatContext结构的内存,并进行简单初始化。

-

avformat_free_context():释放AVFormatContext结构的内存。

-

avformat_close_input():关闭解复用器;关闭后就不再需要使用avformat_free_context()进行释放。

-

avformat_open_input():打开输入视频文件。

-

avformat_find_stream_info():获取音视频文件信息。

-

av_read_frame():读取音视频包。

-

avformat_seek_file():定位文件。

-

av_seek_frame():定位文件。

【解封装应用流程 图4】

3、解码器相关函数

-

avcodec_alloc_context3():分配解码器上下文。

-

avcodec_find_decoder():根据ID查找解码器。

-

avcodec_find_decoder_by_name():根据解码器名字查找解码器。

-

avcodec_open2():打开编解码器。

-

avcodec_send_packet():发送给编码数据包。

-

avcodec_receive_frame():接收解码后数据。

-

avcodec_free_context():释放解码器上下文,包含了avcodec_close()。

-

avcodec_close():关闭解码器。

【解码应用流程 图5】

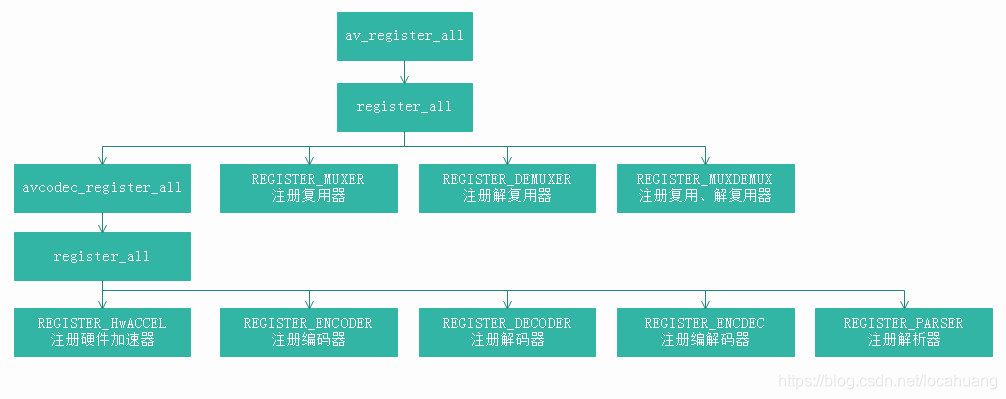

五、组件注册

不同版本的FFmpeg,组件注册方式还稍微有些不一样。3.x版本需要用户调用API函数完成注册操作;4.x版本开始,无需要用户调用API进行注册。

1、FFmpeg 3.x组件注册方式

3.x版本使用ffmpeg,先要执行av_register_all(4.0后已弃用),把全局的解码器、编码器等结构体注册到各自全局的对象链表里,以便后面查找调用。

【3.x 组件注册 图6】

2、FFmpeg 4.x组件注册方式

ffmpeg内部做的注册,不需要用户调用API完成注册。

以codec编解码器为例:

-

1)在configure的时候生成要注册的组件

./configure:7203:print_enabled_components libavcodec/codec_list.c

AVCodec codec_list $CODEC_LIST

这里会生成一个codec_list.c 文件,里面只有static const AVCodec *const codec_list[]数组。 -

2)在libavcodec/allcodecs.c将 static const AVCodec * const codec_list[] 的编解码器用链表的方式组织起来。

3、FFmpeg 4.0.2 组件注册方式

ffmpeg内部做的注册,不需要用户调用API完成注册。

对于demuxer/muxer(解复用器,也称容器)则对应:

-

1)libavformat/muxer_list.c,libavformat/demuxer_list.c 这两个文件也是在configure的时候生成,也就是说直接下载源码是没有这两个文件的。

-

2)在libavformat/allformats.c将demuxer_list[]和muexr_list[]以链表的方式组织。

六、常用数据结构

1、AVFormatContext

封装格式上下文结构体,也是统领全局的结构体,保存了视频文件封装格式相关信息。

- iformat:输入媒体的AVInputFormat,比如指向AVInputFormat ff_flv_demuxer

- nb_streams:输入媒体的AVStream 个数

- streams:输入媒体的AVStream []数组

- duration:输入媒体的时长(以微秒为单位),计算方式可以参考av_dump_format()函数。

- bit_rate:输入媒体的码率

2、AVInputFormat

每种封装格式(例如FLV, MKV, MP4, AVI)对应一个该结构体。

- name:封装格式名称

- extensions:封装格式的扩展名

- id:封装格式ID

- 一些封装格式处理的接口函数,比如read_packet()

3、AVStream

视频文件中每个视频(音频)流对应一个该结构体。

- index:标识该视频/音频流

- time_base:该流的时基, PTS*time_base=真正的时间(秒)

- avg_frame_rate: 该流的帧率

- duration:该视频/音频流长度

- codecpar:编解码器参数属性

4、AVCodecParameters

- codec_type:媒体类型,比如AVMEDIA_TYPE_VIDEO AVMEDIA_TYPE_AUDIO等

- codec_id:编解码器类型, 比如AV_CODEC_ID_H264AV_CODEC_ID_AAC等。

5、AVCodecContext

编解码器上下文结构体,保存了视频(音频)编解码相关信息。

- codec:编解码器的AVCodec,比如指向AVCodec ff_aac_latm_decoder

- width, height:图像的宽高(只针对视频)

- pix_fmt:像素格式(只针对视频)

- sample_rate:采样率(只针对音频)

- channels:声道数(只针对音频)

- sample_fmt:采样格式(只针对音频)

6、AVCodec

每种视频(音频)编解码器(例如H.264解码器)对应一个该结构体。

- name:编解码器名称

- type:编解码器类型

- id:编解码器ID

- 一些编解码的接口函数,比如int (*decode)()

7、AVPacket

存储一帧压缩编码数据。

- pts:显示时间戳

- dts:解码时间戳

- data:压缩编码数据

- size:压缩编码数据大小

- pos:数据的偏移地址

- stream_index:所属的AVStream

8、AVFrame

存储一帧解码后像素(采样)数据。

- data:解码后的图像像素数据(音频采样数据)

- linesize:对视频来说是图像中一行像素的大小;对音频来说是整个音频帧的大小

- width, height:图像的宽高(只针对视频)

- key_frame:是否为关键帧(只针对视频) 。

- pict_type:帧类型(只针对视频) 。例如I, P, B

- sample_rate:音频采样率(只针对音频)

- nb_samples:音频每通道采样数(只针对音频)

- pts:显示时间戳

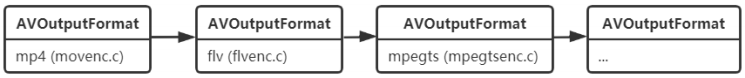

9、AVOutputFormat

1)描述

AVOutputFormat 表示输出文件容器格式,AVOutputFormat结构主要包含的信息有:

- 封装名称描述

- 编码格式信息(video/audio 默认编码格式,支持的编码格式列表)

- 对封装的操作函数(write_header,write_packet,write_tailer等)

ffmpeg支持各种各样的输出文件格式,MP4,FLV,3GP等。

AVOutputFormat结构保存了这些格式的信息和一些常规设置。

每一种封装对应一个AVOutputFormat结构,ffmpeg将AVOutputFormat按照链表存储:

2)常见变量及其作用

const char *name; // 复⽤器名称

const char *long_name;//格式的描述性名称,易于阅读。

enum AVCodecID audio_codec; //默认的⾳频编解码器

enum AVCodecID video_codec; //默认的视频编解码器

enum AVCodecID subtitle_codec; //默认的字幕编解码器

大部分复用器都有默认的编码器,所以如果要调整编码器类型则需要自己手动指定。

比如:

AVOutputFormat ff_flv_muxer = {

.name = "flv",

.audio_codec = CONFIG_LIBMP3LAME ? AV_CODEC_ID_MP3 : AV_CODEC_ID_ADPCM_SWF, // 默认了MP3

.video_codec = AV_CODEC_ID_FLV1,

....

};

AVOutputFormat ff_mpegts_muxer = {

.name = "mpegts",

.extensions = "ts,m2t,m2ts,mts",

.audio_codec = AV_CODEC_ID_MP2,

.video_codec = AV_CODEC_ID_MPEG2VIDEO,

....

};

int (*write_header)(struct AVFormatContext *);

int (*write_packet)(struct AVFormatContext *, AVPacket *pkt);//写一个数据包。 如果在标志中设置AVFMT_ALLOW_FLUSH,则pkt可以为NULL。

int (*write_trailer)(struct AVFormatContext *);

int (*interleave_packet)(struct AVFormatContext *, AVPacket *out, AVPacket *in, int flush);

int (*control_message)(struct AVFormatContext *s, int type, void *data, size_t data_size);//允许从应用程序向设备发送消息。

int (*write_uncoded_frame)(struct AVFormatContext *, int stream_index, AVFrame **frame,unsigned flags);//写一个未编码的AVFrame。

int (*init)(struct AVFormatContext *);//初始化格式。 可以在此处分配数据,并设置在发送数据包之前需要设置的任何AVFormatContext或AVStream参数。

void (*deinit)(struct AVFormatContext *);//取消初始化格式。

int (*check_bitstream)(struct AVFormatContext *, const AVPacket *pkt);//设置任何必要的比特流过滤,并提取全局头部所需的任何额外数据。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?