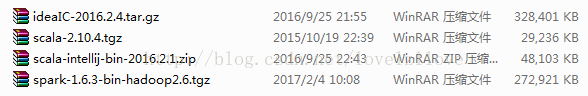

1、上传解压压缩包,包括spark 和 scala 的压缩包,解压到/home/hadoop/apps目录下

2、修改conf 目录下配置文件

a. 修改 slaves 文件,( 若没有 slaves 文件可以 cp slaves.template slaves 创建),

添加 worker 节点的 Hostname, 修改后内容如下:

# A Spark Worker will be started on each of the machines listed below.

hadoop04

hadoop05

hadoop06

b. 配置 spark-env.sh, ( 若没有该文件可以 cp spark-env.sh.template spark-env.sh

创建) , 添加如下内容:

export JAVA_HOME=/usr/local/jdk1.8.0_73/

export SCALA_HOME=/home/hadoop/apps/scala-2.10.4

export HADOOP_HOME=/home/hadoop/apps/hadoop-2.6.4

export HADOOP_CONF_DIR=/home/hadoop/apps/hadoop-2.6.4/etc/hadoop

export SPARK_MASTER_IP=hadoop05

export SPARK_WORKER_MEMORY=1g

c.修改 .bash_profile文件

export SPARK_HOME=/home/hadoop/apps/spark-1.6.3

export PATH=$PATH:$SPARK_HOME/bin:$SPARK_HOME/sbin

export SCALA_HOME=/home/hadoop/apps/scala-2.10.4

export PATH=$PATH:$SCALA_HOME/bin

3、把修改配置后的安装包分发到其它节点上,

并且统一执行命令: source .bash_profile

4、启动并验证 spark 集群:

Spark 只是一个计算框架, 并不提供文件系统功能, 故我们需要首先启动文件系统 hdfs; 在 standalone 模式下, 我们并不需要启动 yarn 功能。

a. 用 start-dfs.sh 启动 hdfs

b. 在 hadoop 集群启动成功的基础上,启动 spark 集群,常见的做法是在 master节点上的

apps/spark-1.6.3/sbin 的目录下执行命令:start-all.sh

c、使用 jps 在 master 和 worker 节点上验证 spark 集群是否正确启动

使用 scala -version 命令,测试scala是否安装成功;使用scala 就可以进入scala的命令行

d、通过 webui 查看 spark 集群是否启动成功: http://hadoop05:8080

2572

2572

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?