免费获取:历史最全-大型语言模型数据集-全面综述及444个数据集分享,涵盖预训练、指令微调、偏好、评估

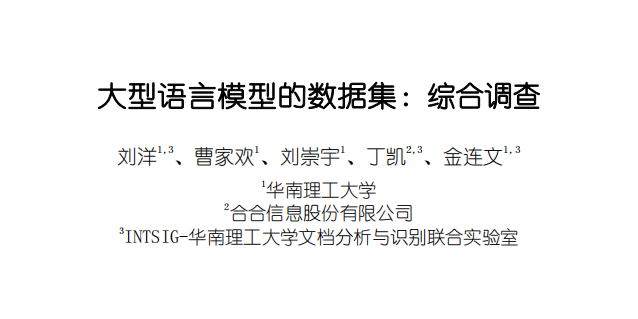

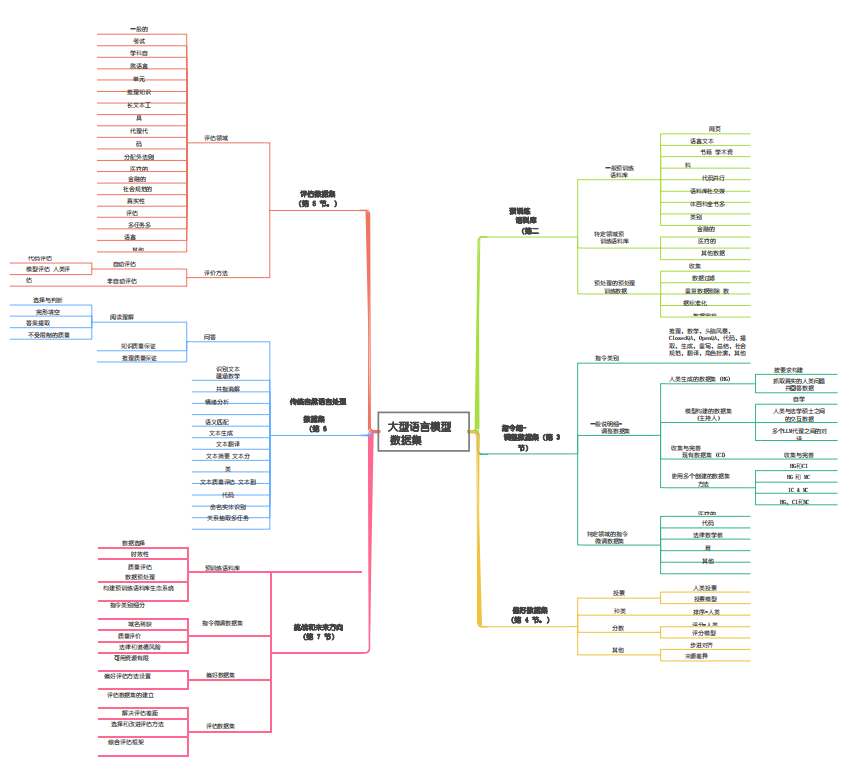

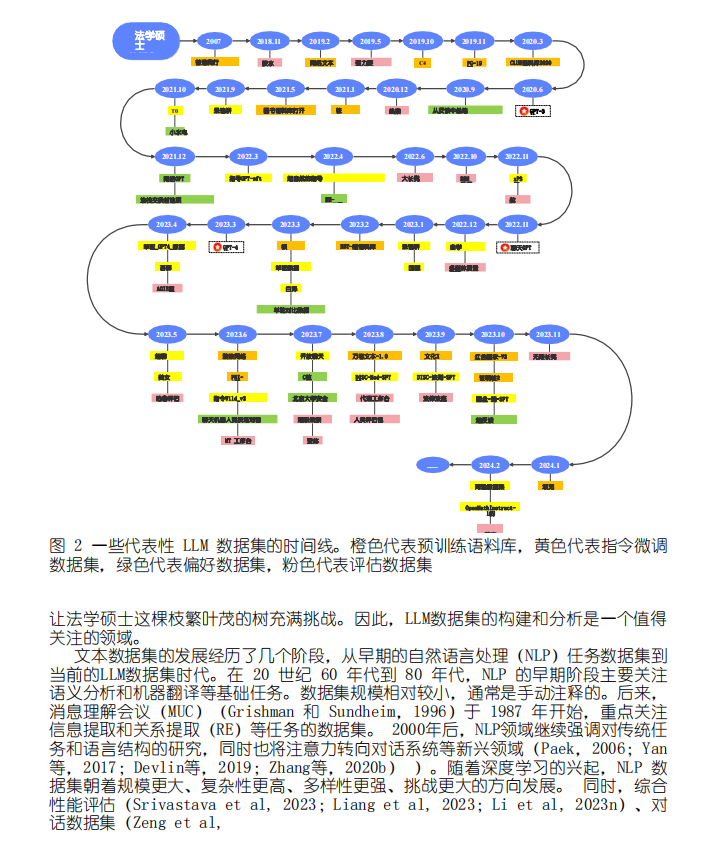

因此,对这些数据集进行审查成为研究的一个重要主题。为了解决当前LLM数据集缺乏全面概述和深入分析的问题,从五个角度对LLM数据集的基本面进行了整合和分类:(1)预训练语料库;(2)指令微调数据集;(3)偏好数据集;(4)评估数据集;(5)传统自然语言处理(NLP)数据集。该调查揭示了当前面临的挑战,并指出了未来研究的潜在途径。此外,还提供了对现有可用数据集资源的全面回顾,包括来自444个数据集的统计数据,涵盖8个语言类别,涉及32个领域。数据集统计中包含了20个维度的信息。预训练语料库的总数据量超过774.5 TB,其他数据集包含超过7亿个实例。我们的目标是展示法学硕士文本数据集的整体概况,为该领域的研究人员提供全面的参考,并为未来的研究做出贡献。

1864

1864

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?