最近这几天,许多网友都在各大平台上分享如何使用llama3的方法。这个开源大模型几天前刚刚才由Meta发布。本次发布Metat共提供了两个版本的Llama 3 ,8B 版本适合在消费级 GPU 上高效部署和开发;70B 版本则专为大规模 AI 应用设计。每个版本都包括基础和指令调优两种形式。所有版本均可在各种消费级硬件上运行,并具有 8000 Token 的上下文长度。

下面介绍llama3的几种部署使用方式!

首先是第一种部署llama3的方法,您可以直接采用在GitHub网站上提供的llama3部署方法。具体步骤如下:第一步,从GitHub上下载llama3的源代码到您的本地电脑。

git clone https://github.com/meta-llama/llama3``cd ./llama3

第二步,在本地电脑上建立一个python虚拟环境并将其激活,

python -m venv venv #建立虚拟环境``./venv/Scripts/activate #激活虚拟环境

第三步,安装项目依赖

pip install -e .``pip3 install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu118

第四步,获取meta提供的llama3的大模型

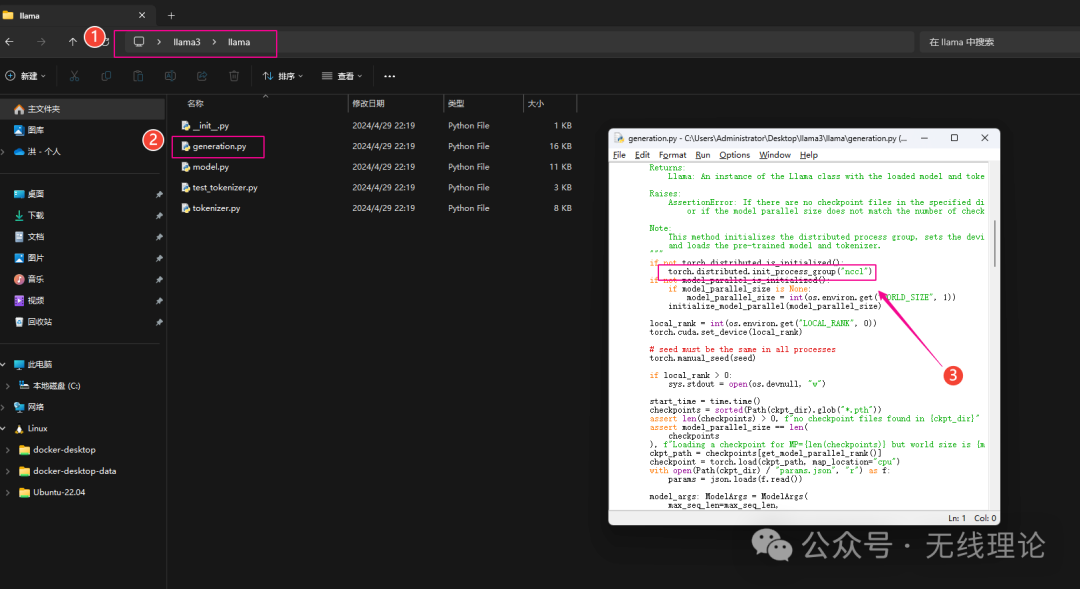

第五步,为llama3配置运行环境;首先找到并打开下图所示的文件,

在文件内搜索下面的程序段:

torch.distributed.init_process_group("nccl")

并将其修改为:

torch.distributed.init_process_group("gloo")

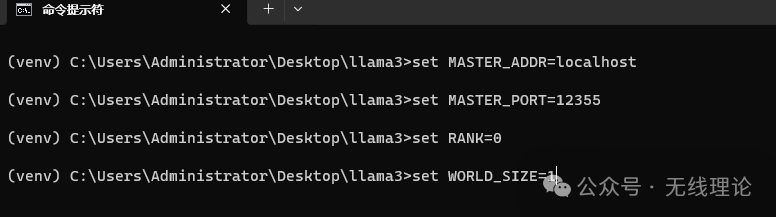

保存后退出文件,随后在windows终端依次输入下面的指令来配置几个临时的环境变量:

set MASTER_ADDR=localhost``set MASTER_PORT=12355``set RANK=0``set WORLD_SIZE=1

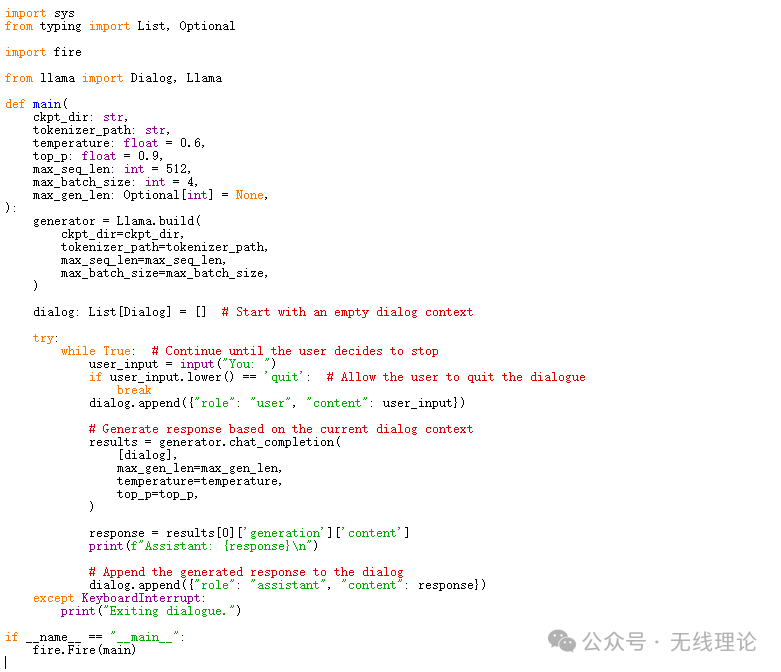

第六步,新建一个名为chat的py文件,并在该文件内粘贴下图所示的程序代码(如果无法想获取源代码,可以在本文结尾领取),

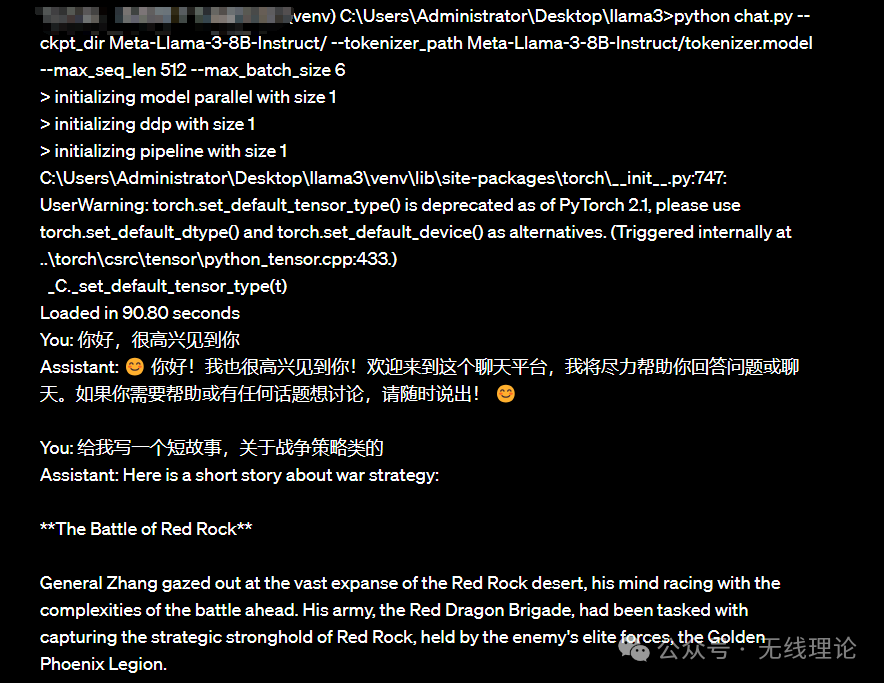

第七步,输入下面的指令来运行llama3项目

python chat.py --ckpt_dir Meta-Llama-3-8B-Instruct/ --tokenizer_path Meta-Llama-3-8B-Instruct/tokenizer.model --max_seq_len 512 --max_batch_size 6

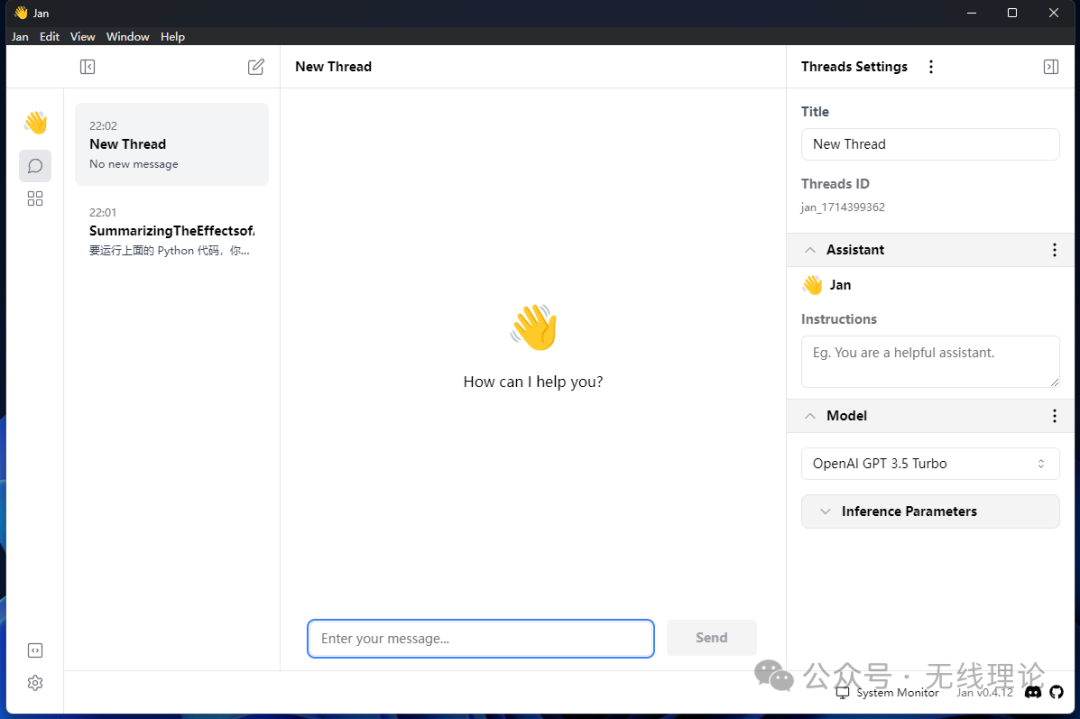

第二种方式,使用Jan来运行llama3项目,

Jan是一款开源、自托管的聊天GPT替代品,可以100%离线在您的计算机上运行。Jan提供可定制的AI助手、全局热键和内联AI等功能,可以提高您的生产力。Jan支持在本地主机上提供OpenAI等价API服务器,可以与兼容的应用程序一起使用。Jan的对话、偏好和模型使用等数据都保留在您的计算机上,安全、可导出,并可随时删除。

第一步,为确保llama3在jan上正常运行,请首先通过以下链接将jan下载到您的本地电脑上:

https://github.com/janhq/jan/releases/download/v0.4.12/jan-win-x64-0.4.12.exe

随后在本地电脑上完成jan的安装,

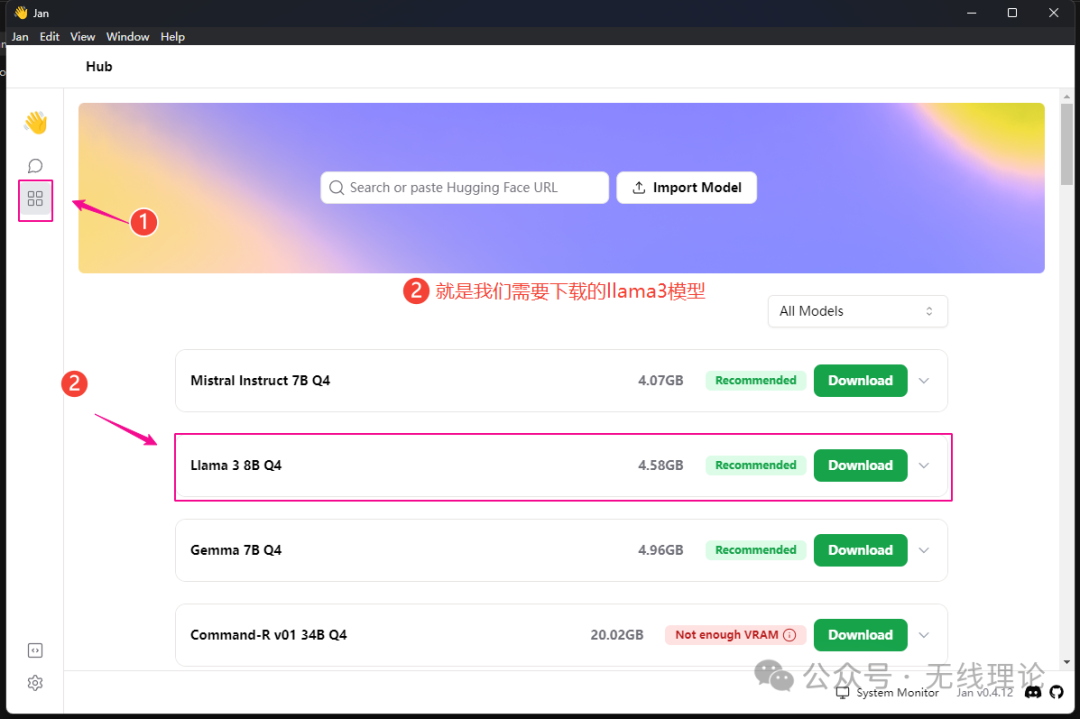

第二步,下载llama3模型。在jan平台上运行的llama3模型需要是GGUF文件格式。实际上,jan平台我们不仅可以下载llama3模型,我们还可以下载其他类型的模型;

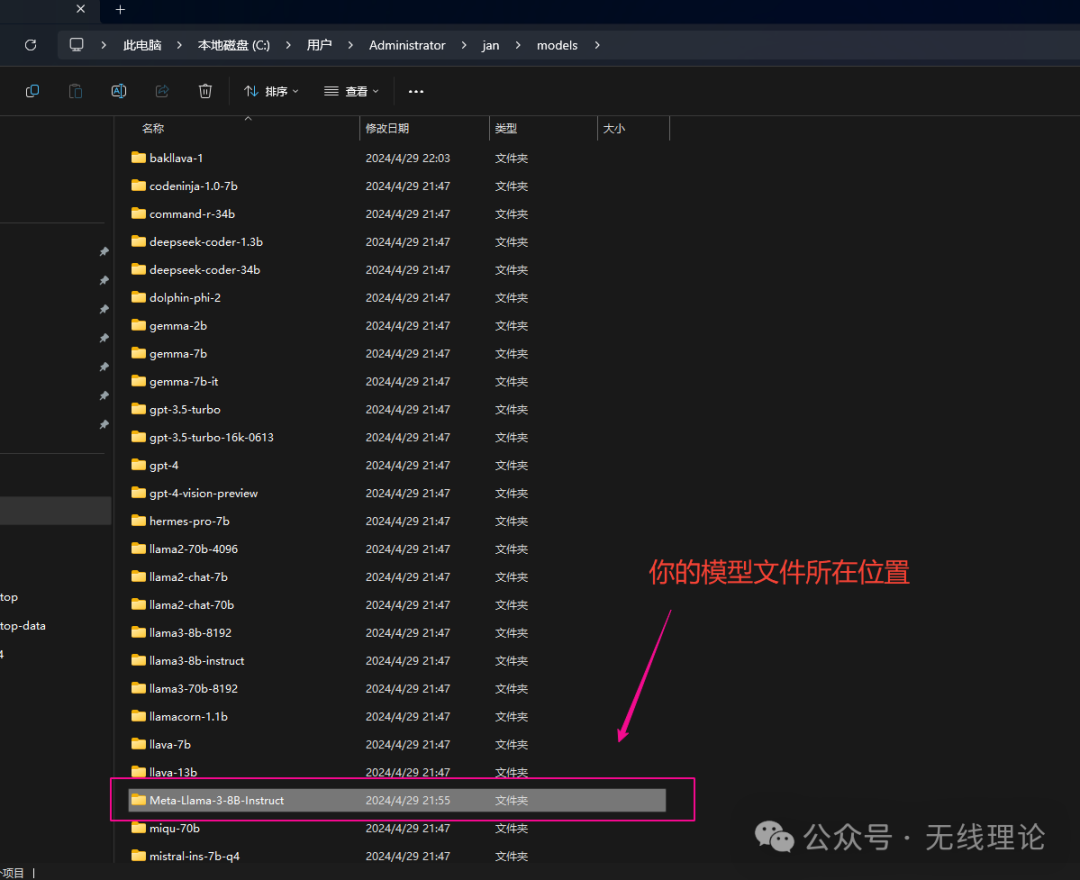

如果因网络问题无法成功下载模型,本文末尾将提供一个直接下载llama3模型的替代方法。下载模型后,您需要将其存放在以下路径中。【请注意,路径中的‘Administrator’代表计算机名;您应将其替换为自己的计算机名。】

C:\Users\Administrator\jan\models

如下所示:

第三步,使用jan提供的平台与llama3大模型展开正常聊天,

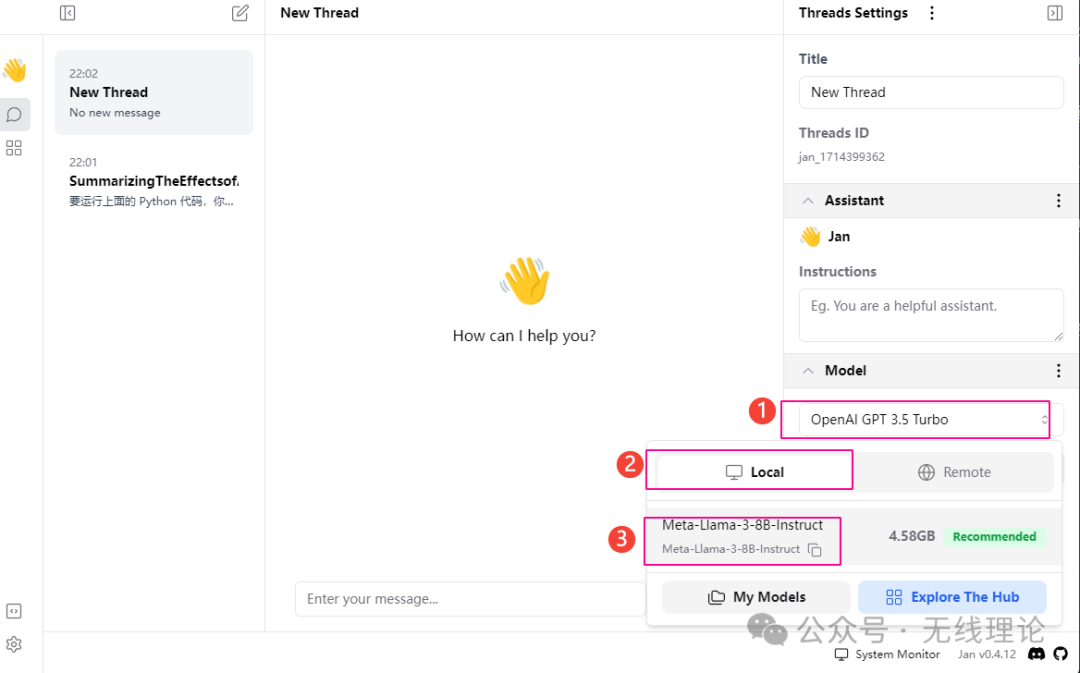

首先将你的llama3模型加载进来,按照下图演示的步骤依次完成模型的载入,

最后就是与大模型的正常聊天了

第三种方式,使用GPT4All来部署运行llama3

GPT4All是一个免费开源的大型语言模型项目,用户可以在本地部署,不仅支持GPU,也可以在CPU上运行,支持离线使用。这使得更多的用户能够接触和使用LLM模型,从而推动人工智能技术的发展。

GPT4All的下载地址如下

windows电脑下载链接:``https://github.com/nomic-ai/gpt4all/releases/download/v2.7.4/gpt4all-installer-win64-v2.7.4.exe``Mac电脑下载链接:``https://github.com/nomic-ai/gpt4all/releases/download/v2.7.4/gpt4all-installer-darwin-v2.7.4.dmg

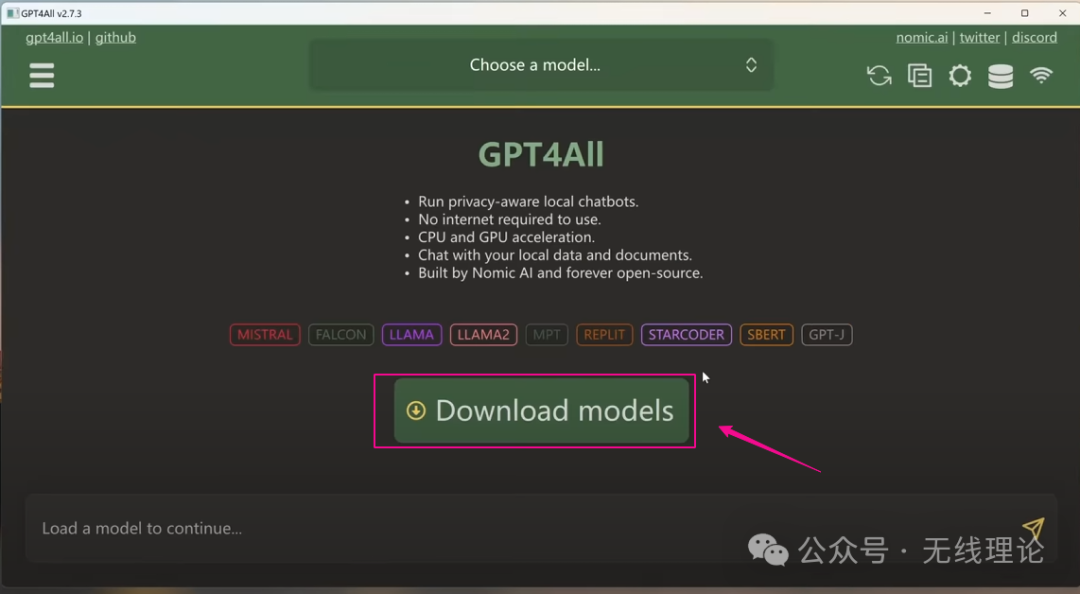

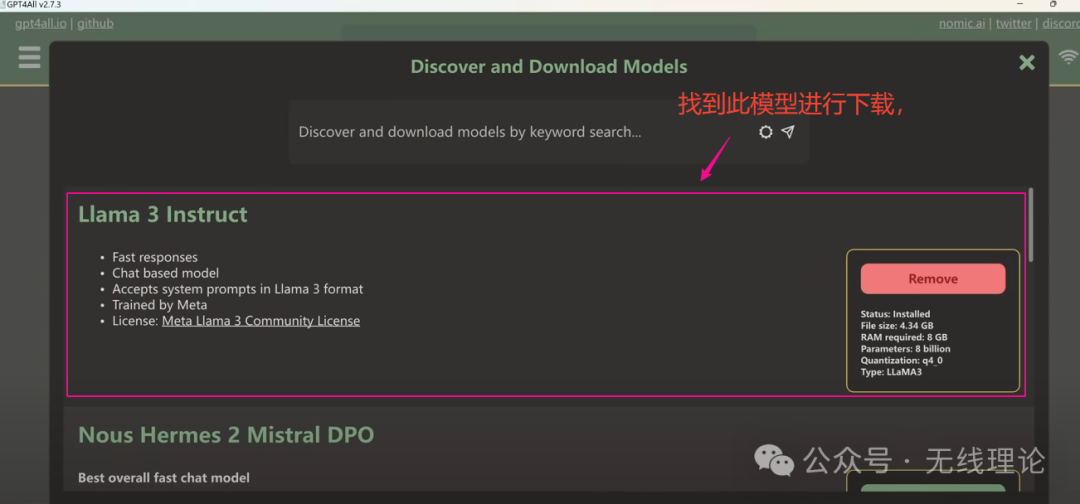

在完成GPT4All应用的安装后,点击Download按钮,进入下载页面:

找到Llama3模型并将其下载到本地

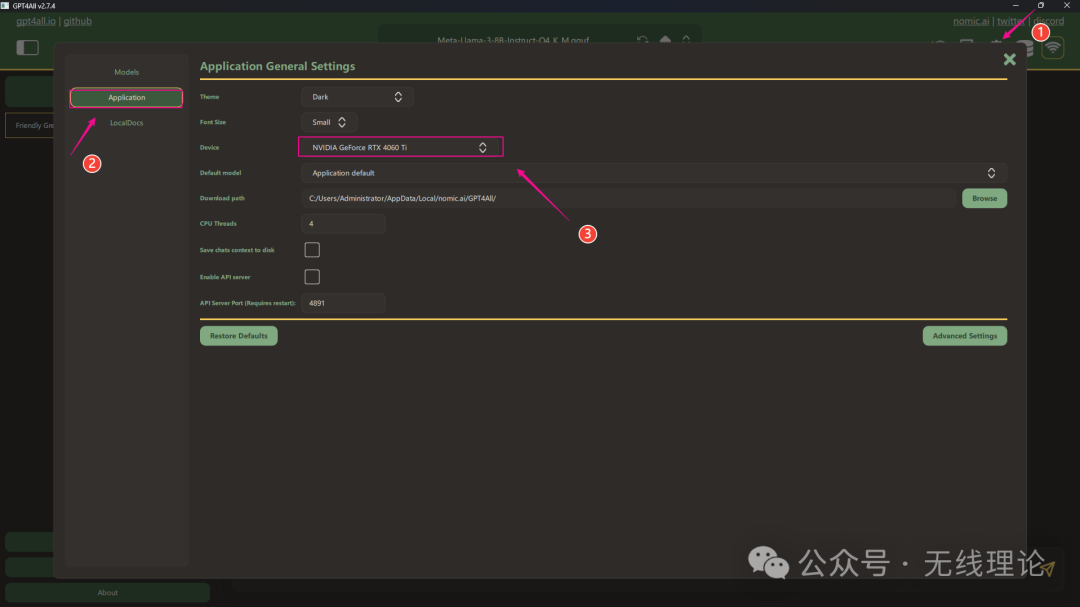

同样,如果在下载过程中因为网络问题而无法下载成功,那么方式2中用到的llama3模型在这里同样可以适用,因为jan和GPT4All都用的是同一种类型的模型。如果你的设备拥有GPU,那么你可以设置GPU为运行项目的首选项,这样以后你就能更加高效的运行大模型了,具体做法如下所示:

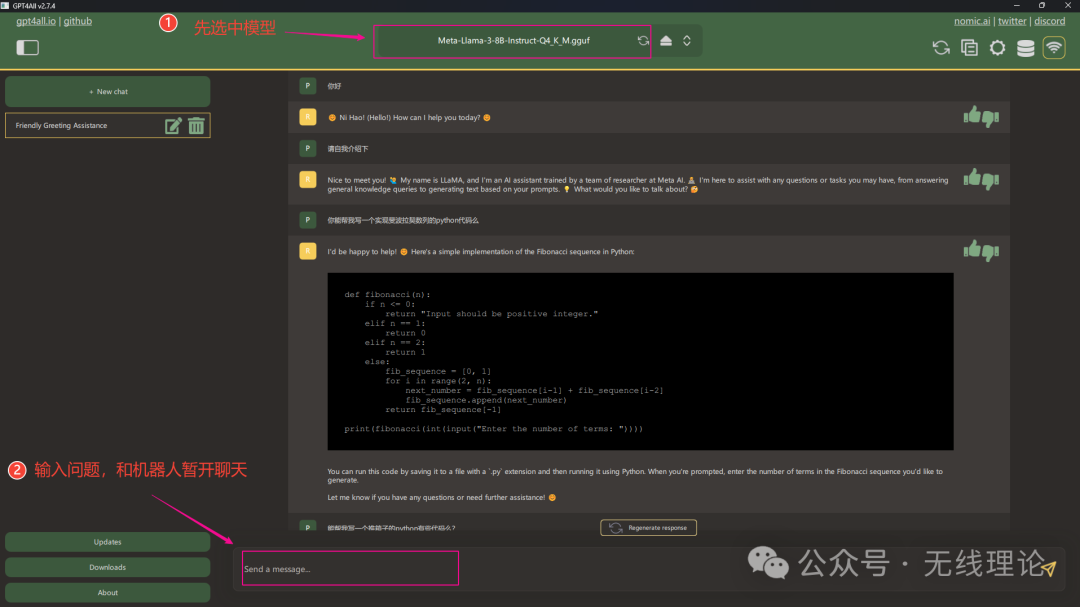

最后就是选中聊天模型,并展开聊天了,

读者福利:如果大家对大模型感兴趣,这套大模型学习资料一定对你有用

对于0基础小白入门:

如果你是零基础小白,想快速入门大模型是可以考虑的。

一方面是学习时间相对较短,学习内容更全面更集中。

二方面是可以根据这些资料规划好学习计划和方向。

包括:大模型学习线路汇总、学习阶段,大模型实战案例,大模型学习视频,人工智能、机器学习、大模型书籍PDF。带你从零基础系统性的学好大模型!

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

👉AI大模型学习路线汇总👈

大模型学习路线图,整体分为7个大的阶段:(全套教程文末领取哈)

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

👉大模型实战案例👈

光学理论是没用的,要学会跟着一起做,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

👉大模型视频和PDF合集👈

观看零基础学习书籍和视频,看书籍和视频学习是最快捷也是最有效果的方式,跟着视频中老师的思路,从基础到深入,还是很容易入门的。

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

👉获取方式:

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

2941

2941

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?