🧙♂️ 诸位好,吾乃斜杠君,编程界之翘楚,代码之大师。算法如流水,逻辑如棋局。

📜 吾之笔记,内含诸般技术之秘诀。吾欲以此笔记,传授编程之道,助汝解技术难题。

📄 吾之文章,不以繁复之言,惑汝耳目;但以浅显之语,引汝入胜。

🚀 若此文对阁下有所裨益,敬请👍🏻-点赞 ⭐ - 收藏 👀 - 关注,不胜感激。

在教大家部署Llama3之前,先要带大家了解一个概念:Ollama。

Ollama是什么?

Ollama是一个用于在本地计算机上运行大型语言模型(LLMs)的命令行工具。它允许用户下载并本地运行像Llama 3、Code Llama等模型,并支持自定义和创建自己的模型。

Ollama是免费开源的项目,支持macOS和Linux操作系统和Windows系统。它还提供了官方的Docker镜像,使用户可以通过Docker容器部署大型语言模型,确保所有与模型的交互都在本地进行,无需将私有数据发送到第三方服务。

安装

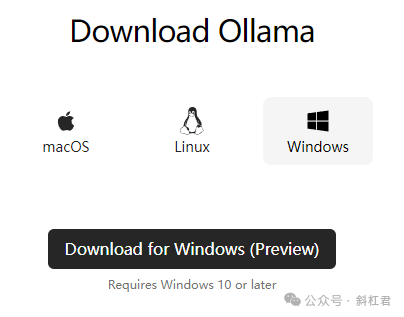

理解了Ollama是什么之后,让我们到官网下载Ollama程序吧~

官网下载页面:https://ollama.com/download

因为我的电脑是windows, 所以这里我下载Windows这个版本。

下载好了,程序大小一共是212M。

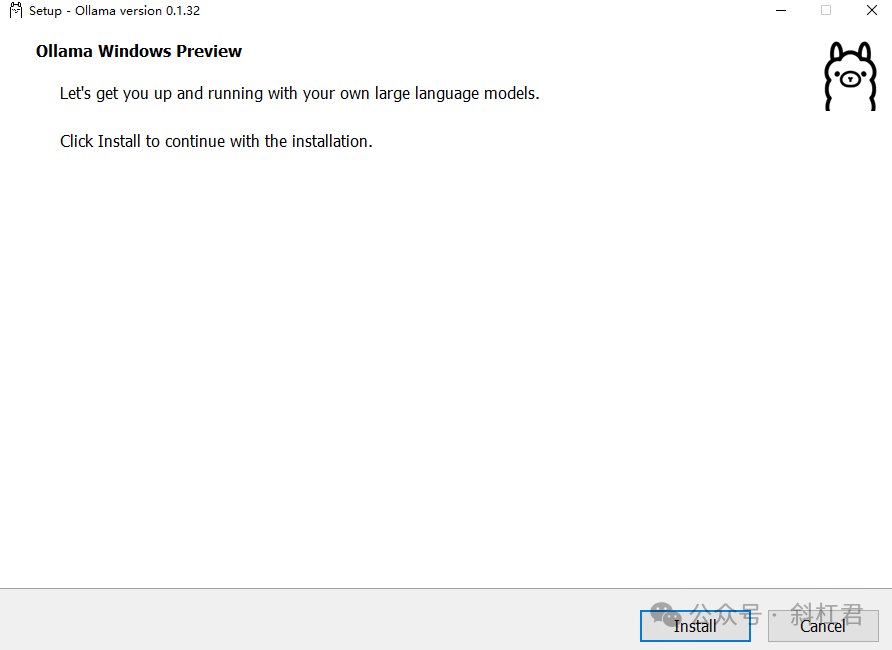

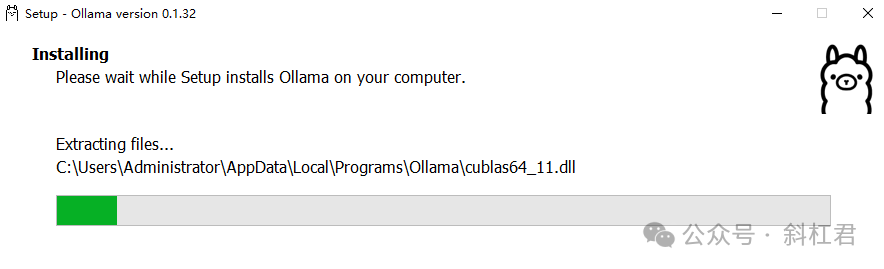

下载好后,双击点开始安装:

默认安装到C盘。PS:很奇怪为什么没给个自定义安装目录的选项 :(

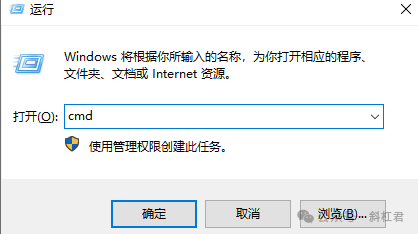

安装完成后,Win+R键调出运行窗口:

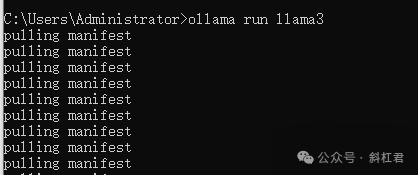

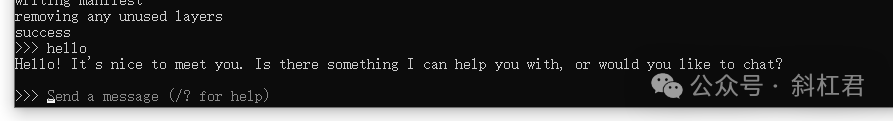

在窗口中键入cmd调出控制台,在控制台中运行命令:ollama run llama3

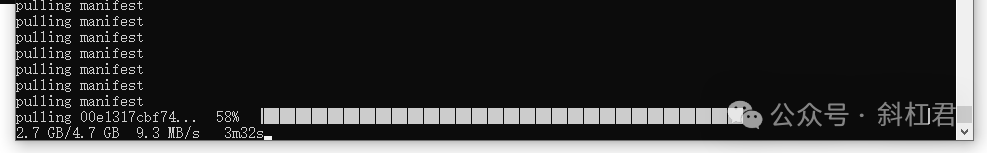

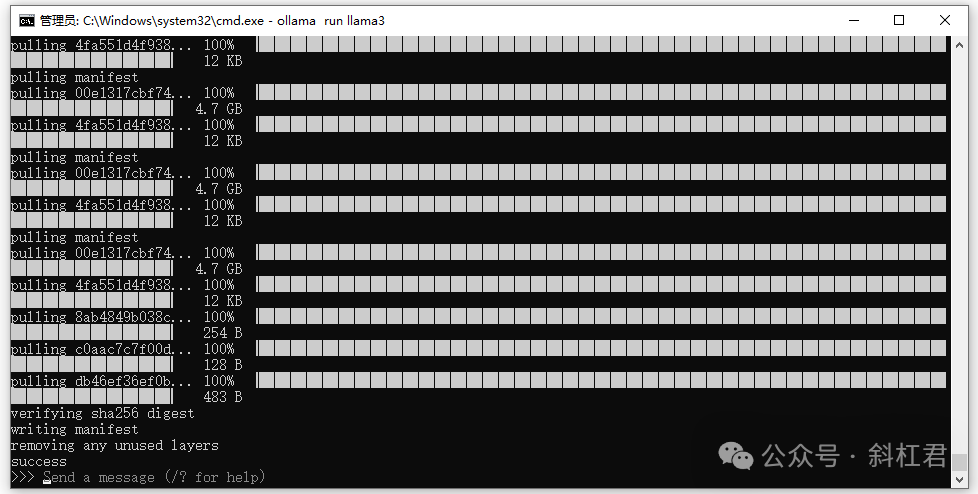

这时就开始下载模型了。

等待一会儿,安装完成。

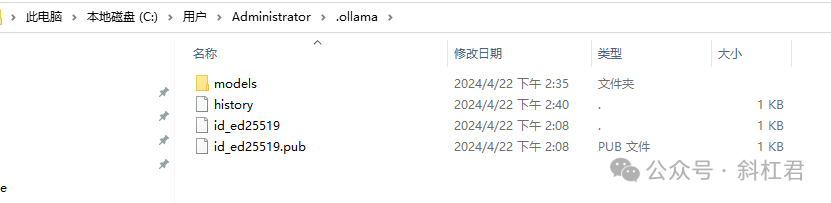

下载的文件在下面这个目录:

测试

先测试一下,回答怎么样?

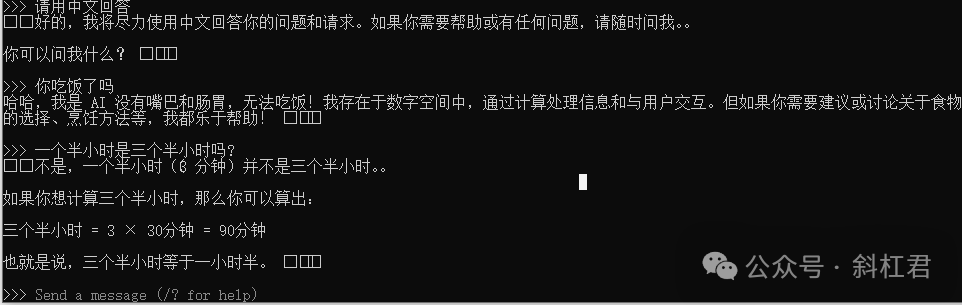

再来测试一下中文。

测试结果回答逻辑是没什么问题的,速度也很快。

好了,使用Ollama在本地部署llama3的教程就为大家教到这里,大家快动手试试,部署个属于自己的本地大模型助手吧!

🧙♂️ 诸位好,我是斜杠君。全栈技术,AI工作流技术研究者。分享探索AI技术等干货内容。我正在写最新版扣子(Coze)工作流教程,关注我获取最新版教程。

关注公众号获取完整版教程

👑 阁下若觉此文有益,恳请👍🏻-点赞 ⭐ - 收藏 👀 - 关注,以资鼓励。倘若有疑问或建言,亦请在评论区💬评论 赐教,吾将感激不尽。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?