之前在window下安装过 Ollama和OpenWebUI搭建本地的人工智能web项目(可以看我之前写的文章),无奈电脑硬件配置太低,用qwen32b就很卡,卡出PPT了,于是又找了一台机器安装linux系统,在linux系统下测试一下速度能否可以快一些。

系统硬件介绍

Ubuntu 22.04.4 LTS

CPU: i5-10400F

内存:32G

硬盘: 512G SSD

显卡: NVIDIA GeForce GTX 1060 6GB

内网IP: 192.168.1.21

下载 Ollama

访问下载: https://ollama.com/

安装Ollama

方法1、命令行下载安装(耗时长)

安装命令:

$ sudo apt install curl

$ curl -fsSL https://ollama.com/install.sh | sh

缺点: 国内网络环境要等很久

方法2 , 手动下载安装

1、手动下载 https://ollama.com/install.sh 这个文件

$ sudo mkdir ollama

cd ollama

$ sudo wget https://ollama.com/install.sh

2、注释掉下载部分 curl xxxx 手动下载ollama-linux-{ARCH}

$ sudo vim install.sh

修改文件:

status "Downloading ollama..."

#curl --fail --show-error --location --progress-bar -o $TEMP_DIR/ollama "https://ollama.com/download/ollama-linux-${ARCH}${VER_PARAM}"

我电脑intel/amd cpu 所以 {ARCH} = amd64

浏览器下载 https://ollama.com/download/ollama-linux-amd64 当然科学上网速度更快哟。 放在 install.sh 同目录下

3、注释掉 #$SUDO install -o0 -g0 -m755 $TEMP_DIR/ollama $BINDIR/ollama

改为下面一行:

$ sudo vim install.sh

修改文件:

status "Installing ollama to $BINDIR..."

$SUDO install -o0 -g0 -m755 -d $BINDIR

#$SUDO install -o0 -g0 -m755 $TEMP_DIR/ollama $BINDIR/ollama

$SUDO install -o0 -g0 -m755 ./ollama-linux-amd64 $BINDIR/ollama

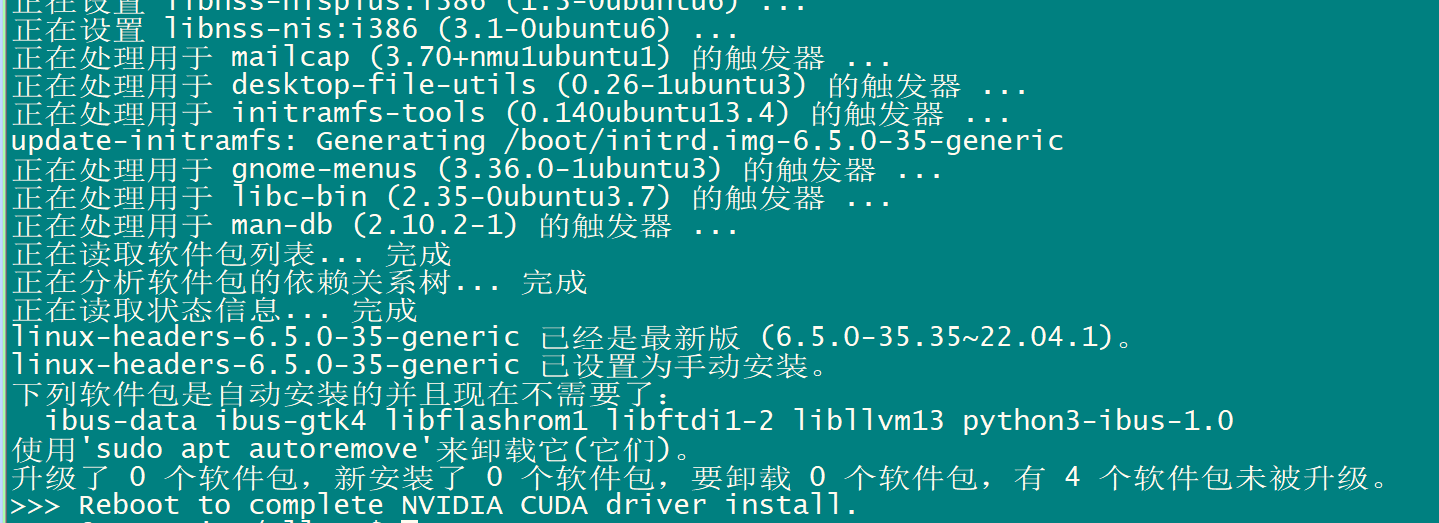

4 运行 install.sh ,安装

sh ./install.sh

重启电脑

配置模型下载路径

cd

sudo vim .bashrc

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1742

1742

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?