在我之前的博客中讲到了感知器(感知器 ),它是用于线性可分模式分类的最简单的神经网络模型,单个感知器只能表示线性的决策面,而反向传播算法所学习的多层网络能够表示种类繁多的非线性曲面。

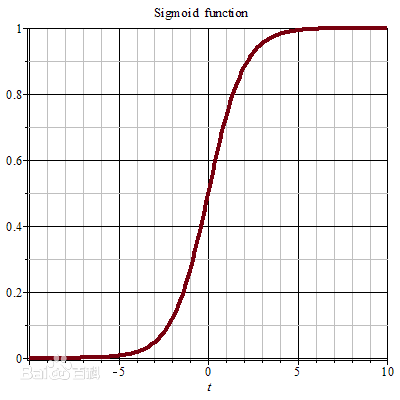

对于多层网络,如果使用线性单元的话,多个线性单元的连接仍然是线性函数,所以还不能表征非线性函数。使用感知器单元,但是它不连续所以也就不可微,不适合梯度下降算法。我们需要这么一种单元,它的输出是输入的非线性函数,而且输出是输入的可微函数。那么可以使用sigmoid单元,它非常类似于感知器单元,而且基于一个平滑的可微阈值函数,It looked like this:

sigmoid函数公式如下:

σ ( y ) = 1 1 + e − y

它的输出范围为[0,1],随输入单调递增,这个函数把非常大的输入值映射到一个小范围的输出,它经常被称为sigmoid单元的挤压函数(squashing function)。sigmoid函数的导数很容易以它的输出表示,即

d σ ( y ) d y = σ ( y ) ⋅ ( 1 − σ ( y ) )

有时候可以使用其他容易计算导数的可微函数代替,比如sigmoid函数中的

e − y 有时候被替换为

e − k y 其中

k 是个正常数,用来决定函数的陡峭性。双曲正切函数也可用来代替sigmoid函数 。

对于由一系列确定的单元相互连接形成的多层网络,反向传播算法可以用来学习这个网络的权值,它使用梯度下降方法来最小化网络输出值和目标值之间的误差平方。

在这里我们要考虑网络中多个输出单元,而不是一个单元,所以可以看到下面的误差公式中要计算两次和:

E ( w ) ≡ 1 2 ∑ d ∈ D ∑ k ∈ o u t p u t s ( t k d − o k d ) 2

其中

o u t p u t s 是网络输出单元的集合,

t k d 和

o k d 是与训练样例

d 和第

k 个输出单元相关的输出值。

反向传播算法需要解决的问题是搜索一个巨大的假设空间,这个空间由网络中所有单元的所有可能权值定义,此时可以用一个误差曲面来形象表示。在和训练单个单元的情况一样,梯度下降可以用来寻找使

E 最小化的一个假设。

多层网络的一个主要不同是它的误差曲面可能有多个局部最小值,那么这就会带来一个问题,使用梯度下降的时候不能保证一定能收敛到全局最小值。不过在实践中反向传播都产生了出色的结果。

反向传播首先把输入x

u 的输出o u

k ,计算它的误差项δ k

δ k ← o k ( 1 − o k ) ( t k − o k )

对于网络的每个隐藏单元

h 计算它的误差项

δ h :

δ h ← o h ( 1 − o h ) ∑ w k h δ k

更新每个网络的权值

w j i :

w j i ← w j i + Δ w j i

其中

Δ w j i = η δ j x j i

反向传播已经开发除了许多变种,最常见的是修改权值更新法则,使第

n 次迭代的权值更新部分依赖于第

n − 1 次迭代时的更新,即

Δ w j i ( n ) = η δ j x j i + α Δ w j i ( n − 1 )

其中

α ∈ [ 0 , 1 ) ,一个冲量常数,上式右边第二项叫做冲量项。

860

860

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?