14.3 Principal Component Analysis Problem Formulation

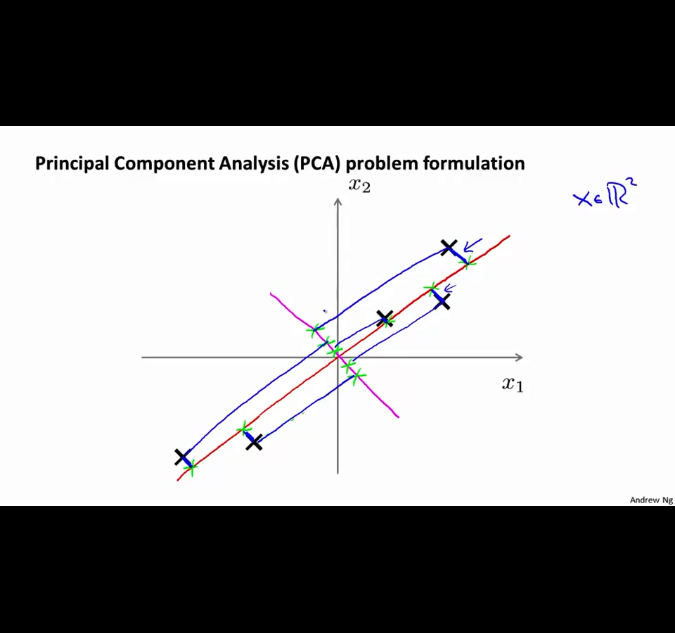

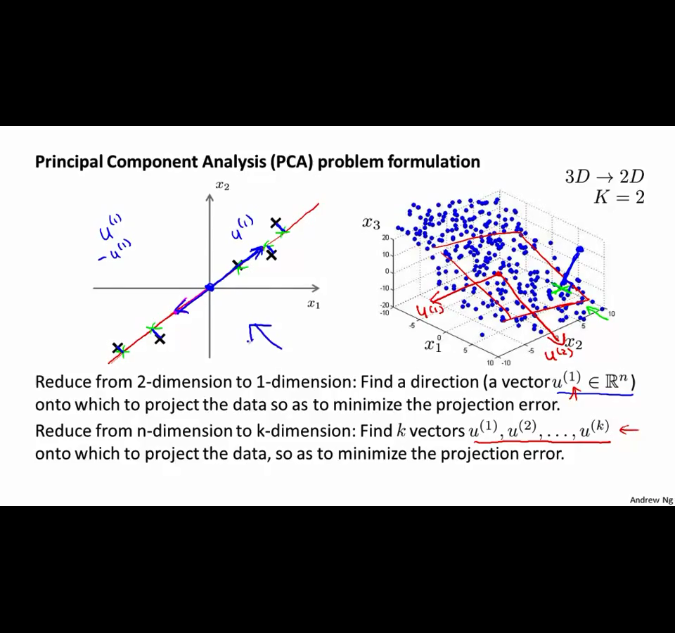

我们想要找到的向量是一个向量,并且原样本点到投影后的样本点的距离之和最小。

等价于,使得投影后样本点的方差最大化。

将3-d转到2-d时,应该找到两个向量表示这个投影的平面。

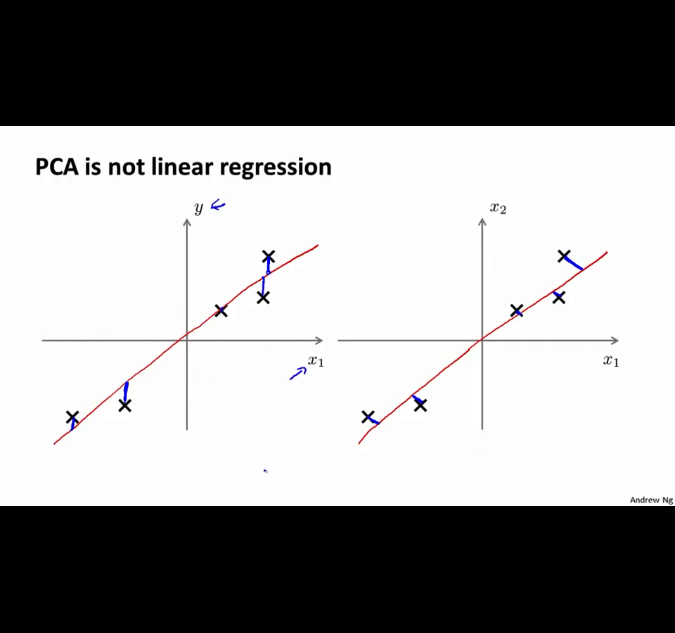

线性回归和PCA的差别,线性回归优化的是预测值和真实值的距离,而PCA优化的目标是到投影点的距离,并且PCA是不用来预测y值的。

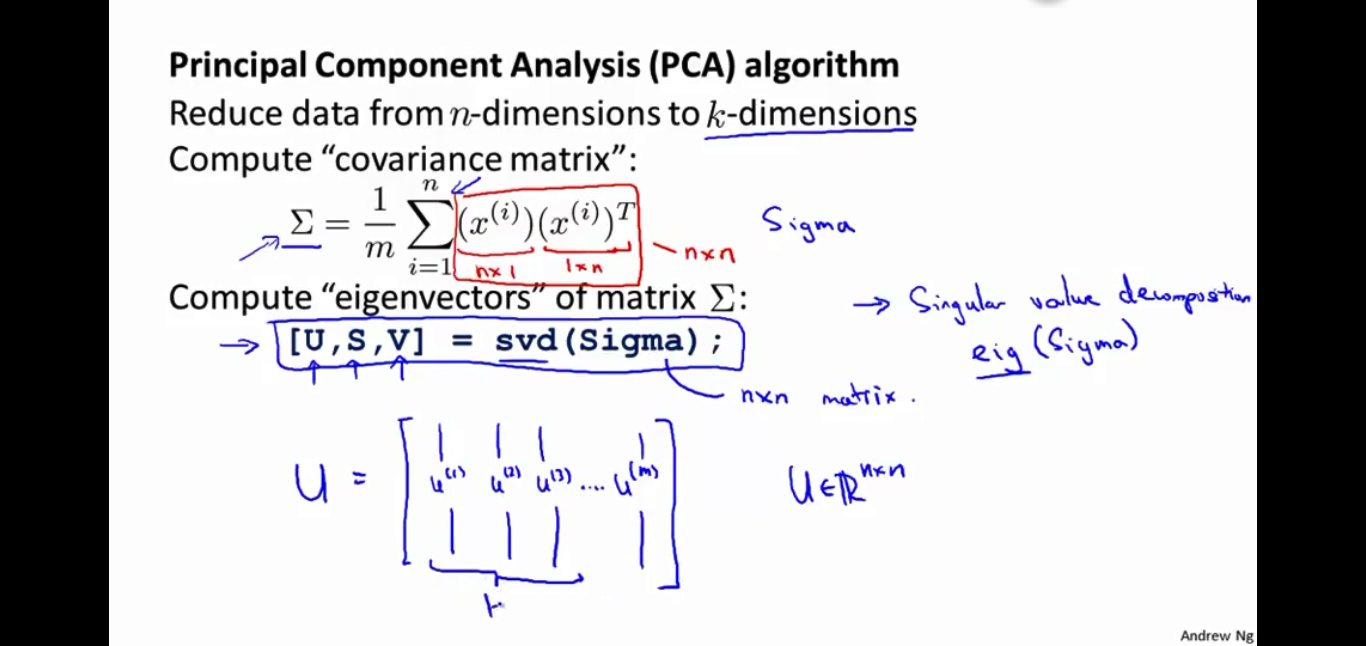

14.4 Principal Component Analysis Algorithm

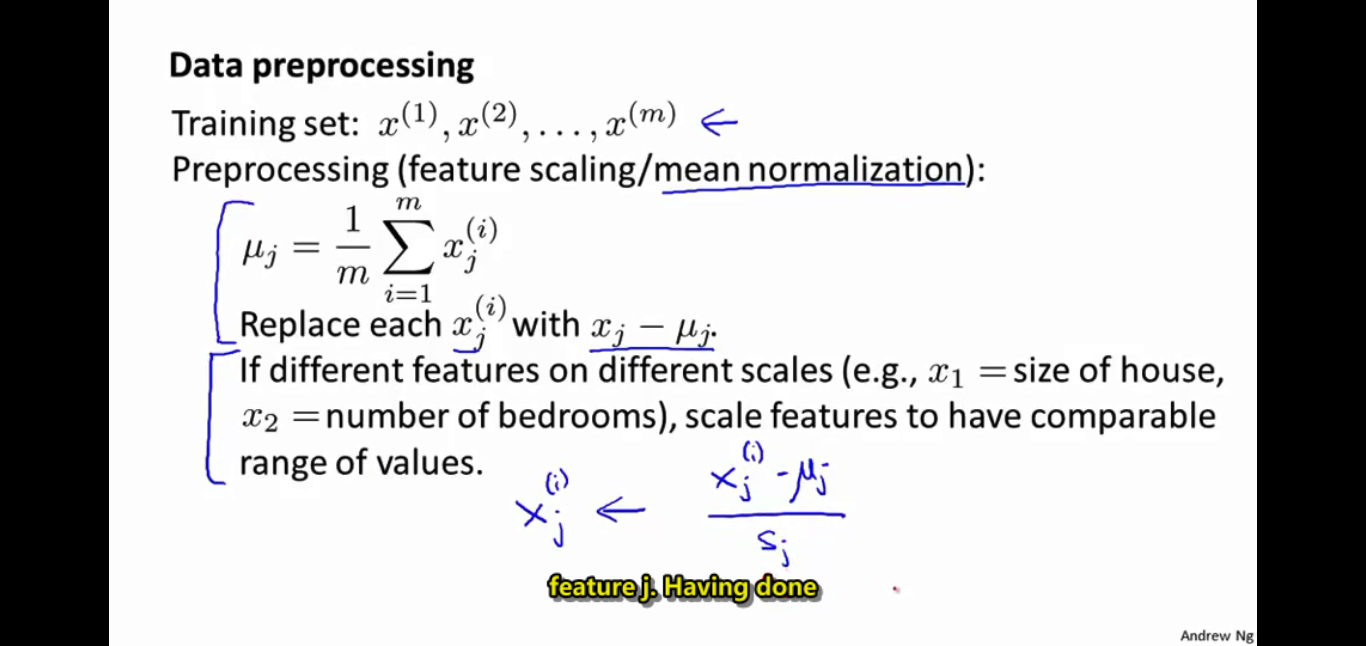

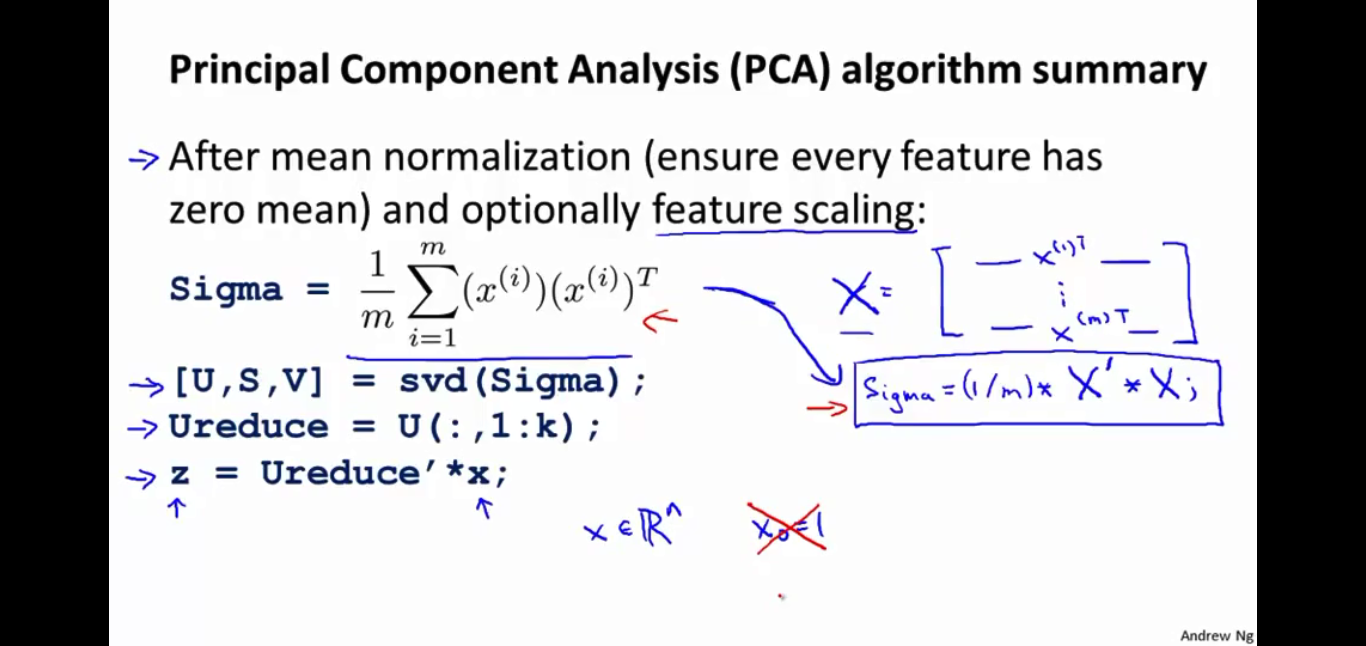

在使用PCA算法之前,要进行预处理,其中

μj

是第j个特征所有值的均值。

求出协方差矩阵,并对协方差矩阵进行奇异值分解,分解后选取前k个向量就是我们需要的向量。

在这里,主要支出了协方差矩阵的另一个求法,sigma=

1m∗XT∗X

Ureduce

= n*k,

xi

= n* 1,可以得到

zi=UTreducexi

= k*1,此时,本来n维的数据就变成了k维。

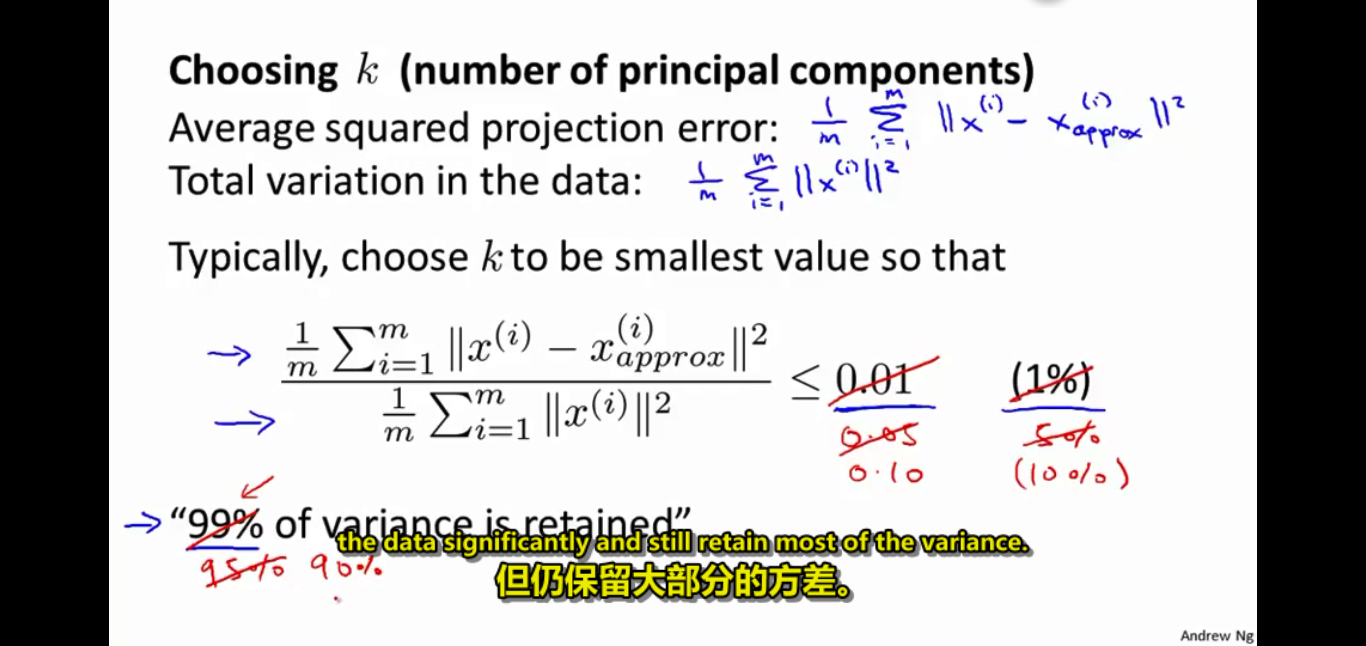

14.5 Choosing the Number of Principal Components

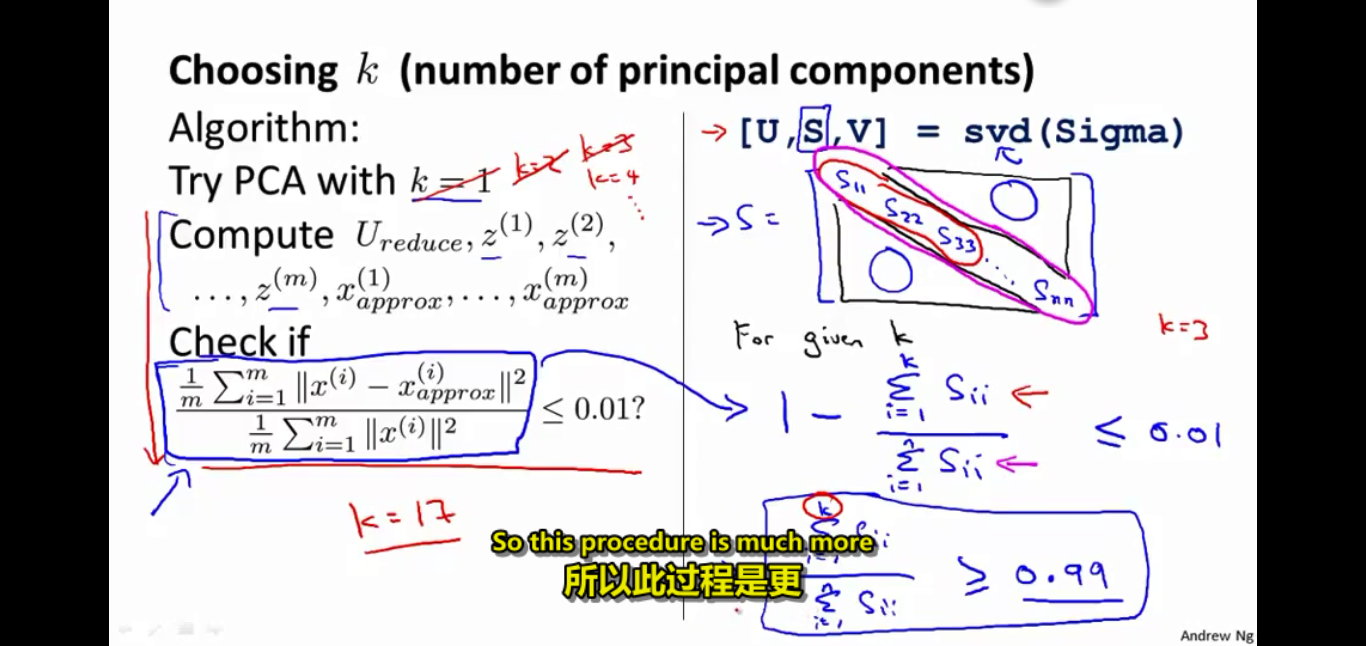

给出了两个参数,第一个参数是数据到映射点的平均距离,第二个是数据的方差。通过两个的比值作为选取k值的标准,如果比例>0.99,我可以称%99的误差被保留了。

给出了算这个比例的另一个方式,就是通过奇异值分解后的S矩阵。

14.7 Advice for Applying PCA

1 不要将PCA用于防止过拟合

2 在使用PCA之前,先跑原始数据,仅当需要使用PCA时,再使用。

230

230

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?