华为诺亚AI系统工程实验室主任刘文志解读如何使用AutoML预测基站流量 - 知乎讲师介绍:刘文志(花名风辰),华为诺亚AI系统工程实验室主任,异构并行计算专家,毕业于中国科学院研究生院,闻名于并行计算江湖,尤善异构并行计算、AI系统工程和大规模集群计算,涉及图像处理、计算机视觉、自…![]() https://zhuanlan.zhihu.com/p/367474946?utm_medium=social&utm_oi=39853307723776VEGA:诺亚AutoML高性能开源算法集简介 - 知乎VEGA概述:VEGA是华为诺亚方舟实验室自研的全流程AutoML算法集合,提供架构搜索、超参优化、数据增强、模型压缩等全流程机器学习自动化基础能力。目前集成的算法大多数已经合入了华为 DaVinci 全栈AI解决方案 Cann…

https://zhuanlan.zhihu.com/p/367474946?utm_medium=social&utm_oi=39853307723776VEGA:诺亚AutoML高性能开源算法集简介 - 知乎VEGA概述:VEGA是华为诺亚方舟实验室自研的全流程AutoML算法集合,提供架构搜索、超参优化、数据增强、模型压缩等全流程机器学习自动化基础能力。目前集成的算法大多数已经合入了华为 DaVinci 全栈AI解决方案 Cann…![]() https://zhuanlan.zhihu.com/p/154516792

https://zhuanlan.zhihu.com/p/154516792

1.1神经网络基本结构

- 参数:一般是指由训练数据得到的数值,例如权重矩阵,卷积核等

- 超参数:在搭建神经网络以及训练之前就要设定好的一些参数,通常由两类超参数,一类是神经网络结构,另一类是算法

所以参数是由参数和超参数共同组成,不同的超参数在经过训练之后会产生不同的参数。进而影响在测试机上的准确性。

1.1.1举例

以CNN举例

CNN的超参数包括以下几个:卷积层的数量,卷积核大小,以及全连接层的宽度等等

但是目前一些很流行的神经网络结构(也就是超参数)都是手动设计出来的,例如res-50等等。

假设我们要搭一个CNN网络,我们要依次设计每一层的超参数,卷积核数量,大小以及步幅。

1.2神经网络结构搜索(NAS)

1.2.1 定义

找一个神经网络结构使得此网络在验证集上的准确率(或者其他指标)最高

1.2.2 举例

- 当以准确率为指标时,Res-50的准确度比VGG要高。

- 当考虑把计算效率也考虑进去时,MobileNet的计算效率要比ResNet高,虽然后者的准确度比前者高

1.2.3 NAS搜索空间

为了完成神经网络搜索,我们第一步需要创建搜索空间:也就是各类超参数集合

1.2.3.1 举例

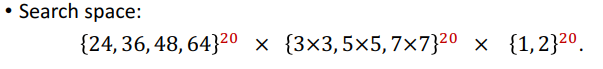

我们卷积核数量,大小,以及步幅均从下面的集合中取:

- 上面时每层所需要的超参数

- 剩下的超参数时一共需要创建多少层,我们假设共需要20层layer。

那么我们的搜索空间为:

搜索空间大小为:

![]()

NAS得到的搜索结果为结构超参数,也就是我们上面定义的集合中取值。

1.2.4 Baseline of NAS: Random Search

随机搜索也就是从我们定义的搜索空间里随机的选取几个值,然后根据定义的指标取选取计算所得值中最大的那一组作为超参数。如下图步骤所示:

1.2.4.1 随机搜索的缺点

- 每一次训练很费时间。例如当使用单GPU训练依次CNN需要花费数小时甚至几天

- 搜索空间太大。一般我们最多搜索几万次,但是对于搜索空间而言,如同沧海一粟

3833

3833

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?