题目: Enhanced LSTM for Natural Language Inference

作者: Qian Chen, Xiaodan Zhu, Zhenhua Ling, Si Wei, Hui Jiang, Diana Inkpen

单位: University of Science and Technology of China, National Research Council Canada, …

出版: ACL, 2017

解决的问题

若我们有两个句子

a=(a1,...,ala)

和

b=(b1,...,blb)

, 其中a为前提,b为假设。

ai

和

bj

都是l维的向量,可以由提前训练好的词向量进行初始化,并且由分析树(parse tree)进行组织。自然语言推理就是得到一个标签y来预测a和b之间的逻辑关系。

本方法提高了自然语言推理的准确性。

方法

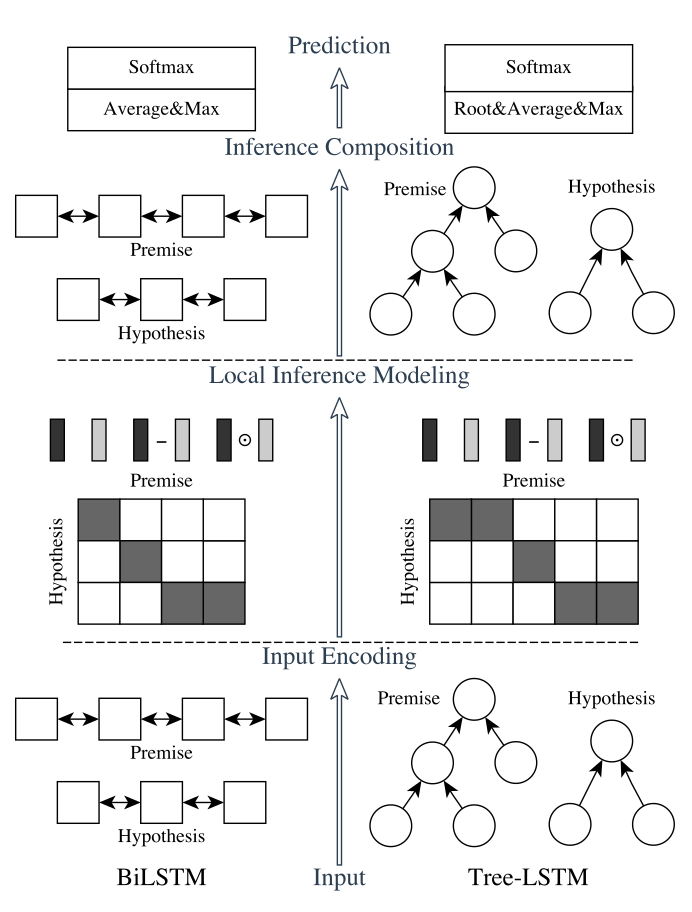

我们的自然语言推理网络由以下部分组成:输入编码,局部推理模型,和推断合成(inference composition)。结构图如下所示:

垂直来看,上图显示了系统的三个主要组成部分;水平来看,左边代表称为ESIM的序列NLI模型,右边代表包含了句法解析信息的树形LSTM网络。

输入编码

我们利用双向LSTM作为我们的基本模块之一。我们用它来编码输入前提和假设。这里BiLSTM学习表示一个单词和它的上下文。随后我们会用BiLSTM来进行推断的合成,从而进行最后的预测。为后面使用,我们记

ai⎯⎯⎯

为BiLSTM由输入序列

a

在时刻i生成的隐藏(输出)状态。

简单来说,在为一个序列建模时,LSTM用一个记忆cell将一系列的门联系在一起来控制信息的流向,这使得它能够有效地处理序列中的长距离信息/依赖。

BiLSTM分别从一个序列的左右两端运行前向和后向LSTM。这两个LSTM在每个时间步生成的隐藏状态被连接一起,以表示这一时间步以及它的上下文。我们在这里使用了LSTM的记忆模块。

上面已经提到,探究句法对自然语言推理的有效性同样是有趣的。

1055

1055

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?