6.0 前言

多Agent领域的一个流行的说法是:

作为单个Agent的系统没有太多要研究的问题。

从单个Agent,到多个Agent,需要理解一些概念,本章就来介绍。

6.1 效用和偏好

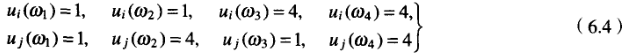

俩Agent i和j,都有各自的偏好和愿望。自然,他们就会对结果进行打分。所以面对结局或状态的集合![]() ,他们会自然的打分,于是可以映射成一个分数,这个分数就叫做效用。

,他们会自然的打分,于是可以映射成一个分数,这个分数就叫做效用。

![]()

![]()

然后不同结局,总有不同的喜好程度吧,或者一样的分吧,就是说如果![]() ,那么结局

,那么结局至少与结局

一样好。

于是我们引入偏好顺序,简化写成:

![]()

同样,如果![]() ,那么Agent i的结局

,那么Agent i的结局严格好于

,简化写成:

![]()

换句话说:

![]()

可以看出,关系的确是

上的一个排序,有以下性质:

- 自反性 对所有

,有

,有

- 传递性 如果

并且

并且 ,则

,则

- 比较性 对所有

和

和 ,或者

,或者 或者

或者

6.1.1 什么是效用

想象一个人,他总资产只有1块钱,然后你给他100万,他是不是会很开心?

然后你再想,一个人,他总共有1亿元,然后你给他100万,他会很开心吗?最起码没第一个人开心,都不用在银行存多久,银行经理就会屁颠屁颠的跑过来跟你谈买理财产品了,那绝对就不止100万了。

然后想象一个人,他负债5亿美元(别问为啥负债就变成美元了),你给他补100万美元,他会好受一点么?当然。

但你再想一个人,他负债刚好100万美元,你给他补完,他不欠钱了,他会好受的,而且肯定是比第一个人好受。

所以效果如图:

这就是效用的特点,而且这也解释清楚了边际效应递减是什么样的。

6.2 环境

现在来看环境。

Agent做动作,然后改变了环境。假设就俩Agent,只能选择合作和不合作,合作就是Cooperate,不合作就是defy,设![]() 是这些动作的集合。环境改变的方式如下面这个函数表示:

是这些动作的集合。环境改变的方式如下面这个函数表示:

![]()

然后下面就是一个环境函数的例子:

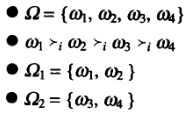

![]()

再看这种情况:

![]()

这种情况下,俩Agent的动作对环境就没有任何影响。

再看:

![]()

这个是不是在说,只有j对环境做动作,才有影响呢。

那把Agent的偏好,和这个环境放一起,会是什么结果呢?假设和(6.1)一样,你看再假设一下这样:

于是我们可以有点不严格的写成这样:

那么,对于Agent i来说,他偏好就是这样的:

![]()

现在,考虑下面的问题:

在这种情形下,如果你是Agent i你会选择什么动作一合作还是不合作?

很明显啊,不管j干啥,自己合作自己爽啊。i肯定选合作。

j也是一样。那说明了什么呢?

两者同时会选择最好的结果,结局就是C, C。你是不是联想起了什么,别急,先跟着思路走;

再假设是这样:

再顺着思路分析,比如Agent i的偏好是:

![]()

于是就无脑选不合作了。换句话说,就是不用策略性的考虑j,就选不合作了。

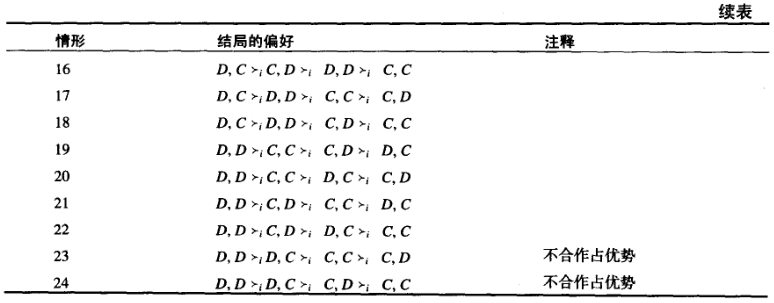

策略?对策?对策论?博弈论?没错,现在收益矩阵是这样:

其中每个格子右上角是i获得的收益,左下角是j获得的收益。

现在再来给你补补对策论:

6.3 优势策略与Nash均衡

博弈论就是说在博弈的时候,两个人要干啥才最好。

现在开始建模:

假设有两个的子集,分别用

和

表示。如果对i希望

中每个结局超过

的每个结局,则对于Agent i来说

优势于

。

说人话就是,全部可能的结果中,有一类结果好于另一类,这一类就优于另一类。

则强优于

,因为每个结局都比后者好。形式上这么写:

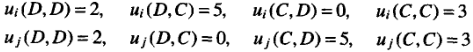

如果下面的条件未正,则结局的集合强优于

:

![]()

现在把动作(集合Ac的元素)视为策略。对于Agent i采取特定策略s,会有很多可能的结局,设用![]() 表示Agent i采用策略s产生的结局。例如参考(6.1),从Agent i的观点来看,有

表示Agent i采用策略s产生的结局。例如参考(6.1),从Agent i的观点来看,有,而

![]() 。

。

很明显,如果![]() 优于

优于![]() ,可以说策略

,可以说策略![]() 优于策略

优于策略![]() 。比如看(6.5),没有任何策略优于合作策略,所以大家都会选择合作,以保证自己的最终收益。

。比如看(6.5),没有任何策略优于合作策略,所以大家都会选择合作,以保证自己的最终收益。

还有一种倒着理解的方式,有其他策略![]() 优势于

优势于![]() ,则理性的Agent不会遵循s。这样理解,就可以倒着删掉没优势的策略,一个一个删,然后,你就会发现,有的时候出现多个结果了……很多个结果互相比较,没有比较出强优势的。这时候我们可以考虑弱优势,至少做的一样好的策略,即:如果每个结局

,则理性的Agent不会遵循s。这样理解,就可以倒着删掉没优势的策略,一个一个删,然后,你就会发现,有的时候出现多个结果了……很多个结果互相比较,没有比较出强优势的。这时候我们可以考虑弱优势,至少做的一样好的策略,即:如果每个结局![]() 至少希望和每个结局

至少希望和每个结局![]() 一样好,那么称策略

一样好,那么称策略![]() 弱优势于策略

弱优势于策略![]() 。

。

然后我们可以来讨论平衡了,就是Nash平衡。最直观的例子就是,你开车吧,要选择走左边吧。自然是别人走左边,你就走左边;别人走右边,我就走右边,是吧。英国是左边,美国和其他欧洲国家是右边,自然就跟着这么走。这就是Nash平衡。你说,什么,这就是Nash平衡?别急,接着往下看:

一般来说,两个策略s1和s2是处于Nash平衡,如果:

- 在Agent i执行s1这样的假设下,Agent j最好执行s2。

- 在Agent j执行s2这样的假设下,Agent i最好执行s1。

这样,就把Agent锁定在了一对策略上了。于是就有了开车走左边还是右边。

但是,实际情况下,有两个情况得说明一下:

- 并不是每个交互的情形都有Nash平衡。

- 有些交互的情形有一个以上的Nash平衡。

尽管这样,Nash平衡仍然是一个重要的概念,在多Agent系统的分析中起着重要的作用。

6.4 竞争和零和交互

竞争懂的都懂,你要好,我要更好。数学上就这么表示:

Agent i希望得到结局![]() 超过得到结局

超过得到结局![]() ,当且仅当Agent j希望得到结局

,当且仅当Agent j希望得到结局![]() 超过得到结局

超过得到结局![]() 。形式可有:

。形式可有:

![]()

这样,一个Agent提高其分量只能以另一个Agent的付出为代价。

零和博弈也懂的都懂,吧?就是说,你赢我就输。反过来,你输的越多,我就赢的越多。数学上这么表示:

零和对局是指,对于任何特定的结局,两个Agent的效用之和为零。形式地,称一种情形为零和(sum to zero),如果它满足下面的条件:

![]()

这是一种最“激烈”的竞争形式,没有产生合作行为的可能。如果允许对手有正的效用,则这意味着自己有负的效用。

棋类是这样的,比如象棋和西洋跳棋。但现实中似乎没有这种情况,即便是最残酷的竞争,比如战争,通常参与者至少也会有一些共同的利益(例如,保证星球的生存)。

由于这些原因,有些社会学家怀疑在现实世界中是否存在零和对策(Zagare, 1984, p.22)。然而,有意思的是,在许多情形下有把人类的交互作为零和交互的趋势。下面将看到,在有些情形下(这些情形中有相互利益合作的可能),这种行为是有破坏性的。

这是一个非常抽象的理论!现在把这个理论应用到某些多Agent情形下。首先讨论囚犯两难问题,这可能是最著名的情况。

6.5 囚犯两难

囚徒困境,应该懂的都懂,吧?算了,再说明一下吧:

两个人被共同起诉一项罪名,被关押在隔离的牢房里。他们没有办法互相通信,也没有办法达成任何一致。这两个人被告知:

- 如果其中一人承认有罪而另一个人没有承认,承认有罪者将被释放,另一个人将被关押3年。

- 如果两个人都承认有罪,则每人将被关押2年。

两个囚犯都知道如果都不承认有罪,则每个人将被关押1年。

就不想如果你是囚犯你咋办了吧。(当然你自己偷偷想也没关系~)直接上对策论的收益矩阵:

换句话说,效用是:

偏好是:

答案似乎不明确啊,你说我合作吧,不合作也有收益;不合作吧,合作似乎也还好。

而这个问题的“标准”方法是使你自己处在囚犯的位置上,比如i,然后考虑:

- 如果我合作,j合作我得3,j不合作我得0。我最坏得的是0。

- 如果我不合作,j合作我得5,j不合作我得2。我最坏得的是2。

- 我希望保证收益2,胜于保证收益0。所以我不合作。

这不是之前的第一种的寻找方法,而是第二种的方法。

诚然,都合作才是最好的,但理性的选择却是不合作。

而且现实中也不少见:从核武器条约,到与自己的孩子商讨问题。销毁核武器(合作)与保留核武器(不合作),你可以自己分析一下。

囚徒困境,这个概念是不是听烂了,以至于听到都不感到新奇了。是不是?然而,它背后的传达的理念可是很坏的,那就是人类存在这种情况,不要合作啦!不合作对双方都好!那些道学家就叽叽歪歪:“哎呀!天要塌了!这世间还有不和睦共处的理吗!!!”别急,我们接下来看:

6.5.1 人们不全是思想家

首先就是很多情况下,确实是这样,都不合作反而能更有好处。但人们不常常都是理性的,或者换句话说“吃亏是福”。

咱还是数学一点,文学一点,辩论一点,逻辑一点。

首先就有利他主义这种方法,说大家可能有时会优先考虑他人。如果付出了“幼稚”的代价,也不会有任何恼怒。

支持者说,哎呀,很多这种情况其实并不是囚徒困境啦。总有内在机制利好合作。比如让座,你如果不合作,不给老人以及带小孩的乘客让个座的话,会受到其他乘客严厉的和不能原谅的目光,甚至是对这种在公共场合不文明行为的斥责!

反对者说,哎呀,就是有这种情况啦,就是有就是有就是有!比如上一代意林公知文中的经典“德国检票”,说歪果仁,得果仁的车站都不检票的,全靠公民的素质撑着。唉,就是一个文明自由!当然,现在看来似乎就是那边人手不足罢了。这种合作就是老实买票,不合作就是逃票,不惩罚啥事没有,你看着办。

6.5.2 另一个囚犯是我的孪生兄弟

参见困境的两人出生下来就没有分开过,配合默契,思考同步,一个人穿裤衩另一个都知道是什么颜色的。这种情况下,自然是都能逃脱法律的制裁啦。

6.5.3 人不是理性的

感情一冲动,我就是不招!你打我啊你打我啊~

6.5.4 未来的阴影

其实吧,就是说,不合作有好处,是吧,但是很多情况下都要合作,就比如,你坚持长期占室友小便宜,那没问题,但你室友,你同班人,同层的人,都知道你这个坏毛病,那对你的信用是不是有影响?以后去创业,碰到老同学,本来吧你项目挺好的,他们一看是你,皱着眉头就把你赶出去了。你说会不会有这种?

数学一点这么说的:

在重复进行的囚犯两难问题中,囚犯两难的对局进行多次。每一一次对局称为“一轮”。重要的是,假设每个Agent都可以看到其对手前一轮的动作:局中人可以看到合作还是不合作,而可以看到是合作还是不合作。

现在车轮战,一轮会接着另一轮。

下一轮,碰到同样的对手,你肯定很少会不合作了,这有两个原因:

- 如果你现在不合作,下一局你的对手也可以通过不合作惩罚你。

- 如果你一开始通过合作“试试深浅”,并且在第一轮得到欺骗的回报,那么因为你们要无限期地进行对局,这次的效用损失(一个效用)会在将来的轮次中“分期偿还”。当考虑了无限轮的情况(或者至少经过了很长时间),则一个单元的效用损失只是获得的整个效用的一小部分。

因此,如果参加不限期的囚犯两难对局,则合作是理性的结局(Binmore,1992,p.358)。“未来的阴影”激励我们在无限期重复的囚犯两难对局中选择合作。

不过,还存在一个有意思的问题。

你最后一轮,你想想还有必要合作吗?理性的考虑应该是不合作。假设进行100轮,那么第100轮确定了。那么第99轮才是不确定的,所以第99轮又要这样来考虑,于是又不合作了。所以倒推过来,全部都不用合作了。

娱乐至死

所以你就能理解,为啥有的人不认来世,只觉得能活一辈子,然后就开摆了,乃至烧杀掳掠吧。这就是他们倒推的思路。

“又回到最初的起点”,似乎又是不合作了。但不管怎么说,“未来的阴影”还是会刺激合作的。而且啊而且,遇到一个不合作的虽然有损失,但是遇到其他Agent交互的时候,合作又能有很好的机会。比如接下来介绍的Axelrod的囚犯两难比赛。

6.5.5 Axelrod的比赛

Robert Axelrod是一个政治学家,他关注Agent在社会中如何产生合作。1980年,他组织了一次公开的比赛,邀请了各界专家,比如政治学家、心理学家、经济学家和对策论的理论学者,来设计程序进行囚犯两难博弈。每个计算机程序能看到其对手上一次做出的选择,并在此基础上只简单地选择C或者D。每个计算机程序互相对弈5局,每一局由200轮组成。胜出的条件是总成绩最好。

计算机程序有从152行的,到仅有5行代码的。下面是一些提交的各种策略的例子:

- ALL-D 是一种“强硬”策略,编码了对策论分析给出的有限次重复囚犯两难的“理性”策略:总是不合作,而不管对手如何动作。

- RANDOM 策略是一种控制:它忽略了对手前一轮的动作,随机选择C和D,使每个结局有相等的概率。

- TIT-FOR-TAT 策略表述如下:

1. 第一轮,合作

2. t>1轮,采取对手-1轮的动作

TIT-FOR-TAT实际上是提出的最简单的策略,只需要5行Fortran代码。 - TESTER 策略是试图利用对不合作不进行惩罚的计算机程序:如策略的名称所暗示的那样,第一轮通过不合作检验对手。如果对手以不合作报复,那么它接着采用TT-FOR-TAT。如果对手没有不合作,那么它重复进行两轮合作对局,然后不合作。

- JOSS 像TESTER一样,JOSS策略也试图利用对手的“弱”点。它基本上是TIT-FOR-TAT,只有10%的时间替代合作,而是不合作。

你可以考虑一下:

- 你觉得哪个策略好

- 你会用什么策略

然后,咱公布结果。您猜怎么着?唉!TIT-FOR-TAT得分是最高的!不过注意嗷,它赢的原因是碰到了其他也愿意合作的Agent。如果强行把它和不愿意合作的Agent放一起,那它就不讨好了。

我们总结了一下TIT-FOR-TAT成功的4条原则:

- 不要嫉妒 在囚犯两难问题中,不要强求为了做得更好而取胜对手。

- 不要首先不合作

- 合作与不合作的交替 正像Axelrod指出的,“TIT-FOR-TAT代表了惩罚与原谅之间的平衡(Axelrod,1984,p.119):惩罚不合作与奖励合作的结合似乎是鼓励合作”。尽管TT-FOR-TAT会在第一轮被欺骗,但是它无情地惩罚那些不合作的行为。而且,TIT-FOR-TAT给出与它受到的伤害同样程度的惩罚:换句话说,对不合作不采取“过火的行动”。此外,因为TTT-FOR-TAT的原凉(奖励合作),有可能使合作建立起来,即使开始时很糟糕。

- 不要过分聪明 如上面所说,TIT-FOR-TAT是Axelrod竞争中最简单的程序。吃惊或者不吃惊,取决于你的观点,他比那些为了决定采取什么动作而试图利用相当先进的程序设计技术的其他程序要好得多。对此,Axelrod指出了三点理由:

- 最复杂的方式试图建立其他Agent的行为模型,而忽略了这个Agent反过来也在观察前一个Agent的事实一它们缺少实际发生的相互学习的模型。

- ·最复杂的方式面对对手的不合作过于一般化,它们不允许将来仍然有合作的可能这样一个事实一它们没有原凉。

- 许多复杂的方式展示的行为过于复杂而难于理解一一对于对手来说,它们同样会随机行动。

6.6 其他的2*2对称交互

回忆一下囚犯两难问题中,Agent i偏好的排序:

![]()

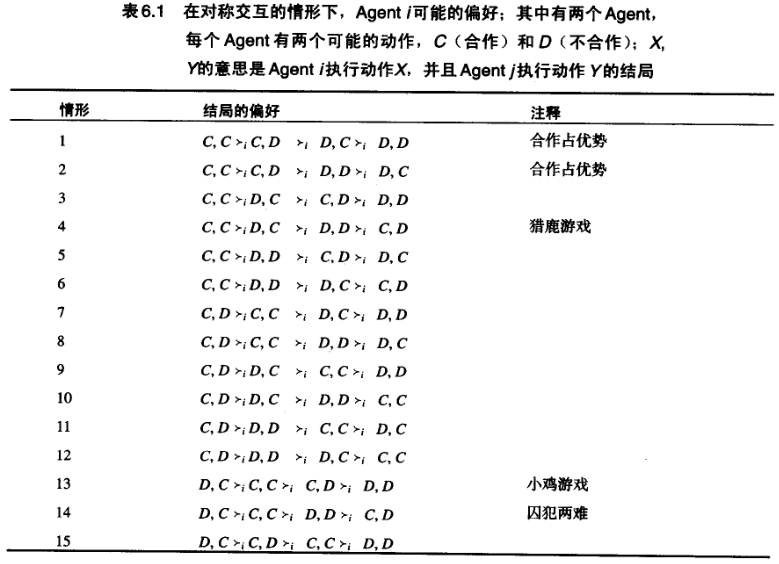

这只是Agent的结局的可能的排序之一。而各种排序有4!=24种,如下表。

许多情形中,Agent采取什么动作是明显的。如(1)和(2)中Agent i明显要合作,因为这两种情况下i合作的结局都优于不合作的结局。同样(23)和(24)中,Agent i明显需要不合作,因为不合作优于合作的结局。(14)是两难问题,剩下有两个有意思的情况要研究:猎鹿游戏和小鸡游戏。

6.6.1 猎鹿游戏

猎鹿游戏来源于瑞士哲学家Jean-Jacques Rousseau1775年关于平等的演说。不过要解释这个问题,咱用贴近作者21世纪初的情形来说明(Poundstone, 1992, pp.218 219)。

你和你的朋友决定,在毕业的前一天理一个滑稽的发型给大家看,这会是一个巨大的玩笑。在你的小团伙的怂恿下,你们两人发誓要理发。

接下来是一夜的忧郁不决。当你预计你的父母和老师的反应时…你开始怀疑你的朋友是否真的会执行这项计划。

并不是说你不想这个计划成功:可能的最好结果是你们两个人都理发。

问题是,作为展示发型的惟一的一个人,将是可怕的。这可能是最坏的结果。

你不能从朋友的窘迫中得到快乐。如果你没有理发,而你的朋友理了发,看起来像一个真正的小丑,结果你们两个人都理了几乎一样好的头发。

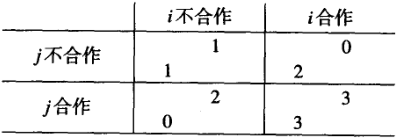

这种情况下,只有两人协调一致,同时合作或不合作,才是最希望的结果。收益矩阵表示如下:

如果你信任你的对手会合作,那么你最好合作。反之,如果你认为你的对手不会合作,那就不能合作。

Poundstone指出“叛变”的情形是猎鹿游戏的一个例子:

“如果我们放弃Bligh船长,最好都离去,但是,如果没有足够的人一起行动,我们就会像变节者一样被吊死”(Poundstone,1992,p.220)。

6.6.2 小鸡游戏

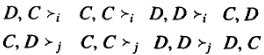

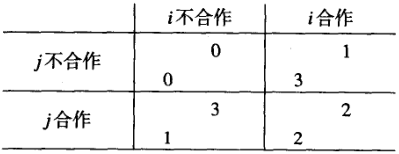

小鸡游戏的偏好如下:

![]()

小鸡游戏的名字来源于一个很无聊的“游戏”,而这个游戏似乎在1950年美国的失足青年中很流行。这个游戏被James Dean通过电影“Rebel Without a Cause”流传下来。

游戏的目的是确定两个年轻的暴徒谁最勇敢,两个局中人通过驾驶他们的骑车向悬崖高速行驶,最胆小的“小鸡”会第一个绕开,退出游戏,赢家是在车上时间最长的人。如果两者都不转弯,那么他们都会跌落悬崖。

Agent i咋办捏,如果它觉得自己比j更勇,那就一直开(不合作),反之如果自己比较弱诶,拜托很弱诶,那就最好绕开悬崖(合作)。如果两个都觉得自己勇,都呆车上(不合作),那就会出现最坏的结局。小鸡游戏勇效用矩阵表示如下:

小鸡游戏有俩Nash平衡,就是左下和右上。就是一方退让,另一方朝前开。

6.7 多Agent系统的依赖关系

除了这种博弈竞争,还有另一种关系,叫依赖(Sichman等,1994;Sichman and Demazeau,1995)。就是如果一个Agent需要另一个Agent帮忙,来实现自己的目标,则两个Agent之间存在依赖关系。有多种可能的依赖关系:

- 独立 Agent之间没有依赖关系

- 单向依赖 一个Agent依赖另一个Agent,反之不成立

- 相互依赖 为了共同的目标,两个Agent相互依赖

- 交互依赖 两个Agent互相依赖,但是所为的目标不同。注意,相互依赖蕴涵着交互依赖

还有局部的和相互信念的关系,如果一个Agent只觉得自己相信依赖关系存在,则有局部信念依赖。当Agent相信依赖关系存在,还相信另一个Agent也知道这一点,则存在信念相互依赖。Sichman及其同事实现了一个称为DepNet的社会推理系统(Sichman等,l994)。给出多Agent系统的描述,DepNet可以计算系统中存在的Agent之间的关系。

6.8 注释和进一步阅读

Binmore(1992, p.310~316)在他的有趣又清晰的有趣对策论导论(Fun and Games)中详细讨论了囚犯两难问题的哲学含义。推荐作为教材,但要求学生要有一定的数学知识。

Axelrod(1984)推荐作为进一步阅读的起点。另外,Axelrod的竞赛,还有一个有趣的设计,就是噪声,就是有可能会存在对方或你误认是合作还是不合作。

Mor and Rosenschein(1995)给出了近期囚犯两难问题的文献。

Axelrod(1997)近期的文章收集出版。

Zagare(1984)是一本非数学的对策论引论,强调了对策论在社会学中的应用。

习题

1.[1级]

考虑下面偏好和结局的集合:

哪些集合(如果存在的话)优势于另一些集合?当没有集合优势于其他集合时,给出说明。

2.[2级]

考虑下列交互的情形:

现在,对于每一个情形:

- 从非形式地分析这个情形开始,决定两个Aget应该做什么行动。

- 根据结局对Agent的偏好进行分类。

- 决定哪个策略是强优势或弱优势。

- 使用删除强优势策略的想法在适当的地方对情况简化。

- 辨别出任何Nash平衡。

3.[课堂讨论]

这道题最好作为课堂练习,分成三组进行囚犯两难问题对局。其中一组为“仲裁者”,记录对局的进展和比分,制止任何违规行为。首先,进行几分钟的单轮对策,然后进行重复对策,先进行事先确定次数的对策,然后由仲裁人选择重复的次数,但不告诉局中人。

- 在单轮对策和重复对策中,哪种策略在囚犯两难中最好?

- 进行人与TTT-FOR-TAT和ALL-D等策略的对策。

- 让局中人事先准确地定义他们的策略(写在纸上),看你是否能在对局中确定他们的策略;分布这个策略,看看这个策略是否能被欺骗。

4.[2级]

对于课文中没有讨论的表6.1中的情形:

- 画出效用矩阵刻画这一情形(注意这是对称交互的情形)。

- 决定Agent会做什么行动。

- 可能的话,辨别现实世界中与这个抽象的情形相应的交互情形。

3301

3301

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?