1.Logistic回归基础知识

二分类模型:根据x,判断y是否为0或1。

目标:输入x,判断y=1的概率,即 ,其

,

参数:

输出: ,

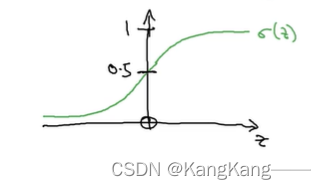

为sigmod()函数, 其中

(1)logistic模型

(2)损失函数Loss

损失函数用于衡量单一训练样例的效果

(3)成本函数Cost

成本函数用于衡量w和b的效果,在全部训练集上来衡量。

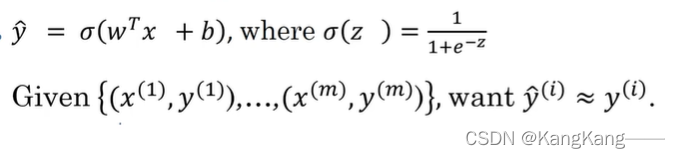

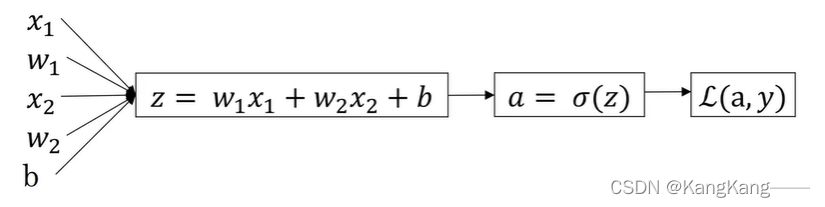

(4)梯度下降法

梯度下降法适用于处理成本函数为凸函数,用来训练或学习训练集上参数w和b,确定出来拥有最小成本函数的参数w和b。

计算原理:

也可写成

其中 为学习率,可以控制每次迭代或梯度下降的步长。

logistic回归的成本函数为凸函数,因此可以使用梯度下降法,每次从初始点开始朝着最陡的下坡走一步,进而可以找到接近全局最优解的结果。若成本函数为非凸函数,则有可能会陷入局部最优解。

2.单个训练样本的Logistic回归梯度下降法(计算某一项损失函数)

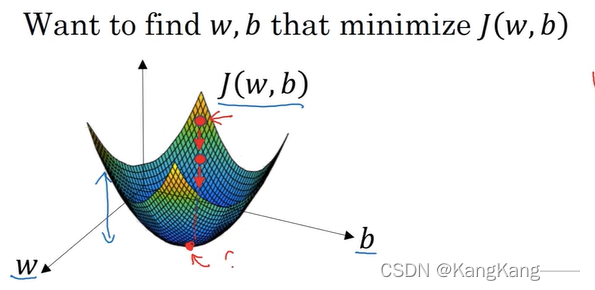

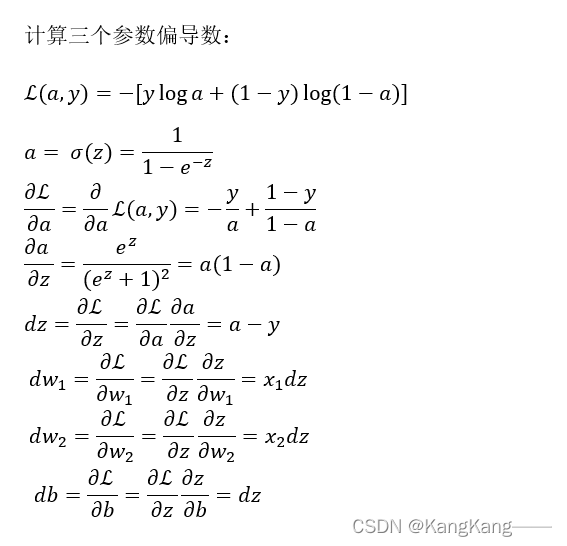

logistic回归公式求损失函数

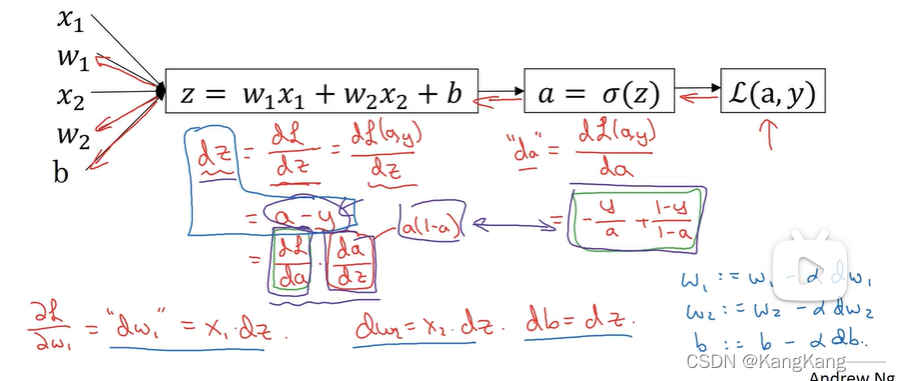

计算流程图的正向传播,从左到右计算成本函数J

计算流程图的反向传播,从右向左计算导数

假设样本只有两个特征,则需要三个参数

Logistic回归向前传播

Logistic回归向后传播

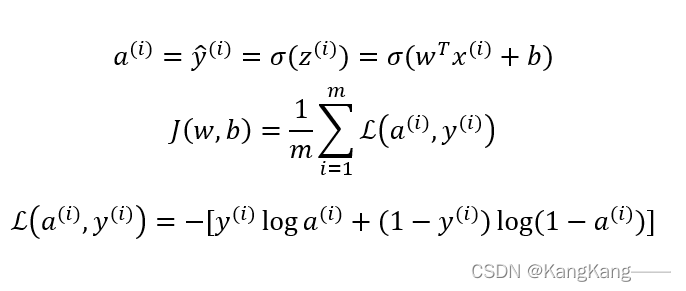

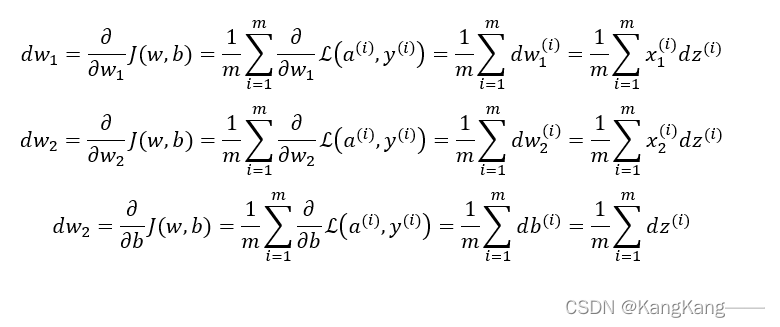

3.训练集m个样本的梯度下降法(计算成本函数,实际上为1到m项损失函数和的平均)

(1)logistic回归公式求成本函数

计算各参数的偏导数,即全局梯度值(假设样本只有两个特征,则需要三个参数

)

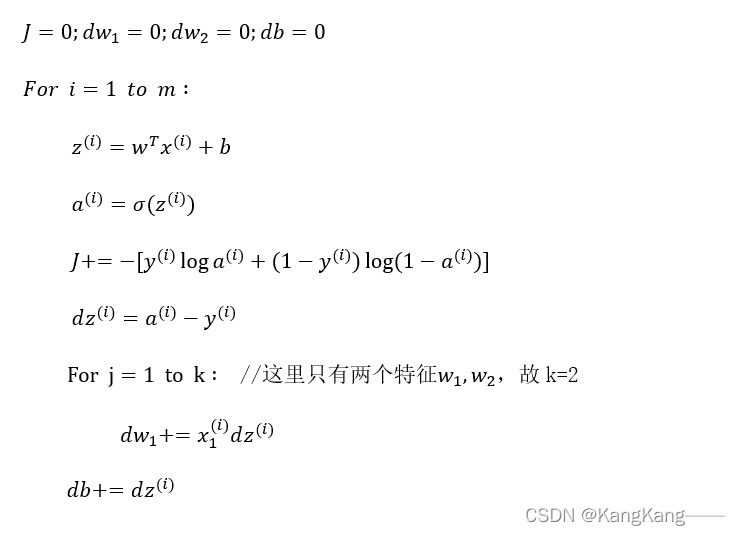

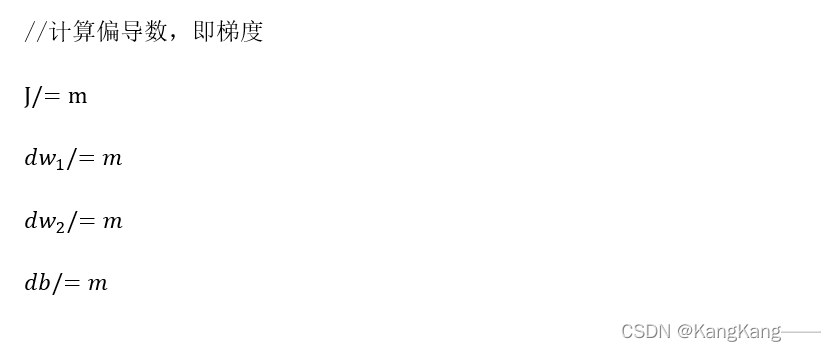

(2)求数据集m项的Logistic回归一次迭代的计算梯度过程

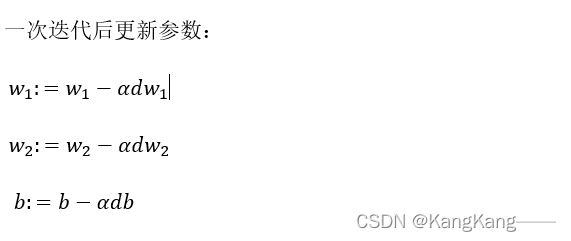

更新参数,为下次迭代做准备:

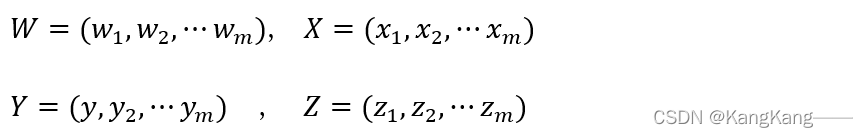

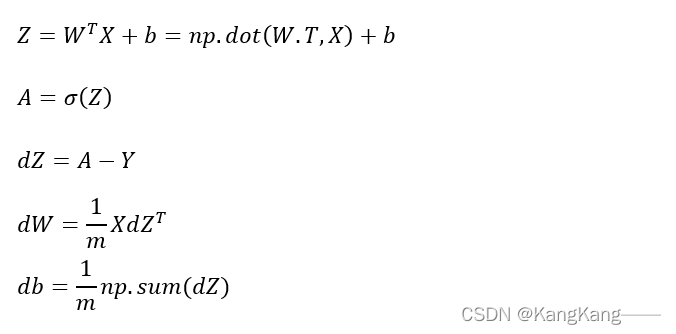

(3)求数据集m项向量化的Logistic回归的梯度计算过程

(向量化可以去显示for循环,加快运行速度)

更新参数,为下次迭代做准备:

4104

4104

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?