Tensorflow_gpu安装_windows系统下用GPU训练tensorflow模型

为了后续的实验,需要使用Tensorflow_gpu,故记录一下实验环境的安装过程,下面是环境所需各个库的版本

cudatoolkit==10.0.130

cudnn==7.6.5

gensim==3.4.0

huggingface-hub==0.16.4

imbalanced-learn==0.9.0 数据不平衡

keras==2.2.5

myutils==0.0.21

python==3.7.10

scikit-learn==1.0.2

TensorFlow-gpu==1.15.0

torch==1.9.1+cu102

transformers==4.16.2

xgboost==1.6.2

1.关于tensorflow的介绍

2.python环境,由于为了方便管理python版本和库版本的关系,使用Anaconda来代替

点击 Anaconda的下载地址可以下载

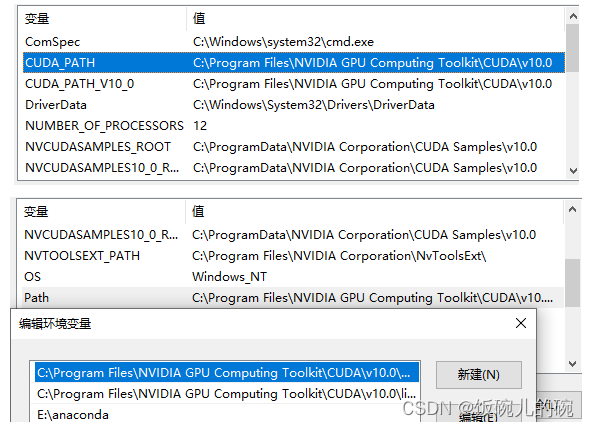

如果没有自动帮你设置环境变量的话,按照下面图片自己设置就好了

添加镜像源(方便后续库的安装)

进行cmd:输入

conda config --add channels https://mirrors.tuna.tsinghua.edu.cn/anaconda/pkgs/free/

conda config --add channels https://mirrors.tuna.tsinghua.edu.cn/anaconda/pkgs/main/

conda config --add channels https://mirrors.tuna.tsinghua.edu.cn/anaconda/cloud/conda-forge/

注意!!!考虑好anaconda的版本选择,虽然可以创建自己需要的python虚拟环境,py版本向下兼容,但也最好别下最新版本,作者实验的python环境是3.7.10,anaconda选择的版本是Anaconda3-2021.05-Windows-x86_64.exe点击即可下载,使用的是镜像源。会比官网下载得快,其中包含的python版本是3.9.7

3.用conda创建虚拟环境

在这里将要创建一个虚拟的python环境,为了后续tensorflow的使用

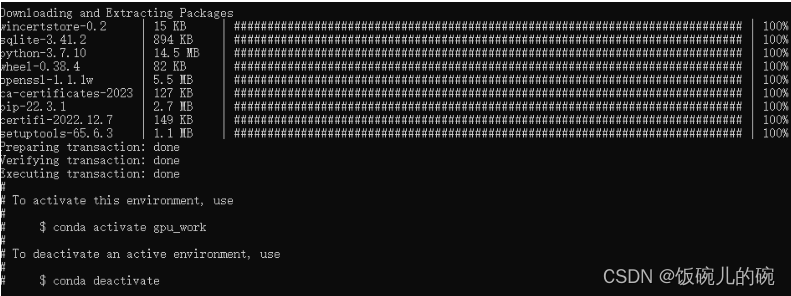

conda create --name gpu_work python==3.7.10

如上图就是创建虚拟环境创建成功了

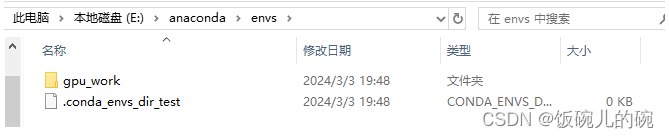

cmd中执行以上命令后,创建一个名为gpu_work的python的虚拟环境,并配备一个版本为3.7.10的python解释器,在你的Anaconda3安装路径下的envs文件夹中应该会出现一个名为gpu_work的一个文件夹,那便是我们刚刚创建好的环境

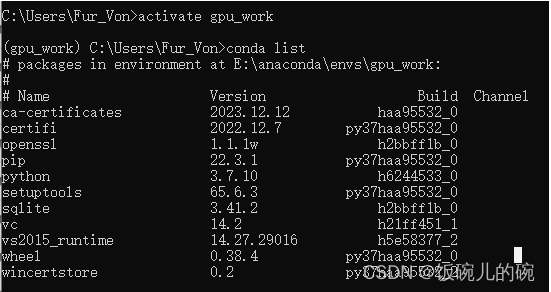

activate gpu_work

再执行以上命令后又可以激活已存在的环境gpu_work,如下图,可以检查一下虚拟环境中一些库的版本号,以此确认是否创建成功

做了以上准备工作,接下里就是正式安装tensorflow了,需要特别注意!的是(cudatoolkit,cudnn,tensorflow-gpu,在当前python版本满足的前提下,三者的版本必须对应正确,否则就无法正常使用GPU!!!)

这里我选择的是最稳妥的方法,也就是cuda,cudnn,tensorflow-gpu分别安装,但是特别注意的是版本要对应

4.cuda安装

CUDA官方下载地址,选择自己对应的版本号即可,我要下载的tensorflow_gpu版本是1.15.0,所以这里cuda我选择10.0的下载

一路默认安装后即可,然后就是环境变量的检查

检查没问题后CUDA就安装成功了

5.cudnn安装

https://developer.nvidia.com/rdp/cudnn-archive这是cudnn的官方下载地址,第一次单击下载时,会让你先注册登录,然后再进行下载,注册信息就正常填写就行,我要下载的tensorflow_gpu版本是1.15.0,所以这里cudnn我选择7.6.5的下载

官网下载慢,而且需要登录账号,从国内镜像源下载后解压,再复制到对应文件夹即可。网址https://mirrors.tuna.tsinghua.edu.cn/anaconda/pkgs/main/win-64/

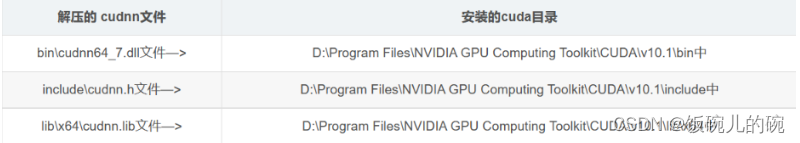

下载完成后,这里我们需要把cudnn里的三个文件移动或者copy到cuda的对应文件夹里面去

自此cudnn的安装也成功完成

6.tensorflow-gpu的安装

直接win+R打开cmd,先activate激活并进入到我们创建的python环境中去:选择合适的版本**(必须和cuda和cudnn版本对应)**

pip install tensorflow-gpu==1.15.0-i https://pypi.tuna.tsinghua.edu.cn/simple

自此就全部安装成功了

参考:

1245

1245

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?