MING 大模型简介

MING [1] 是上海交通大学未来媒体网络协同创新中心和上海人工智能实验室智慧医疗中心合作研发的、基于Transformer架构的大规模智能对话系统。该模型具有优秀的医疗场景下的对话生成和理解能力,该项目目前已在github上开源。

MING大模型调研

1. 调研

MING-MOE是基于 Transformer 架构的大规模智能对话系统,旨在提供强大的对话生成和理解能力,涵盖广泛的知识领域,特别适用于医疗领域的智能问答和对话场景。该模型是一种新的基于混合专家(Mixture-of-Experts, MOE)的医学大型语言模型MING-MOE,进一步优化了医疗多任务学习的能力,MING-MOE采用混合低秩自适应(MoLoRA)技术。研究团队已证明,MING-MOE在超过20项医疗任务上达到了最先进的性能,这表明它比现有模型有了显著的改进。该方法不仅扩展了医学语言模型的功能,而且提高了推理效率[2]。

2. 集成到智慧医生问答系统

为了将 MING 大模型集成到基于 Spring Boot 的智慧医生问答系统中,本小组考虑按照以下步骤进行:首先从 MING-MOE 模型的官方文档或相关资源中获取模型的 API 接口地址和认证信息。

然后,在的 Spring Boot 项目中引入适当的 HTTP 客户端库,比如 Apache HttpClient 或 Spring 的 RestTemplate,以便进行 API 请求的发送和接收。根据 MING-MOE 模型的接口规范,构建正确的请求,包括所需的输入数据和参数。发送 HTTP 请求到 MING-MOE 模型的 API 接口,并处理返回的结果。

最后,根据模型返回的结果,解析其中包含的对话信息或其他相关数据,进行适当的处理和展示。

不过初步阅读代码发现,MING并不提供现成的API(有待进一步调研),先尝试本地部署MING。

3. 实践:本地部署MING

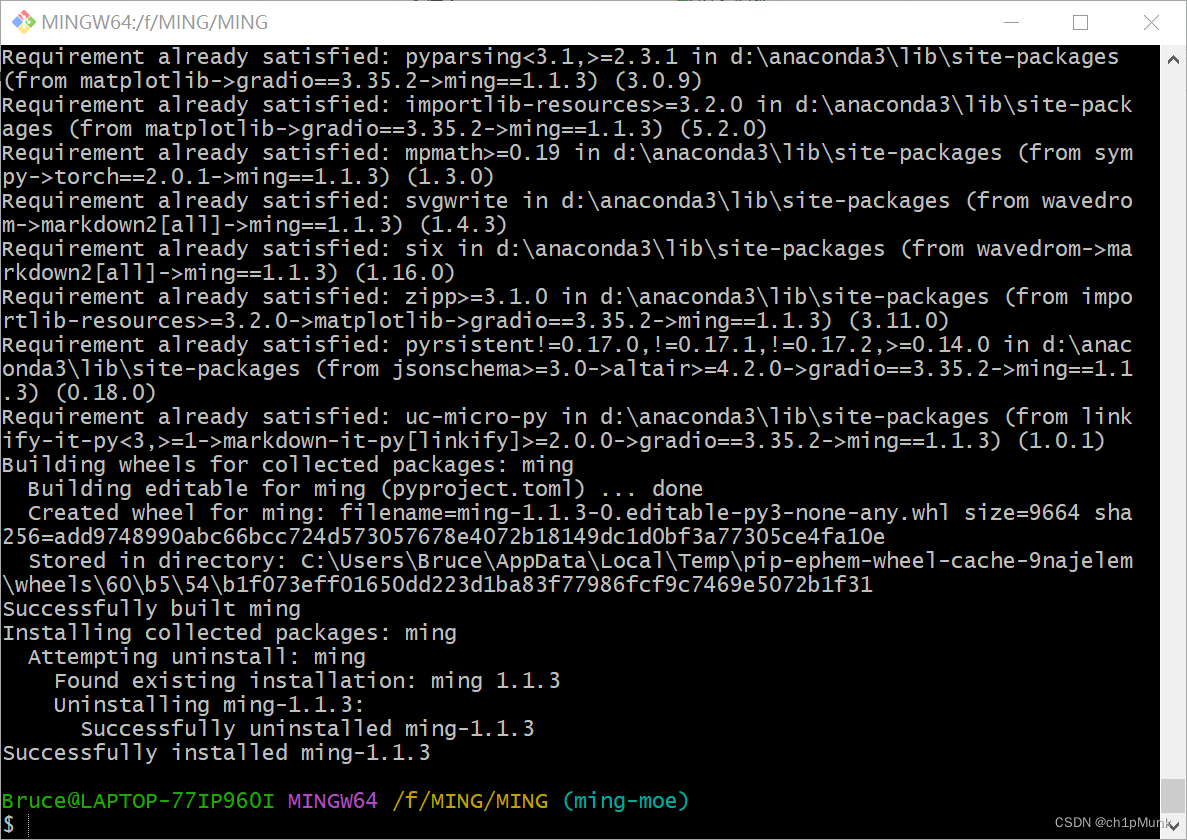

3.1 安装项目依赖[1]

git clone https://github.com/MediaBrain-SJTU/MING

cd MING

pip install -e .

安装成功。

3.2 下载模型参数并运行

CUDA_VISIBLE_DEVICES=0 python -m fastchat.serve.cli \

--model_path {path_to_checkpoint} \ # 模型路径

--model_base {path_to_base_model} \ # 基座模型路径

--max-new-token 3072 # 输出最大长度

4. 参考文献

[1] MediaBrain-SJTU/MING: 明医 (MING):中文医疗问诊大模型 (github.com)

[3]

@misc{liao2024mingmoe,

title={MING-MOE: Enhancing Medical Multi-Task Learning in Large Language Models with Sparse Mixture of Low-Rank Adapter Experts},

author={Yusheng Liao and Shuyang Jiang and Yu Wang and Yanfeng Wang},

year={2024},

eprint={2404.09027},

archivePrefix={arXiv},

primaryClass={cs.CL}

}

1450

1450

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?