学好 Python 不论是就业还是做副业赚钱都不错,但要学会 Python 还是要有一个学习规划。最后大家分享一份全套的 Python 学习资料,给那些想学习 Python 的小伙伴们一点帮助!

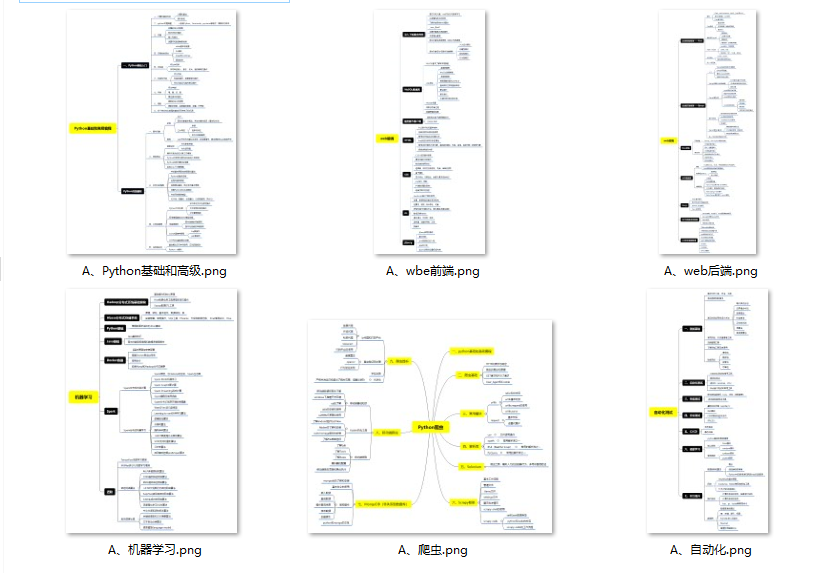

一、Python所有方向的学习路线

Python所有方向路线就是把Python常用的技术点做整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照上面的知识点去找对应的学习资源,保证自己学得较为全面。

二、学习软件

工欲善其事必先利其器。学习Python常用的开发软件都在这里了,给大家节省了很多时间。

三、全套PDF电子书

书籍的好处就在于权威和体系健全,刚开始学习的时候你可以只看视频或者听某个人讲课,但等你学完之后,你觉得你掌握了,这时候建议还是得去看一下书籍,看权威技术书籍也是每个程序员必经之路。

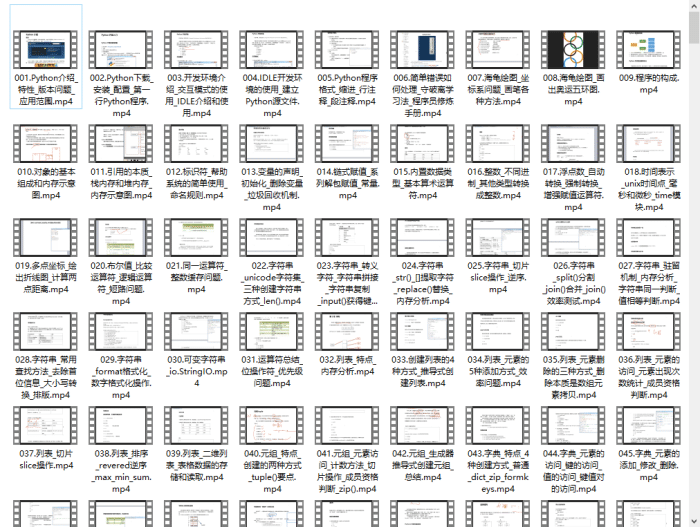

四、入门学习视频

我们在看视频学习的时候,不能光动眼动脑不动手,比较科学的学习方法是在理解之后运用它们,这时候练手项目就很适合了。

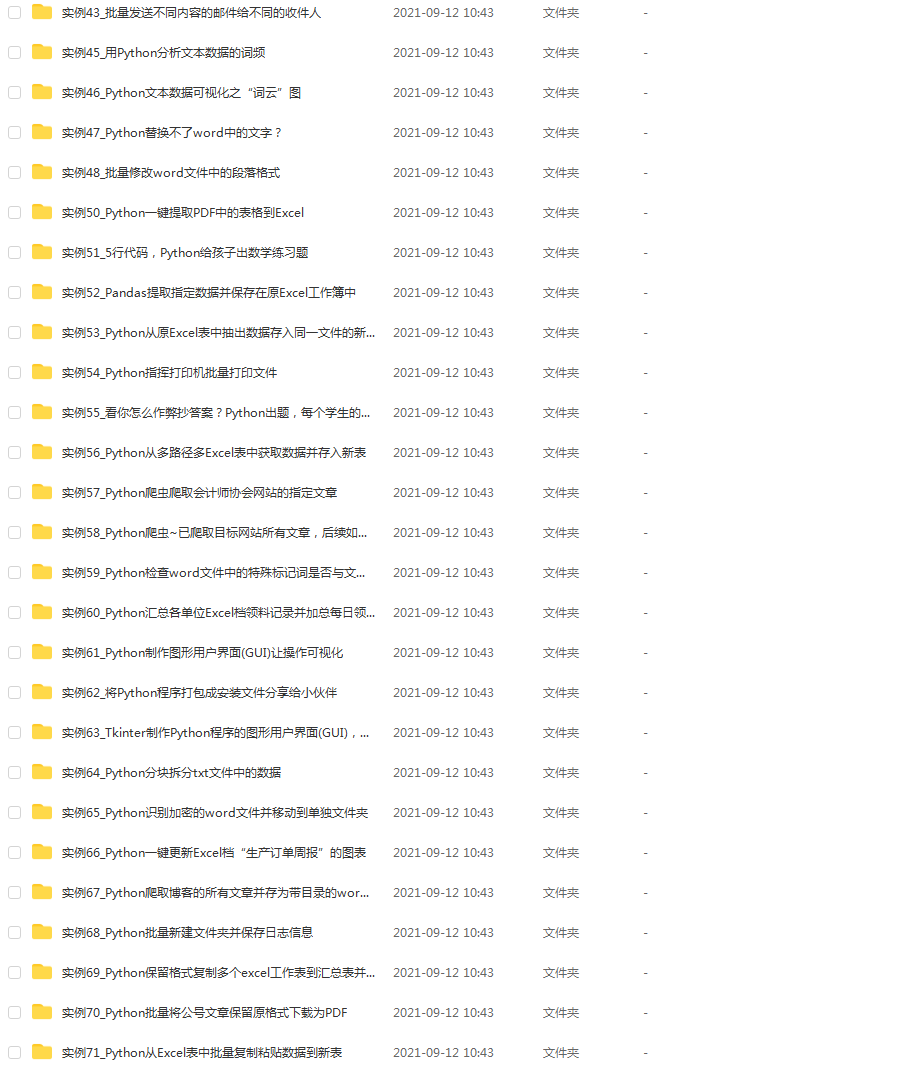

五、实战案例

光学理论是没用的,要学会跟着一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

六、面试资料

我们学习Python必然是为了找到高薪的工作,下面这些面试题是来自阿里、腾讯、字节等一线互联网大厂最新的面试资料,并且有阿里大佬给出了权威的解答,刷完这一套面试资料相信大家都能找到满意的工作。

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

组

步骤:

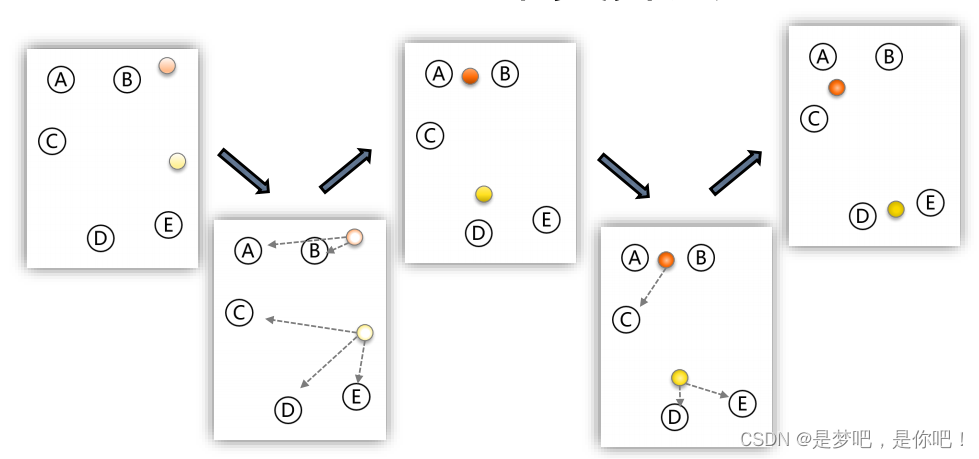

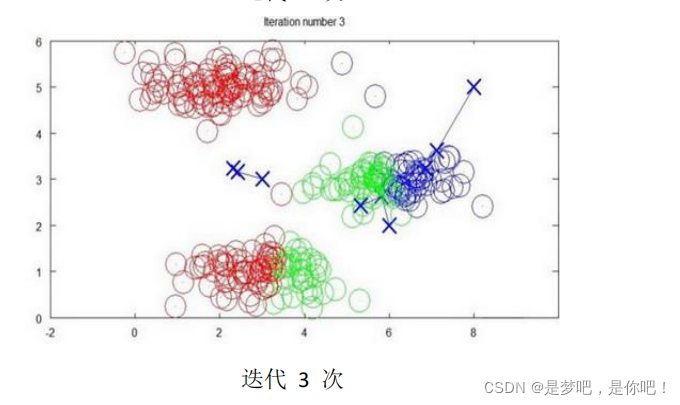

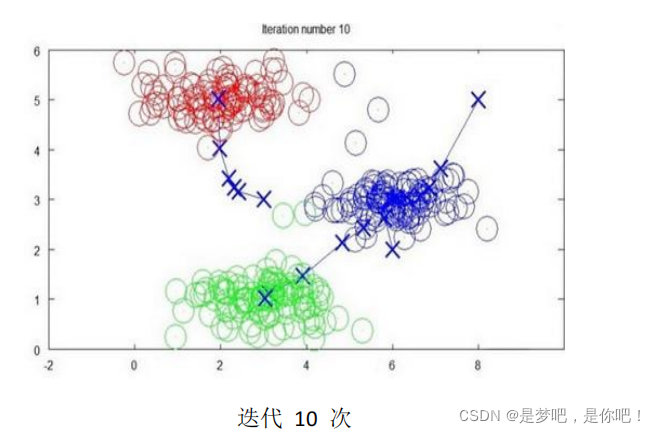

- 设定 K 个类别的中心的初值;

- 计算每个样本到 K个中心的距离,按最近距离进行分类;

- 以每个类别中样本的均值,更新该类别的中心;

- 重复迭代以上步骤,直到达到终止条件(迭代次数、最小平方误差、簇中心点变化率)。

- 下面是一个聚类示例:

K-means聚类算法

K-****均值算法的伪代码如下:

Repeat {

for i = 1 to m

c(i) := index (form 1 to K) of cluster centroid closest to x(i)

for k = 1 to K

μk := average (mean) of points assigned to cluster k

}

算法分为两个步骤,第一个 for 循环是赋值步骤,即:对于每一个样例 i ,计算其应该属

于的类。第二个 for 循环是聚类中心的移动,即:对于每一个类K ,重新计算该类的质心。

from sklearn.cluster import KMeans # 导入 sklearn.cluster.KMeans 类

import numpy as np

X = np.array([[1,2], [1,4], [1,0], [10,2], [10,4], [10,0]])

kmCluster = KMeans(n_clusters=2).fit(X) # 建立模型并进行聚类,设定 K=2

print(“聚类中心坐标:”,kmCluster.cluster_centers_) # 返回每个聚类中心的坐标

print(“分类结果:”,kmCluster.labels_) # 返回样本集的分类结果

print(“显示预测判断:”,kmCluster.predict([[0, 0], [12, 3]])) # 根据模型聚类结果进行预测判断

聚类中心坐标: [[10. 2.]

[ 1. 2.]]

分类结果: [1 1 1 0 0 0]

显示预测判断: [1 0]

Process finished with exit code 0

2.2 针对大样本集的改进算法:Mini Batch K-Means

对于样本集巨大的问题,例如样本量大于 10万、特征变量大于100,K-Means算法耗费的速度和内存很大。SKlearn 提供了针对大样本集的改进算法 Mini Batch K-Means,并不使用全部样本数据,而是每次抽样选取小样本集进行 K-Means聚类,进行循环迭代。Mini Batch K-Means 虽然性能略有降低,但极大的提高了运行速度和内存占用。

from sklearn.cluster import MiniBatchKMeans # 导入 .MiniBatchKMeans 类

import numpy as np

X = np.array([[1,2], [1,4], [1,0], [4,2], [4,0], [4,4],

[4,5], [0,1], [2,2],[3,2], [5,5], [1,-1]])

fit on the whole data

mbkmCluster = MiniBatchKMeans(n_clusters=3,batch_size=6,max_iter=10).fit(X)

print(“聚类中心的坐标:”,mbkmCluster.cluster_centers_) # 返回每个聚类中心的坐标

print(“样本集的分类结果:”,mbkmCluster.labels_) # 返回样本集的分类结果

print(“显示判断结果:样本属于哪个类别:”,mbkmCluster.predict([[0,0], [4,5]])) # 根据模型聚类结果进行预测判断

聚类中心的坐标: [[ 2.55932203 1.76271186]

[ 0.75862069 -0.20689655]

[ 4.20588235 4.5 ]]

样本集的分类结果: [0 0 1 0 0 2 2 1 0 0 2 1]

显示判断结果:样本属于哪个类别: [1 2]

Process finished with exit code 0

2.3 图像

from sklearn.cluster import kmeans_plusplus

from sklearn.datasets import make_blobs

import matplotlib.pyplot as plt

Generate sample data

n_samples = 4000

n_components = 4

X, y_true = make_blobs(

n_samples=n_samples, centers=n_components, cluster_std=0.60, random_state=0

)

X = X[:, ::-1]

Calculate seeds from kmeans++

centers_init, indices = kmeans_plusplus(X, n_clusters=4, random_state=0)

Plot init seeds along side sample data

plt.figure(1)

colors = [“#4EACC5”, “#FF9C34”, “#4E9A06”, “m”]

for k, col in enumerate(colors):

cluster_data = y_true == k

plt.scatter(X[cluster_data, 0], X[cluster_data, 1], c=col, marker=“.”, s=10)

plt.scatter(centers_init[:, 0], centers_init[:, 1], c=“b”, s=50)

plt.title(“K-Means++ Initialization”)

plt.xticks([])

plt.yticks([])

plt.show()

3 案例1

3.1 代码

-- coding: utf-8 --

import numpy as np

import pandas as pd

from sklearn.cluster import KMeans, MiniBatchKMeans

def main():

读取数据文件

file = pd.read_excel(‘K-Means.xlsx’, header=0) # 首行为标题行

file = file.dropna() # 删除含有缺失值的数据

print(file.dtypes) # 查看 df 各列的数据类型

print(file.shape) # 查看 df 的行数和列数

print(file.head())

数据准备

z_scaler = lambda x:(x-np.mean(x))/np.std(x) # 定义数据标准化函数

dfScaler = file[[‘D1’,‘D2’,‘D3’,‘D4’,‘D5’,‘D6’,‘D7’,‘D8’,‘D9’,‘D10’]].apply(z_scaler) # 数据归一化

dfData = pd.concat([file[[‘地区’]], dfScaler], axis=1) # 列级别合并

df = dfData.loc[:,[‘D1’,‘D2’,‘D3’,‘D4’,‘D5’,‘D6’,‘D7’,‘D8’,‘D9’,‘D10’]] # 基于全部 10个特征聚类分析

df = dfData.loc[:,[‘D1’,‘D2’,‘D7’,‘D8’,‘D9’,‘D10’]] # 降维后选取 6个特征聚类分析

X = np.array(df) # 准备 sklearn.cluster.KMeans 模型数据

print(“Shape of cluster data:”, X.shape)

KMeans 聚类分析(sklearn.cluster.KMeans)

nCluster = 4

kmCluster = KMeans(n_clusters=nCluster).fit(X) # 建立模型并进行聚类,设定 K=4

print(“Cluster centers:\n”, kmCluster.cluster_centers_) # 返回每个聚类中心的坐标

print(“Cluster results:\n”, kmCluster.labels_) # 返回样本集的分类结果

整理聚类结果(太棒啦!)

listName = dfData[‘地区’].tolist() # 将 dfData 的首列 ‘地区’ 转换为 list

dictCluster = dict(zip(listName,kmCluster.labels_)) # 将 listName 与聚类结果关联,组成字典

listCluster = [[] for k in range(nCluster)]

for v in range(0, len(dictCluster)):

k = list(dictCluster.values())[v] # 第v个城市的分类是 k

listCluster[k].append(list(dictCluster.keys())[v]) # 将第v个城市添加到 第k类

print(“\n聚类分析结果(分为{}类):”.format(nCluster)) # 返回样本集的分类结果

for k in range(nCluster):

print(“第 {} 类:{}”.format(k, listCluster[k])) # 显示第 k 类的结果

return

if name == ‘main’:

main()

(1)python中apply函数python中apply函数")

(2)Pandas中DataFrame数据合并、连接(concat、merge、join)Pandas中DataFrame数据合并、连接(concat、merge、join)")

(3)Python pandas 中loc函数的意思及用法,及跟iloc的区别Python pandas 中loc函数的意思及用法,及跟iloc的区别")

(4)tolist函数 其他形式(数组或者矩阵等)转为列表形式tolist函数 其他形式(数组或者矩阵等)转为列表形式")

(5)利用zip函数将两个列表(list)组成字典(dict)利用zip函数将两个列表(list)组成字典(dict)")

3.2 结果

地区 D1 D2 D3 D4 D5 D6 D7 D8 D9 D10

0 北京 5.96 310 461 1557 931 319 44.36 2615 2.20 13631

1 上海 3.39 234 308 1035 498 161 35.02 3052 0.90 12665

2 天津 2.35 157 229 713 295 109 38.40 3031 0.86 9385

3 陕西 1.35 81 111 364 150 58 30.45 2699 1.22 7881

4 辽宁 1.50 88 128 421 144 58 34.30 2808 0.54 7733

Shape of cluster data: (30, 10)

Cluster centers:

[[-3.04626787e-01 -2.89307971e-01 -2.90845727e-01 -2.88480032e-01

-2.85445404e-01 -2.85283077e-01 -6.22770669e-02 1.12938023e-03

-2.71308432e-01 -3.03408599e-01]

[ 4.44318512e+00 3.97251590e+00 4.16079449e+00 4.20994153e+00

4.61768098e+00 4.65296699e+00 2.45321197e+00 4.02147595e-01

4.22779099e+00 2.44672575e+00]

[ 1.52987871e+00 2.10479182e+00 1.97836141e+00 1.92037518e+00

1.54974999e+00 1.50344182e+00 1.13526879e+00 1.13595799e+00

8.39397483e-01 1.38149832e+00]

[ 4.17353928e-01 -6.60092295e-01 -5.55528420e-01 -5.50211065e-01

-2.95600461e-01 -2.42490616e-01 -3.10454580e+00 -2.70342746e+00

1.14743326e+00 2.67890118e+00]]

Cluster results:

[1 2 2 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 3 0 0 0 0 0]

聚类分析结果(分为4类):

第 0 类:[‘陕西’, ‘辽宁’, ‘吉林’, ‘黑龙江’, ‘湖北’, ‘江苏’, ‘广东’, ‘四川’, ‘山东’, ‘甘肃’, ‘湖南’, ‘浙江’, ‘新疆’, ‘福建’, ‘山西’, ‘河北’, ‘安徽’, ‘云南’, ‘江西’, ‘海南’, ‘内蒙古’, ‘河南’, ‘广西’, ‘宁夏’, ‘贵州’, ‘青海’]

第 1 类:[‘北京’]

第 2 类:[‘上海’, ‘天津’]

第 3 类:[‘西藏’]

Process finished with exit code 0

4 案例2

4.1 案例——数据

(1)数据介绍:

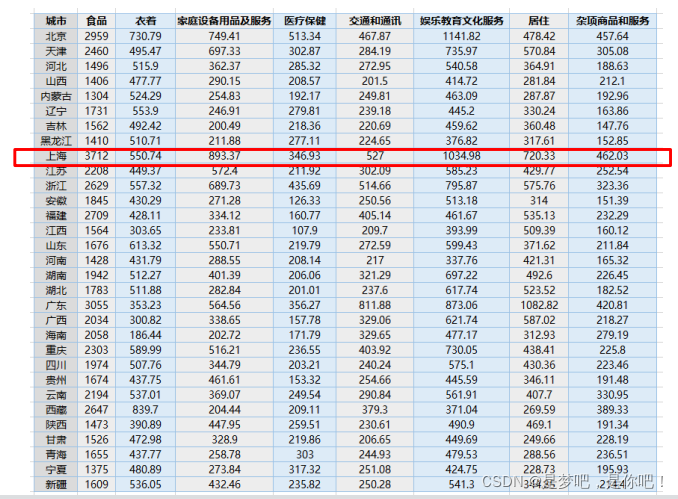

现有1999年全国31个省份城镇居民家庭平均每人全年消费性支出的八个主要变量数据,这八个变量分别是:食品、衣着、家庭设备用品及服务、医疗保健、交通和通讯、娱乐教育文化服务、居住以及杂项商品和服务。利用已有数据,对31个省份进行聚类。

(2)实验目的:

通过聚类,了解 1999 年各个省份的消费水平在国内的情况

1999年全国31个省份城镇居民家庭平均每人全年消费性支出数据

4.2 代码

#*1. 建立工程,导入sklearn相关包==============**

import numpy as np

from sklearn.cluster import KMeans

#*==2. 加载数据,创建K-means算法实例,并进行训练,获得标签**

def loadData(filePath):

fr = open(filePath, 'r+') #r+:读写打开一个文本文件

lines = fr.readlines() #.readlines() 一次读取整个文件(类似于 .read() ) .readline() 每次只读.readlines() 慢得多。

retData = [] #retData:用来存储城市的各项消费信息

retCityName = [] #retCityName:用来存储城市名称

for line in lines:

items = line.strip().split(",")

retCityName.append(items[0])

文末有福利领取哦~

👉一、Python所有方向的学习路线

Python所有方向的技术点做的整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照上面的知识点去找对应的学习资源,保证自己学得较为全面。

👉二、Python必备开发工具

👉三、Python视频合集

观看零基础学习视频,看视频学习是最快捷也是最有效果的方式,跟着视频中老师的思路,从基础到深入,还是很容易入门的。

👉 四、实战案例

光学理论是没用的,要学会跟着一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。(文末领读者福利)

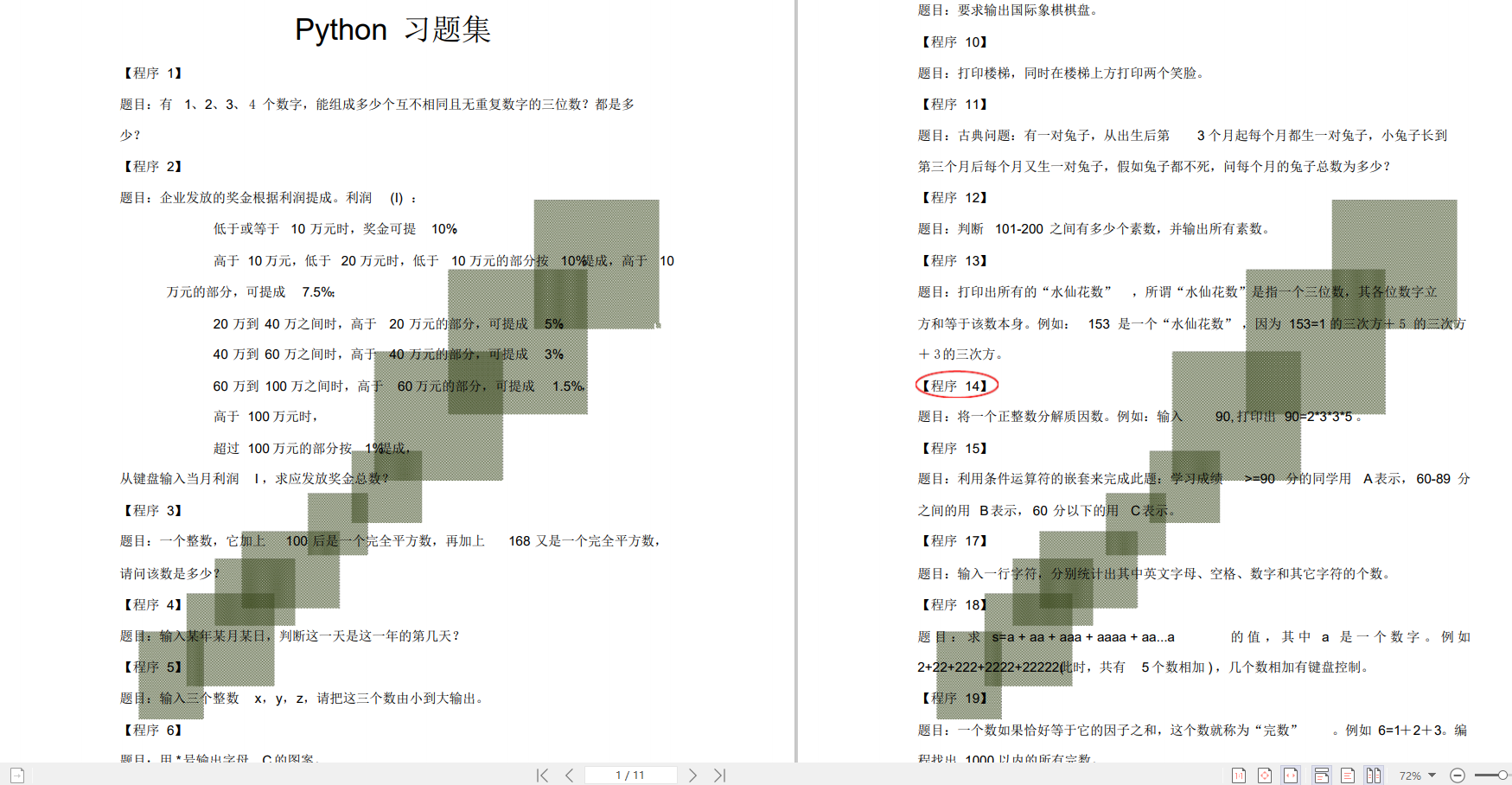

👉五、Python练习题

检查学习结果。

👉六、面试资料

我们学习Python必然是为了找到高薪的工作,下面这些面试题是来自阿里、腾讯、字节等一线互联网大厂最新的面试资料,并且有阿里大佬给出了权威的解答,刷完这一套面试资料相信大家都能找到满意的工作。

👉因篇幅有限,仅展示部分资料,这份完整版的Python全套学习资料已经上传

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

956

956

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?