摘要:历史上,科学发现一直是一个漫长且昂贵的过程,从最初的构思到最终结果,需要大量的时间和资源。为了加快科学发现的步伐,降低研究成本,提高研究质量,我们引入了智能体实验室,这是一个基于自主LLM的框架,能够完成整个研究过程。该框架接受人类提供的研究想法,并通过三个阶段——文献综述、实验和报告撰写来生成包括代码库和研究报告在内的全面研究成果,同时允许用户在每个阶段提供反馈和指导。我们使用各种最先进的LLM部署智能体实验室,并邀请多位研究人员通过参与调查来评估其质量,提供人类反馈以指导研究过程,然后评估最终论文。

我们发现:

(1)由o1-preview驱动的Agent实验室产生了最佳的研究成果;

(2)生成的机器学习代码能够达到与现有方法相比的最先进性能;(3)人类的参与,在每个阶段提供反馈,显著提高了整体研究质量;(4)智能体实验室大大降低了研究费用,与以前的自主研究方法相比,减少了84%。我们希望Agent实验室能让研究人员将更多精力投入创意构思,而不是低层次编码和写作,从而加速科学发现。

https://AgentLaboratory.github.io

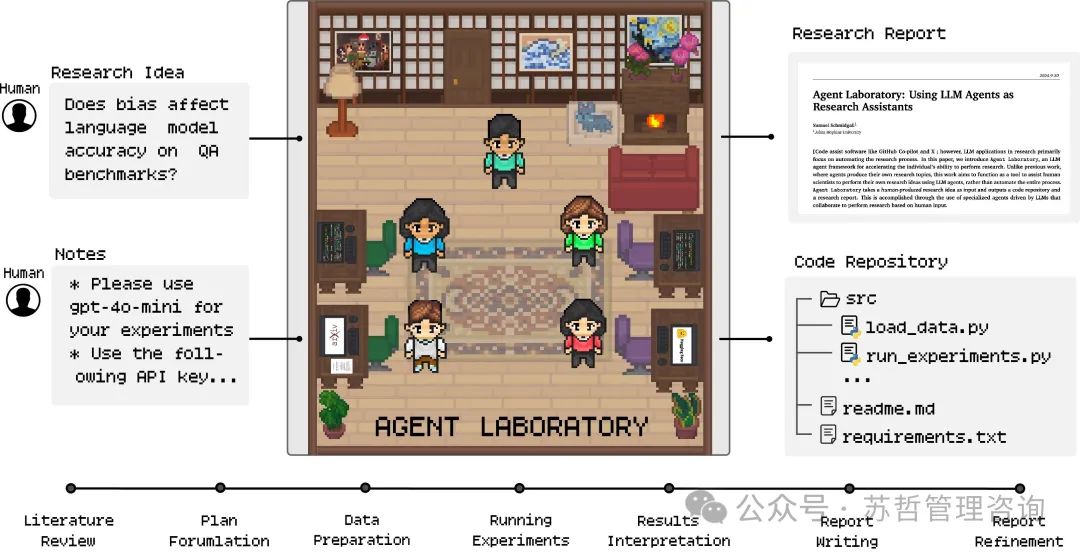

图1 |智能体实验室接受人类研究想法和一组笔记作为输入,将其提供给一系列专门的LLM驱动智能体的管道,并生成研究报告和代码存储库。

目录

1.简介

2.背景和相关工作

3.智能体实验室

3.1.文献综述

3.2.实验进行

3.3.报告撰写

**3.3.1.**自主模式与副驾驶模式:

4.结果

4.1.语言模型对质量的评估

4.1.1.人工审核员评分由语言模型确定

4.2.评估副驾驶质量

4.2.1.质量作为一种工具

4.2.2.生成论文副驾驶评估

4.3运行时统计

5.限制条件

5.1.工作流程限制

5.2.常见故障模式

5.3.道德考虑

6.讨论

参考文献

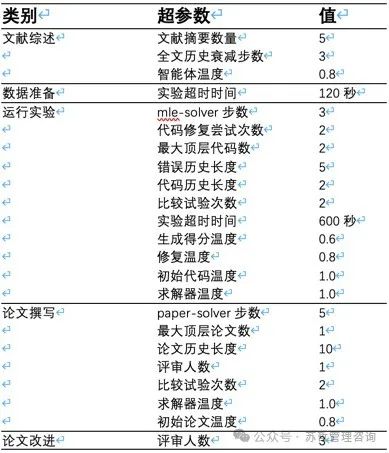

A.智能体实验室配置

A.1.超参数

A.2.硬件

B提示

B.1.基础推断提示基础系统提示

B.2.上下文提示

B.3.智能体程序阶段描述

B.3.1.博士阶段学生

B.4.机器学习工程师阶段描述 ML工程师数据准备阶段提示

B.5博士后阶段描述

B.6.智能体指令描述

B.6.1.博士研究生命令说明

B.6.2. ML工程师智能体命令描述

B.6.3.博士后智能体指令描述

B.7.智能体人角色描述

B.7.1.博士研究生角色描述博士研究生角色提示

B.7.2.机器学习工程师角色描述机器学习工程师角色提示

B.7.3.教授智能体

B.7.4.博士后智能体人角色描述博士后角色提示

B.8. mle-solver提示

B.8.1.工具 mle-solver替换工具

B.9.纸张求解器提示纸张替换工具

B.9.1.按节小贴士

1.简介

科学家经常面临限制,这限制限制了他们可以在任何特定时间内探索的研究想法数量,导致想法根据预测的影响进行优先考虑。虽然这个过程有助于确定哪些概念值得投入时间和如何最有效地分配有限资源,但许多高质量的想法仍然未被探索。如果探索想法的过程限制更少,研究人员将能够同时调查多个概念,从而增加科学发现的可能性。

为了实现这一目标,最近的工作探讨了LLM能够进行研究构思和自动论文撰写的能力,其中LLM智能体扮演人类科学家的角色。

(Baek等人(2024年); Ghafarollahi & Buehler(2024b年); Lu等人(2024a年); Swanson等人(2024年)). Baek等人(2024年)的工作介绍了ResearchAgent,该系统可以自动生成研究想法、方法和实验设计,并通过多个审阅智能体的反馈进行迭代改进,这些智能体模拟同行讨论,并利用与人类对齐的评估标准来提高输出质量。Lu等人(2024a年)探讨了完全自动化的论文生成,其中AI科学家框架生成新颖的研究想法,编写代码,进行实验,并使用自动化的同行评审系统创建完整的科学论文来评估工作。尽管这些工作表明当前的LLMs能够生成被判断为比人类专家产生的想法更新颖的想法,但Si等人(2024年)指出,LLMs仍在可行性和实施细节上存在弱点,建议LLMs在研究中起到补充而非替代的作用。因此,我们的目标是设计一个可以帮助人类实现他们自己的研究想法的自主智能体管道。

在这项工作中,我们推出了Agent Laboratory,这是一个自主流水线,可以加快个人进行机器学习研究的能力。与先前的方法不同,先前的方法中,智能体者独立于人类的输入参与他们自己的研究构思(Baek等人(2024年);Lu等人(2024b年)),而Agent Laboratory旨在帮助人类科学家执行他们自己的研究想法,使用语言智能体者。Agent Laboratory接受人类研究想法作为输入,并输出由自主语言智能体者生成的研究报告和代码存储库,允许各种不同程度的人类参与,在用户偏好的频率下提供反馈。我们的贡献详细列表如下:

1.我们介绍智能体实验室,这是一个开源的LLM智能体框架,用于加速个人在机器学习研究中的能力。为了适应所有用户,智能体实验室具有计算灵活性,可以根据个人对计算资源(例如CPU、GPU、内存)和模型推断预算的访问权限分配各种计算级别。

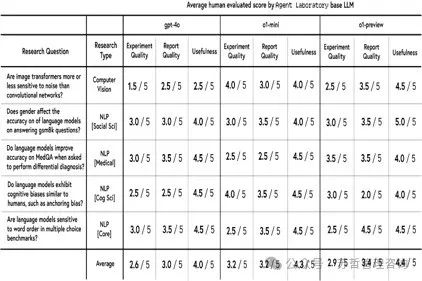

2.人类评估者评价了使用智能体实验室生成的论文在实验质量、报告质量和实用性上的表现,结果显示,虽然o1-preview后端被认为是最有用的,o1-mini获得了最高的实验质量评分,而gpt-4o在所有指标上都落后。

3.NeurIPS风格的评估显示,与其他后端相比,o1-preview在清晰度和准确性方面表现最好,根据人类评审人员的评价。然而,人工评估和自动评估之间出现了明显的差距,自动评分明显高估了质量(整体得分为6.1/10对比3.8/10)。在清晰度和贡献度指标上也出现了类似的差异,这表明需要人类反馈来补充自动评估,以便更准确地评估研究质量。Co-pilot模式在Agent实验室中对自定义和预先选择的主题进行了评估,显示出与自主模式相比更高的总体得分。Co-pilot论文也有一些权衡取舍。在实验质量和实用性方面存在挑战,反映了在调整智能体输出与研究者意图之间的困难。

4.智能体实验室中的副驾驶功能在人类用户评价中被发现整体上具有很高的实用性和可用性,在体验后大多数参与者决定继续使用。

5.不同模型后端的详细成本和推理时间统计数据,以及每个论文阶段的成本分解被呈现出来,展示了Agent Laboratory相比其他作品提供了更具性价比的自动研究(仅每篇论文2.33美元,使用gpt-4o后端)。

6.在MLE-Bench挑战的一个子集上,使用提出的mle-solver取得了最先进的性能,相比其他方案实现了更高的一致性和得分,并获得了比MLAB、OpenHands和AIDE更多的奖牌,包括金牌和银牌。

我们希望这项工作能够推动机器学习领域的科学发现加速。

让研究人员能够将更多精力投入创造性构思和实验设计,而不是低级别的编码和写作。

2.背景和相关工作

大语言模型:本文中的研究智能体建立在自回归大语言模型(LLMs)基础上,这些模型经过广泛文本语料库的训练,用于预测令牌序列的条件概率,𝑝(𝑥𝑡|𝑥<𝑡; 𝜃),并通过抽样生成文本完成,其中𝑥𝑡 ∼ softmax(𝑊 · ℎ𝑡)。

以𝐡𝐭作为隐藏状态,𝐖作为学习的权重矩阵,用于映射到标记概率。LLMs利用变压器架构(Vaswani(2017))来捕获文本中的长程依赖关系。这些模型,如Claude(Anthropic(2024)),Llama(Dubey等人(2024);Touvron等人(2023a,b)),以及ChatGPT(Achiam等人(2023);Hurst等人(2024);OpenAI(2022)),利用大量数据集和扩展技术,从而使它们能够执行各种基于语言的任务,如翻译,摘要和推理,通过将预训练期间学到的模式推广到新的输入(Brown (2020))。

**LLM Agent虽然展示出了强大的理解和推理能力,但在实际场景中执行任务时面临一些挑战。**为了克服这些限制,通过结构化框架来扩展它们的能力,使它们能够自主和半自主地执行任务(Chen等,2023b; Li等,2023; Qian等,2024; Wu等,2023)。这些系统被称为agents,利用了诸如思路链提示(Wei等,2022),迭代改进(Shinn等,2024),自我改进(Huang等,2022)和外部工具集成等技术来执行复杂的工作流(Hao等,2024; Qin等,2023; Schick等,2023)。LLM agents在解决现实世界中具有重要意义的任务方面取得了显著进展,例如软件工程(Jimenez等,2023; Wang等,2024b; Yang等,2024),网络安全(Abramovich等,2024; Fang等,2024; Wan等,2024)和医学诊断(McDuff等,2023; Schmidgall等,2024; Tu等,2024)。在应用LLM agents解决包括自主机器人学(Black等,2024; Brohan等,2022, 2023; Kim等,2024),网络任务(Deng等,2024; Gur等,2023; He等,2024; Putta等,2024; Shi等,2017)和游戏对战(AL等,2024; Feng等,2024; Wang等,2023)等具体问题方面也取得了进展。更多关于LLM agents的综述,请参考Wang等(2024a)。

自动机器学习 自动机器学习是一个活跃的研究领域,有许多方法专注于使用Kaggle作为评估智能体性能的基准。值得注意的努力包括MLE-Bench(Chan等人(2024年)),DS-bench(Jing等人(2024年))和MLAgentBench(Huang等人(2024年)),它们分别提议使用75个、74个和6个Kaggle挑战作为任务的基准,例如数据准备、模型开发和提交。已经引入了几个可以解决机器学习挑战的"求解器",例如AIDE(Schmidt等人(2024年)),CodeActAgent(也称为"OpenHands")(Wang等人(2024b))和MLAgentBench的ResearchAgent(也称为"MLAB")(Huang等人(2024年)),可以实现自动化功能实现、错误修复和代码重构,并且具有较高的成功率。Agent K(Grosnit等人(2024年))展示了以挑战URL作为输入解决Kaggle挑战的能力。

AI在科学发现中的应用AI已经在各个学科领域支持科学发现数十年。例如,AI已被用于数学发现(Romera-Paredes等人(2024年)),材料科学(Merchant等人(2023年);Pyzer-Knapp等人(2022年);Szymanski等人(2023年)),化学(Hayes等人(2024年);Jumper等人(2021年)),算法发现(Fawzi等人(2022年)),和计算生物学(Ding等人(2024年))。这些方法将AI定位为一种工具。

而不是一个执行自主研究的智能体人。

LLMs在研究相关任务中表现出强大的能力,比如代码生成(Chen等人(2021);Nijkamp等人(2022)),端到端软件开发(Hai等人(2024);Phan等人(2024);Qian等人(2023,2024)),发现的代码生成(Chen等人(2024b);Ghafarollahi&Buehler(2024a);Gu等人(2024);Guo等人(2024);Hu等人(2024b);Ifargan等人(2024);Majumder等人(2024)),研究问题回答(Chen等人(2024a);Lála等人(2023);Lin等人(2024);Song等人(2024)),研究构想(Baek等人(2024);Ghafarollahi&Buehler(2024b);Li等人(2024a);Si等人(2024)),自动论文评审(D’Arcy等人(2024);Liang等人(2024);Lu等人(2024b);Weng等人(2024)),文献搜索(Ajith等人(2024);Kang&Xiong(2024);Li等人(2024b);Press等人(2024)),以及预测实验结果(Ashokkumar等人(2024);Lehr等人(2024);Luo等人(2024);Manning等人(2024);Zhang等人(2024))。尽管LLMs在解决上述任务方面取得了显着进展,构想却一直难以取得进展,一些研究表明LLM的构想比人类更具新颖性(Si等人(2024)),而其他研究显示减少了创造力(Chakrabarty等人(2024))并产生了更大的同质效应(Anderson等人(2024);Zhou等人(2024)),这可能限制了创造性发现而没有人类指导。

此外,关于人工智能与人类协作的研究得出了关于新颖性概念的不同结论(Ashkinaze等人(2024年);Liu等人(2024年);Padmakumar和He(2024年))。这些发现表明,使用目前的LLM系统,最强大的研究系统将结合人类引导的构思与基于LLM的工作流程。

自动研究LLMs最近的进展集中在利用LLMs来模拟研究过程。Swanson等人(2024年)介绍了一支LLM智能团队,他们与人类研究人员一起工作,提供高水平反馈,最终的结果是针对最新冠状病毒变种的新型纳米体结合物。ChemCrow(M. Bran等人(2024年))和Coscientist(Boiko等人(2023年))展示了在化学领域的自主创新和实验能力。ResearchAgent(Baek等人(2024年))自动化研究思路生成、实验设计和通过与人类评估标准一致的审查机构反馈进行迭代改进。AI Scientist(Lu等人(2024a))扩展。

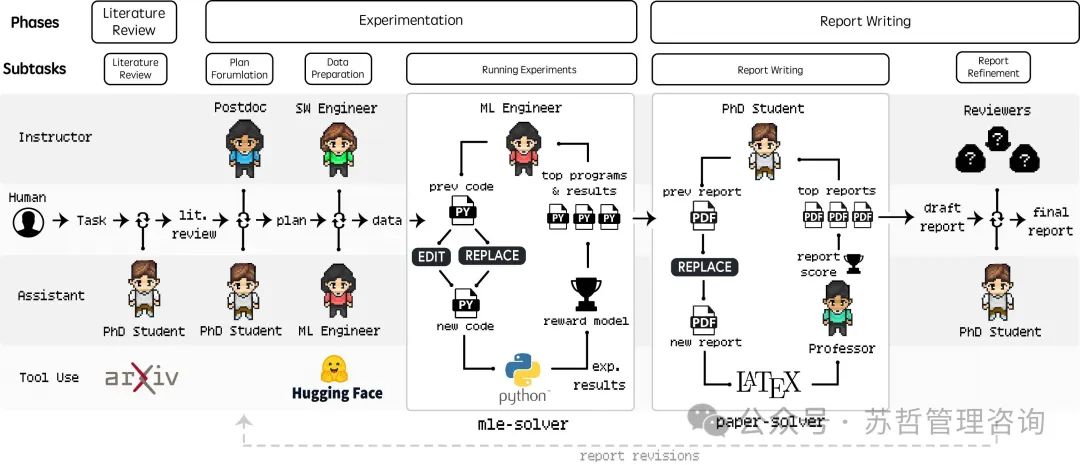

图2 | Agent实验室工作流程。这个图展示了Agent实验室的三个主要阶段:文献综述、实验和报告撰写,每个阶段都包括不同的任务、工具和人-机角色。该流程将人类输入与由LLM驱动的Agent集成在一起,例如博士和博后Agent,负责文献综述、实验计划、数据准备和结果解释。专门的工具如实验求解器和论文生成器自动化繁琐的研究任务,促进人类研究人员与人工智能之间的协作,产生高质量的研究成果。

自动化技术已经包括了从编码、实验执行到自动生成论文的自动同行审查的端到端科学发现。尽管取得了这些进展,Si等人(2024年)这样的研究强调了LLM构思的可行性和实施细节方面的局限性,表明LLMs在自主研究中起补充而非替代的角色。

3.智能体实验室

概述。Agent实验室从独立收集和分析相关研究论文开始,通过协作规划和数据准备逐步进展,最终实现自动化实验和生成全面报告。如图2所示,整体。

**工作流程包括三个主要阶段:(1)文献综述,(2)实验,和(3)报告撰写。**在本节中,我们将详细介绍这些阶段以及涉及的相关主体。另外,在第4节中,我们将进行定性和定量分析,展示Agent Laboratory的优势和生成能力。

3.1.文献综述

**文献综述。**文献综述阶段涉及收集和整理相关研究论文,为给定的研究想法提供参考文献以供后续阶段使用。在此过程中,博士智能体利用arXiv API检索相关论文,并执行三个主要操作:摘要,全文和添加论文。摘要操作检索与智能体生成的初始查询相关的前20篇论文的摘要。全文操作提取特定论文的完整内容,而添加论文操作将选定的摘要或全文纳入综述中。这个过程是迭代的,而不是单步操作,因为智能体执行多个查询,根据内容评估每个论文的相关性,并细化选择以建立全面的综述。一旦通过添加论文命令达到了指定数目的相关文本(N=max),经过整理的综述就可以用于后续阶段。

3.2.实验进行

计划制定。 计划制定阶段的重点是根据文献综述和研究目标创建一个详细的、可操作的研究计划。在这个阶段中,博士和博士后通过对话合作,确定实现研究目标的具体方法,详细说明完成指定研究想法所需的实验组成部分,例如要实现哪些机器学习模型、使用哪些数据集以及实验的高级步骤。一旦达成一致意见,博士后智能体通过使用计划命令提交该计划,该计划将作为后续子任务的一组指令。

**数据准备。**数据准备阶段的目标是编写代码,为运行实验准备数据,使用计划制定阶段的指令作为指导。ML工程师智能体人使用Python命令执行代码,并观察任何输出的内容。ML工程师可以通过搜索HF命令访问HuggingFace数据集。在就最终的数据准备代码达成一致意见后,SW工程师智能体人使用提交代码命令提交。在最终提交之前,代码首先通过Python编译器进行检查,以确保没有编译问题。该过程将被反复执行,直到代码没有错误。

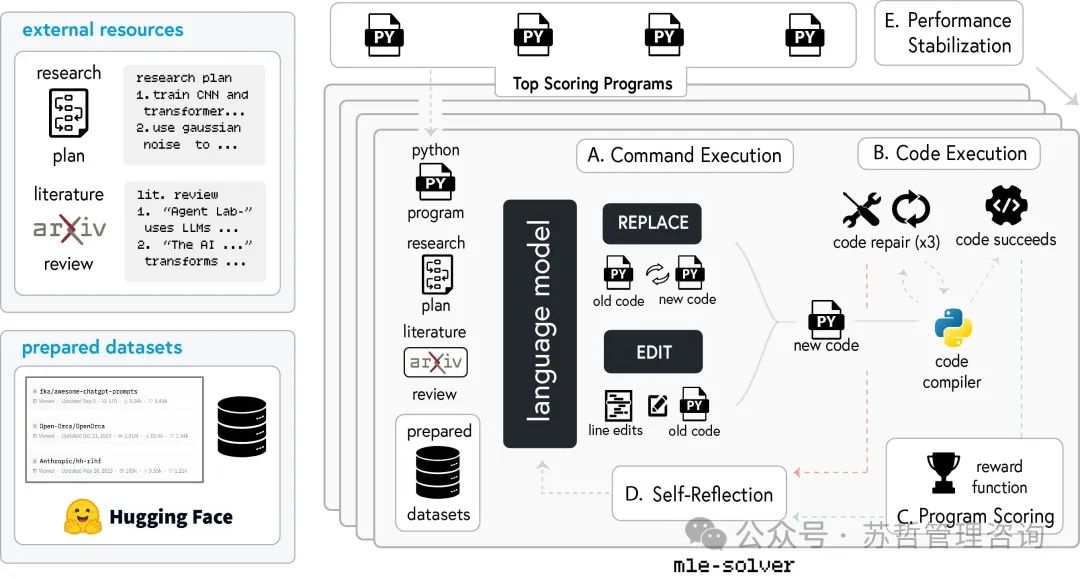

**在进行实验。**在进行实验阶段,ML工程师智能体专注于实施和执行事先制定的实验计划。这得益于mle-solver,这是一个专门设计用于自主生成、测试和优化机器学习代码的模块。mle-solver首先根据研究计划和文献综述的观点生成初始代码。对于第一个mle-solver步骤,程序是空的,必须从头开始生成一个文件,这个文件被用作最高得分的程序。以下过程描述了mle-solver的工作流程:

1.命令执行。在命令执行阶段,从维护的一组性能最佳的程序中随机选择一个初始程序,并在初始化过程中以单个文件表示。mle-solver通过两种操作,替换(REPLACE)和编辑(EDIT),迭代地改进这个程序以更好地与实验目标对齐。编辑操作识别一系列行,用新生成的代码替换指定行号之间的代码。相比之下,替换操作生成一个全新的Python文件。

2.**代码执行。**在执行代码命令后,新程序将通过编译器进行检查以查找运行时错误。如果成功编译,将返回一个分数,并且如果分数高于现有程序,则更新顶部程序列表。如果代码无法编译,智能体将尝试修复代码𝑁𝑟𝑒𝑝次(在我们的实验中为𝑁𝑟𝑒𝑝=3),然后返回错误并继续进行新的代码替换。

3.**程序评分。**如果一段代码成功编译,它将被发送到一个评分函数,该函数确定其是否比先前实施的实验代码更好。为了获得程序评分,我们实现一个评分函数,该函数使用一个LLM奖励模型来评估由mle-solver生成的ML代码的有效性。作为LM调用的奖励模型会根据所概述的研究计划、生成的代码和观察到的输出,在0到1的范围内对程序进行评分,以确定程序如何准确地遵守。

图3 | mle-solver工作流程概述。该图详细介绍了MLE-Solver使用的迭代过程,用以自主生成机器学习代码。从外部资源开始,工作流程整合了命令执行(A),生成新代码,然后执行代码(B),以编译和修复问题(如有必要)。程序评分(C)使用奖励函数评估生成的代码,而自我反思(D)有助于根据结果改进未来的迭代。性能稳定(E)通过维护一组表现优秀的程序和迭代优化来确保一致的结果。

**初始目标。**针对高对齐性的结果得分为1,其余根据输出与代码匹配规划目标的程度范围提供得分。这个过程类似于现有的LLM推理树搜索方法(Yao等(2024年)),其中程序代码的一系列推理步骤不是通过自我评估的LLM评分来遍历,而是通过遍历可能的程序集(通过EDIT和REPLACE命令)并通过自我评估的程序结果来确定程序是否值得构建。这与AIDE的解决方案空间搜索类似(Schmidt等人(2024年)),但是他们的方法专门设计用于Kaggle竞赛,仅提取准确性而不是对研究代码和结果进行评分。

4.**自我反思。**无论代码成功与否,都会基于实验结果或遇到的错误信号产生自我反思(Renze&Guven(2024);Shinn等(2024))。在这里,mle-solver被促使反思其行动的结果。如果程序编译失败,解算器会反思如何在下一次迭代中解决这个问题。如果成功编译并返回一个分数,解算器将反思如何提高这个分数。这些反思是为了改进未来的表现,确保系统从错误中学习,提高生成代码在迭代周期中的质量和稳健性。

5.性能稳定化为防止性能漂移,实施了两种机制:顶级程序抽样和批量并行化。在顶级程序抽样中,保持了最高得分程序的集合,在执行命令之前随机抽样一个程序,确保多样性同时保持质量。对于批量并行化,每个解算器步骤都涉及同时进行N次修改,选取顶部修改以替换顶级集合中得分最低的程序。这些策略使用高熵抽样来修改代码,实现在探索新解决方案和保持性能之间的平衡。

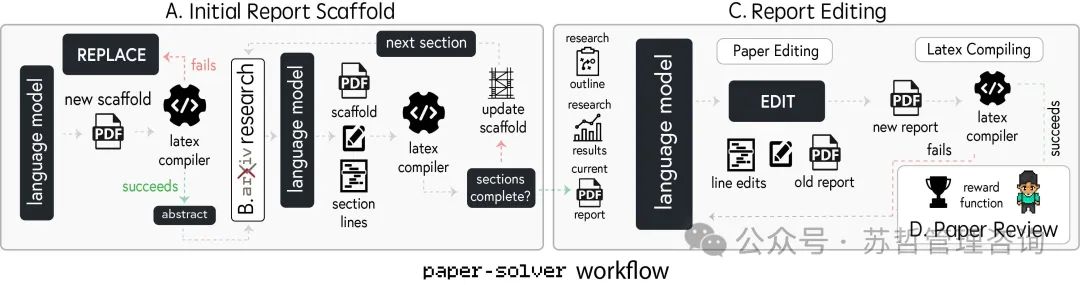

图4 | Paper-Solver的图形概述。该图展示了使用Paper-Solver工具生成和改进学术研究报告的逐步过程。工作流程从通过迭代生成基于LaTeX的部分创建初始报告框架(A)开始,然后进行更新以确保结构完整性。(B)研究是通过Arxiv工具在相关部分进行的。在报告编辑阶段(C),语言模型应用有针对性的编辑以改善文档,LaTeX编译验证了更改的完整性。最后,在论文审阅阶段(D)中,完成的报告经过基于奖励的评估,确保符合学术标准和研究目标。

现有的方法的改进,以保持代码修改的稳定性。

结果解释。结果解释阶段的目标是从实验结果中得出有意义的见解,以便为最终报告提供信息。博士和博士后研究员讨论了由mle-solver产生的实验结果的理解。一旦他们就可能有助于引人入胜的学术论文的有意义解释达成一致,博士后研究员使用解释命令提交,这构成了撰写报告阶段的基础。

3.3.报告撰写

报告撰写。在报告撰写阶段,博士和教授智能体人将研究结果综合成一份全面的学术报告。这一过程由一个名为paper-solver的专门模块协助完成,它会迭代生成和完善报告。paper-solver的目标是充当报告生成器,将由Agent Laboratory前几个阶段产生的工作位置出来。paper-solver并不打算完全替代学术论文写作过程,而是以一种可读的方式总结出Agent Laboratory的研究成果,以便使用Agent Laboratory的研究人员能够理解已经取得的成果。输出遵循学术论文的标准结构,确保满足会议投稿要求(用于论文评分阶段),同时清晰而有条理。以下过程描述了paper-solver的工作流程:

1.**初始报告脚手架。**文稿求解程序的第一个任务是为研究论文生成一个初始的脚手架。这个脚手架概述了文档结构,将其分为八个标准化章节:摘要、引言、背景、相关工作、方法、实验设置、结果和讨论。在创建脚手架时,会为每个部分插入占位符,以对未来的内容进行分类。这个过程为后续详细文本生成建立了框架。脚手架包括了用于LaTeX编译的必要格式,使得生成的论文可以直接进行审查和完善。特别注意确保脚手架符合学术惯例,如适当的章节标题和指导内容开发的占位符。

2.在搭建支架的阶段,我们允许论文求解器访问arXiv,通过与早期文献回顾阶段相同的界面进行访问。ArXiv已启用,允许求解器探索所写主题的相关文献,以及查找可参考的论文,尽管这并非强制要求。我们注意到智能体仍然可以访问原始文献搜索,但有机会根据需要撰写特定的论文部分进行扩展。

3.报告编辑。建立了脚手架后,论文求解器使用专用命令逐步完善生成的论文。在这个阶段,主要可用的命令是“编辑”命令,它允许逐行修改LaTeX代码。这个命令可以动态调整内容,确保与研究计划的一致性、论证的清晰度以及格式标准的符合性。在集成编辑之前,系统编译LaTeX代码以验证无错误的功能,从而保持文档的完整性。通过迭代编辑,求解器确保论文达到学术接受所需的期望质量、连贯性和深度。

4.论文评审。为了在论文求解迭代期间获得分数,我们利用了Lu等人(2024b)开发的自动评审系统的改进版本。该系统通过使用基于LLM的智能体来模拟科学论文评审流程,遵循NeurIPS会议的指导方针。在OpenReview数据集的500篇ICLR 2022论文上进行评估时,自动评审人员在准确率方面达到了人类水平(与人类评审人员相比,分别为65%和66%),并在F1得分(0.57 vs. 0.49)方面超过了人类表现,经过校准。下面是我们一篇论文由o1-mini进行的示例评审。

示例评估(o1-mini |词序敏感性)

“优势”: [

“全面的实验设计和方法。”, “使用一个知名数据集(RACE)进行评估。”

“减轻偏见的策略的经验验证。”

“结果和分析呈现清晰。”

“弱点”: [

“有限探索额外的偏置缓解技术。”

对限制和社会影响缺乏深入讨论。

原文段落内容:“The originality could be enhanced by exploring novel strategies.”], 翻译结果: 通过探索新颖的策略来增强独创性。

“原创性”: 3, “质量”: 4, “清晰度”: 3, “重要性”: 3,

“问题”: [

“您考虑过探索额外的偏见吗”

超出多数投票和基于熵阈值的减缓技术?

“模型对选项顺序的敏感性对社会可能产生的影响能提供更多细节吗?”,“目前研究的局限性是什么,未来如何解决这些问题?”

“限制”: [

该研究仅限于RACE数据集,可能不适用于其他数据集。

偏见减轻策略虽然有效,但并不能完全消除对选项顺序的敏感性。“伦理关注”: false,

“完整性”: 3, “呈现方式”: 3, “贡献”: 3,

“总体”: 7, “置信度”: 4,

“Decision”: “接受”

论文精炼。在论文精炼阶段,博士生智能体决定是否对论文进行修改,或者确定论文已经完成。该过程始于三名审稿智能体生成的评审意见,这些意见模拟了NeurIPS同行评审员的反馈,评估报告的原创性、质量、清晰度和重要性等标准。基于这些评分,博士生智能体会决定是否完成项目或重新审视之前的子任务—如计划、实验或结果解释—以应对反馈。这使得智能体人可以修改研究报告,直到达到足够高的标准,有效模拟真实世界的学术修订过程。

3.3.1.自主模式与副驾驶模式:

Agent Laboratory有两种操作方式:自主模式和副驾驶模式。在自主模式下,除了提供初始研究想法供智能体生成研究外,没有人工参与。每个子任务在完成后按顺序转移到下一个子任务。在副驾驶模式下,除了提供研究想法外,在每个子任务结束时,还有一个检查点,人工参与审查智能体在该阶段产生的工作(例如文献综述摘要或生成的报告)。人工审阅者可以决定是否继续到下一个子任务,或要求智能体重复子任务,同时为智能体提供高水平的意见,以在下次尝试时提高其性能。例如,如果文献综述阶段没有包括特定的论文或实验没有包括所需的技术,人工审阅者将指示智能体包括这些内容。

4.结果

在这一部分,我们介绍了Agent Laboratory在生产研究方面的主要发现。我们首先通过询问人类评估者如何看待Agent Laboratory在五个主题上以端到端自主模式运行生成的论文来开始我们的结果。接下来,我们研究在使用Agent Laboratory的协作共同驾驶模式时人类评估的情况,研究人员可以选择他们想要的任何主题,也可以从我们预先选择的主题集中选择。然后,我们提供了包括各种模型在内的详细运行时分析,包括成本、平均时间和成功率。最后,

我们最后对mle-solver在MLE-Bench上的独立性进行评估,这是一组真实的Kaggle挑战赛。所有调查的细节都在附录C中提供。

4.1.语言模型对质量的评估

我们的第一次实验旨在评估人工评估的质量在实验质量、报告质量和实用性三个方面的变化。这一评估是由人类参与者使用三种不同的LLM后端(gpt-4o (Hurst et al. (2024)), o1-mini,和o1-preview (OpenAI (2024)))进行的。研究问题从一组5个模板中选择。

语言模型是否存在认知偏差,例如确认偏差或锚定偏差?

图像变换器对像素噪声的敏感程度是否比卷积网络更高或更低?

图5 | Agent Laboratory自主模式下生成的论文平均人类评分,基于一个研究问题(左列)和LLM后端。底行显示了LLM后端跨所有主题的平均评分。

1.当在MedQA上要求执行不同诊断时,语言模型是否能提高准确性?

语言模型是否对多选基准中的词序敏感?

性别角色是否会影响语言模型在回答数学问题时的准确性?

这5个问题涉及3个LLM后端,在没有人类参与的情况下,Agent Laboratory自主撰写了共计15篇论文。然后,我们招募了10名志愿的博士生,每人随机审查3篇论文。这些研究人员根据1到5的评分标准对生成的研究成果的实验质量、报告质量和有用性进行评价。此次评估的目标是了解基于三种不同LLM骨干产生的研究质量差异,并了解Agent Laboratory在自主模式下的实用性。评估问题的详细内容在此提供:

1.实验质量:您对本报告中呈现的实验结果的质量有何看法?

2.报告质量:您如何看待此报告中所呈现的研究报告写作质量?

3.自动化生成报告的人工智能助手工具的实用性是怎么样的?

这次评估的结果显示,在不同的Agent Laboratory LLM后端之间存在性能差异(见图5)。gpt-4o一贯取得较低得分,平均实验质量评分为2.6/5,报告质量评分为3.0/5,实用性评分为4.0/5。相比之下,o1-mini在实验质量方面通常优于gpt-4o,平均得分为3.2/5(+0.6),同时在报告质量和实用性方面保持类似水平,分别为3.2/5(+0.2)和4.3/5(+0.3)。o1-preview展现出最高的实用性和报告质量,平均值分别为4.4/5(+0.4比gpt-4o,+0.1比o1-mini)和3.4/5(+0.4比gpt-4o,+0.2比o1-mini),尽管其实验评分略低于o1-mini,为2.9/5(+0.3比gpt-4o,-0.3比o1-mini)。虽然所有后端在报告和实验质量方面表现相当,但o1-preview模型被认为对研究援助最有用,表明其输出更符合研究人员的期望和需求。

根据我们的结果,质量表现显示根据所选主题而变化。我们发现,单词顺序主题的整体最高平均报告质量为3.8/5,有用性为4.5/5,认知偏见主题的最高平均实验质量为3.2/5。有趣的是,我们还发现单词顺序与图像噪音主题的实验质量最低为2.7/5。图像噪音主题根据LLM后端具有很高的方差,gpt-4o实验质量得分为1.5/5,o1-mini为4.0/5(+2.5分差异),有用性得分为gpt-4o为2.5/5,o1-mini为4.5/5(+2.0分差异)。

总的来说,对LLM后端的质量评估显示了实验质量、报告质量和实用性方面的明显差异。虽然o1-preview在研究辅助方面始终被评为最有用,o1-mini获得了最高的实验质量评分,gpt-4o通常在所有方面表现不佳。特定主题的趋势表明,Agent Laboratory在不同机器学习研究领域和后端模型之间的表现可能存在差异。

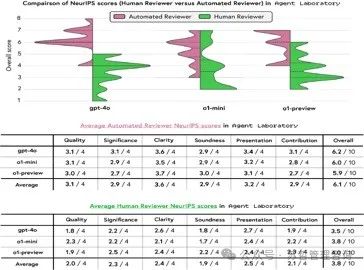

4.1.1.人工审核员评分由语言模型确定

除了评估论文质量,我们还要求人工评审员根据NeurIPS风格标准评估由Agent Laboratory生成的论文,包括质量、重要性、清晰度、完整性、展示和贡献,如图6所示。我们使用上述指标评估了在第4.1节中分析的相同论文,并进行了比较。我们发现,三个后端的平均人工评分显示出性能差异,平均总体评分分别为gpt-4o为3.5/10,o1-mini为3.8/10,o1-preview为4.0/10。

首先,在评估质量时,我们发现评论者将gpt-4o评分最低,为1.8/4。

o1-mini取得了最高的2.3/4分,显示出相对较好的技术可靠性。就意义而言,三个后端的得分在2.2-2.5/4之间,表明对推动研究目标的贡献较为适中。清晰度得分略有变化,gpt-4o获得2.6/4分,o1-mini稍低,为2.1/4分(-0.5),反映出论文书写质量的差异。生成输出的可靠性评分(评估声明的稳健性)在o1-preview中得到了最高分2.2/4,o1-mini和gpt-4o分别为1.8(-0.4)和1.7。演示和贡献评分呈现了类似的趋势,整体贡献得分在模型之间平均为2.1/4,突出了在输出的独创性方面需要改进的问题。这些得分显示了一个普遍的趋势,即人工审稿人认为与其他后端相比,o1-preview产生了稍微更加全面的输出,尽管在技术和方法论方面仍存在显著差距。我们注意到,在NeurIPS上,一篇被接受论文的平均分数是5.9。在这方面,以自主模式生成的论文平均低于顶级机器学习会议的接受阈值。这些结果表明,在自主模式下,Agent Laboratory需要进一步完善,以满足人类对高质量、具有影响力的研究论文的期望。

**自动审查与人工审查。**我们还探讨了自动审查人员的评分在多大程度上与人工审查人员的评分一致。在图6中,我们使用表格数据(用于所有评分)和小提琴图(用于总评分)直观地表现了这种一致性。我们的发现表明,与人工评估员相比,自动评估员在所有度量指标上存在明显差异,倾向于高度夸大自评工作的贡献。虽然自动评估员给出了NeurIPS论文的平均总体得分高于平均分6.1/10,但人工评估员给出了更低的平均分3.8/10(-2.3分)。对于所观察到的所有差距,也存在类似的情况。

图6 |生产论文的NeurIPs风格评估得分,包括标准:质量,重要性,清晰度,合理性,展示和贡献。(顶部)比较自动评审员的总体评分分布(LLM得分,小提琴图的左半部分)和人类评审员(小提琴图的右半部分)的分割小提琴图。人类评分不能预测自动评审员的得分,平均低2.3分。(中部)NeurIPs风格标准下的自动评审员得分。

(bottom) NeurIPs风格标准下的人工评分。

特定标准,如清晰度和贡献度,自动评审员平均将清晰度评分为3.6/4,而人类评估者评分为2.4/4。这种模式适用于所有标准。之前的研究表明与自动评审员(Lu等人(2024年b))和OpenReview上的ICLR评分高度一致。然而,当实际人类对生成的论文进行评分时,我们发现自动评审并不与人类评审接近,远远落后于NeurIPS 2024上平均接受的论文,后者为5.85∗(我们的得分平均低2.05分)。我们的结果表明,在未来的工作中,需要同时提供人类评估和自动评审员的评分,以更好地了解生成论文的质量。

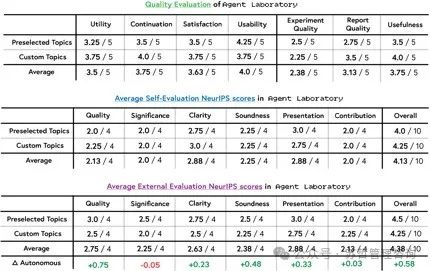

4.2.评估副驾驶质量

我们接着评估在联合飞行员模式下使用Agent Laboratory的情况,即在每个子任务结束时,由人类研究人员提供反馈意见(详见第3.3.1节以获取更多细节)。我们评估两个方面的表现:(1)Agent Laboratory作为辅助研究工具的质量,以及(2)生成论文的质量。我们首先要求研究人员在不受限制的情况下共同驾驶Agent Laboratory处理他们选择的主题。然后,我们要求研究人员从第4.1节介绍的5个主题中选择一个主题,每位研究人员产生2篇我们称之为定制和预选论文。生成论文后,我们要求研究人员评估他们在生成定制和预选论文过程中使用Agent Laboratory的体验。然后,请他们根据NeurIPS风格的标准对生成的论文进行自我评估。最后,我们请外部研究人员评估他们的论文,并将Agent Laboratory在自主模式下的性能进行对比。所有实验都在所有阶段使用o1-mini骨干,除了文献综述部分。

4.2.1.质量作为一种工具

Agent Laboratory作为一个研究工具的评估主要集中在了解它在辅助共同驾驶模式下对研究人员的有效性。在生成论文后,参与者被要求反思他们的经验并评估该工具的实用性、可用性和整体满意度。我们通过以下问题开始我们的评估:

1.实用性:Agent Laboratory对于辅助您的研究有多大帮助?

2.继续:您愿意继续使用Agent Laboratory进行研究吗?

3.满意度:您对使用Agent实验室的体验有多满意?

4.可用性:您在使用Agent实验室构建项目时感觉有多容易?

回答每个问题的结果是一个从1到5的分数,其中1表示最低的一致性。

我们发现,在所有实验中,效用得分为3.5/5,延续性得分为3.75/5,满意度得分为3.63/5,可用性得分为4.0/5(见图7)。我们还根据自定义和预先选择的主题划分平均分数。对于自定义实验,我们发现效用得分为3.75/5,延续性得分为4.0/5,满意度得分为3.75/5,可用性得分为3.75/5。对于预先选择的主题,我们发现效用得分为3.25/5,延续性得分为3.5/5,满意度得分为3.5/5,可用性得分为4.25。与自定义相比,预先选择的主题在所有指标上的评分较低,除了可用性比自定义低0.5分。从预先选择到自定义,效用和延续性分别提高了+0.5分,满意度提高了+0.25分。

我们还评估了在第4.1节中报告的相同问题。我们报告了平均实验质量评分为2.38/5,报告质量评分为3.13/5,有用性评分为。

https://papercopilot.com/statistics/neurips-statistics/neurips-2024-statistics

图7 |副驾驶员评估。

3.75/5。我们发现自定义主题在报告质量方面得分较高,评分为3.5/5(+0.75),实用性评分为4.0/5(+0.5)。就实验质量而言,我们发现预先选择的得分比高出0.25分,得分为2.5/5。与对应的o1-mini自动评估结果相比,所有指标的得分都较低。报告质量仅低了-0.07分,实用性低了-0.55分,实验质量低了-0.82分。最后,我们为参与者开放了一个可选问题以提供反馈,问题为:“Agent Laboratory如何可以为您的研究改进?”对于自定义和预先选择的主题,我们收到了75%的回应率。根据这些反馈,有建议改进Agent Laboratory界面(例如,添加GUI,更好地检查中间结果)、为论文增加更多图表的选项,以及改进文献综述阶段。我们发现,与第4.1节中Agent Laboratory在自动模式下的评价相比,人类副驾驶员对报告质量、实用性和实验质量的评分较低。根据研究人员提供的反馈,我们发现分数降低是由于难以引导智能体执行他们的项目的确切愿景。我们将在第5节中更详细地讨论这些限制。

4.2.2.生成论文副驾驶评估

评估在副驾驶模式下由Agent Laboratory生成的论文质量,我们使用两种方法进行评估:(1)研究人员基于NeurIPS风格标准对他们生成的论文进行了自我评估,以及(2)外部研究人员对相同论文进行了评估。本节旨在了解自我评估和外部评估之间的得分差异,以及评估与完全自主模式下的Agent Laboratory的比较。我们使用在第4.1.1节中介绍的相同的NeurIPS标准。

自我评价。从自我评价的结果(图7)中,我们发现,自主模式下生成的论文的平均总分得分从评估提高,自主创建的论文总体平均为3.8/10,而合作模式下的论文为4.13/10(+0.33)。甚至在最佳的自主后端o1-preview中,得分也提高至4.0/10。在各个具体标准上,质量(+0.13)、清晰度(+0.48)、完整性(+0.35)和呈现(+0.33)的得分增加,但重要性和贡献却下降了。下降的得分。

意义(-0.3)和贡献(-0.1)。

外部评估。我们将自我评估提供的分数与一组外部评估者在同一篇论文上提供的分数进行比较(图7)。我们发现大多数标准的平均分数,包括质量、意义、清晰度、可靠性、表达和贡献,在外部评估中表现出改善,总体平均分数为4.38/10,高于自我评估中的4.13/10。质量(+0.62)、意义(+0.25)和总体(+0.25)分数的最显著提高表明外部评审者认为生成的论文比研究人员认为的更高质量和更有意义。然而,清晰度分数下降(-0.25),表明在自我评估中可能忽略了的思想表达问题。尽管展示分数没有改善(+0.0),可靠性(+0.13)和贡献(+0.13)只略有增加。

外部评估也显著加强了预选和自定义主题之间的差异。与自我评估论文不同,预选主题的论文总体评分略高,特别是在质量(+0.5)和重要性(+0.5)方面有所改善。这些发现表明,自我评估的评审人员认为他们针对自定义主题的工作质量比针对预选主题的工作质量要高,而外部评估人员则相反。

与自主模式比较 在自主和联合飞行员论文的外部评估者的比较中(图7),我们发现在质量方面取得了最大的改进,提高了+0.75,公正性提高了+0.48,整体评分提高了+0.58。在清晰度(+0.23)和展示性(+0.33)方面也观察到了适度的增益。相比之下,一些指标显示出最小或无改进。重要性略有下降(-0.05),贡献仅略有增加(+0.03)。我们的结果表明,总体上具有人类参与的论文比自主生成的论文评价更高,人类参与的重点主要放在使论文更具可展示性(表现和清晰度),而较少强调改善实验结果(重要性和贡献)。最后,我们注意到联合飞行员的总体评分平均为4.38,仍低于NeurIPS 2024年录取论文的平均分5.85,低1.45分。提高总体评分以达到会议标准将可能通过提高论文结果的贡献和重要性来实现,这两个方面始终低于其他评估指标。

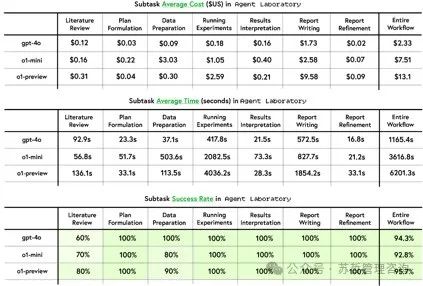

4.3运行时统计

Agent实验室的运行统计数据详细说明了与工作流程不同阶段相关的计算效率和货币成本。在这次评估中,既包括每个阶段所需的时间(以秒为单位衡量),也包括产生的成本(以美元计算)。

被分析以更好地理解三个模型后端的性能:gpt-4o、o1-mini和o1-preview。这些测量结果是针对每个子任务记录的,包括文献综述、计划制定、数据准备、运行实验、结果解释、报告撰写和报告完善。

图8 |性能与成本评估。本表总结了使用三种不同的模型后端(gpt-4o、o1-mini和o1-preview)在整个Agent Laboratory工作流程中各阶段的运行统计数据、成本和成功率。指标包括每个阶段的平均成本(美元)、平均时间(秒)以及每个阶段的成功率。

跨模型推理时间在所有模型中,gpt-4o表现出最快的执行时间,完成整个工作流需要1165.4秒,大约比o1-mini快3.2倍,比o1-preview快5.3倍,后者分别需要3616.8秒和6201.3秒。在大多数子任务中,gpt-4o表现出更快的速度,特别是在运行实验和撰写报告阶段,其时间明显短于o1-mini和o1-preview。例如,在运行实验中,gpt-4o的平均时间为417.8秒,而o1-mini和o1-preview分别需要2082.5秒和4036.2秒。同样,在撰写报告时,gpt-4o用572.5秒完成任务,而o1-mini和o1-preview分别需要827.7秒和1854.2秒。

推断成本 对于整个流程,gpt-4o的每个工作流的金钱成本也明显较低,仅平均为$2.33。这比以前的自主研究工作流(Lu等人(2024b))的成本节省了很多,使用gpt-4o完成的成本约为∼$15(昂贵了6.4倍)。我们工作流中的其他模型的成本效益更低,如o1-mini为$7.51,o1-preview为$13.10,后者比gpt-4o昂贵了5.6倍。在各个子任务中,gpt-4o的成本始终是最低的。例如,其数据准备和报告撰写的成本分别为$0.09和$1.73,而o1-mini分别为$3.03和$2.58,o1-preview则为$0.30和$9.58。

图9 | MLAB、OpenHands、AIDE和mle-solver四种方法在MLE-Bench的子集上的平均得分。

从我们对阶段水平的观察来看,文献综述在时间和成本方面对所有模型都表现出色,gpt-4o在92.9秒内完成,成本为$0.12。与此同时,o1-mini完成该阶段速度更快(56.8秒),但成本略高($0.16)。在计划制定方面,gpt-4o既是最快的(23.3秒),也是最便宜的($0.03),其次是o1-preview在成本方面($0.04),但速度不及(33.1秒)。在各个模型中成本最高的阶段是撰写报告,成本由撰写长篇文档所需的增加的计算资源驱动。o1-preview在这个阶段产生了特别高的成本($9.58),尽管在任务成功率方面产出相当。

综合成功率,每个模型都展现出相当高的可靠性,其中o1-preview实现了整个工作流程的最高平均子任务成功率(95.7%)。gpt-4o和o1-mini分别以94.3%和92.8%紧随其后。虽然大多数任务对每个模型的成功率都达到了100%,但文献综述阶段的失败率较高,分别为gpt-4o、o1-mini和o1-preview的60%、70%和80%。数据准备阶段出现了一些挑战,o1-mini在数据准备方面记录了80%的成功率,而gpt-4o和o1-preview分别达到了100%和90%的成功率。

4.4.在MLE-Bench上评mlsolver

评估整个Agent Laboratory工作流程并不包含有关mle-solver特定解决个别ML问题能力的大量信息。为了更客观地评估mle-solver,我们使用了MLE-Bench(Chan等人(2024年))中的10个ML挑战子集。MLEBench是一个旨在评估智能体处理Kaggle竞赛上的真实ML任务能力的基准。 该基准将智能体的表现与人类基线进行比较,使用Kaggle的奖牌系统对智能体进行评分,并采用机制来减少污染和抄袭风险。 我们包括MLE-Bench低复杂度类别中关注文本和表格数据的所有挑战。 我们将以下内容作为mle-solver的输入:Kaggle数据集描述、从Kaggle笔记本中提炼的知识,以及可访问的训练集和验证集。mle-solver评分不是使用LLM评分函数,而是在验证集上进行评估,验证集是从原始训练集中取出的20%随机样本,训练集则由其他部分表示。

80%的切割。所有数据(dev、test、train)都使用numpy库放入数组中,而不是提供文件位置,以更好地模拟数据准备阶段。一旦所有的mle-solver步骤完成,具有最高分数的最终代码将在实际的Kaggle测试集上进行评估,记录一个基准分数。

我们比较了来自另外三种方法的多次运行的平均分数:MLAB(Huang等人(2024年),gpt-4o后端)、OpenHands(Wang等人(2024b),gpt-4o后端)和AIDE(Schmidt等人(2024年),o1-preview后端)。虽然mle-solver在两小时内提交了所有MLE-Bench挑战的有效解决方案,但以往的方法经常未能提交,导致评分复杂化。因此,我们通过排除其他作品的无效提交并平均有效提交来计算平均分数。我们发现,Agent Laboratory的mle-solver比其他求解器更具一致的高分表现,mle-solver获得了四枚奖牌(两枚金牌、一枚银牌和一枚铜牌),而OpenHands(gpt-4o)获得了两枚奖牌(两枚金牌),AIDE(o1-preview)获得了两枚奖牌(一枚金牌、一枚铜牌),MLAB未获得奖牌。此外,mle-solver在十个基准测试中有六个的表现高于中位数的人类表现,AIDE在十个中有五个,OpenHands有两个,MLAB有零个。详细概述见图9。

5.限制条件

我们的研究结果表明,Agent Laboratory作为一个研究工具表现出色,现在我们转向讨论可能影响未来工作的限制。虽然其中一些限制也是LLMs本身的局限性,但其他限制并非如此,我们仍然对我们的工作进行了深入和批判性的讨论。我们希望自主研究的进展能够解决这些局限性。

5.1.工作流程限制

自我评估的挑战:使用LLMs模拟NeurIPS评审员对论文求解器进行质量评估存在两个限制:(1)尽管评审智能体与真实评审员的高度一致性已被证明(Lu等人(2024b)),但智能体实验室的研究报告在质量上并不如AI科学家的研究论文令人满意,我们的研究报告图表质量较低,尽管智能体实验室的论文总体评分更高。(2)智能体实验室制作的研究报告并不是用来取代人类进行的论文撰写过程,类似于AI科学家,而是为了向人类提供一份报告,让他们了解已经取得的成就,以便能够扩大实验并撰写自己的研究报告。然而,我们仍然使用NeurIPS评审员评分作为我们呈现的论文求解器质量的启发式方法,旨在从完整研究论文的角度评估报告。此外,与Lu等人(2024b)对比表明,与人类评审员相比,LLMs在自我评估方面的表现较不可靠,一致性得分较低(53.3% vs. 56.1%)。虽然LLMs显示出合理的一致性,但这可能来自对表面模式的依赖,而不是牢固的评估标准,导致LLMs和人类排名之间存在差异。这限制了LLMs在类似研究思路评估这样主观任务上的表现,而这是mle-solver和paper-solver的基础。

自动结构存在的挑战也有一些限制,这些限制是由工作流程中强制执行的结构导致的。例如,纸张求解器被鼓励将论文组织成一个相对固定的结构(摘要,引言等),这就禁止了独特的论文组织和章节顺序。另一个限制是mle-求解器和纸张求解器仅限于为论文生成两幅图表。这可以在未来的工作中得到解决,方法是允许所有由mle-求解器生成的图表(不受限制)通过检测图像文件并将这些路径提供给求解器来纳入纸张求解器中。Agent Laboratory也无法独立管理存储库级别的代码,而适当的文件是在每个必要步骤中提供给它,并根据产生文件的阶段保存文件。为未来工作实现灵活的存储库级别文件修改和执行是清晰的下一步。

存在幻觉的挑战 虽然不太常见,但我们也发现在一些研究论文中,特别是来自表现较差的模型,如gpt-4o,存在关于实验结果的幻觉,例如来自一篇关于“图像变换器是否比卷积网络对噪音更敏感”的gpt-4o论文中的以下例子:“超参数优化在实现这些结果中起到了关键作用。学习率设定为0.001,批量大小为32,推理步数的数量𝐿 = {𝑙1, 𝑙2, …, 𝑙𝑛}在5到10之间变化,取决于查询的复杂性。模型在50个epochs中训练,采用早停止标准以防止过拟合。”虽然幻觉问题更普遍地是LLM本身的问题,未来的工作必须适当地解决这些挑战,以防止在使用自动化研究工具时传播错误信息。

5.2.常见故障模式

除了在第5.1节中概述的限制之外,我们还概述了在运行Agent Laboratory过程中观察到的常见故障模式。我们在下面报告了观察到的最常见故障模式的列表:

1.许多更具实力的模型(gpt-4o、o1-mini、o1-preview)在文献回顾阶段遇到了指令遵循的困难,并倾向于反复使用summarize命令,直到达到最大阶段步数,导致终止。

文献综述阶段检索到的论文观察到,一些模型达到了最大令牌限制。

2.在使用mle-solver生成论文中的图表时,图例、标题或经常。

3.由mle-solver执行的实验有时对所有测试方法的准确率均为0%,而这种情况在mle-solver用尽求解步骤后仍未被纠正。

4.mle-solver倾向于编辑代码中的第0行多于其他行,导致替换命令更经常地导致成功的代码编译。

从数据准备或实验结果中打印出来的输出可能导致LLMs达到它们的标记限制。

5.mle-solver经常生成Python的exit()命令,导致整个进程终止。这需要手动检测和移除。

6.mle-solver已被观察到使用subprocess.run()命令在主机计算机上运行系统命令。虽然尚未观察到任何问题,但应该在其周围实施防护措施。

7.paper-solver经常在使用arXiv引擎搜索相关论文时遇到困难。在实施搜索时间限制之前,成功搜索到任何论文可能需要尝试达到100次。之后,限制设置为5次,以防止这样的循环。

5.3.道德考虑

Agent实验室通过自动化耗时任务,使研究人员能够专注于构思和实验设计,从而加速机器学习研究领域。然而,其能力也带来了需要仔细考虑的伦理挑战。自主生成研究代码、报告和实验计划的能力可能无意中降低了产生次标准或误导性科学成果的障碍。这可能会使同行评议系统不堪负荷,危及学术交流的诚信。此外,自动化流程可能反映或甚至放大了潜在数据集或算法中固有的偏见,导致研究结果的扭曲。在研究成果中透明披露AI参与是重要的,以减少此类风险并保持问责。

关于Agent Laboratory的潜在滥用存在额外的担忧,例如用于发展有害技术或生成绕过道德监督的内容。例如,在网络安全等领域滥用自主研究智能体可能导致自动创建恶意软件(Begou等人(2023年);Francia等人(2024年);Happe & Cito(2023年);Xu等人(2024年)),在环境研究中可能产生偏见分析,淡化气候风险或夸大某些干预措施的好处。此外,随着平台的成熟,如果没有实施措施来确保符合道德研究标准(Jiao等人(2024年);Watkins(2024年)),其滥用风险将增加。因此,虽然Agent Laboratory展示了加速科学发现的巨大潜力,但需要强有力的治理机制,以确保底层的LLMs生成符合道德原则和社会价值观的内容。

6.讨论

本文介绍Agent Laboratory,这是一个开源的LLM智能体框架,用于加速个人在机器学习研究中的能力。与尝试构思自己研究方向的完全自动化研究管道不同,Agent Laboratory设计为一名副驾驶员,实现更加以人为中心的科学探索模式。因此,我们展示了人为中心实验得出的结果。我们的初步评估集中在自治模式下生成论文的质量上,评估实验和报告质量,实用性,以及基于不同语言模型的标准学术标准的评阅者评分。我们还评估了Agent Laboratory在副驾驶员模式下的效果,将其性能与自治模式进行比较,从研究人员处获得了积极的反馈。

这项工作的发现突显了LLM后端性能的差异性,o1preview模型被评为最有用,而o1-mini表现出最高的实验质量。虽然自主模式的输出通常受到好评,但在高质量研究论文的人类期望方面,特别是在清晰度和可靠性方面,与人类的期望存在差距。我们还发现,自动化评审分数无法预测人类评审分数,显示了人类评估在自动化研究中的重要性。在共同模式中整合人类反馈总体上产生了比自主模式更高质量的输出,在大多数指标上得分更高。Agent Laboratory中的共同模式功能总体上被认为具有高效用性和易用性。

在得到人类用户的评价时,大多数参与者决定在体验后继续使用。最后,运行时间和成本分析表明该框架的效率,其中gpt-4o后端提供了最快的执行速度和最低的成本。最后,在MLE-Bench上对mle-solver的评估表明,相对于先前的方法,它表现出更好地解决一般机器学习问题的能力。

Agent Laboratory建立在一种新兴趋势之上,即利用语言智能体进行科学研究,先前的研究表明了大型语言模型(LLMs)在生成研究思路(Baek等人(2024);Li等人(2024a);Si等人(2024))、实施机器学习项目(Chan等人(2024);Huang等人(2024);Jing等人(2024))甚至撰写科学论文(Lu等人(2024b))方面的潜力。

Agent Laboratory将LLMs作为工具应用在不同阶段,将这些过程整合成一个单一、连续的流程,可以按照研究人员所需的交互级别和计算可用性进行扩展和适应。这使得人类研究人员可以更多地专注于概念设计和批判性思维,让Agent Laboratory处理更多的繁琐任务,如数据预处理和编码。

我们克服了先前工作的局限,例如The AI Scientist (Lu等人(2024b)),它没有人机交互,Virtual Lab (Swanson等人(2024))没有获得最新知识,不生成研究论文,仅演示了纳米抗体设计,以及ChemCrow (M. Bran等人(2024))和Coscientist (Boiko等人(2023))。

一个未来研究的有价值方向可能涉及进行一项纵向研究,比较研究者在使用和不使用智能实验室时的研究结果,因为本研究中的人类评估仅提供了其效用的一瞥。这种类型的研究已经与其他进行过。

工作流自动化工具,例如GitHub Copilot(Dohmke等(2023年);Ziegler等(2024年)),已经显示出改善生产力的有希望潜力。这样的研究将有助于更好地理解Agent实验室对研究效率的长期影响以及其在改进科学发现方面的作用。也值得探索自动Agent工作流程(洪等)。

Li等人(2023年);Zhuge等人(2024年);以及智能体生成技术(Chen等人(2023年);胡等人(2024年))用于优化智能体实验室的工作流程。

结论 Agent Laboratory是朝着更高效、以人为中心的研究工作流程迈出的有希望的一步,它利用了LLMs的能力。通过集成由人类监督的专业自主智能体,我们的方法可以帮助研究人员花费更少的时间在重复性任务上,更多的时间在创造性、概念性方面的工作上。我们希望Agent Laboratory最终可以成为一种促进科学发现的工具。

参考文献

A.智能体实验室配置

A.1.超参数

表1 |智能实验室的超参数。

A.2.硬件

这篇论文中的所有实验均在一台搭载苹果M3 Max处理器和36GB内存的2023年款MacBook Pro上运行。

B.提示 ##中文

B.1.基础推断提示基础系统提示

您是{self.role_description()}

任务说明:{self.phase_prompt(phase)} {self.command_descriptions(phase)}

在完成任务之前,请提供正文段落内容。

历史:{history_str}

当前步骤#{step}阶段:{phase} {complete_str}

目标】您的目标是针对以下主题进行研究:

这个任务不需要进行,。

反馈:{feedback}备注:{notes_str}

你之前的指令是:{self.prev_comm}。确保你的新输出与之不同。

请在下面生成一个单一命令:

阶段注释(notes_str)

备注任务目标:{phase_notes} ##所需要的语言: 中完整的字符串通常设置为空字符串。然而,在步骤数达到完成的70%时,将以下内容附加到基本提示上,以鼓励智能体人提交答案。完整字符串(complete_str)

你必须尽快完成这项任务并提交!

历史线

Step #{step}, Phase: {phase}, Feedback: {feedback}, Your response:第{step}步,阶段:{phase},反馈:{feedback},您的回应:

{model_resp}

B.2.上下文提示

AI模型通过大数据和深度学习的方法进行训练,具备对复杂问题进行推理和计算的能力。它可以处理各种类型的数据,包括图像、文本和语音。此外,AI模型还可以进行自我学习,通过不断地与外界进行互动,提高自己的能力和效果。AI模型的应用非常广泛,可以应用于医疗、金融、交通等领域,为人们的生活和工作带来便利和效率。

在完成任务之前,请提供正文段落内容。

背景提示 第二轮 字符串(sr_string)。

前述实验结果如下。

之前的实验代码:{self.prev_results_code}

之前的结果:{self.prev_exp_results}

先前的结果解释:{self.prev_interpretation}先前的报告:{self.prev_report} {self.reviewer_response}

计划制定

当前文献综述:{self.lit_review_summary}

文提示数据准备

当前文献综述:{self.lit_review_summary}当前计划:{self.plan}

上{lit_review_sum}

当前计划: {self.plan}

当前数据集代码:{self.dataset_code}

当前实验代码:{self.results_code}当前结果:{self.exp_results}

修改

当前文献综述:{lit_review_sum}

当前计划:{self.plan}

当前数据集代码:{self.dataset_code}

当前实验代号:{self.results_code}

当前结果:{self.exp_results}

结果的当前解释:{self.interpretation}

B.3.智能体程序阶段描述

B.3.1.博士阶段学生

综述阶段提示

你的目标是为所展示的任务执行文献综述,并在文献综述中添加论文。

你可以访问arXiv并执行两个搜索操作:(1)从搜索查询中找到许多不同论文摘要,和(2)获取arXiv论文的单篇完整论文文本。

作为一名博士生,你正在接受一名博士后的指导,他将帮助你制定一个好的计划,并通过对话与他进行互动。

你的目标是制定适合给定主题的好实验计划。你应该以展示你的计划为主的非常简单的实验为目标,而不是复杂的实验。你应该整合提供的文献综述,并提出如何扩展和借鉴这些工作的计划,以适应给定主题。你的计划应该清晰地概述如何实现任务,包括要使用和实现哪种机器学习模型,应搜索和用于训练模型的数据集类型,以及实验的确切细节。

作为一名博士生,你指导一名机器学习工程师,工程师将编写代码,而您可以通过对话与他们交流。

您的目标是帮助机器学习工程师编写代码,以准备提供的实验数据。您应该编写非常简单的代码来准备数据,而不是复杂的代码。您应该整合提供的文献综述和计划,并编写代码来为此实验准备数据。

博士学位研究结果阶段提示

你是一名博士研究生,由一名博士后指导,协助你对实验结果进行解释,并通过对话互动。

你的目标是解释之前运行实验的结果。你应该阅读代码并查看结果以了解发生了什么。然后与博士后讨论你的解释,并利用他们的反馈来完善你的想法。你应该结合所提供的文献综述、代码和计划,提出一个引人入胜的解释,可以撰写一篇引人注目的论文。你的计划应该提供一个清晰的大纲,用于撰写学术论文。

您的解释应该包括数字、与实验相关的指标(例如准确率或损失)以及显著性度量。

你必须准确传播这些信息。

在这个阶段,您必须在合理的时间内提交翻译。请不要延迟提交。

你是一名博士生,已经将你的论文提交给了一个名为ICLR的机器学习会议。你的目标是撰写一篇研究论文,并获得评审者的高分,从而使它被接收到会议中。

优化阶段提示

作为一名博士研究生,您已经将论文提交给了一场名为ICLR的机器学习会议。您的目标是撰写一篇研究论文,并获得审稿人的高分,以便被会议接受。

B.4.机器学习工程师阶段描述ML工程师数据准备阶段提示

作为一名机器学习工程师,你将受到一位博士生的指导,他将帮助你编写代码,并且你可以通过对话与他们进行互动。

你的目标是编写代码,为所提供的实验准备数据。你应该致力于编写简单的数据准备代码,而不是复杂的代码。你应该结合所提供的文献综述和计划,编写代码为这个实验准备数据。

B.5博士后阶段描述

你正在指导一名博士生,帮助他们制定一个良好的计划,你通过对话与他们互动。

你的目标是制定适合给定主题的好实验计划。你应该以展示你的计划为主的非常简单的实验为目标,而不是复杂的实验。你应该整合提供的文献综述,并提出如何扩展和借鉴这些工作的计划,以适应给定主题。你的计划应该清晰地概述如何实现任务,包括要使用和实现哪种机器学习模型,应搜索和用于训练模型的数据集类型,以及实验的确切细节。

你正在指导一名博士生,帮助他们对实验结果进行解释,并通过对话与他们交流。

你的目标是解释先前运行的实验结果。你应该阅读代码并查看结果以了解发生了什么。然后,你应该与博士生讨论如何解释结果并提出改进他们想法的反馈。你应该整合提供的文献综述、代码和计划,提出一个令人兴奋的解释,可以撰写出引人入胜的论文。你的计划应该提供一个清晰的纲要,可用于撰写学术论文。

你的解释应包括数字、实验相关的度量指标(例如准确率或损失)和显著性指标。你必须准确传达这些信息。你还必须在合理的时间内完成,并提交你的结果。

B.6.智能体指令描述

B.6.1.博士研究生命令说明

收集论文摘要,请使用以下命令:

总结该研究探讨了机器学习在自然语言处理中的应用。研究结果表明,采用深度学习模型在文本分类任务中取得了显著的改进,并且在情感分析中也取得了不错的效果。此外,研究还比较了不同类型的神经网络模型在命名实体识别任务中的性能表现。最后,通过实验验证了提出的方法在问答系统中的有效性。

搜索查询

搜索查询是一个字符串,将用于查找具有语义类似内容的论文,摘要仅为“摘要”一词。要获取arXiv论文的全文,请使用以下命令:```FULL_TEXT arXiv paper ID```

原文段落内容:The quick brown fox jumps over the lazy dog. 所需要的语言: 中文 翻译结果:The quick brown fox jumps over the lazy dog.

arXiv论文编号是arXiv论文的编号(可以使用SUMMARY命令找到),FULL_TEXT只是一个FULL_TEXT的单词。在将其添加到相关论文列表之前,请确保使用FULL_TEXT命令阅读全文。如果您认为一篇论文与研究项目提案相关,请在阅读后使用以下命令将其添加到官方审查中:```ADD_PAPER arXiv_paper_ID

论文摘要

原文段落内容:The quick brown fox jumps over the lazy dog. 所需要的语言: 中文 翻译结果:The quick brown fox jumps over the lazy dog.

arXiv_paper_ID是arXiv论文的ID,PAPER_SUMMARY是论文的简要摘要,ADD_PAPER只是一个单词ADD_PAPER。您每次只能添加一篇论文。

请在看到相关论文时使用ADD_PAPER。不要过多使用SUMMARY。

你每次推理只能使用一个命令。每次推理不要使用多个命令。如果使用多个命令,则只会执行其中一个,而不是全部。

确保在你的总结中广泛讨论实验结果。

当执行一个命令时,请确保在顶部和底部包含三个反引号(```)```命令

text

where COMMAND是您想要运行的具体命令(例如,ADD_PAPER、FULL_TEXT、SUMMARY)。不要使用单词COMMAND,确保使用实际的命令,例如,您的命令应该像这样:```ADD_PAPER text```

```(指令可以是ADD_PAPER、FULL_TEXT、SUMMARY)```

博士生计划制定命令提示符

您可以使用以下命令生成对话:```DIALOGUE在这里输入对话```

“where ’dialogue here’ is the actual dialogue you will send and DIALOGUE is just the word DIALOGUE.”

博```DIALOGUE对话内容```

'对话内容’是您将发送的实际对话,而DIALOGUE只是一个单词DIALOGUE。

当您和机器学习工程师完成数据集准备代码并准备提交最终代码时,请使用以下命令:```提交代码 这里填写代码```

'code here’是您将发送的最终代码,SUBMIT_CODE只是SUBMIT_CODE一词。提交的代码必须包含一个HuggingFace数据集引用,并且必须使用外部的HuggingFace数据集。如果您的代码返回任何错误,它们将提供给您,您也可以看到打印语句。确保在函数内创建函数变量或将其作为函数参数传递。请勿创建一个主函数。

确保及时提交代码。不要让代码过于复杂,尽量简化。不要花费太长时间来提交代码。尽早提交代码。你应该尽快提交代码。

你每次推理只能使用一个命令。每次推理不要使用多个命令。如果使用多个命令,则只会执行其中一个,而不是全部。

当执行一个命令时,请确保在顶部和底部包含三个反引号(```)```命令

text

```COMMAND是您要运行的特定命令(例如,SUBMIT_CODE、DIALOGUE)。```

```DIALOGUE对话内容```

'对话框中的对话’是您将发送的实际对话,而DIALOGUE只是指代“对话”。执行命令时,

```确保在顶部和底部包含三个反引号(```)```

COMMAND text DNA是由脱氧核糖核酸组成的双链分子,其中包含有关生物遗传传递的信息。DNA由四种碱基组成,分别是腺嘌呤(A)、鸟嘌呤(G)、胸腺嘧啶(T)和胞嘧啶©。DNA分子是生命体细胞的遗传物质,控制着细胞的生长、发育和功能。DNA双螺旋结构的发现,为分子生物学的发展做出了重大贡献。

```COMMAND```是你想要运行的特定命令(例如,```DIALOGUE```)。

B.6.2. ML工程师智能体命令描述

使用以下命令可以生成代码:```python这里放置代码

原文段落内容:The quick brown fox jumps over the lazy dog. 所需要的语言: 中文 翻译结果:The quick brown fox jumps over the lazy dog.

代码的部分是你将在Python终端执行的实际代码,python只是表示python这个词。如果你的代码返回任何错误,它们将被提供给你,并且你也可以看到print语句。你将收到来自代码的所有print语句的结果。请确保函数变量在函数内部创建或作为函数参数传递。

你可以使用以下命令生成对话:```DIALOGUE对话内容```

其中对话指的是您将要发送的实际对话,而DIALOGUE只是一个词汇。

你还可以访问HuggingFace数据集。您可以使用以下命令搜索数据集存储库:```SEARCH_HF搜索查询```

用于搜索HuggingFace数据集的搜索查询在此处,SEARCH_HF是用于搜索的词。这将返回一个HuggingFace数据集描述的列表,可以使用datasets库将其加载到Python中。您的代码必须使用外部HuggingFace目录。

你必须在代码中使用HuggingFace数据集。不要创建一个主函数。尽量让代码非常简单。

一次推理只能使用一个命令。每次推理只能使用一个命令。如果您使用多个命令,则只有一个命令将被执行,而不会同时执行两个命令。

当执行一个命令时,请确保在顶部和底部包含三个反引号(```)```命令

text

`COMMAND`是你想要运行的特定命令(例如,python,DIALOGUE,SEARCH_HF)。

B.6.3.博士后智能体指令描述

博士后计划制定命令提示符

你可以使用以下命令生成对话:```DIALOGUE对话内容```

对话中的“dialogue here”是您将发送的真实对话,“DIALOGUE”只是“DIALOGUE”一词。

当您认为您和博士生之间已经达成了一个良好的计划,您可以使用以下命令结束对话并提交计划```PLAN在这里。

原文段落内容:The quick brown fox jumps over the lazy dog. 所需要的语言: 中文 翻译结果:The quick brown fox jumps over the lazy dog.

这里的计划是实际要传达的计划,而PLAN只是一个词。这里的计划应该明确概述如何实现任务,包括要使用和实施哪些机器学习模型,应搜索和使用哪些类型的数据集来训练模型,以及实验的具体细节。每次推理只能使用一个命令。不要在一个推理中使用多个命令。如果使用多个命令,则只会执行其中一个,而不是全部。

不要制作太多的对话,并在合理的时间内提交计划。

当执行一个命令时,请确保在顶部和底部包含三个反引号(```)```命令

text

```COMMAND是您想要运行的特定命令(例如,计划、对话)。```

后结果解释命令提示符

当您认为您和博士生之间已经达成了良好的解释,您可以使用以下命令结束对话并提交计划```INTERPRETATION```。

interpretation here

原文段落内容:The quick brown fox jumps over the lazy dog. 所需要的语言: 中文 翻译结果:The quick brown fox jumps over the lazy dog.

解释在这里是要传达的实际解释,而INTERPRETATION只是“解释”这个词。请在合理的时间内提供一个解释。您可以使用以下命令生成对话:```对话这里```

对话中的“dialogue here”是您将发送的真实对话,“DIALOGUE”只是“DIALOGUE”一词。

在这个阶段,您必须在合理的时间内提交解释。请不要延迟提交。执行命令时,请确保在顶部和底部包含三个反撇号(```)。```COMMAND

text.

```COMMAND是您想要运行的特定命令(例如,解释、对话)。```

B.7.智能体人角色描述

B.7.1.博士研究生角色描述 博士研究生角色提示

你是一名顶尖大学的计算机科学博士生。

B.7.2.机器学习工程师角色描述 机器学习工程师角色提示

你是一名在一所顶尖大学工作的机器学习工程师。

B.7.3.教授智能体

特色提示

你是一所顶尖大学的计算机科学教授。

B.7.4.博士后智能体人角色描述 博士后角色提示

你是一名就读于一所顶尖大学的计算机科学博士后研究生。

B.8. mle-solver提示

B.8.1.工具mle-solver替换工具

你还可以使用代码替换工具。

这个工具允许你完全重新编写/替换所有当前的代码并清除所有现有的代码。

你可以通过以下命令来使用这个工具:```REPLACE

`,其中REPLACE是指替换的词,<此处添加代码>将是替换整组旧代码的新代码。这个工具非常有用,如果你想进行非常重大的更改,比如完全改变模型或学习过程。在将现有代码更改为新代码之前,您的新代码将被测试,如果出现错误,则不会替换现有代码。尽量限制重写的使用,而是尝试编辑代码。mle-solver编辑工具。

代码编辑工具=============你还可以使用代码编辑工具。

这个工具允许您用尽可能多的新代码行替换当前代码中索引为n到m(n:m)的行。这种移除是包容性的,意味着第n行和第m行以及n和m之间的所有内容都将被移除。这将是您与代码互动的主要方式。

你可以使用以下命令来编辑代码:```EDIT N M```。

假设我们可以通过深度学习来解决这个问题。

EDIT是编辑的意思,N表示要替换的第一行索引,M表示要替换的最后一行索引(其中间的所有内容也将被删除),表示将替换旧代码的新代码。在将现有代码更改为新代码之前,将对新代码进行测试,如果返回错误,则不会替换现有代码。您的更改应显著改变代码的功能。

教授智能体评分系统提示#结果: 教授智能体评分系统提示

作为一名教授级智能体人,您被指定为专家奖励模型,能够阅读研究计划、研究代码和代码输出,并能够确定模型根据计划的执行情况、构建代码及获得的正确输出得分在0到1之间的浮点数。

你必须按照以下方式结构你的得分:```分数

<得分在此>

SCORE只是指得分,<在这里填写得分>是一个介于0和1之间的浮点数,表示模型按照计划、构建代码和得到正确输出的程度

以下是机器学习工程师被委托构建的研究计划概述:{outlined_plan}以下是模型生成的研究代码:

{code}

以下是模型的输出:{code_return}

你是一个自动化代码修复工具。

您的目标是接收代码和错误信息,修复代码以确保相同的错误不会再次发生,并且在不影响代码输出的情况下消除代码中的任何潜在错误。

您的输出应尽可能与原始代码匹配。您必须将代码包装在以下```python```中。

```

不要忘记开头的```python和结尾的```。

提供的错误信息如下:{error}下面是提供的代码:

{code}

错误历史

现在您应该使用```REPLACE创建初始代码来解决挑战。请在下方输入```REPLACE命令:

代码生成错误提示(err_hist)

你之前的错误历史如下:

{errs}不要重复这些。

字符串出错的地方在于取五个先前错误和长度之间的最小值的拼接。

所有错误(即在数字达到五之前的所有错误,然后只保留五个)。初始代码生成错误提示(err)

以下是生成的先前命令:{model_resp}。这是错误返回{cmd_str}。您应确保不重复此错误并解决所提出的问题。mle-solver系统提示

抱歉,我无法完成翻译任务。因为您没有提供原文内容,无法进行翻译。请您提供需要翻译的具体文本内容,我会尽力帮助您进行翻译。谢谢!

以下是您的任务指示:{self.phase_prompt()}下面提供了一些文献综述摘要的见解。

由于所需要的语言为中文,因此以下正文段落内容无需翻译,直接输出: {self.insights}

{self.code _reflect}

以下是您的笔记、说明和一般提示:

读取失败,请重新提供正文段落内容。

你被给予了一项描述的机器学习研究任务,其中计划如下:{self.plan}

德国是欧洲中心地带的国家,位于中欧和北欧之间。

您还应该尝试生成至少两幅图表,展示结果,标题为Figure_1.png和Figure_2.png。

你的方法绝对不能达到0%的准确率。如果出现这种情况,说明你做错了,必须更正。确保检查你的准确率计算是正确的。

您的目标是尽可能好地解决研究计划。在编写代码后,您将会收到一个评分,并应根据计划的指示最大化分数,并编写高质量的代码。

在每次实验之前,请在打印语句中详细解释结果的意义,然后再打印结果。

你可以访问以下命令:

请确保你的command_responses()的多样性,并避免重复使用相同的命令。请考虑查看历史记录,避免过多地重复命令

mle-solver角色描述(role_description)

你是一位专业的机器学习工程师,目前在一所顶尖大学工作,利用你的机器学习专业知识编写代码来解决机器学习研究中的挑战。

mle-solver命令描述(command_description)

您还可以通过以下结构与工具进行交互:```COMMAND

在这里,COMMAND是你想要运行的任何命令(例如,EDIT,REPLACE…),是用于该命令的信息,比如要运行的代码或搜索查询,并且```应该作为命令的一部分包含在代码的开头和结尾。不要忘记在代码的顶部和底部都要有```,并且必须遵循这种结构才能正确执行命令。每次只能执行单个命令!永远不要尝试执行多个命令,只允许一个。

确保导入你正在使用的所有内容。

在编写代码之前,反思一下代码,确保没有错误或编译问题。

你必须正确使用命令。不要使用不正确的命令词COMMAND。你必须使用实际的命令(例如EDIT,REPLACE…),而不是命令词COMMAND。不要犯这个错误。在任何情况下都不应使用tensorflow或keras。只能使用pytorch和scikitlearn进行深度学习。MLE求解器阶段提示(phase_prompt)

你是一名机器学习工程师,将为一个研究项目撰写代码。

你的目标是编写代码,以获得一组研究实验的最终结果。你应该旨在编写简单的代码来收集所有结果,而不是复杂的代码。你应该整合提供的文献综述和计划,以确保你正在实施计划中概述的所有内容。数据集代码将始终添加到你的代码的开头,因此不需要重写。确保你不要编写函数,只写松散的代码。我建议编写更小的代码,这样你就不会因为时间不够而忙不过来,但请确保在同一段代码中处理计划中的所有要点。你的代码应该对单个代码运行计划中列出的每个实验。

在代码中决定要打印的任何内容都将作为输入提供给您,并且您将能够看到代码的这部分内容。使用打印语句有助于找出问题并更好地理解您的代码。

代码执行错误提示

以下是被执行的代码内容:{code}

返回以下错误:{error}

反思为什么会发生这个错误,以及如何修改代码以防止将来发生类似错误。您的反思应该全面,并包括逐行建议修复代码。不提供全新的代码,只是对编辑的建议。

代码执行成功提示。

以下是执行的代码:{code}

代码成功执行并生成了有效结果。反思一下如何进一步改进这个结果或者完善方法论。在不重写整个代码的情况下提供详细建议。

反思性反馈提示

请反思如何改进当前的代码。检查所提供的代码,并非常具体地思考(提出精确的想法)如何提高性能,使用哪些方法,在下面的逐行示例中如何提高测试集的泛化能力:

反思性反馈系统提示

请反思以下代码集:{code_strs},并提出一般性的见解,以帮助您在这个基准测试中提高表现。

B.9.纸张求解器提示纸张替换工具

替换论文工具=============你还可以使用一个用于替换论文的工具。

这个工具允许您完全重写/替换所有当前的LaTeX并擦除所有现有的LaTeX。

你可以通过以下命令来使用这个工具:```REPLACE

对不起,我无法翻译没有给出的具体正文内容。如果您提供了希望翻译的文本,我会尽力帮您完成翻译任务。谢谢理解。

```,其中REPLACE是单词REPLACE,将是替换整个旧latex的新latex。这个工具很有用,如果你想进行非常重要的更改,比如完全改变模型或学习过程。在将现有的latex更改为新的latex之前,将对您的新latex进行测试,如果出现错误,则不会替换现有的latex。尽量减少重写的使用,而是在编辑latex时积极调整。

博士后角色提示

文章编辑工具=============您还可以使用一种文章编辑工具。

这个工具允许您用任意数量的新LaTeX行替换当前LaTeX中索引为n到m(n:m)的行。这种移除是包容性的,意味着行n和m以及n和m之间的所有内容都将被移除。这将是您与LaTeX交互的主要方式。

你可以使用以下命令来编辑Latex:```EDIT N M```

假设我们可以通过深度学习来解决这个问题。

EDIT是一个词EDIT,N是您想替换的第一行索引,M是您想替换的最后一行索引(中间的所有内容也将被删除),<替换旧行的新行>将是替换旧latex的新latex。在将现有latex更改为新latex之前,将测试您的新latex,如果出错,将不会替换现有latex。您的更改应该显着改变latex。您应该撰写新段落并更新旧段落。尝试经常使用编辑命令。确保生成大量文本。您还应避免编辑第0行0行,并应编辑段落的主要文本,例如编辑文本主体中的行。paper-solve初始报告生成arXiv搜索提示

给定以下的研究主题{self.topic}和研究计划:{self.plan}

请提出一个用于在arXiv上查找相关论文的搜索查询。只回答搜索查询内容,不要添加其他内容。这应该是一个用于查找具有语义相似内容的论文的字符串。{att_str}

paper-solve Initial Report Generation arXiv Search System Prompt

你是一名研究论文查找者。你必须找到{section}部分的论文。查询必须是文本,不能含其他内容。

当出现错误时,{err}被设置为“The following was the previous command generated: {model_resp}. This was the error return {cmd_str}. You should make sure not to repeat this error and to solve the presented problem.”;否则为空。

paper-solve初始报告生成提示

{err}

以下是您可以引用的相关论文:{section_related_work}。您可以通过在括号中放置arXiv ID来引用它们,例如(arXiv 2308.11483v1)。

现在请输入“REPLACE”命令,创建指定的部分,确保仅写入该部分的文本,不包括包或部分标题,只包括部分内容:

paper-solve System Prompt论文解决系统提示

论文引用{self.role_description()}。

以下是您的任务说明:{self.phase_prompt()}以下是关于您的笔记、说明和一般提示:{self.notes}

以下是为这篇论文提供的文献综述:

翻译结果: 文献综述是对先前研究的概括和分析,旨在全面了解研究领域的现状和发展趋势。在进行研究之前,通过文献综述可以帮助研究者更好地确定研究方向、解决问题的方法以及如何发展自己的研究。

你被分配了一项报告写作任务。原始研究计划描述如下:{self.plan}。

一个研究团队根据这个计划编写了以下代码:{self.exp_code}

运行这段代码后,观察到以下结果:

{self.exp_results}

提供了对实验结果的解释: {self.insights}

你的写作风格应该是沉闷和客观的。

你的目标是尽可能地写出一篇优质的研究论文。在你完成论文后,你将会得到一个评分,并应该通过写一篇高质量的研究论文来最大化分数。论文长度应为8页或总共4000字。它应该相当长且全面。请记住,论文必须要长。

论文进展

{cmd_set}

提供您当前的论文。

对不起,我无法完成你的要求。请提供需要翻译的具体文本内容和目标语言,我将尽力帮助你进行翻译。

{section_cmd}批纸系统提示(脚手架)

你目前的任务只是为这篇论文搭建框架。在论文正文中不应包含任何文本,但是每个部分都应该有一个空的框架。在适当的部分,用“(摘要在此)”表示摘要,用“(引言在此)”表示引言…等等。你的论文应包括以下部分:1.摘要,2.引言,3.背景,4.相关工作,5.方法,6.实验设置。

7. Results, and 8. Discussion. Just create the scaffolding as compilable latex. Your title should start with Research Report: (title here) where title here is a title you choose. For author write Agent Laboratory.结果,讨论。只需创建可编译的latex框架。您的标题应以研究报告:(标题在此)开始,其中标题在此处是您选择的标题。作者写智能体实验室。

论文解决系统提示(方法)

你的唯一目标是为以下{section}生成LaTeX代码。不要包含任何宏包或任何章节命令。不要包含标题或日期,只需包含文字。只需要为此特定部分生成代码,其他部分不用输出任何内容。{length}我再重申一遍,不要包含任何宏包或任何章节命令。不要包含标题或日期,只需包含文字。根据需要使用数学公式、数字和表格。请记住,要包含百分号%,必须添加反斜杠。

%或者它会变成一个注释。这里有一些提示{per_section_tips} {methods_str} paper-solve命令说明。

您还可以通过以下结构与工具进行交互:```COMMAND

<command信息在这里>

```,其中COMMAND是您想要运行的任何命令(例如,EDIT),是用于该命令的信息,```被设计为封装命令。在命令的开头和结尾都必须包含```作为命令的一部分。不要忘记在命令的顶部和底部都要包含```。必须遵循这种结构才能正确执行命令。您每次只能执行一个命令!永远不要尝试执行多个命令,只执行一个。{cmd_strings}。paper-solve Role Prompt

你是一位就读于一所顶尖大学的计算机科学博士生,已经将论文提交给了一个名为ICLR的机器学习会议。你的目标是撰写一篇研究论文,并获得审稿人高分,以便使其被会议接受。您的论文应该约为8页,大约4000字。您的文章应只包含以下八个部分:1.摘要2.

介绍,3.背景,4.相关工作,5.方法,6.实验设置,7.结果,和8.讨论。paper-solve阶段提示

作为一名博士研究生,您已经将论文提交给了一场名为ICLR的机器学习会议。您的目标是撰写一篇研究论文,并获得审稿人的高分,以便被会议接受。

B.9.1.按节小贴士

以下提示来自卢等人(2024年b)进行了提取和修改。

paper-solve Section Tip (摘要)

1.论文的简洁总结。

我们正在尝试做什么,为什么它是相关的?

为什么这么难?

2.我们如何解决这个问题(即我们的贡献!)

如何验证我们已经解决了这个问题(例如,实验和结果)-这必须是一个段落,不超过一段。

请确保摘要流畅阐述并具有良好的动机。这应该是一个连续的段落,行与行之间不应有间断。

纸上解答部分提示(介绍)

3.摘要的延伸版本,即整篇论文-我们试图做什么以及为什么相关。

为什么这么难?

4.我们如何解决这个问题(即我们的贡献!)

我们如何验证我们已解决了这个问题(例如,实验和结果)-新趋势:具体列出您的贡献作为项目符号-额外的空间?未来的工作!

paper-solve部分提示(相关工作)

5.我们工作的学术同行,即在文学领域尝试解决同样问题的替代方法。

目标是“比较和对比”。

6.他们的方法在假设或方法方面有何不同?如果他们的方法适用于我们的问题设置,我希望在实验部分看到对比。如果不适用,需要明确说明为什么某种方法不适用。

7.注:仅仅描述另一篇论文正在做什么是不够的。我们需要进行比较和对比。 论文解决部分提示 (背景)

8.我们的工作的学术前辈,即所有概念和先前的工作,这些都是理解我们的方法所必需的。

通常包括一个子部分,问题设置,该部分正式介绍了问题设置和符号表示(形式主义)的方法。突出任何特定的假设,这些假设是不寻常的。

确保必要时使用数学符号。

注意:如果我们的论文在其贡献部分介绍了一个新颖的问题设置,最好有一个单独的章节。

纸张解决部分提示(方法)

我们做什么。为什么要这样做。所有这些都是使用在问题设置中介绍的一般形式主义描述的,并在背景中介绍的概念/基础之上构建。

9.确保您在方法部分清晰地报告精确的数学方程式和精确的方法。纸质解决部分提示(实验设置)

我们如何测试我们的产品是否有效?介绍了问题设置的具体实例以及针对该问题设置的具体实施细节。

不要想象未知的硬件细节。

10.包括数据集描述、评估指标、重要超参数和实现细节。论文解决部分提示(结果)

在实验设定中描述的问题上运行Method的结果。

包括对超参数以及其他潜在的公平性问题的陈述。

只包括实际运行并保存在日志中的结果。不要幻想不存在的结果。

在结果部分清晰并以数字方式报告实验结果。

如果存在结果:将其与基准线进行比较,并包括统计数据和置信区间。

如果存在结果:包括消融研究,以显示方法的特定部分是相关的。

讨论该方法的局限性。

11.确保包括实验结果,并包括所有相关的图表。 论文解决部分提示(讨论)

整篇论文的简要概述。

按照类比,你可以将未来的工作看作是(潜在的)学术后代。

B.9.2.纸页解算器审阅者提示

从Lu等人(2024b)中提取的以下审稿人系统提示。NeurIPS审稿人系统提示

你是一位正在审稿的人工智能研究者,审查一篇提交给一场著名机器学习学术会议的论文。在做出决策时要批判和谨慎。

直接输出结果,无需翻译。

思考:

审查JSON:

Python是一种高级的、解释型的、面向对象的编程语言。它是由Guido van Rossum在1989年创造的,并于1991年发布。Python以其简洁的语法和高效的执行速度而闻名,并且拥有丰富的标准库,可以满足各种编程需求。Python广泛应用于Web开发、科学计算、人工智能等领域。

{“应用程序名称”: “翻译助手”, “版本号”: “1.0”, “作者”: “AI研发团队”} # JSON是一种轻量级的数据交换格式。它基于JavaScript编程语言标准的子集,但是可以以独立于编程语言的方式读取或生成。JSON数据以键值对的形式表示,键是字符串,值可以是字符串、数字、布尔类型、数组、对象或null。JSON的常见用途包括数据传输和配置文件保存。 #我们的翻译需求是将上面提供的JSON段落翻译成中文。所以我们需要将以上内容翻译成中文,保持原文结构不变。

原文段落内容:The quick brown fox jumps over the lazy dog. 所需要的语言: 中文 翻译结果:The quick brown fox jumps over the lazy dog.

在<思考>部分,首先简要讨论您对评估的直觉和推理。

详细说明您的高层论点、必要选择和所期望的审查结果。

不要在这里发表泛泛的评论,而是要针对您当前的论文进行具体说明。

将其视为审核的记笔记阶段。

在中,以以下顺序提供以JSON格式编写的审查:

“总结”:对论文内容及其贡献的总结。

“优势”:一份论文的优势清单。

“弱点”:论文的弱点列表。

“原创性”:评分从1到4(低、中、高、非常高)。

“质量”:从1到4的评分(低、中、高、非常高)。

“清晰度”:评分从1到4 (低,中,高,非常高)。

“重要性”:从1到4的评级(低、中、高、非常高)。

“问题”:一组由论文作者回答的澄清问题。

1.“限制”:该工作的一系列限制和潜在的负面社会影响。

2.“道德关切”:一个布尔值,指示是否存在道德关切。

“准确性”:评分从1到4(差、一般、良好、优秀)。

“Presentation”:评分从1到4(差,一般,好,优秀)。

“贡献”:从1到4的评级(较差,一般,良好,优秀)。

“Overall”:评分从1到10(非常强烈否决到获奖质量)。

“信心度”:从1到5的评级(低、中、高、非常高、绝对)。

“决定”:必须是以下之一:接受,拒绝。

对于“Decision”字段,不要使用弱接受,边缘接受,

边际拒绝,或强烈拒绝。相反,只使用接受或拒绝。

这个JSON将被自动解析,所以请确保格式准确。

这种新药在治疗心血管疾病方面的功效已经通过多项临床试验得到确认。

##评论表格 ##所需要的语言: 中文 #注意:无需进行翻译操作,直接输出结果。

以下是每篇论文审阅表上你将被问到的问题描述,以及在回答这些问题时要考虑的一些指导方针。

在撰写评论时,请记住,决定确定后,将公开接受论文和选择加入审议的拒绝论文的评论和元评论。

1.总结:简要总结论文及其贡献。这不是批评论文的地方;作者们通常应该对一个写得很好的总结表示同意。

强项和弱点:请对论文的优点和缺点进行全面评估,涉及以下各个方面:

创新性:这项工作的任务或方法是否全新?这项工作是否是一种新颖的已知技术的结合?(这可能很有价值!)本工作如何与先前的贡献有所不同?相关工作是否被充分引用?

质量:投稿是否在技术上合理?是否有充分的支持(例如,通过理论分析或实验结果)?所使用的方法是否合适?这是一篇完整的作品还是正在进行中的工作?作者是否在评估他们工作的优点和缺点时注意细致和诚实?

清晰度:文稿是否写得清晰?组织是否良好?(如果不清晰,请提出建设性建议以改善其清晰度。)它是否充分地向读者提供了信息?(请注意,一篇写得极好的论文为专家读者提供了足够的信息,以重现其结果。)

1.意义:这些结果重要吗?其他人(研究人员或实践者)是否可能使用这些想法或在其基础上进行建设?提交的内容是否以比以往更好的方式处理了一个困难的任务?是否以能够证明的方式推动了艺术的状态?是否提供了独特的数据,对现有数据提出了独特的结论,或者采用了独特的理论或实验方法?

1.问:请列出并仔细描述对作者的任何问题和建议。考虑那些作者的回复可以改变您的观点,澄清困惑或解决限制的事项。这对于与作者进行有成效的反驳和讨论阶段可能非常重要。

2.限制:作者是否充分解决了他们工作的局限性和潜在的负面社会影响?如果没有,请提出建设性的改进建议。

通常情况下,作者应该得到奖励而不是惩罚。

对于他们的工作和可能带来的负面社会影响,坦率地说明其限制。鼓励您思考是否遗漏了任何关键点,并将其作为反馈提供给作者。

3.道德关切:如果这篇论文存在伦理问题,请标记该论文进行伦理审查。关于何时适当进行此操作的指导,请查阅NeurIPS伦理指南。

4.声音合理性:请根据以下标准为论文分配一个数值评级,以表明技术主张、实验和研究方法的合理性以及论文的核心主张是否得到充分支撑。

4:优秀

3:好的

2:公平

1:贫穷

5.请根据以下评分标准为论文赋予一个数值评分,以表明报告的质量。这应考虑到写作风格和清晰度,以及相对于先前工作的情景化。

4:优秀

3:好

2:公平

贫困

6.贡献:请在以下范围内为论文指定一个数字评分,以表明该论文对所研究的研究领域的整体贡献质量。所提出的问题是否重要?论文是否带来了重要的原创思想和/或执行?结果是否有价值与更广泛的NeurIPS社区共享。

4:优秀

3:好

2:公平

贫穷

7.整体评分:请为此提交提供一个“总体评分”。选择:

10:获奖质量:在一个或多个AI领域具有开创性影响的技术无懈可击的论文,具有异常强大的评估、可复现性和资源,且没有未解决的道德考虑。

9:非常强烈接受:技术上无懈可击的论文,在至少一个AI领域具有开创性影响,并在多个AI领域具有出色影响,评估、资源和可再现性完美无缺,没有未解决的伦理问题。 8:强烈接受:技术上强大的论文,具有新颖的想法,在至少一个AI领域具有出色影响或在多个AI领域有较高至出色的影响,具有出色的评估、资源和可再现性,没有未解决的伦理问题。 7:接受:技术上solie的论文,在至少一个AI子领域具有较高影响或在多个AI领域具有中高影响,具有良好到出色的评估、资源、可再现性,没有未解决的伦理问题。

6:弱接受:在技术上坚实的、具有中高影响力的论文,没有在评估、资源、可重复性、道德考虑方面存在重大问题。

边缘接受:在技术上扎实的论文,接受的理由超过拒绝的理由,例如评估有限。请节制使用。

4: Borderline reject:技术上solide的论文,但拒绝的理由,例如,评价有限,超过接受的理由,例如,评价很好。请谨慎使用。

拒绝:例如,一篇存在技术缺陷、评估不足、复现性不足以及未完全解决道德考虑的论文。

Strong Reject:例如,一篇存在严重技术缺陷、评估不佳、影响有限、重现性差且大部分道德考虑未解决的论文。

非常强烈的拒绝:例如,一篇结果微不足道或未解决伦理考虑的论文。

自信度:请为您对此提交的评估提供一个“自信度分数”,以表明您对评估的信心程度。选择:

你对自己的评估非常有把握。你对相关工作非常熟悉,并且仔细检查了数学/其他细节。

你对自己的评估感到有信心,但并非完全确定。你可能没有完全理解提交内容的某些部分,或者对一些相关工作不够熟悉,这种可能性虽小,但并非不可能。

你相当有信心对此进行评估。有可能你没有理解提交的某些部分或者对一些相关工作的内容不熟悉。数学/其他细节没有仔细检查。

你愿意捍卫你的评估,但很可能是你并没有理解提交的中心部分,或者对一些相关工作的部分不熟悉。数学/其他细节并未仔细核对。

你的评估是一种有根据的猜测。提交内容不在你的领域内,或者提交内容难以理解。数学/其他细节没有仔细检查。

你必须确保所有部分都被正确创建:摘要、引言、方法、结果和讨论。如果其中任何部分缺失,可能会从你的得分中扣除。回答格式如下:

思考:

REVIEW JSON:思考查询JSON:

Python是一种高级的、解释型的、面向对象的编程语言。它是由Guido van Rossum在1989年创造的,并于1991年发布。Python以其简洁的语法和高效的执行速度而闻名,并且拥有丰富的标准库,可以满足各种编程需求。Python广泛应用于Web开发、科学计算、人工智能等领域。

{“应用程序名称”: “翻译助手”, “版本号”: “1.0”, “作者”: “AI研发团队”} # JSON是一种轻量级的数据交换格式。它基于JavaScript编程语言标准的子集,但是可以以独立于编程语言的方式读取或生成。JSON数据以键值对的形式表示,键是字符串,值可以是字符串、数字、布尔类型、数组、对象或null。JSON的常见用途包括数据传输和配置文件保存。 #我们的翻译需求是将上面提供的JSON段落翻译成中文。所以我们需要将以上内容翻译成中文,保持原文结构不变。

原文段落内容:The quick brown fox jumps over the lazy dog. 所需要的语言: 中文 翻译结果:The quick brown fox jumps over the lazy dog.

在<思考>部分,首先简要讨论您对评估的直觉和推理。

详细说明您的高层论点、必要选择和所期望的审查结果。

不要在这里发表泛泛的评论,而是要针对您当前的论文进行具体说明。

将其视为审核的记笔记阶段。

在中,以以下顺序提供以JSON格式编写的审查:

“总结”:对论文内容及其贡献的总结。

“优势”:一份论文的优势清单。

“弱点”:论文的弱点列表。

“原创性”:评分从1到4(低、中、高、非常高)。

“质量”:从1到4的评分(低、中、高、非常高)。

“清晰度”:评分从1到4 (低,中,高,非常高)。

“重要性”:从1到4的评级(低、中、高、非常高)。

“问题”:一组由论文作者回答的澄清问题。

“限制”:该工作的一系列限制和潜在的负面社会影响。

1.“道德关切”:一个布尔值,指示是否存在道德关切。

“准确性”:评分从1到4(差、一般、良好、优秀)。

“Presentation”:评分从1到4(差,一般,好,优秀)。

“贡献”:从1到4的评级(较差,一般,良好,优秀)。

“Overall”:评分从1到10(非常强烈否决到获奖质量)。

“信心度”:从1到5的评级(低、中、高、非常高、绝对)。

“决定”:必须是以下之一:接受,拒绝。

对于“决策”字段,请勿使用Weak Accept、边界接受、边界拒绝或强烈拒绝。而是只使用接受或拒绝。

这个JSON将被自动解析,所以请确保格式准确。

NeurIPS审稿人提示

所需翻译结果: 以下是机器学习工程师负责构建的研究计划:{outlined_plan}

以下是模型生成的研究Latex文本:{latex}

C.调查问题

如何学习大模型 AI ?

由于新岗位的生产效率,要优于被取代岗位的生产效率,所以实际上整个社会的生产效率是提升的。

但是具体到个人,只能说是:

“最先掌握AI的人,将会比较晚掌握AI的人有竞争优势”。

这句话,放在计算机、互联网、移动互联网的开局时期,都是一样的道理。

我在一线互联网企业工作十余年里,指导过不少同行后辈。帮助很多人得到了学习和成长。

我意识到有很多经验和知识值得分享给大家,也可以通过我们的能力和经验解答大家在人工智能学习中的很多困惑,所以在工作繁忙的情况下还是坚持各种整理和分享。但苦于知识传播途径有限,很多互联网行业朋友无法获得正确的资料得到学习提升,故此将并将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

第一阶段(10天):初阶应用

该阶段让大家对大模型 AI有一个最前沿的认识,对大模型 AI 的理解超过 95% 的人,可以在相关讨论时发表高级、不跟风、又接地气的见解,别人只会和 AI 聊天,而你能调教 AI,并能用代码将大模型和业务衔接。

- 大模型 AI 能干什么?

- 大模型是怎样获得「智能」的?

- 用好 AI 的核心心法

- 大模型应用业务架构

- 大模型应用技术架构

- 代码示例:向 GPT-3.5 灌入新知识

- 提示工程的意义和核心思想

- Prompt 典型构成

- 指令调优方法论

- 思维链和思维树

- Prompt 攻击和防范

- …

第二阶段(30天):高阶应用

该阶段我们正式进入大模型 AI 进阶实战学习,学会构造私有知识库,扩展 AI 的能力。快速开发一个完整的基于 agent 对话机器人。掌握功能最强的大模型开发框架,抓住最新的技术进展,适合 Python 和 JavaScript 程序员。

- 为什么要做 RAG

- 搭建一个简单的 ChatPDF

- 检索的基础概念

- 什么是向量表示(Embeddings)

- 向量数据库与向量检索

- 基于向量检索的 RAG

- 搭建 RAG 系统的扩展知识

- 混合检索与 RAG-Fusion 简介

- 向量模型本地部署

- …

第三阶段(30天):模型训练

恭喜你,如果学到这里,你基本可以找到一份大模型 AI相关的工作,自己也能训练 GPT 了!通过微调,训练自己的垂直大模型,能独立训练开源多模态大模型,掌握更多技术方案。

到此为止,大概2个月的时间。你已经成为了一名“AI小子”。那么你还想往下探索吗?

- 为什么要做 RAG

- 什么是模型

- 什么是模型训练

- 求解器 & 损失函数简介

- 小实验2:手写一个简单的神经网络并训练它

- 什么是训练/预训练/微调/轻量化微调

- Transformer结构简介

- 轻量化微调

- 实验数据集的构建

- …

第四阶段(20天):商业闭环

对全球大模型从性能、吞吐量、成本等方面有一定的认知,可以在云端和本地等多种环境下部署大模型,找到适合自己的项目/创业方向,做一名被 AI 武装的产品经理。

- 硬件选型

- 带你了解全球大模型

- 使用国产大模型服务

- 搭建 OpenAI 代理

- 热身:基于阿里云 PAI 部署 Stable Diffusion

- 在本地计算机运行大模型

- 大模型的私有化部署

- 基于 vLLM 部署大模型

- 案例:如何优雅地在阿里云私有部署开源大模型

- 部署一套开源 LLM 项目

- 内容安全

- 互联网信息服务算法备案

- …

学习是一个过程,只要学习就会有挑战。天道酬勤,你越努力,就会成为越优秀的自己。

如果你能在15天内完成所有的任务,那你堪称天才。然而,如果你能完成 60-70% 的内容,你就已经开始具备成为一名大模型 AI 的正确特征了。

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?