先自我介绍一下,小编浙江大学毕业,去过华为、字节跳动等大厂,目前阿里P7

深知大多数程序员,想要提升技能,往往是自己摸索成长,但自己不成体系的自学效果低效又漫长,而且极易碰到天花板技术停滞不前!

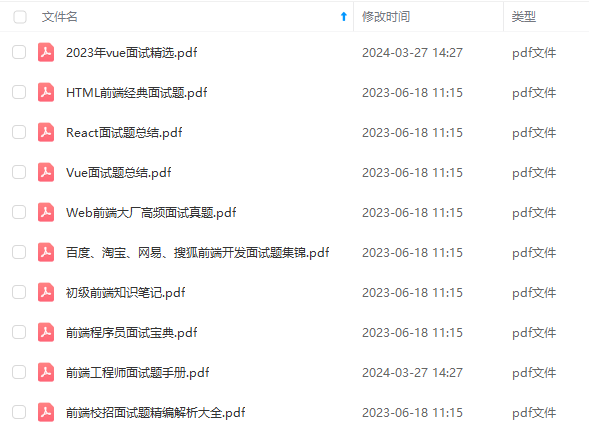

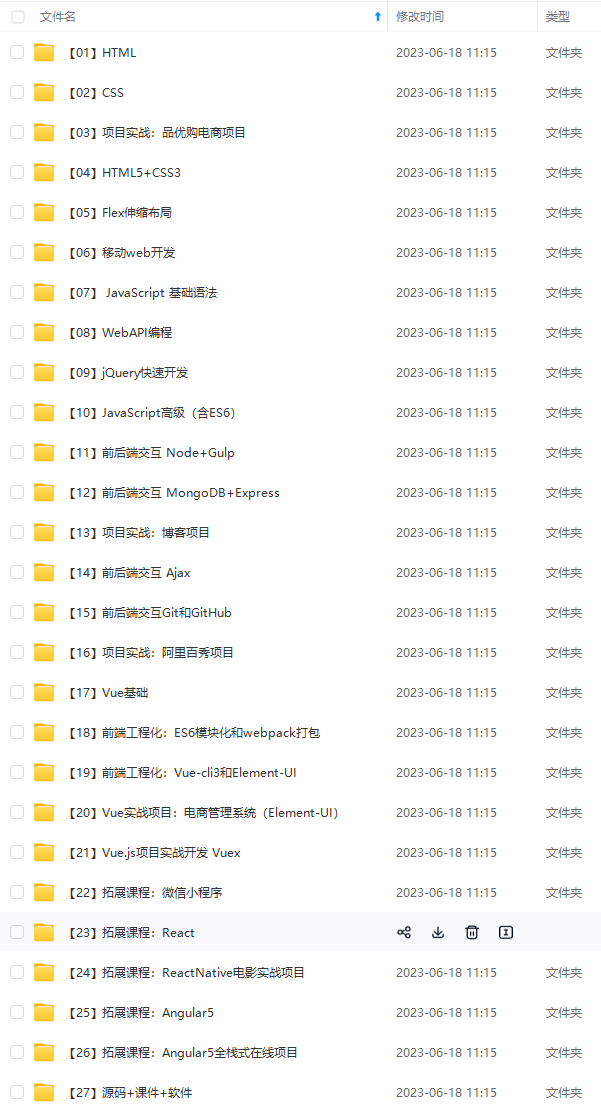

因此收集整理了一份《2024年最新Web前端全套学习资料》,初衷也很简单,就是希望能够帮助到想自学提升又不知道该从何学起的朋友。

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上前端开发知识点,真正体系化!

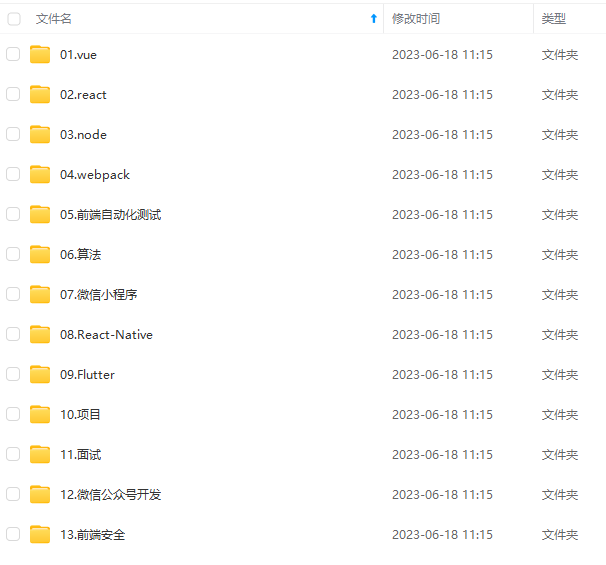

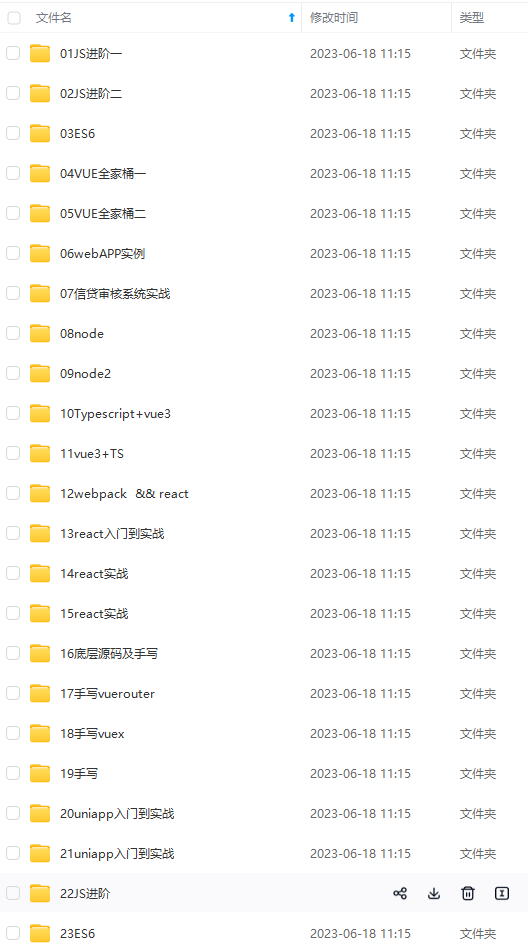

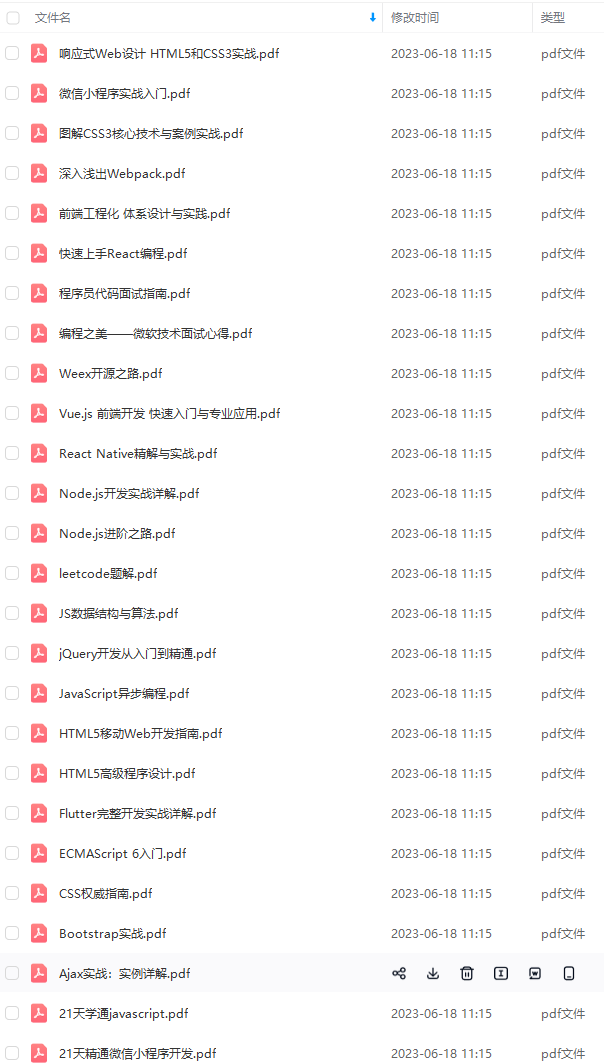

由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新

如果你需要这些资料,可以添加V获取:vip1024c (备注前端)

正文

z = x + y

print(z)

矩阵转置

print(y.t())

矩阵相乘

print(x.mm(y.t()))

点乘

print(x*y)

转置操作可以用.t()来完成,也可以用 transpose(0,1)来完成。

2.2 Tensor 与 numpy.ndarray 之间的转换

PyTorch 的Tensor 可以与Python 的常用数据处理包Numpy 中的多维数组进行转换。

import torch

import numpy as np

为深度学习创建PyTorch张量-最佳选择

Tensor与tensor区别: 区别是:默认数据类型与指定的数据类型。

data = np.array([1, 2, 3])

另外一种转换 Tensor 的方法,为 torch.FloatTensor(data)

t1 = torch.Tensor(data)

t2 = torch.tensor(data)

t3 = torch.as_tensor(data)

t4 = torch.from_numpy(data)

print(t1)

print(t2)

print(t3)

print(t4)

print(t1.dtype)

print(t2.dtype)

print(t3.dtype)

print(t4.dtype)

‘’'tensor([1., 2., 3.])

tensor([1, 2, 3], dtype=torch.int32)

tensor([1, 2, 3], dtype=torch.int32)

tensor([1, 2, 3], dtype=torch.int32)

torch.float32

torch.int32

torch.int32

torch.int32’‘’

tensor 转化为 numpy 的多维数组

print(t1.numpy())

‘’‘[1. 2. 3.]’‘’

Tensor 和 Numpy 的最大区别在于 Tensor 可以在 GPU 上进行运算。

默认情况下,Tensor 是在 CPU 上进行运算的,如果我们需要一个 Tensor

在 GPU 上的实例,需要运行这个 **Tensor 的.cuda()**方法。

在下面的代码中,首先判断在本机上是否有 GPU 环境可用(有 NVIDIA 的GPU,并安装了驱动)。如果有 GPU 环境可用,那么再去获得张量 x,y 的 GPU 实例。注意在最后打印 x 和 y 这两个 GPU 张量的和的时候,我们调用了.cpu() 方法,意思是将 GPU 张量转化为 CPU 张量,否则系统会报错。

import torch

x = torch.rand(5, 3)

y = torch.ones(5, 3)

if torch.cuda.is_available():

x = x.cuda()

y = y.cuda()

z = x+y

print(z)

print(z.cpu())

‘’'tensor([[1.4453, 1.6272, 1.3072],

[1.9444, 1.2703, 1.8512],

[1.8694, 1.1878, 1.8789],

[1.5737, 1.8825, 1.4636],

[1.8158, 1.9969, 1.8819]], device=‘cuda:0’)

tensor([[1.4453, 1.6272, 1.3072],

[1.9444, 1.2703, 1.8512],

[1.8694, 1.1878, 1.8789],

[1.5737, 1.8825, 1.4636],

[1.8158, 1.9969, 1.8819]])‘’’

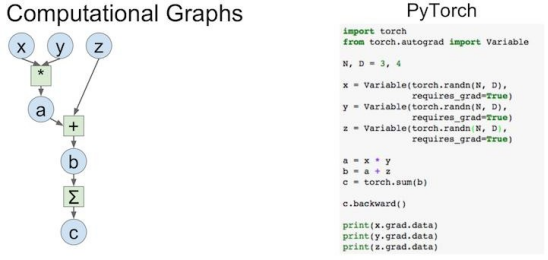

动态运算图(DynamicComputationGraph)是 PyTorch 的最主要特性,它可以让我们的计算模型更灵活、复杂,并可以让反向传播算法随时进行。而反向传播算法就是深度神经网络的核心。

下面是一个计算图的结构以及与它对应的 PyTorch 代码:

import torch

from torch.autograd import Variable

N, D = 3, 4

产生标准正态分布的随机数或矩阵的函数 randn

x = Variable(torch.randn(N, D), requires_grad=True)

y = Variable(torch.randn(N, D), requires_grad=True)

z = Variable(torch.randn(N, D), requires_grad=True)

a = x*y

b = a+z

c = torch.sum(b)

c.backward()

print(x.grad)

print(y.grad)

print(z.grad)

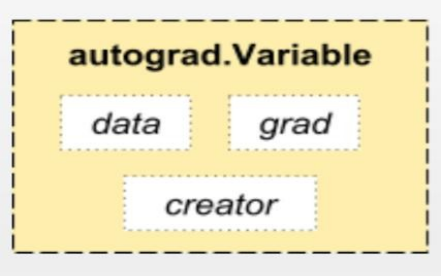

用来构建计算图的数据叫做自动微分变量(Variable),它与 Tensor 不同。每个 Variable 包含三个属性,分别对应着数据(data),父节点(creator), 以及梯度(grad)。其中**“梯度”就是反向传播算法所要传播的信息**。而父节点用于将每个节点连接起来构建计算图(如上图所示)。

下面我们编写代码实际使用自动微分变量。

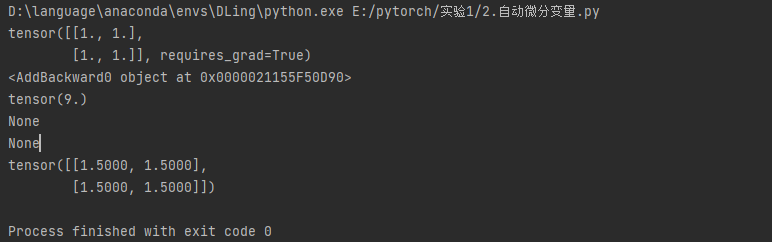

import torch

导入自动梯度运算包,主要用Variable这个类

from torch.autograd import Variable

创建一个Variable ,包裹了2*2张量,将需要计算梯度属性置为True

x = Variable(torch.ones(2, 2), requires_grad=True)

print(x)

y = x+2

每个Variable都有一个creator (创造者节点)

print(y.grad_fn)

z = torch.mean(y*y)

.data 返回z包裹的Tensor

print(z.data)

backward 可以实施反向传播算法,并计算所有计算图上叶子节点(没有子节点)的导数(梯度)信息。

注意,由于 z 和 y 都不是叶子节点,所以都没有梯度信息。

z.backward()

print(z.retain_grad())

print(y.retain_grad())

z对x的倒数

print(x.grad)

import torch

from torch.autograd import Variable

s = Variable(torch.FloatTensor([[0.01, 0.02]]), requires_grad=True)

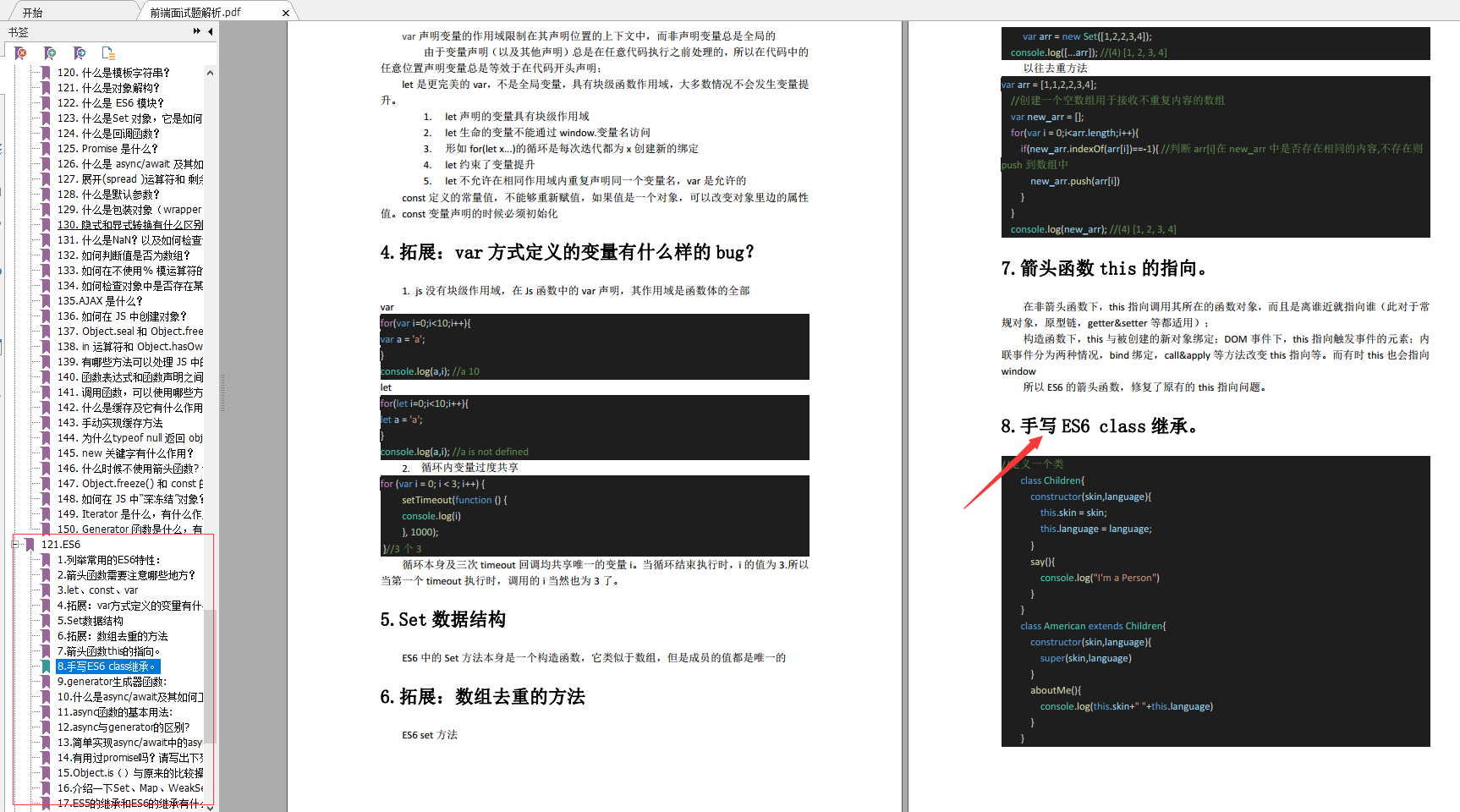

ES6

-

列举常用的ES6特性:

-

箭头函数需要注意哪些地方?

-

let、const、var

-

拓展:var方式定义的变量有什么样的bug?

-

Set数据结构

-

拓展:数组去重的方法

-

箭头函数this的指向。

-

手写ES6 class继承。

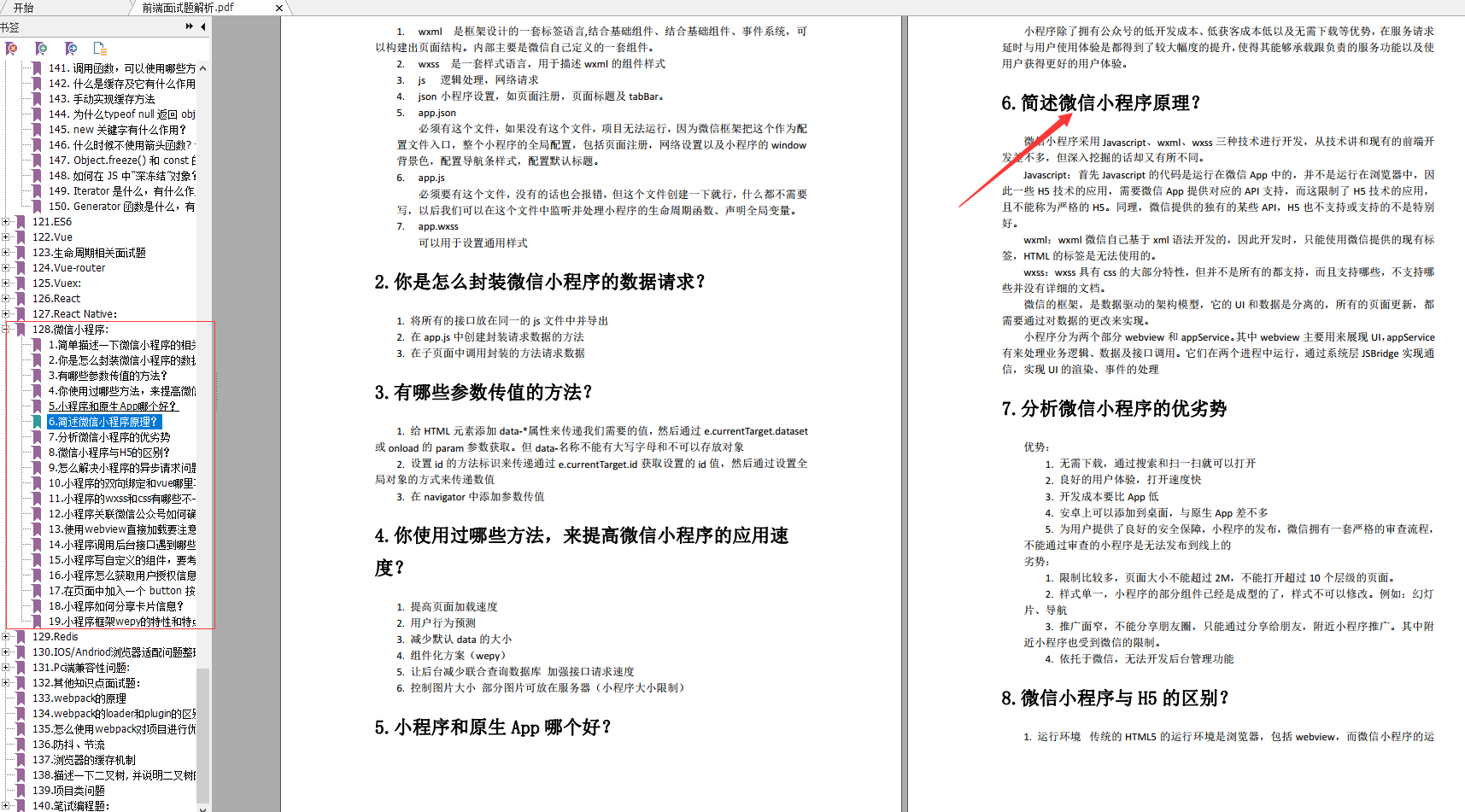

微信小程序

-

简单描述一下微信小程序的相关文件类型?

-

你是怎么封装微信小程序的数据请求?

-

有哪些参数传值的方法?

-

你使用过哪些方法,来提高微信小程序的应用速度?

-

小程序和原生App哪个好?

-

简述微信小程序原理?

-

分析微信小程序的优劣势

-

怎么解决小程序的异步请求问题?

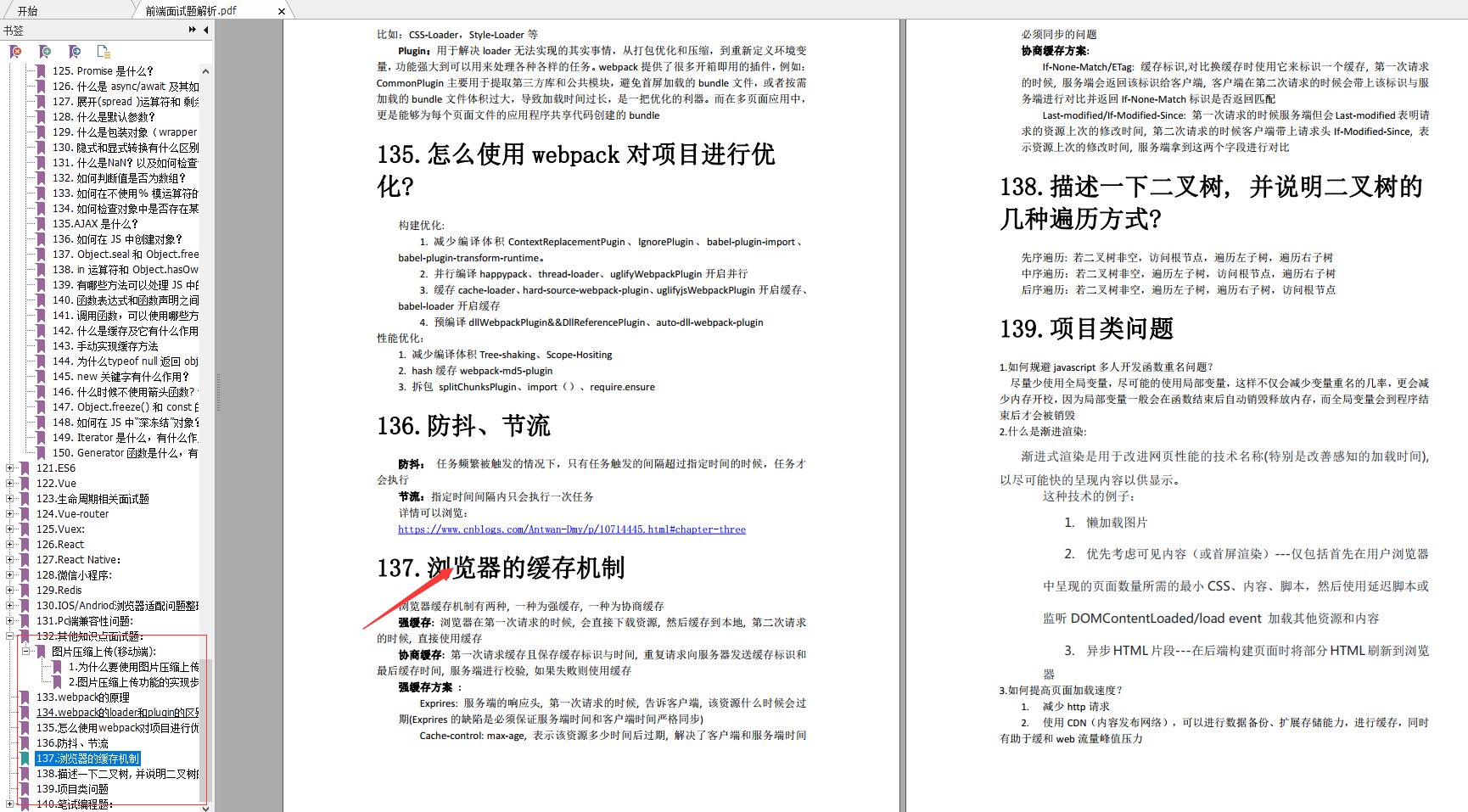

其他知识点面试

-

webpack的原理

-

webpack的loader和plugin的区别?

-

怎么使用webpack对项目进行优化?

-

防抖、节流

-

浏览器的缓存机制

-

描述一下二叉树, 并说明二叉树的几种遍历方式?

-

项目类问题

-

笔试编程题:

最后

技术栈比较搭,基本用过的东西都是一模一样的。快手终面喜欢问智力题,校招也是终面问智力题,大家要准备一下一些经典智力题。如果排列组合、概率论这些基础忘了,建议回去补一下。

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

需要这份系统化的资料的朋友,可以添加V获取:vip1024c (备注前端)

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

g.csdnimg.cn/img_convert/aec12fc95e5722b9f2f1f22eeb5e67bd.png)

最后

技术栈比较搭,基本用过的东西都是一模一样的。快手终面喜欢问智力题,校招也是终面问智力题,大家要准备一下一些经典智力题。如果排列组合、概率论这些基础忘了,建议回去补一下。

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

需要这份系统化的资料的朋友,可以添加V获取:vip1024c (备注前端)

[外链图片转存中…(img-EPPoZ9jb-1713218533212)]

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

9万+

9万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?