proxies = {

‘http’: ‘http://222.89.32.159:21079’,

‘https’: ‘http://222.89.32.159:21079’

}

headers = {

“User-Agent”: “Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/80.0.3987.163 Safari/537.36”

}

res = requests.get(url=urls,headers=headers,proxies=proxies)

我想了半天没想好到底哪些网站拒绝强,所以我就随便找一个网站来测试了,你可以再去尝试逛一下自己学校的教务管理系统,12360,facebook等…

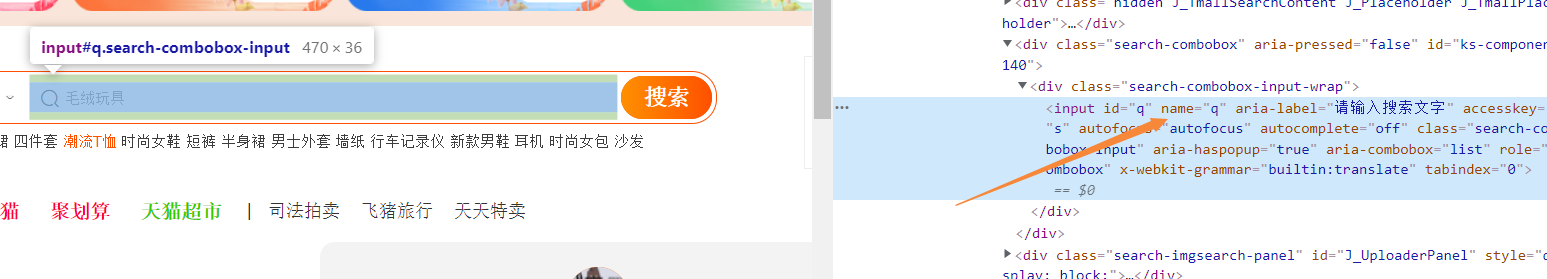

目标网址:

https://www.taobao.com/

所以定位就很容易:

driver.find_element_by_name(‘q’)

之前写过一次使用代理玩爬虫,是requests模块,但是作为个人,我越往后面学,发现selenium用得反而越来越多,requests被逐渐抛弃一般,所以这里补充一个selenium添加代理。

方式很简单:

ops.add_argument(‘–proxy-server=http://%s’ % a) #添加代理

注意这里的a格式为:ip:port

**注意:** 使用代理ip需要安装模块selenium-wire:

pip install selenium-wire

你应该是:

from seleniumwire import webdriver

而不是:

from selenium import webdriver

比如在X宝搜索:XX手机

完整代码:

from selenium import webdriver

from fake_useragent import UserAgent

from selenium.webdriver.chrome.options import Options

headers = {‘User-Agent’: UserAgent().random}

ops = Options()

driver = webdriver.Chrome(r’D:\360安全浏览器下载\chr

本文介绍了如何在Python的Selenium4中使用代理IP进行网页自动化操作,包括设置HTTP代理、安装selenium-wire库、处理cookies以及在淘宝、Facebook和Bing等网站上的应用实例。

本文介绍了如何在Python的Selenium4中使用代理IP进行网页自动化操作,包括设置HTTP代理、安装selenium-wire库、处理cookies以及在淘宝、Facebook和Bing等网站上的应用实例。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

3778

3778

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?