一、Python所有方向的学习路线

Python所有方向路线就是把Python常用的技术点做整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照上面的知识点去找对应的学习资源,保证自己学得较为全面。

二、学习软件

工欲善其事必先利其器。学习Python常用的开发软件都在这里了,给大家节省了很多时间。

三、入门学习视频

我们在看视频学习的时候,不能光动眼动脑不动手,比较科学的学习方法是在理解之后运用它们,这时候练手项目就很适合了。

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

举例:

输入的尺寸是227×227×3,卷积核大小是11×11,输出是6,输出维度是55×55,group为3

我们带入公式可以计算出

参数量:

1 1 2 × 3 3 × 6 3 × 3 11^2 \times \frac{3}{3} \times \frac{6}{3} \times 3 112×33×36×3=726

运算量:

[ ( 2 × 1 1 2 × 3 / 3 + 1 ) × 55 × 55 × 6 / 3 ] × 3 \left[\left(2 \times 11^{2} \times3 / 3 +1\right) \times 55 \times 55 \times 6 / 3\right] \times 3 [(2×112×3/3+1)×55×55×6/3]×3=2205225

深度可分离卷积(Depthwise separable conv)

============================================================================================

设输入特征维度为 D F × D F × M D_{F}\times D_{F}\times M DF×DF×M,M为通道数, D k D_{k} Dk为卷积核大小,M为输入的通道数, N为输出的通道数,G为分组数。

当分组数量等于输入map数量,输出map数量也等于输入map数量,即M=N=G,N个卷积核每个尺寸为$D_{k}\times D_{k}\times 1 $时,Group Convolution就成了Depthwise Convolution。

逐点卷积就是把G组卷积用conv1x1拼接起来。如下图:

深度可分离卷积有深度卷积+逐点卷积。计算如下:

-

深度卷积:设输入特征维度为 D F × D F × M D_{F}\times D_{F}\times M DF×DF×M,M为通道数。卷积核的参数为 D k × D k × 1 × M D_{k}\times D_{k}\times 1 \times M Dk×Dk×1×M。输出深度卷积后的特征维度为: D F × D F × M D_{F}\times D_{F}\times M DF×DF×M。卷积时每个通道只对应一个卷积核(扫描深度为1),所以 FLOPs为: M × D F × D F × D K × D K M\times D_{F}\times D_{F}\times D_{K}\times D_{K} M×DF×DF×DK×DK

-

逐点卷积:输入为深度卷积后的特征,维度为 D F × D F × M D_{F}\times D_{F}\times M DF×DF×M。卷积核参数为 1 × 1 × M × N 1\times1\times M\times N 1×1×M×N。输出维度为 D F × D F × N D_{F}\times D_{F}\times N DF×DF×N。卷积过程中对每个特征做 1 × 1 1 \times 1 1×1的标准卷积, FLOPs为: N × D F × D F × M N \times D_{F} \times D_{F}\times M N×DF×DF×M

将上面两个参数量相加就是 D k × D k × M + M × N D_{k} \times D_{k} \times M+M \times N Dk×Dk×M+M×N

所以深度可分离卷积参数量是标准卷积的 D K × D K × M + M × N D K × D K × M × N = 1 N + 1 D K 2 \frac{D_{K} \times D_{K} \times M+M \times N}{D_{K} \times D_{K} \times M \times N}=\frac{1}{N}+\frac{1}{D_{K}^{2}} DK×DK×M×NDK×DK×M+M×N=N1+DK21

======================================================================

详见论文翻译:

https://blog.csdn.net/hhhhhhhhhhwwwwwwwwww/article/details/122692846

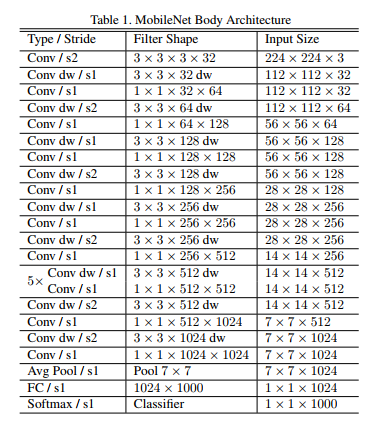

mobileNetV1的网络结构如下图.前面的卷积层中除了第一层为标准卷积层外,其他都是深度可分离卷积(Conv dw + Conv/s1),卷积后接了一个7*7的平均池化层,之后通过全连接层,最后利用Softmax激活函数将全连接层输出归一化到0-1的一个概率值,根据概率值的高低可以得到图像的分类情况。

import torch

import torch.nn as nn

import torchvision

def BottleneckV1(in_channels, out_channels, stride):

return nn.Sequential(

nn.Conv2d(in_channels=in_channels,out_channels=in_channels,kernel_size=3,stride=stride,padding=1,groups=in_channels),

nn.BatchNorm2d(in_channels),

nn.ReLU6(inplace=True),

nn.Conv2d(in_channels=in_channels, out_channels=out_channels, kernel_size=1, stride=1),

nn.BatchNorm2d(out_channels),

nn.ReLU6(inplace=True)

)

class MobileNetV1(nn.Module):

def init(self, num_classes=1000):

super(MobileNetV1, self).init()

self.first_conv = nn.Sequential(

nn.Conv2d(in_channels=3,out_channels=32,kernel_size=3,stride=2,padding=1),

nn.BatchNorm2d(32),

nn.ReLU6(inplace=True),

)

self.bottleneck = nn.Sequential(

BottleneckV1(32, 64, stride=1),

BottleneckV1(64, 128, stride=2),

BottleneckV1(128, 128, stride=1),

BottleneckV1(128, 256, stride=2),

BottleneckV1(256, 256, stride=1),

BottleneckV1(256, 512, stride=2),

BottleneckV1(512, 512, stride=1),

BottleneckV1(512, 512, stride=1),

BottleneckV1(512, 512, stride=1),

BottleneckV1(512, 512, stride=1),

BottleneckV1(512, 512, stride=1),

BottleneckV1(512, 1024, stride=2),

BottleneckV1(1024, 1024, stride=1),

)

self.avg_pool = nn.AvgPool2d(kernel_size=7,stride=1)

self.linear = nn.Linear(in_features=1024,out_features=num_classes)

self.dropout = nn.Dropout(p=0.2)

self.softmax = nn.Softmax(dim=1)

self.init_params()

def init_params(self):

for m in self.modules():

if isinstance(m, nn.Conv2d):

nn.init.kaiming_normal_(m.weight)

nn.init.constant_(m.bias,0)

elif isinstance(m, nn.Linear) or isinstance(m, nn.BatchNorm2d):

nn.init.constant_(m.weight, 1)

nn.init.constant_(m.bias, 0)

def forward(self, x):

x = self.first_conv(x)

x = self.bottleneck(x)

x = self.avg_pool(x)

x = x.view(x.size(0),-1)

x = self.dropout(x)

x = self.linear(x)

out = self.softmax(x)

return out

if name==‘main’:

model = MobileNetV1()

print(model)

input = torch.randn(1, 3, 224, 224)

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

3411

3411

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?