一、Python所有方向的学习路线

Python所有方向路线就是把Python常用的技术点做整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照上面的知识点去找对应的学习资源,保证自己学得较为全面。

二、学习软件

工欲善其事必先利其器。学习Python常用的开发软件都在这里了,给大家节省了很多时间。

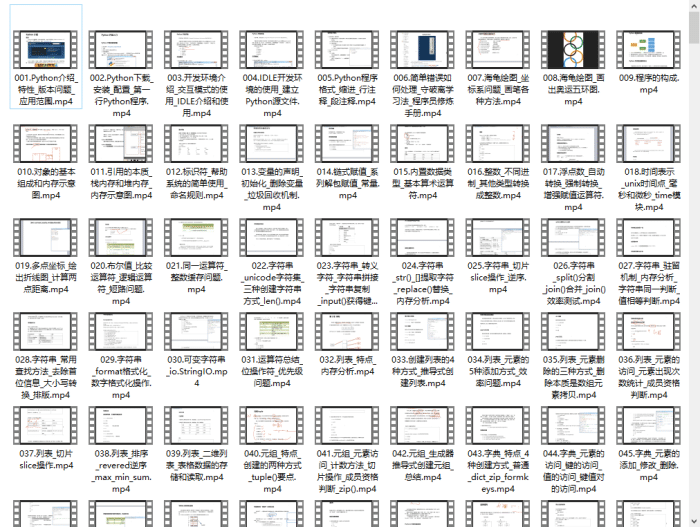

三、入门学习视频

我们在看视频学习的时候,不能光动眼动脑不动手,比较科学的学习方法是在理解之后运用它们,这时候练手项目就很适合了。

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

class RNN(Layer):

“”"A Vanilla Fully-Connected Recurrent Neural Network layer.

Parameters:

n_units: int

The number of hidden states in the layer.

activation: string

The name of the activation function which will be applied to the output of each state.

bptt_trunc: int

Decides how many time steps the gradient should be propagated backwards through states

given the loss gradient for time step t.

input_shape: tuple

The expected input shape of the layer. For dense layers a single digit specifying

the number of features of the input. Must be specified if it is the first layer in

the network.

Reference:

http://www.wildml.com/2015/09/recurrent-neural-networks-tutorial-part-2-implementing-a-language-model-rnn-with-python-numpy-and-theano/

“”"

def init(self, n_units, activation=‘tanh’, bptt_trunc=5, input_shape=None):

self.input_shape = input_shape

self.n_units = n_units

self.activation = activation_functionsactivation

self.trainable = True

self.bptt_trunc = bptt_trunc

self.W = None # Weight of the previous state

self.V = None # Weight of the output

self.U = None # Weight of the input

def initialize(self, optimizer):

timesteps, input_dim = self.input_shape

Initialize the weights

limit = 1 / math.sqrt(input_dim)

self.U = np.random.uniform(-limit, limit, (self.n_units, input_dim))

limit = 1 / math.sqrt(self.n_units)

self.V = np.random.uniform(-limit, limit, (input_dim, self.n_units))

self.W = np.random.uniform(-limit, limit, (self.n_units, self.n_units))

Weight optimizers

self.U_opt = copy.copy(optimizer)

self.V_opt = copy.copy(optimizer)

self.W_opt = copy.copy(optimizer)

def parameters(self):

return np.prod(self.W.shape) + np.prod(self.U.shape) + np.prod(self.V.shape)

def forward_pass(self, X, training=True):

self.layer_input = X

batch_size, timesteps, input_dim = X.shape

Save these values for use in backprop.

self.state_input = np.zeros((batch_size, timesteps, self.n_units))

self.states = np.zeros((batch_size, timesteps+1, self.n_units))

self.outputs = np.zeros((batch_size, timesteps, input_dim))

Set last time step to zero for calculation of the state_input at time step zero

self.states[:, -1] = np.zeros((batch_size, self.n_units))

for t in range(timesteps):

Input to state_t is the current input and output of previous states

self.state_input[:, t] = X[:, t].dot(self.U.T) + self.states[:, t-1].dot(self.W.T)

self.states[:, t] = self.activation(self.state_input[:, t])

self.outputs[:, t] = self.states[:, t].dot(self.V.T)

return self.outputs

def backward_pass(self, accum_grad):

_, timesteps, _ = accum_grad.shape

Variables where we save the accumulated gradient w.r.t each parameter

grad_U = np.zeros_like(self.U)

如果你也是看准了Python,想自学Python,在这里为大家准备了丰厚的免费学习大礼包,带大家一起学习,给大家剖析Python兼职、就业行情前景的这些事儿。

一、Python所有方向的学习路线

Python所有方向路线就是把Python常用的技术点做整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照上面的知识点去找对应的学习资源,保证自己学得较为全面。

二、学习软件

工欲善其必先利其器。学习Python常用的开发软件都在这里了,给大家节省了很多时间。

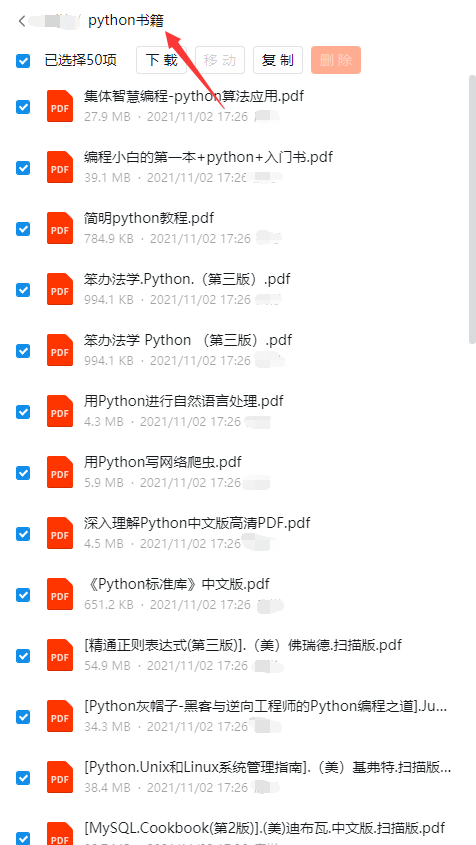

三、全套PDF电子书

书籍的好处就在于权威和体系健全,刚开始学习的时候你可以只看视频或者听某个人讲课,但等你学完之后,你觉得你掌握了,这时候建议还是得去看一下书籍,看权威技术书籍也是每个程序员必经之路。

四、入门学习视频

我们在看视频学习的时候,不能光动眼动脑不动手,比较科学的学习方法是在理解之后运用它们,这时候练手项目就很适合了。

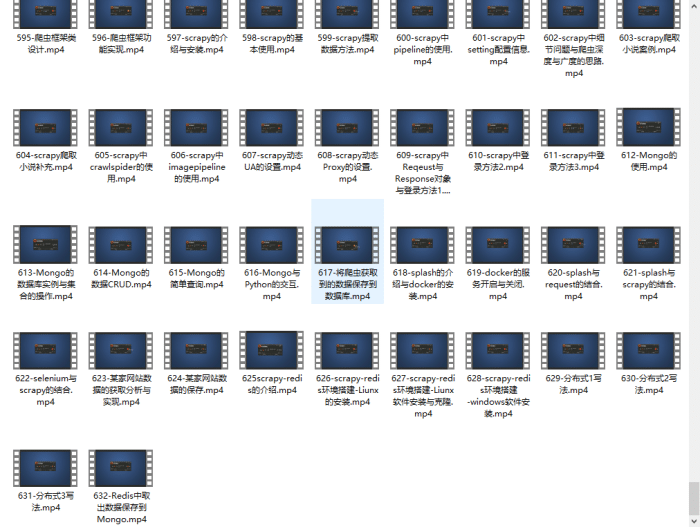

四、实战案例

光学理论是没用的,要学会跟着一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

五、面试资料

我们学习Python必然是为了找到高薪的工作,下面这些面试题是来自阿里、腾讯、字节等一线互联网大厂最新的面试资料,并且有阿里大佬给出了权威的解答,刷完这一套面试资料相信大家都能找到满意的工作。

成为一个Python程序员专家或许需要花费数年时间,但是打下坚实的基础只要几周就可以,如果你按照我提供的学习路线以及资料有意识地去实践,你就有很大可能成功!

最后祝你好运!!!

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

1335

1335

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?