文末有福利领取哦~

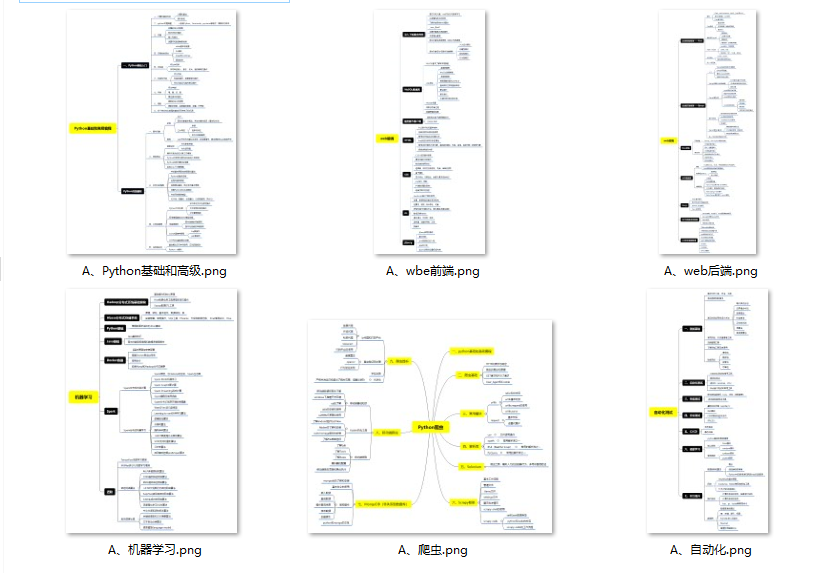

👉一、Python所有方向的学习路线

Python所有方向的技术点做的整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照上面的知识点去找对应的学习资源,保证自己学得较为全面。

👉二、Python必备开发工具

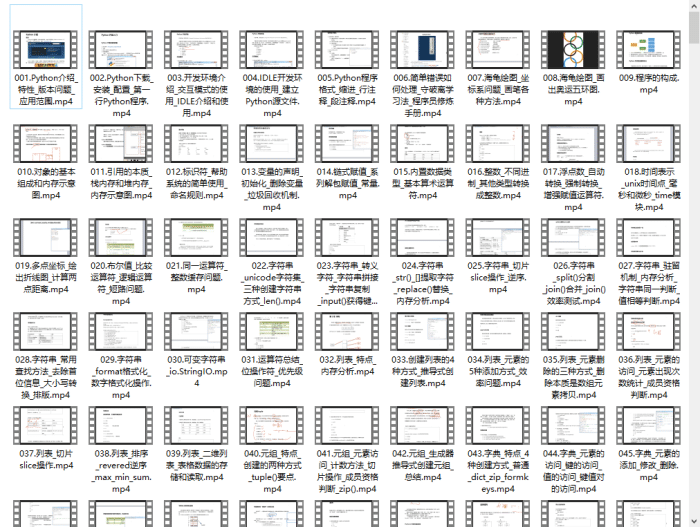

👉三、Python视频合集

观看零基础学习视频,看视频学习是最快捷也是最有效果的方式,跟着视频中老师的思路,从基础到深入,还是很容易入门的。

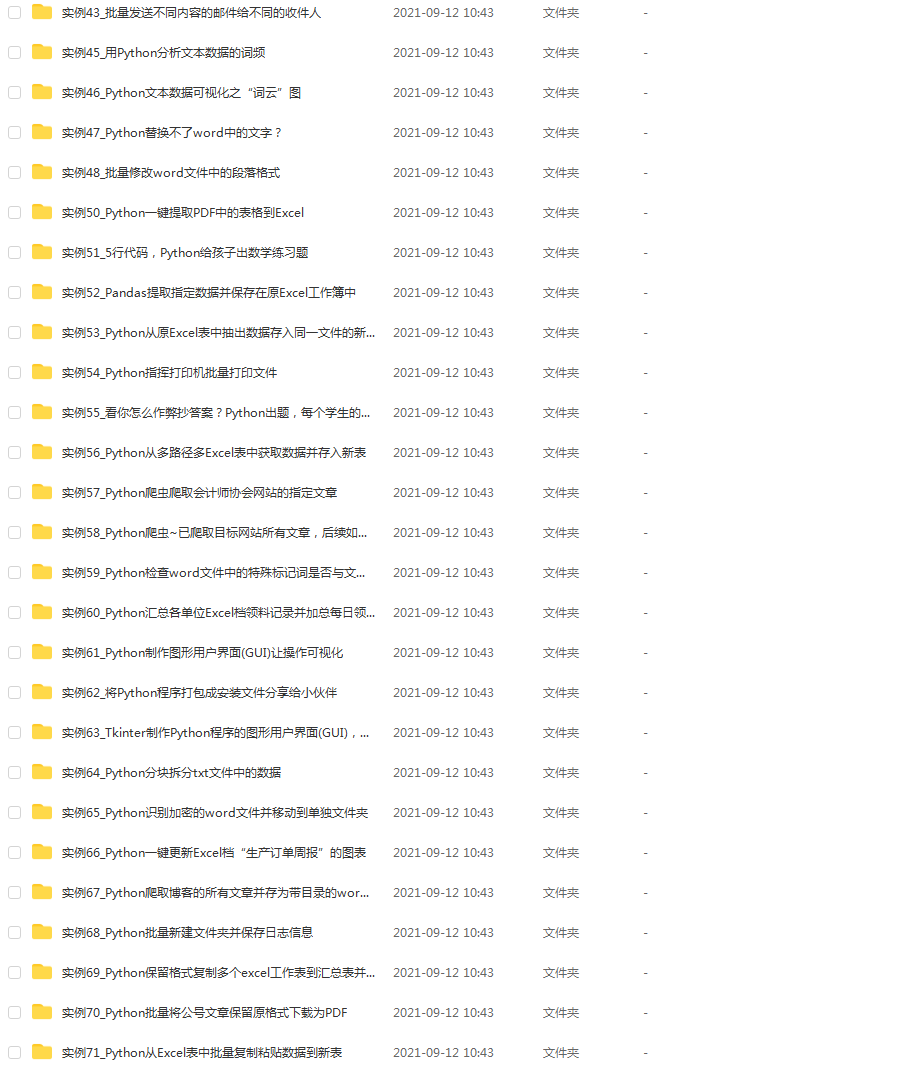

👉 四、实战案例

光学理论是没用的,要学会跟着一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。(文末领读者福利)

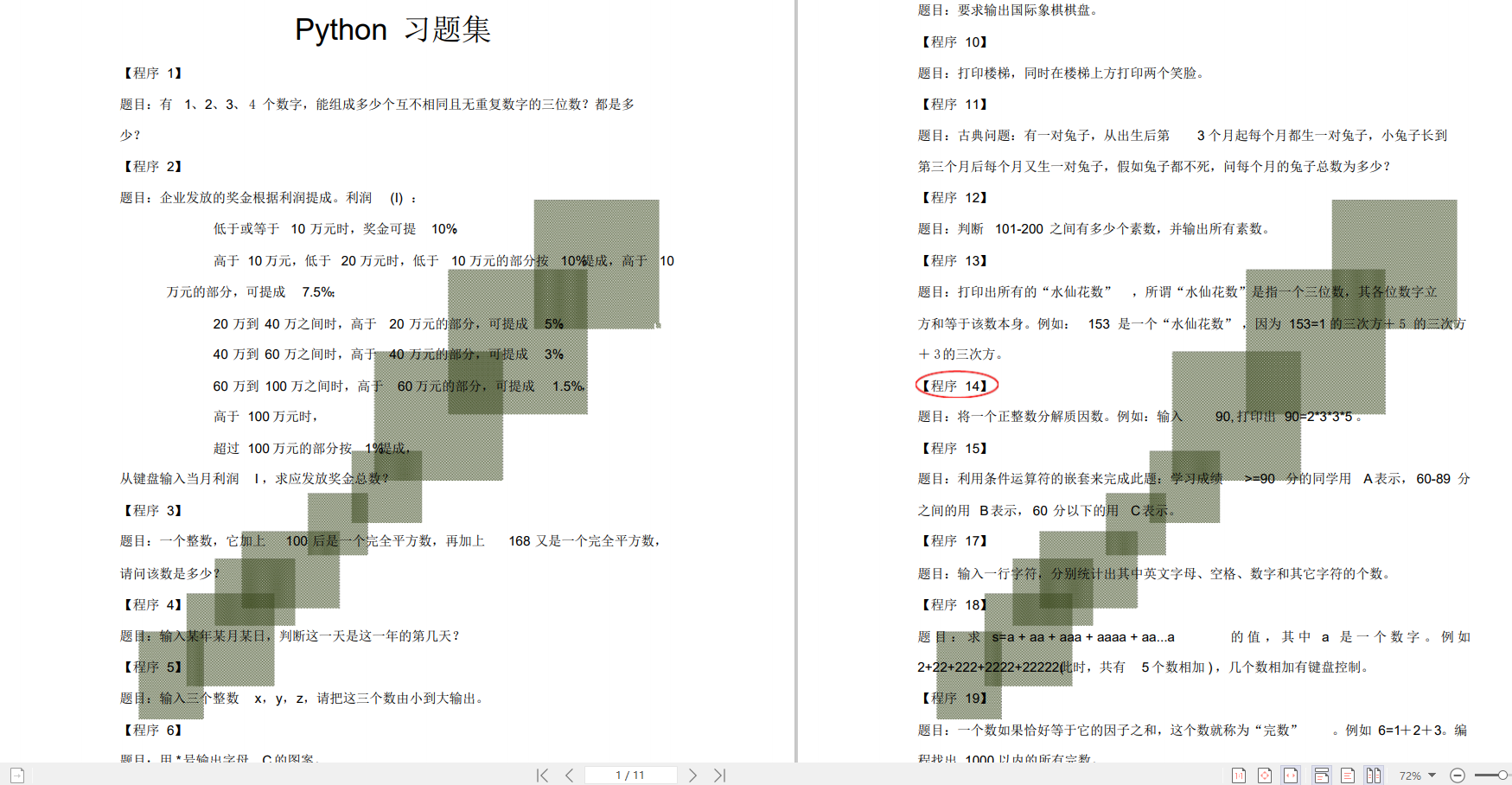

👉五、Python练习题

检查学习结果。

👉六、面试资料

我们学习Python必然是为了找到高薪的工作,下面这些面试题是来自阿里、腾讯、字节等一线互联网大厂最新的面试资料,并且有阿里大佬给出了权威的解答,刷完这一套面试资料相信大家都能找到满意的工作。

👉因篇幅有限,仅展示部分资料,这份完整版的Python全套学习资料已经上传

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

常见自动化程序方案

所谓的自动化程序,就是用机器大批量地发起请求,拿到响应后再做处理。专业术语叫做

网页爬虫或者网页机器人。

模拟请求(基于代码或爬虫框架)

此方案需要我们至少熟悉一门编程语言(Python、Node.js、Java等),自行编写代码或者借助优秀的开源爬虫框架,实现数据获取。某些场景,还需要通过抓包分析目标网站的参数规则,然后通过组合式请求方能达到目的。

这里罗列下我用过或收藏且还在不断更新维护的框架:

| 名称 | 开发语言 | 简介 |

|---|---|---|

| Scrapy | Python | A fast high-level web crawling & scraping framework for Python. |

| Pyspider | Python | A Powerful Spider(Web Crawler) System in Python. |

| Nutch | Java | 一种高度可扩展、可伸缩的开源 Web 爬虫软件项目。功能强大,支持 Hadoop 集群内运行 |

| webmagic | Java | 一个简单灵活的Java爬虫框架。基于WebMagic,你可以快速开发出一个高效、易维护的爬虫。真的非常简单😄 |

| Spiderman2 | Java | 开源Web数据抽取工具,我没实际使用过 |

| node-crawler | Node.js | Web Crawler/Spider for NodeJS + server-side jQuery 😉 |

开发者工具 F12 🛠️

首先访问目标网站,按需进行登录,然后按下键盘 F12(或者 Ctrl+Shift+I)进入开发者工具,可以在控制台中写或贴入 JS 脚本,回车收尾😎。

这是我常用的一种方式,用户验证脚本跟少规模作业。

自动化测试工具(Selenium/Puppeteer/Playwright)

WEB 自动化测试工具,是指通过程序代替人工完成验证 WEB 功能的过程。当然,也能利用它来抓取数据。这类工具通过驱动程序(webdriver、DevTools Protocol),驱使浏览器执行既定的动作/脚本。

- Selenium:老牌大哥,我最开始接触的自动化测试工具,支持 Chrome、Edge、Firefox、IE、Safari 等浏览器,对开发语言支持也很广:Java、Python、C#、Ruby、JavaScript

- Puppeteer: Chrome 开发团队在 2017 年发布的一个 Node.js 包,用来模拟 Chrome 浏览器的运行。主打对 Chrome 的良好支持,社区有针对 Java、Python 版本。

- Playwright:微软大厂出品,浏览器支持 Chrome、Edge、Firefox、Safari,官方提供 Java、Python、Node.js、C# 编程语言的 SDK。

Electron / Traui

这两个软件跟上一节工具基本一致,之所以单独列出来,是因为它们提供了更丰富的接口,既能控制浏览器完成任务,又可以制作 GUI 界面(可用于与爬虫程序交互)。

2019年那会,我用闲余时间基于 Electron 做了个小玩具:

浏览器扩展(插件)

官方应该叫做浏览器扩展(Extensions),但是我们习惯叫做插件😄,后续文章我将重点以此方式进行实践。

浏览器扩展(插件)是运行在特定浏览器,遵循相关规范的应用程序包,由 JS、CSS、HTML 组成,能够管理标签页、注入代码、操作DOM、监控页面活动等。

插件功能非常强大,具体的文档详见Chrome Extensions Document。不过有一个小遗憾是不能在插件内打开标签页的开发者工具,官方给出的回答是出于安全考虑。

有大佬做的强大插件webscraper插件(本地使用免费)👍。

小结

我们在做数据采集时,可以根据实际情况灵活选择方案。不过,无论是何种方式,都要随着目标网站的更新迭代,做相应的适配,否则会出现程序无效的情况,而这是一个耗时耗力的过程🙂。

另外,部分网站会对自动化测试工具进行检测,可以参考:bot.sannysoft.com/,正常浏览器会看到如下的结果图。

拦路虎🧱

拦路虎之 IP 限制

当 ip 被限制,就无法正常访问网站或服务。我们的请求很可能被防火墙、网关、WAF(Web 应用防护系统)等前置设备、应用拦截,压根没有到藏在后面的网站。常用应对方式是更换终端IP,比如用代理。

拦路虎之验证码

验证码就是用来拦截爬虫程序的,常见有字符图片验证码(数字+字母+中文,再来点干扰线跟字符变形,增加识别成本),也会有逻辑交互类,以及手机/邮箱接收验证码。

现代验证码越来越先进(下图是网易网盾首页列出来的常见类型),即使对正常用户也是很艰难才能完成验证。

这里不得不提一下谷歌「我不是机器人」的验证:reCAPTCHA ,没少被它蹂躏🤣。但是关于 reCAPTCHA 又有一个让我觉得非常惊艳的故事,是关于如何把人类纸质书数字化的,当时靠人工、机器字符识别的效率、效果都不行,于是该公司(后来被谷歌收购)想到把书籍扫描件分割为无数个小图,显示为验证码,让用户进行识别,然后得到最多的结果作为纸质书内容的数字字符(会有算法的参与),具体的看这篇文章:你以为自己在填验证码,其实你是在给Google义务劳动。

这真是太酷了!全人类共同参与到知识数字化进程中来,是在为人类文明做贡献,想想就很激动👏。

聊完常见验证码,是不是要开始说下怎么怎么自动识别它们?

对于文字型可以用OCR,简单交互类的可以用脚本模拟人工拖拽动作,逻辑类的话就难很多,需要对症下药。当然也可以花钱调商用接口,我用过的有超级鹰。

拦路虎之行为检测

最后

🍅 硬核资料:关注即可领取PPT模板、简历模板、行业经典书籍PDF。

🍅 技术互助:技术群大佬指点迷津,你的问题可能不是问题,求资源在群里喊一声。

🍅 面试题库:由技术群里的小伙伴们共同投稿,热乎的大厂面试真题,持续更新中。

🍅 知识体系:含编程语言、算法、大数据生态圈组件(Mysql、Hive、Spark、Flink)、数据仓库、Python、前端等等。

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

2748

2748

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?