前言:嗨大家好!今天我要和大家分享一个超实用的教程——在本地服务器上无需高昂价格的GPU也能运行离线AI项目的开源神器:LocalAI,并结合cpolar内网穿透工具实现轻松远程使用的详细步骤。

随着AI大模型的发展,各大厂商纷纷推出了自己的线上AI服务。从写文章到生成图片或视频,这些服务确实给我们的生活和工作带来了便利。然而,使用这些在线AI软件时,数据需要传输到商家的服务器上,这让不少用户产生了担忧:我的数据会泄露吗?隐私保护情况如何?

为了应对这些问题,今天给大家推荐一款很不错的AI项目:LocalAI!这款开源工具可以在本地直接运行大语言模型(LLM)、生成图像和音频等。最棒的是,你不需要高端昂贵的GPU,消费级硬件通过CPU就能轻松完成推理任务,真正降低了AI使用的门槛。

在本文中,我将详细介绍如何使用Docker快速部署LocalAI,并结合cpolar内网穿透工具实现远程访问。无论你是技术新手还是有经验的老手,都能从中学到实用的知识和技巧!

目录

1. Docker部署

本例使用Ubuntu 22.04进行演示,使用Docker进行部署,如果没有安装Docker,可以查看这篇教程进行安装:[《Docker安装教程——Linux、Windows、MacOS》](https://www.cpolar.com/blog/docker-installation-linux-windows-macos)

安装好Docker后,打开终端执行这行命令启动容器即可:

```shell

sudo docker run -ti --name local-ai -p 8080:8080 localai/localai:latest-cpu

```这里使用的镜像是仅使用CPU来运行的镜像,如果大家有Nvidia显卡的好GPU,也可以使用下方命令拉取支持N卡的镜像来运行容器:

```shell

sudo docker run -ti --name local-ai -p 8080:8080 --gpus all localai/localai:latest-gpu-nvidia-cuda-12

```更多项目配置与使用详情大家也可以访问作者的github主页进行查看:https://github.com/mudler/LocalAI

2. 简单使用演示

容器启动后,我们在Ubuntu中使用浏览器访问 http://localhost:8080 即可打开LocalAI的Web UI页面:

能看到页面中央提示我们现在还没有添加大模型,我们可以点击Gallery,在跳转页面选择一个大模型:

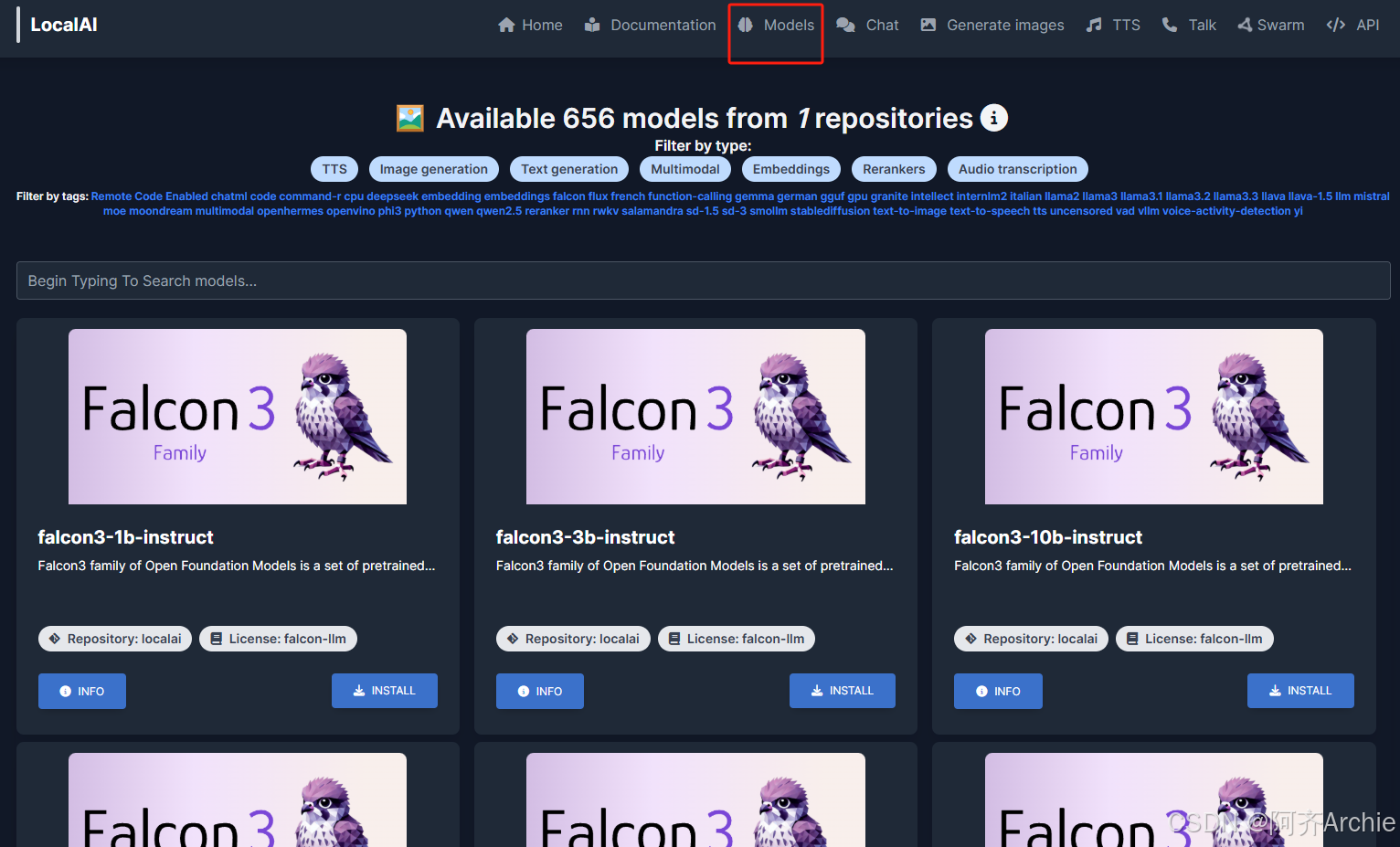

可以看到在这个界面中有600多个大模型,并且可以根据用途标签(文字转语音、图片生成、文章生成等等)进行筛选或者在下方输入框搜索指定的模型:

我这里以添加llama-3.2-1b模型来进行演示:点击install按钮安装等待完成即可

安装完成后,点击页面上方导航条中的HOME回到主页即可发现刚刚添加的llama-3.2模型:

想要使用这个AI大模型,点击上方导航中的chat即可与它聊天了:

点击右侧的模型选择,下拉框中会显示你已经安装的大模型:

目前我只安装了这一个,如果想继续安装其他大模型,可以点击页面上方导航栏中的Models进行选择:(跳转的就是首次挑选模型安装的那个页面)

3. 安装cpolar内网穿透

不过我们目前只能在本地局域网内访问刚刚部署的LocalAI来使用AI大模型聊天,如果想不在同一局域网内时,也能在外部网络环境使用手机、平板、电脑等设备远程访问与使用它,应该怎么办呢?我们可以使用cpolar内网穿透工具来实现远程访问的需求。无需公网IP,也不用设置路由器那么麻烦。

下面是安装cpolar步骤:

> *Cpolar官网地址:* [https://www.cpolar.com](https://www.cpolar.com/)

使用一键脚本安装命令:

```shell

sudo curl https://get.cpolar.sh | sh

```

安装完成后,执行下方命令查看cpolar服务状态:(如图所示即为正常启动)

```shell

sudo systemctl status cpolar

```

Cpolar安装和成功启动服务后,在浏览器上输入ubuntu主机IP加9200端口即:【[http://localhost:9200](http://localhost:9200/)】访问Cpolar管理界面,使用Cpolar官网注册的账号登录,登录后即可看到cpolar web 配置界面,接下来在web 界面配置即可:

4. 配置公网地址

登录cpolar web UI管理界面后,点击左侧仪表盘的隧道管理——创建隧道:

- 隧道名称:可自定义,本例使用了: localai ,注意不要与已有的隧道名称重复

- 协议:http

- 本地地址:8080

- 域名类型:随机域名

- 地区:选择China Top

点击创建:

创建成功后,打开左侧在线隧道列表,可以看到刚刚通过创建隧道生成了两个公网地址,接下来就可以在其他电脑或者移动端设备(异地)上,使用任意一个地址在浏览器中访问即可。

如图所示,现在就已经成功实现使用公网地址异地远程访问本地部署的LocalAI来用AI大模型聊天啦!

**小结**

为了方便演示,我们在上边的操作过程中使用cpolar生成的HTTP公网地址隧道,其公网地址是随机生成的。这种随机地址的优势在于建立速度快,可以立即使用。然而,它的缺点是网址是随机生成,这个地址在24小时内会发生随机变化,更适合于临时使用。

如果有长期使用LocalAI,或者异地访问与使用其他本地部署的服务的需求,但又不想每天重新配置公网地址,还想让公网地址好看又好记并体验更多功能与更快的带宽,那我推荐大家选择使用固定的二级子域名方式来配置公网地址。

5. 配置固定公网地址

由于以上使用cpolar所创建的隧道使用的是随机公网地址,24小时内会随机变化,不利于长期远程访问。因此我们可以为其配置二级子域名,该地址为固定地址,不会随机变化。

点击左侧的预留,选择保留二级子域名,地区选择china top,然后设置一个二级子域名名称,我这里演示使用的是`mylocal`,大家可以自定义。填写备注信息,点击保留。

保留成功后复制保留的二级子域名地址:

登录cpolar web UI管理界面,点击左侧仪表盘的隧道管理——隧道列表,找到所要配置的隧道`localai`,点击右侧的`编辑`。

修改隧道信息,将保留成功的二级子域名配置到隧道中

- 域名类型:选择二级子域名

- Sub Domain:填写保留成功的二级子域名

- 地区: China Top

点击`更新`

更新完成后,打开在线隧道列表,此时可以看到随机的公网地址已经发生变化,地址名称也变成了保留和固定的二级子域名名称。

最后,我们使用固定的公网地址在任意设备的浏览器中访问,可以看到成功访问本地部署的LocalAI Web UI页面,这样一个永久不会变化的二级子域名公网网址即设置好了。

通过本地服务器上的LocalAI和cpolar的组合,你可以在不依赖昂贵硬件的情况下轻松运行离线AI项目,并且随时随地进行远程访问。希望这篇文章能帮助你在日常工作中更好地利用AI技术。如果你有任何问题或建议,欢迎随时留言交流!

1666

1666

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?