目录

CrawlSpider

简介

CrawlSpider 是 Scrapy 框架提供的一个特殊的 Spider 类型,在Scrapy中Spider是所有爬虫的基类,而CrawSpiders就是Spider的派生类,用于处理那些需要遵循特定规则和链接提取的网站。它是基于广度优先算法构建的,可以自动发现并跟踪网页上的链接,并根据预定义的规则提取数据。

CrawlSpider 提供了一种更高级的方法来定义爬取规则,而无需编写大量的重复代码。它基于规则系统工作,其中每个规则由一个或多个链接提取器(LinkExtractor)和一个回调函数(callback)组成。规则定义了要提取的链接和如何处理这些链接的方法。

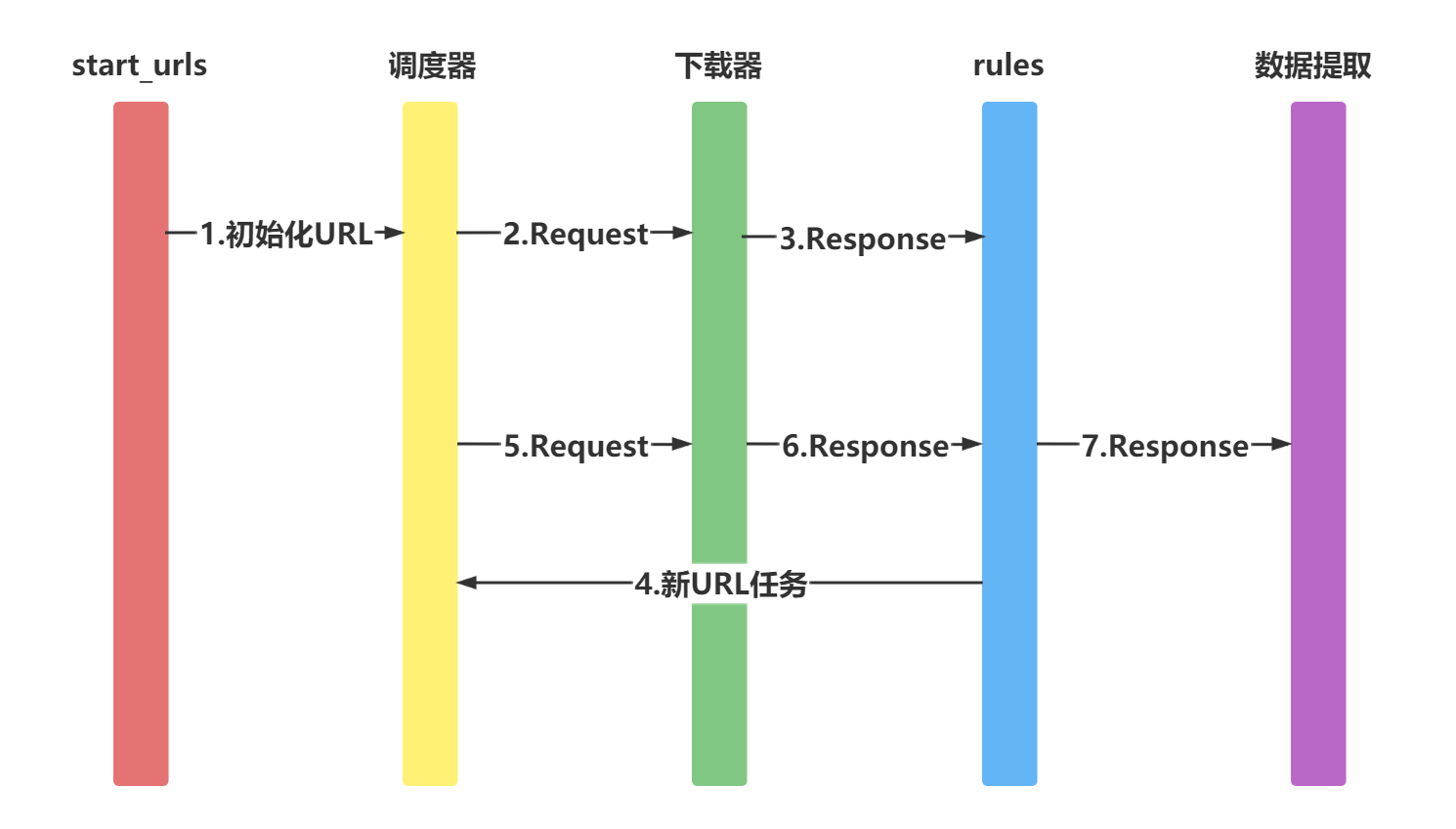

基本运行

适用于先爬取start_url列表中的网页,再从爬取的网页中获取link并继续爬取的工作。

特性和概念

-

链接提取器(LinkExtractor):链接提取器用于从网页中提取链接。CrawlSpider 提供了几种内置的链接提取器,如基于正则表达式、基于 CSS 选择器、基于 XPath 等,你可以根据需求选择合适的链接提取器。

-

规则(Rule):规则定义了要提取的链接和如何处理这些链接的方法。每个规则由一个链接提取器和一个回调函数组成。链接提取器用于提取链接,回调函数定义了如何处理这些链接。可以定义多个规则来处理不同类型的链接。

-

回调函数(callback):回调函数是指定规则要调用的方法。当链接提取器提取到链接时,将会调用相应的回调函数来处理提取到的

链接。在回调函数中,你可以编写解析页面和提取数据的逻辑。

-

follow 参数:在规则中,可以设置 follow 参数来决定是否继续跟踪从链接提取器提取的链接。如果设置为 True,则会继续跟踪这些链接并提取数据;如果设置为 False,则不会跟踪这些链接。

-

allowed_domains 参数:allowed_domains 参数用于限制爬取的域名。只有在 allowed_domains 列表中的域名下的链接才会被跟踪和提取数据,其他域名下的链接将被忽略。

基本使用

在 Scrapy 框架中,创建 CrawlSpider 时通常是通过继承 scrapy.spiders.CrawlSpider 类来实现的,因为 CrawlSpider 类提供了许多内置的功能和方法来处理链接提取和规则定义。

创建CrawlSpider

要使用 CrawlSpider,首先需要创建一个 Scrapy 项目。可以使用以下命令来创建一个新的 Scrapy 项目

scrapy startproject project_name

进入项目目录

cd project_name

在项目中创建一个新的 Spider

scrapy genspider spider_name spider_domain

注:spider_name是你给 Spider 命名的标识符,spider_domain是要爬取的网站的域名。

在生成的 Spider 文件中,将基类指定为 CrawlSpider,定义一个名为 MySpider 的 Spider 类,它继承自 CrawlSpider。我们指定了要爬取的网站域名和起始链接。rules 属性定义了我们要遵循的链接提取规则和回调函数。在这个示例中,我们使用了一个空的 LinkExtractor,表示提取所有链接,然后将其传递给 parse_item 方法进行解析。

from scrapy.spiders import CrawlSpider, Rule

from scrapy.linkextractors import LinkExtractor

class MySpider(CrawlSpider):

name = 'myspider'

allowed_domains = ['example.com']

start_urls = ['http://www.example.com']

rules = (

Rule(LinkExtractor(allow=()), callback='parse_item', follow=True),

)

def parse_item(self, response):

# 在这里定义解析页面的逻辑

# 可以从 response 中提取数据

# 返回解析后的数据

yield {

'url': response.url,

'title': response.css('title::text').get()

}

运行

scrapy crawl myspider

使用CrawlSpider中核心的2个类对象

Rule对象

Rule类与CrawlSpider类都位于scrapy.contrib.spiders模块中

class scrapy.contrib.spiders.Rule(

link_extractor,

callback=None,

cb_kwargs=None,

follow=None,

process_links=None,

process_request=None)

参数含义:

-

link_extractor为LinkExtractor,用于定义需要提取的链接

-

callback参数:当link_extractor获取到链接时参数所指定的值作为回调函数

注意 回调函数尽量不要用parse方法,crawlspider已使用了parse方法

-

follow:指定了根据该规则从response提取的链接是否需要跟进。当callback为None,默认值为True

-

process_links:主要用来过滤由link_extractor获取到的链接

-

process_request:主要用来过滤在rule中提取到的request

LinkExtractors

链接提取器

作用

response对象中获取链接,并且该链接会被接下来爬取 每个LinkExtractor有唯一的公共方法是 extract_links(),它接收一个 Response 对象,并返回一个 scrapy.link.Link 对象

使用

class scrapy.linkextractors.LinkExtractor(

allow = (),

deny = (),

allow_domains = (),

deny_domains = (),

deny_extensions = None,

restrict_xpaths = (),

tags = ('a','area'),

attrs = ('href'),

canonicalize = True,

unique = True,

process_value = None

)

主要参数:

- allow:满足括号中“正则表达式”的值会被提取,如果为空,则全部匹配。

- deny:与这个正则表达式(或正则表达式列表)不匹配的URL一定不提取。

- allow_domains:会被提取的链接的domains。

- deny_domains:一定不会被提取链接的domains。

- restrict_xpaths:使用xpath表达式,和allow共同作用过滤链接(只选到节点,不选到属性)

- restrict_css:使用css表达式,和allow共同作用过滤链接(只选到节点,不选到属性)

查看效果-shell中验证

首先运行

scrapy shell 'https://www.zhhbqg.com/1_1852/835564.html'

继续import相关模块

from scrapy.linkextractors import LinkExtractor

提取当前网页中获得的链接

link = LinkExtractor(restrict_xpaths=(r'//a'))调用LinkExtractor实例的extract_links()方法查询匹配结果

link.extract_links(response)

示例

(爬取小说网数据)

from scrapy.linkextractors import LinkExtractor

from scrapy.spiders import CrawlSpider, Rule

from xiaoshuo.items import XiaoshuoItem

class XiaoshuoSpiderSpider(CrawlSpider):

name = 'xiaoshuo_spider'

allowed_domains = ['fhxiaoshuo.com']

start_urls = ['http://www.fhxiaoshuo.com/read/33/33539/17829387.shtml']

rules = [

Rule(LinkExtractor(restrict_xpaths=(r'//div[@class="bottem"]/a[4]')), callback='parse_item'),]

def parse_item(self, response):

info = response.xpath("//div[@id='TXT']/text()").extract()

it = XiaoshuoItem()

it['info'] = info

yield it

注意

- callback后面函数名用引号引起

- 函数名不要用parse

- 参数的括号嵌套,不要出问题

8958

8958

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?