一、论文中 5 METHOD 的笔记

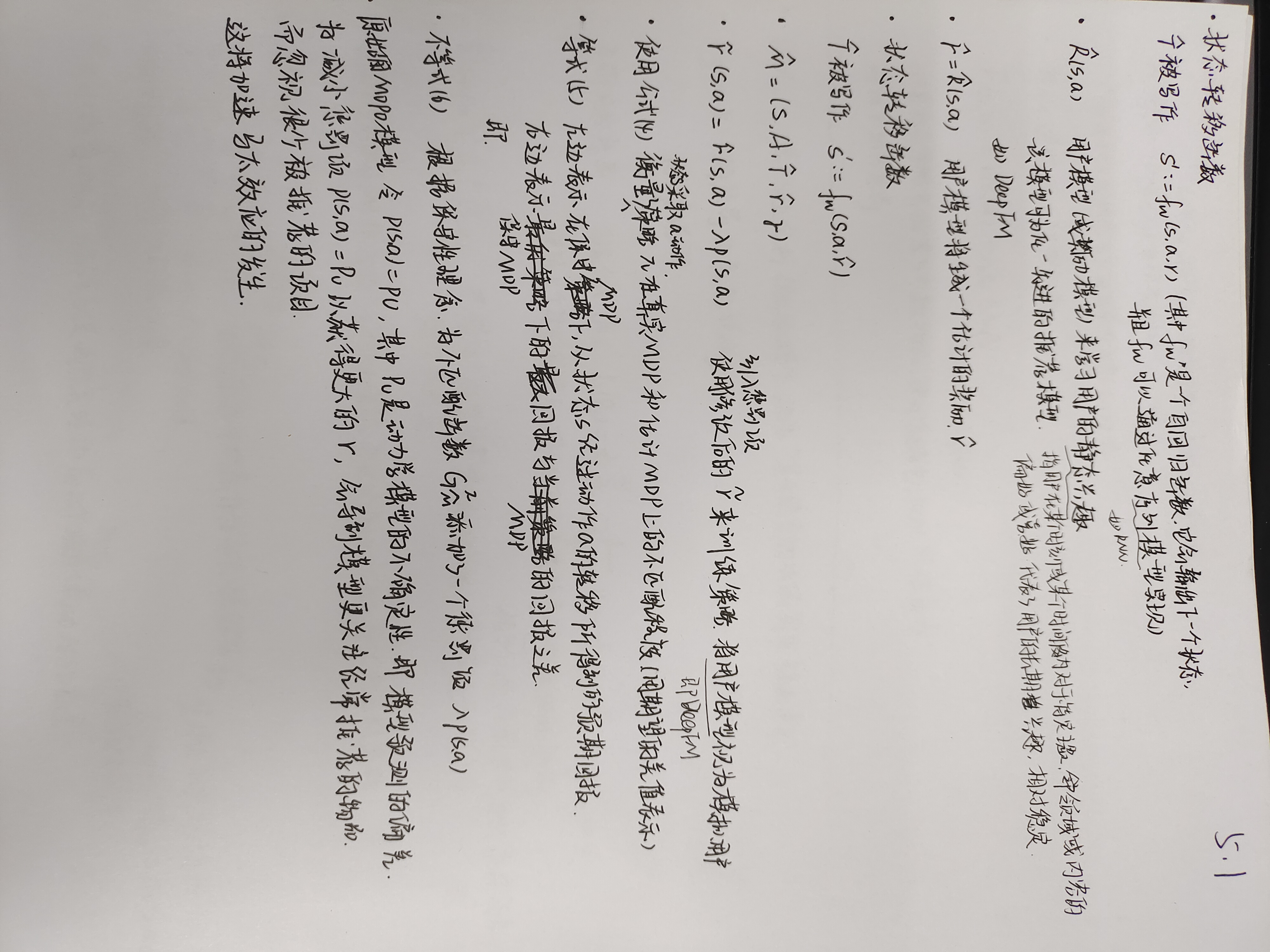

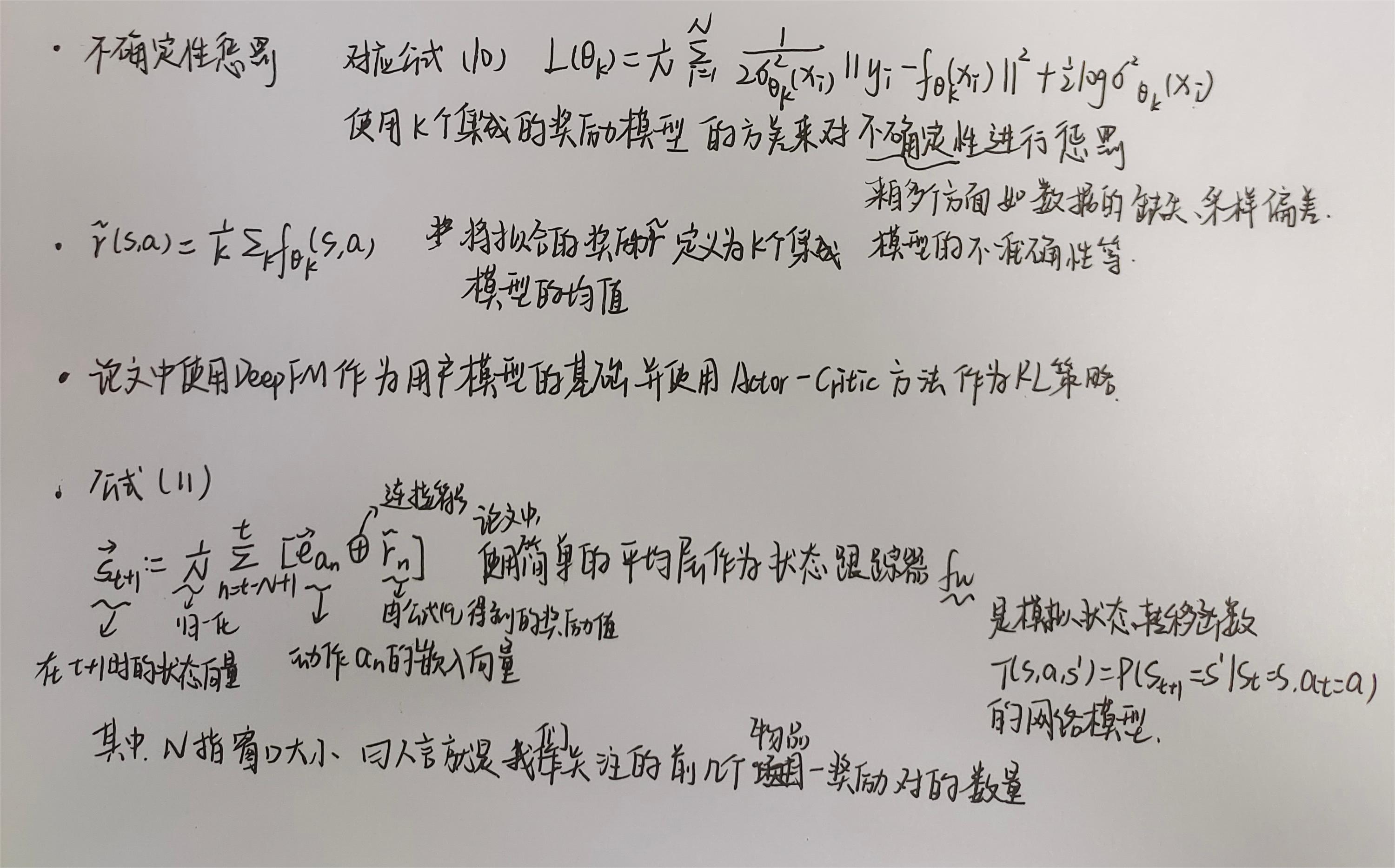

1.1 5.1 Model-based RL in Recommendation

1.2 5.2 Matthew Effect

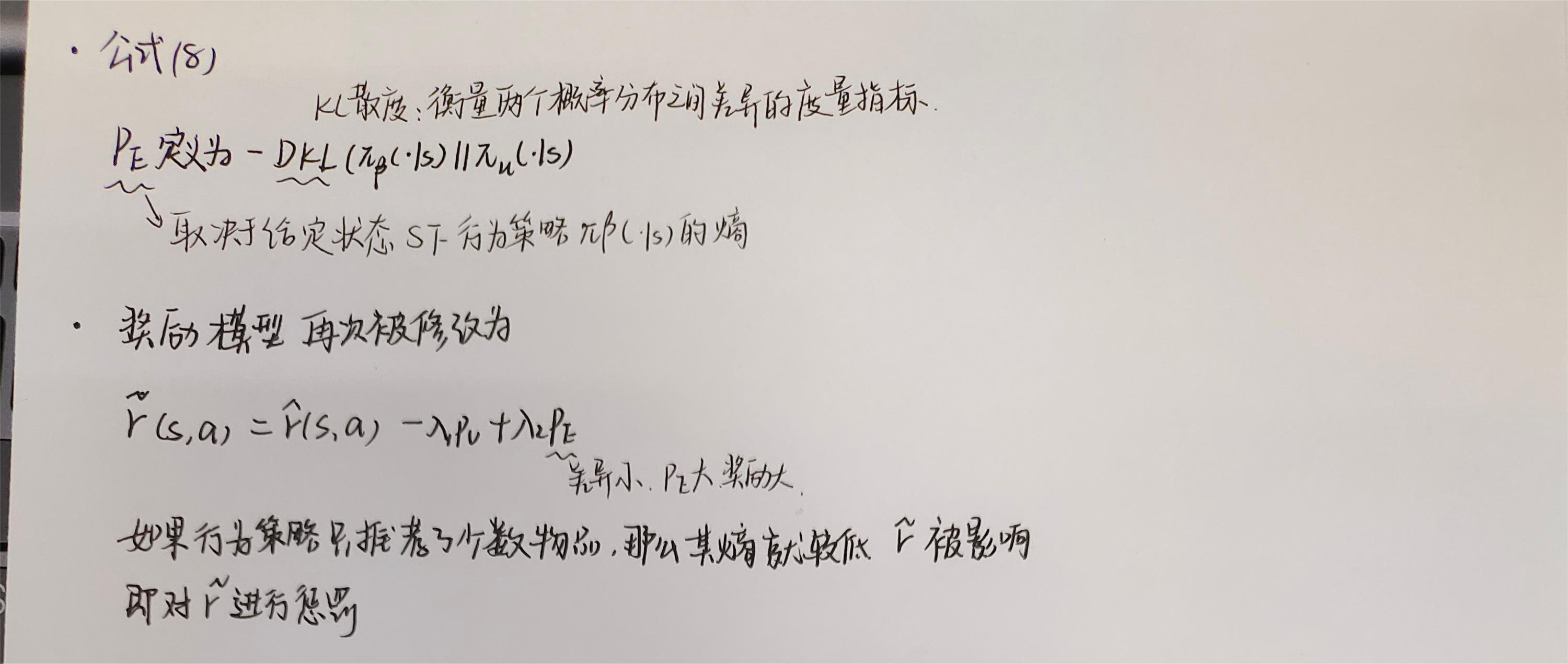

1.3 5.3 Solution: Re-design the Penalty

熵惩罚项不依赖于选择的动作,而只依赖于所处的状态。这意味着这种惩罚的效果将是间接的,并且考虑长期优化会惩罚导致较少多样状态的动作。因此,学习到的策略在离线数据中实现了反事实的探索,从而抵消了离线强化学习中的马太效应。

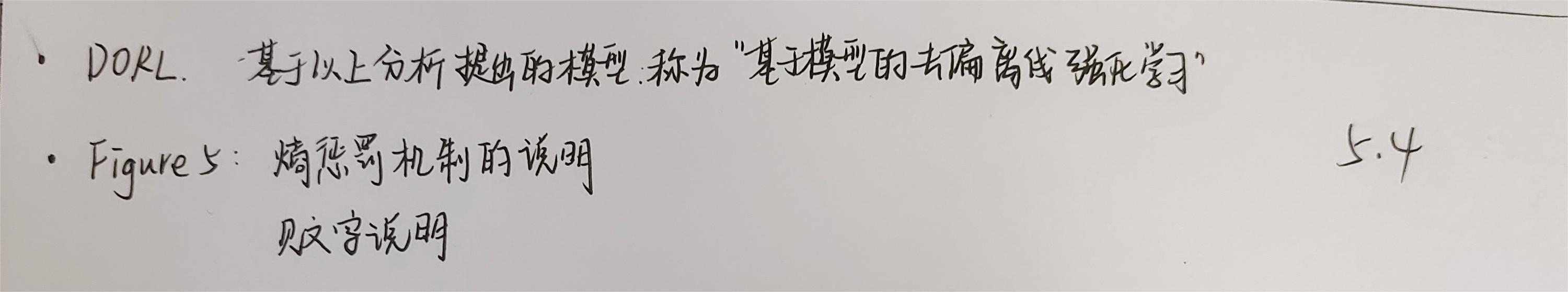

1.4 5.4 The DORL Method

Figure 5显示了交互过程的轨迹。其中时间 t 的当前动作是推荐视频8,上一时间 t-1 的动作是推荐视频3……。我们在公式(9)中定义PE为k阶熵(k = 1, 2, · · · )的总和。例如,当k = 3时(代码中k==3),搜索所有用户的推荐日志,收集具有[{3, 7, 8}, ?]的所有连续子序列,其中"?"可以匹配任何视频,{3, 7, 8}是一个排序集合,可以包括它的所有枚举,例如[8, 3, 7]或[7, 3, 8]。在这些子序列上,我们可以计算动作"?"的频率,从而估计给定前三个推荐视频的行为策略𝜋𝛽的熵。为了不失一般性,我们将熵归一化到(0,1]范围内。

741

741

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?