目录

第六章 初始化

一、为什么要初始化?

- 初始点的选取,有时能够决定算法是否收敛

- 当收敛时,初始点可以决定学习收敛的多快,是否能够收敛到一个代价高或低的点

- 过大的初始化导致梯度爆炸,过小的初始化导致梯度消失

二、什么是好的初始化?

- 让各神经元层激活值不会出现饱和现象

- 各层激活值也不能为0

三、常见的初始化

1、全零初始化

- 全零初始化:参数初始值为0。

- 缺点:同一层的神经元会学习到相同的特征,不能破坏不同神经元的对称性质。如果神经元的权重被初始化为0 ,所有神经元的输出都将是相同的,除了输出之外,所有的中间层的节点的值都为零。一般神经网络拥有对称的结构, 那么在进行第一次误差反向传播时,更新后的网络参数将会相同,在下一次更新时,相同的网络参数学习提取不到有用的特征,因此深度学习模型都不会使用0初始化所有参数。

2、随机初始化

- 随机初始化:将参数初始化为小的随机数。一般随机值从均值为μ ,标准差是σ的高斯分布中取样,最终参数的每个维度来自一个多维的高斯分布。

- 缺点:一旦随机分布选择不当,就会导致网络优化陷入困境。若参数初始值取得太小,在反向传播时会导致小的梯度,对于深度网络来说,会产生梯度弥散问题,降低参数的收敛速度。 若参数初始值取得太大,那么神经元会容易饱和。

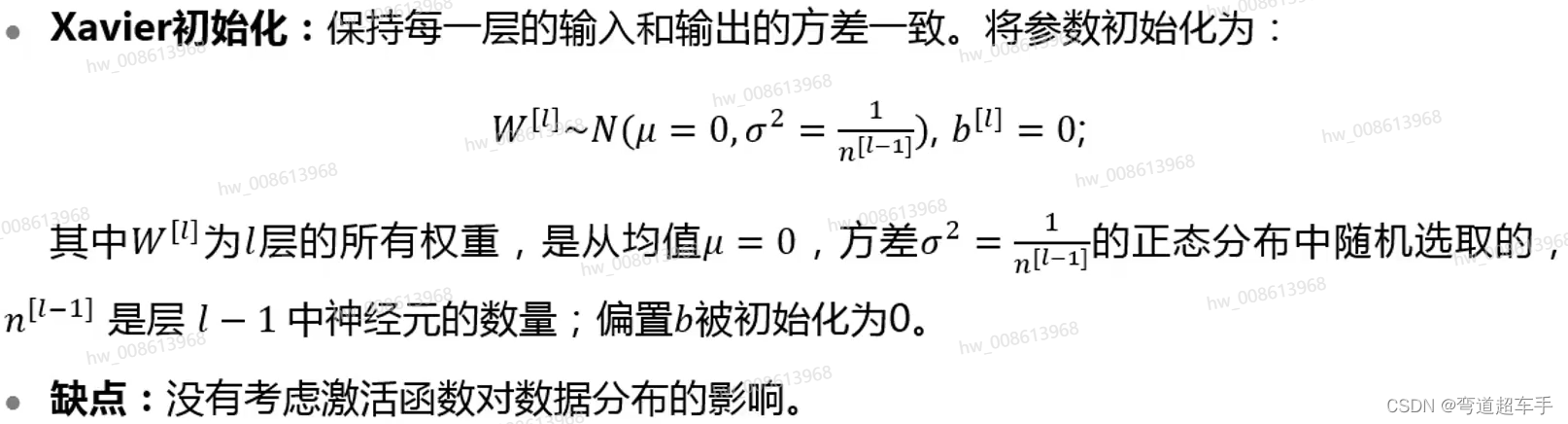

3、Xavier初始化

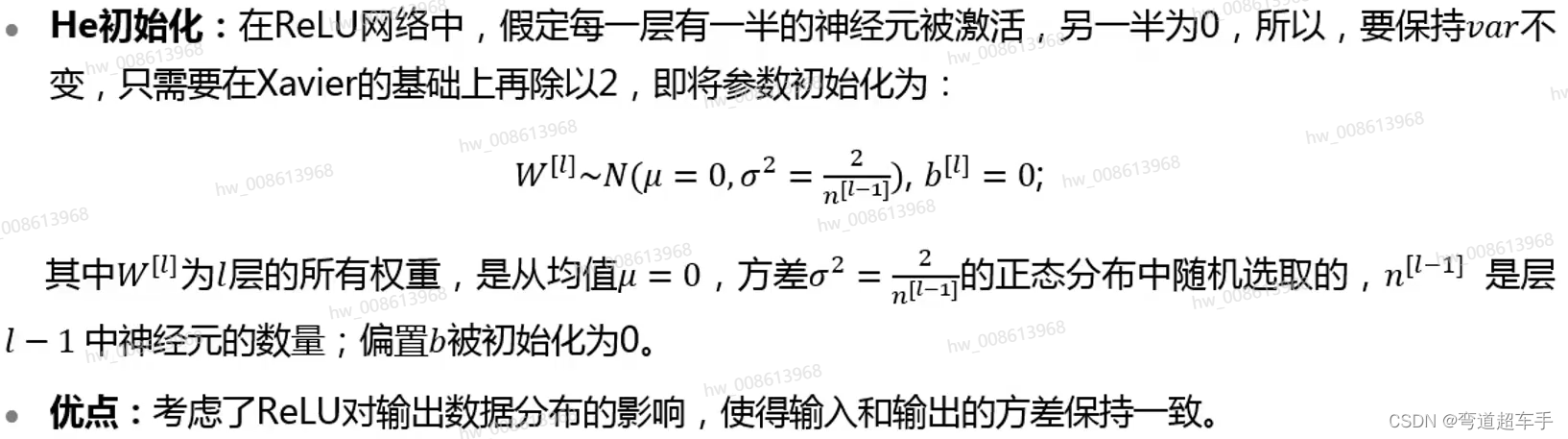

4、He初始化

第七章 参数调节

1、试错法:比如学生设计了一个实验后,遵循学习过程的所有步骤(从数据收集到特征图映射的可视化),然后在超参数上依次迭代直到时间终止。

2、网格搜索:如果有三个或更少的超参数时,常见的超参数搜索方法是网格搜索。对于每个超参数,使用者选择一个较小的有限值集去探索。然后,这些超参数笛卡尔乘积得到一组组超参数,网格搜索使用每组超参数训练模型。挑选验证集误差最小的超参数作为最好的超参数。

3、随机搜索:网格搜索和随机搜索之间的唯一区别在于策略周期的第一步,随机搜索在配置空间上随机选择点。

4、贝叶斯优化:

- 构建模型

- 选择超参数

- 训练,评估

- 优化模型,返回到第二步

2485

2485

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?