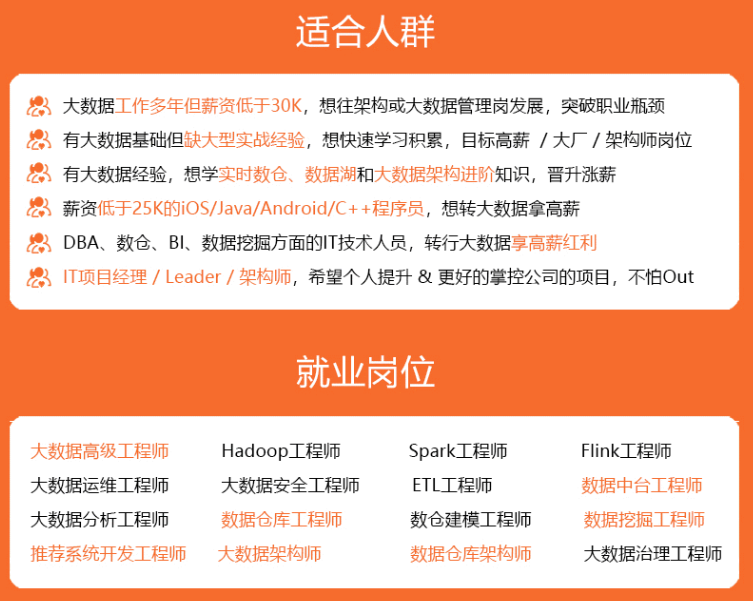

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上大数据知识点,真正体系化!

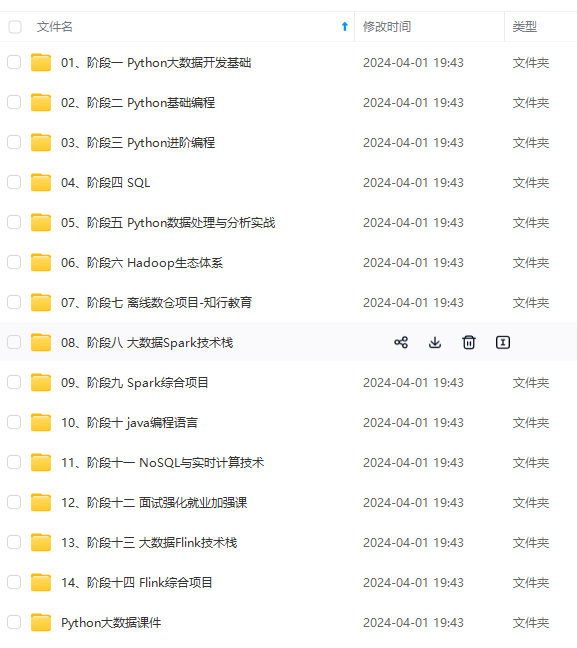

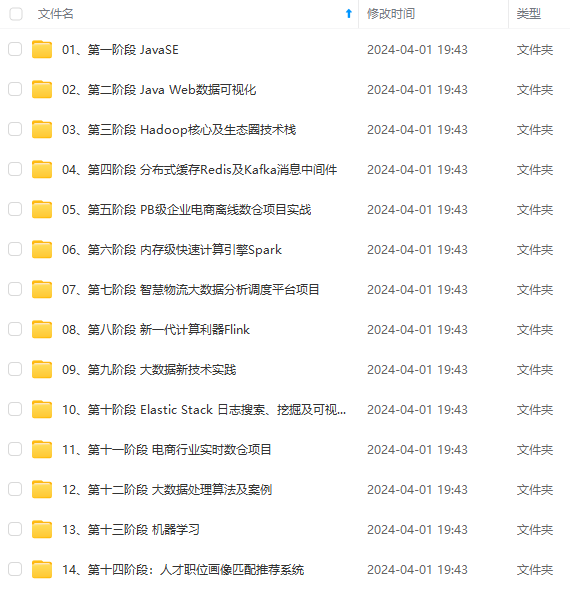

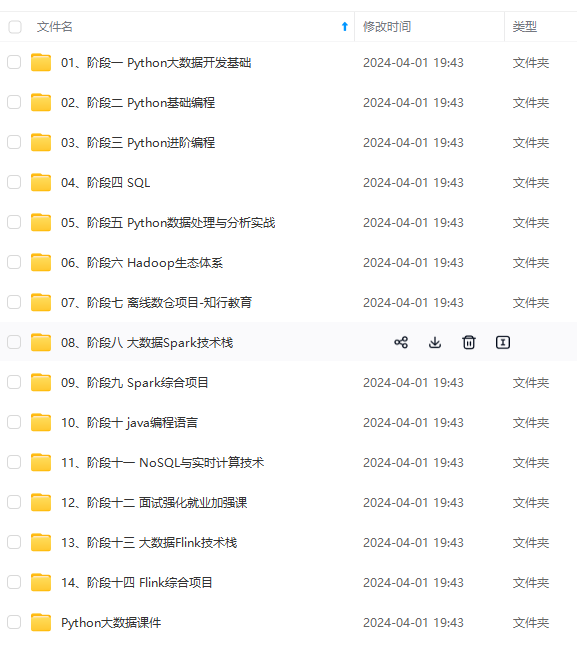

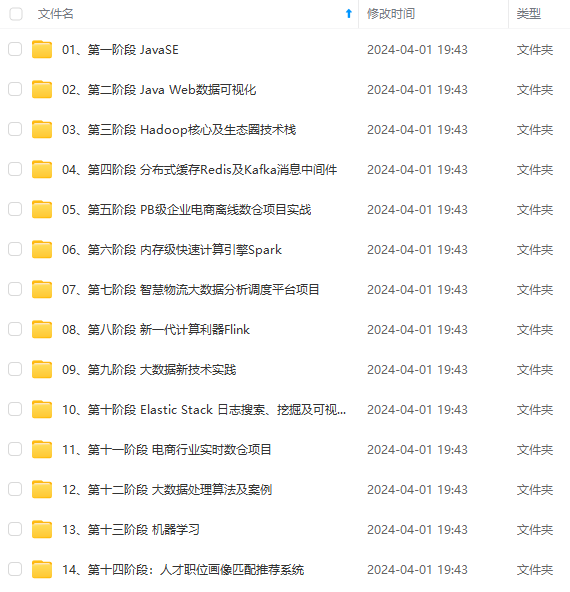

由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新

下载后把文件解压,如图:

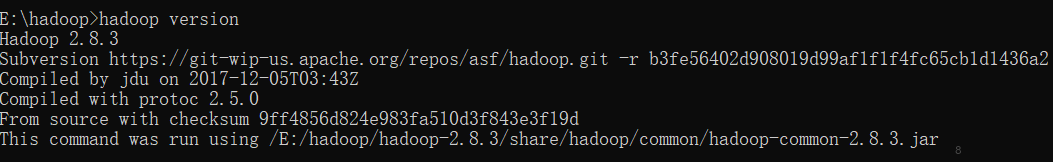

本文基于Hadoop版本hadoop-2.8.3

2,当前电脑要安装有java的jdk,配置java环境和java_home。我没修改环境变量,我是通过Windows下bat文件写入代码实现,命令行启动的bat文件代码:

set JAVA_HOME=D:\Java

set HADOOP_HOME=E:\hadoop\hadoop-2.8.3

set path=C:\Windows\System32;%JAVA_HOME%\bin;%HADOOP_HOME%\bin;

start cls

3,此时启动第2步的bat文件,输入命令:hadoop version,然后输出如图:

表明Hadoop初步的搭建安装成功。但是此时仍然不能查看节点等,还需要完成下面步骤。

4,Hadoop在Windows下完整运行需要Windows组件支持,从

https://github.com/steveloughran/winutils

这里下载一个,下载完成后,解压得到若干版本的winutils,我选用2.8.3版本:

然后把上面的bin文件一股脑全部复制到第1步中解压后的hadoop-2.8.3\bin文件夹下面,覆盖原先的bin目录文件下所有文件。

5,创建三个文件夹,namenode,datanode,tmp。如图:

6,把以下4个配置文件全部复制替换掉hadoop\hadoop-2.8.3\etc\hadoop下的文件:

core-site.xml:

<?xml version="1.0" encoding="UTF-8"?>fs.defaultFS

hdfs://localhost:9000

hadoop.tmp.dir

/E:/hadoop/my/tmp

hdfs-site.xml:

<?xml version="1.0" encoding="UTF-8"?>dfs.replication

1

dfs.namenode.name.dir

/E:/hadoop/my/namenode

dfs.datanode.data.dir

/E:/hadoop/my/datanode

mapred-site.xml:

<?xml version="1.0"?>mapreduce.framework.name

yarn

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上大数据知识点,真正体系化!

由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新

升的进阶课程,涵盖了95%以上大数据知识点,真正体系化!**

由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新

948

948

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?