引言

核函数是支持向量机(Support Vector Machine,SVM)和其他机器学习算法中的一个重要概念。它们用于将非线性问题转化为高维特征空间中的线性问题,从而使线性分类器能够有效地处理非线性数据。

核函数的主要思想是通过将数据映射到一个更高维度的特征空间,使原始数据在这个新的特征空间中变得线性可分或更容易分离。这种映射通常是非线性的,但核函数的关键性质是,它们允许在高维空间中计算内积,而不需要显式地计算特征空间的每个维度。

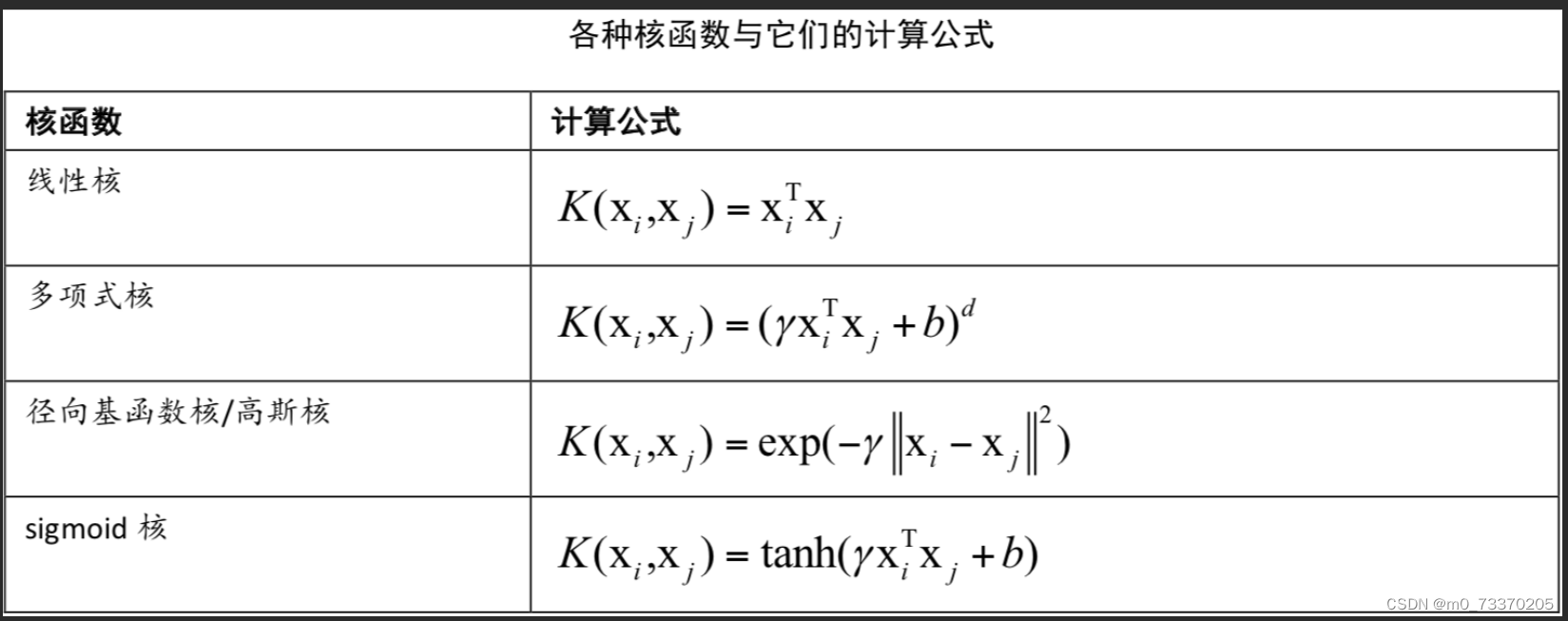

常用的核函数

1. 线性核函数:这是最简单的核函数,它不进行任何特征映射,直接使用原始特征。在线性可分的情况下,这个核函数通常效果很好。

2. 多项式核函数:多项式核函数将数据映射到更高维度的特征空间,并使用多项式函数来实现映射。它的形式为K(x, y) = (x·y + c)^d,其中d是多项式的次数,c是一个常数。

3. 高斯核函数(RBF核函数):高斯核函数是非常常用的核函数之一,它将数据映射到无穷维的特征空间。它的形式为K(x, y) = exp(-γ‖x - y‖²),其中γ是一个控制核函数宽度的参数。

4. 均匀核函数:均匀核函数也称为矩形核函数,用于将数据映射到无限维的特征空间。它在给定的超立方体中返回1,否则返回0。

5. Sigmoid核函数:Sigmoid核函数是另一种非线性核函数,它的形式为K(x, y) = tanh(αx·y + c),其中α和c是核函数的参数。

个人思考

个人认为核函数的选择取决于问题的性质和数据的分布。一般实践中需要尝试不同的核函数,并调整相关参数来找到最适合问题的核函数。SVM是最常用的是支持向量机,但核函数也可以应用于其他算法,如核主成分分析(Kernel PCA)和核岭回归(Kernel Ridge Regression)等。核函数的选择和参数调优是机器学习任务中的关键一步,它可以显著影响模型的性能,所以好的方法配置可以事半功倍,在python中内置了很多函数可以用于此方面的实现,有兴趣的可以试下!

245

245

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?