目录

一.广义线性回归到逻辑回归

1.什么是逻辑回归

首先逻辑回归并不是一个回归算法,而是一个分类算法,因为逻辑回归是基于多元线性回归算法的,所以逻辑回归是一个线性的分类算法。比如有一堆点,这些点有很多种颜色,我们要用线将这线点划分开,尽量一种颜色一个区域

2.学习之前我们要线了解一个函数:Sigmoid函数:

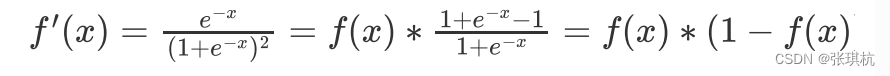

Sigmoid函数有一个非常好的特性,它的导数可以用自身来表示:

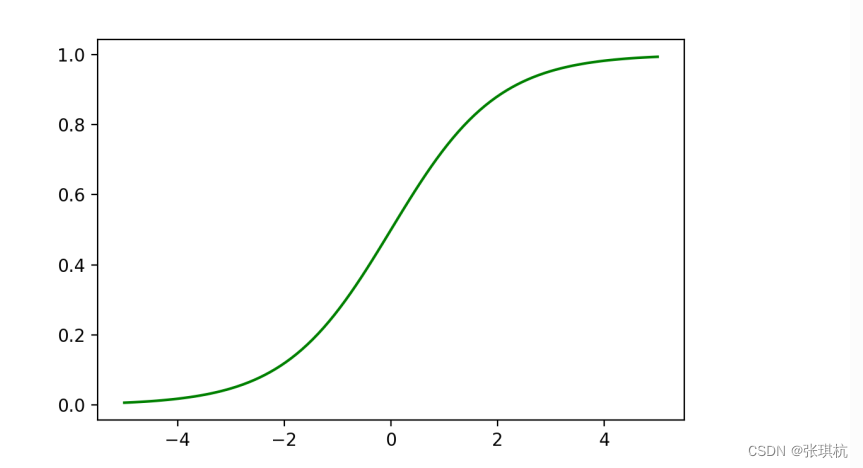

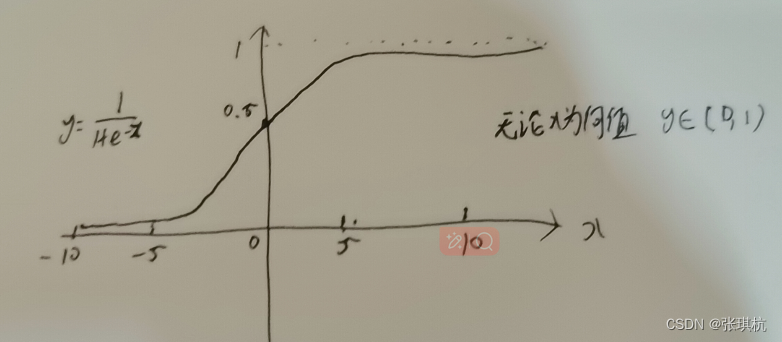

它的函数图像:

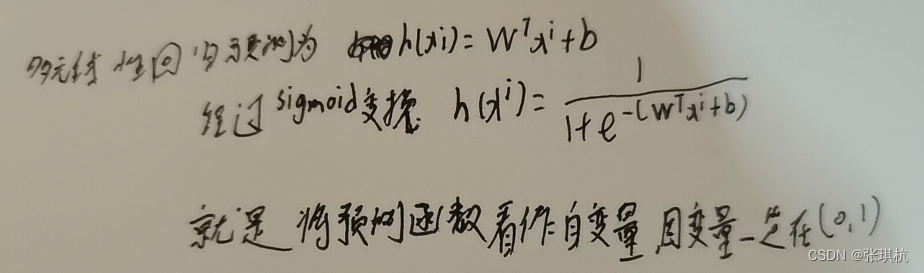

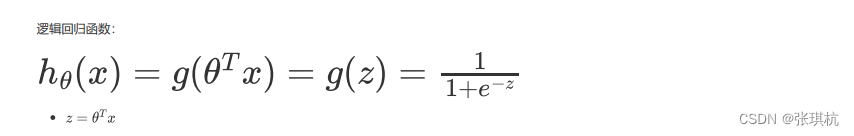

逻辑回归的原理就是将多元线性回归的结果缩放到(0,1)之间,比如我们将0.5视为一个分类点,那么就可以将结果分为两类(0,0.5)和(0.5,1).那么要怎么缩放呢?

同理,我们将0.2,0.4,0.6,0.8看作分类点,那么就可以把数据分为五类了

2.逻辑回归公式推导:

1.损失函数推导

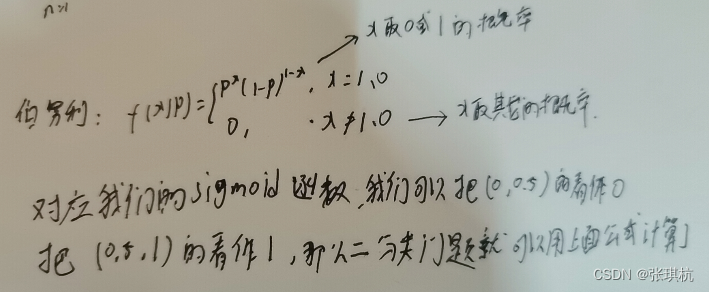

首先是二分类,这里用概率论的伯努利分布(Bernoulli)0-1分布引入一下:

然后我们再使用最大似然估计思想:最大似然估计就是当我们样本有很多的时候,比如一百个球,不知道有多少个白球和黑球,但是我们放回的抽取了一百次,其中有70次白球,30次黑球,我们就可以估计白球的概率为0.7,黑球的概率为0.3。这种方法就叫最大似然估计。

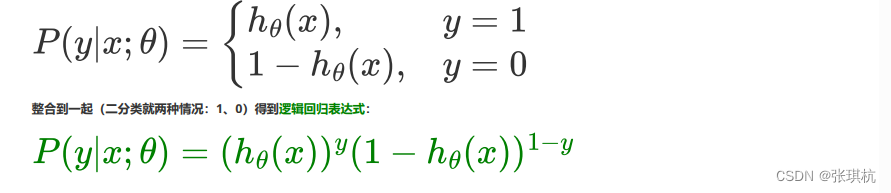

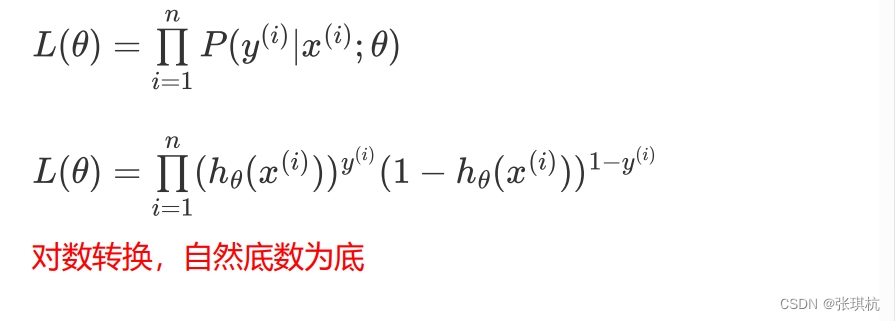

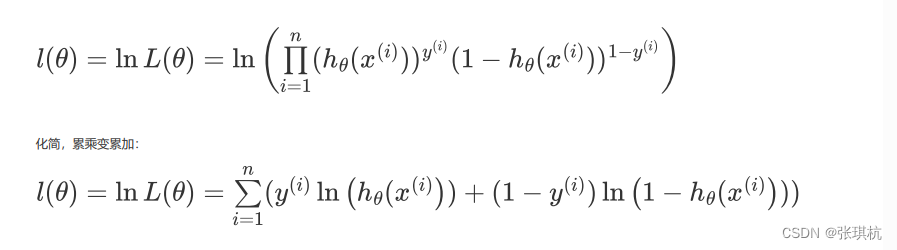

那么我们这里的0和1就像白球和黑球,每次摸到的球可以用伯努利计算,那么它的每次摸球的概率相乘就是它的损失函数了。根据伯努利分布得到 ,也就是就是抓到1的概率,1-它就是0的概率,下面那个方程当抓到1时后面哪项就为0,反正就是抓到0的概率

通过最大似然估计思想后化简就得到了逻辑回归的损失函数了

3.逻辑回归梯度下降

1.函数特性:

逻辑回归的下降规则和线性回归的一样,梯度下降不太清楚的可以去看看梯度下降算法推导

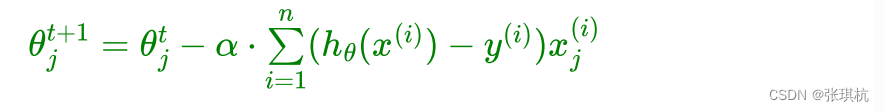

将逻辑回归的损失函数带入梯度那么:下一步=当前+梯度

前面推的逻辑回归函数:

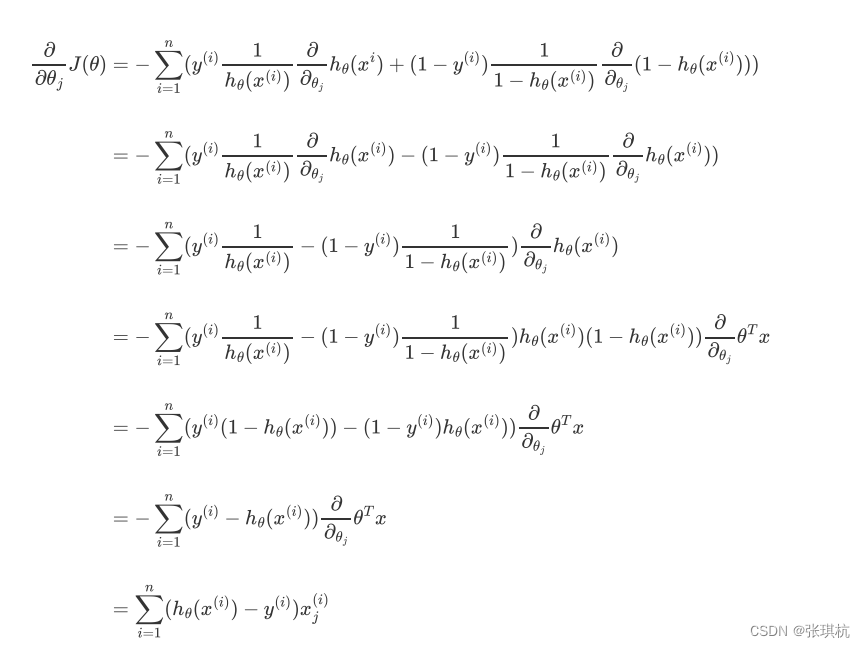

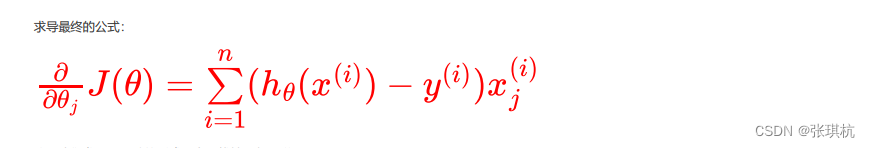

我们将逻辑回归的损失函数求导:

其实最后得到的这个导函数形式和多元线性回归一样,将其导入到梯度下降公式后就得到逻辑回归梯度下降公式了,这个是用来对参数更新的,一步步的走到极值,也就是一步步走到最优解

4.逻辑回归的多分类问题:

我们上面说的主要是二分类问题,那么多分类呢,就是分类白球,黑球,红球,绿球呢

根据我们上面所说的将0.5作为分类点,那么0.2,0.4,0.6,0.8的呢,其实也可以看着二分类问题,我们可以将(0.8,1)的看着一类分类好以后再将(0.6,1)的看着一类以此类推,五次二分类后就将他们分类好了。

这种方法称为One-Vs-Rest,作为一个二分类的扩展方法。优点:普适性还比较广,可以应用于能输出值或者概率的分类器,同时效率相对较好,有多少个类别就训练多少个分类器。缺点:很容易造成训练集样本数量的不平衡(Unbalance),尤其在类别较多的情况下,经常容易出现正类样本的数量远远不及负类样 本的数量,这样就会造成分类器的偏向性。

5.多分类Softmax回归

1.多项分布-指数分布族形式

多项式分布可以理解为二项式分布的扩展,比如抛硬币是二项式,骰子是多项式

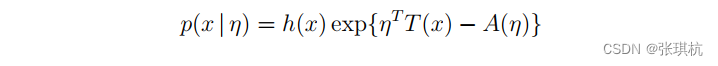

指数分布族中的分布:

其中:

为自然参数(natural parameter),可以是向量形式

T ( x )为充分统计量(sufficient statistic)

A(η)为累计函数(cumulant function),作用是确保概率和为1

h(x)为underlying measure

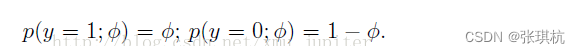

对于二项分布(伯努利分布),每一个取不同均值的参数Φ,就会唯一确定一个y属于{0,1}之间的分布。所以可以表示为

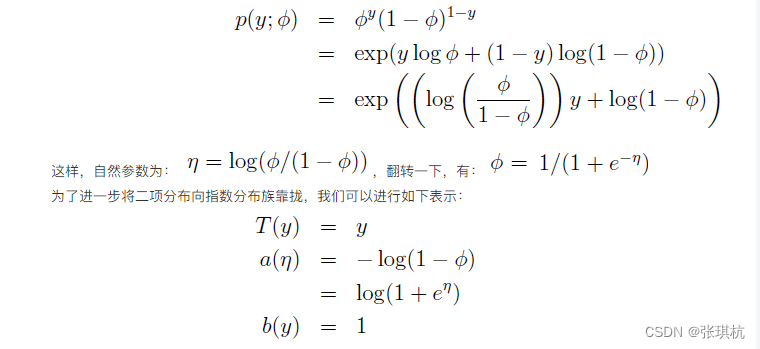

故二项分布的分布函数只以Φ作为参数,统一这样表示二项分布:

这显示了二项分布可以被写成是指数分布族的形式,所以二项分布属于指数分布族。

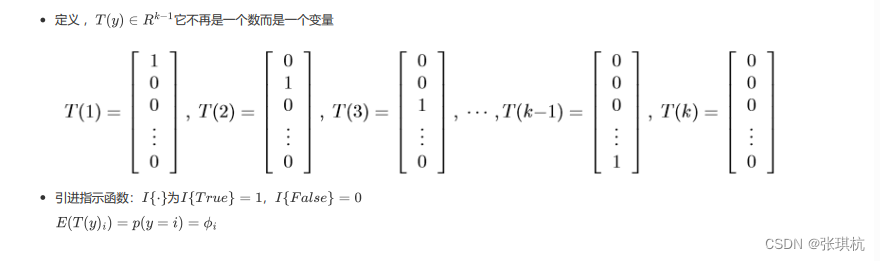

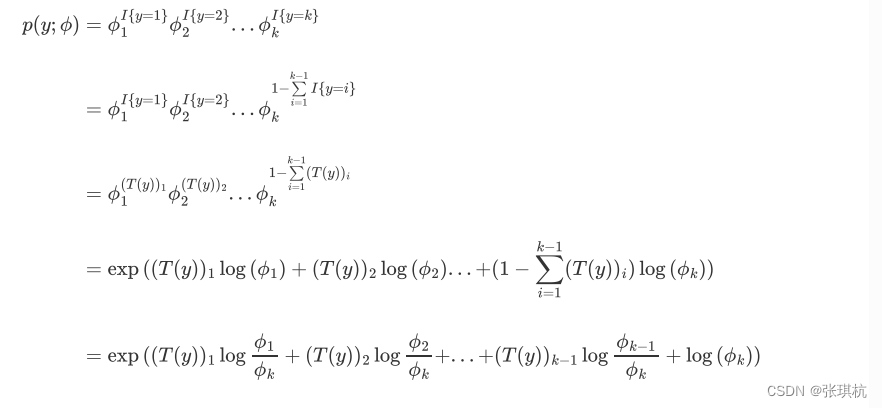

对于多项式分布:

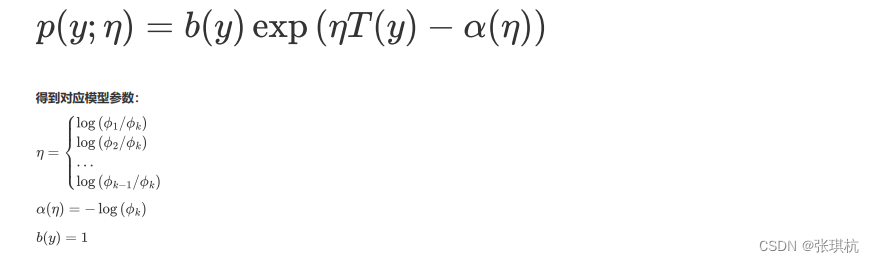

得到它的指数分布族形式:

指数分布族标准表达式如下:

2.广义线性模型推导Softmax回归

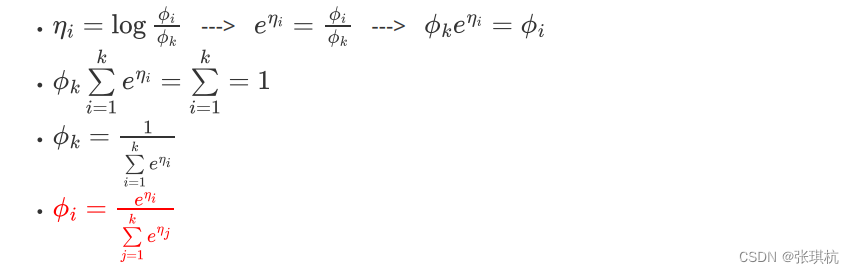

证明了多项分布属于指数分布族后,接下来求取由它推导出的概率函数Softmax

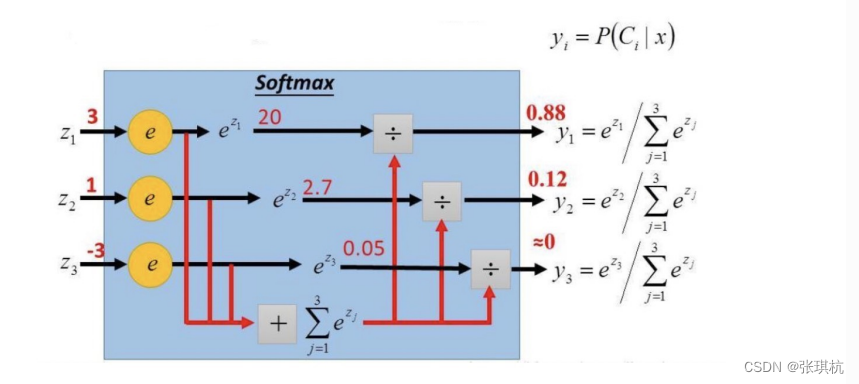

上面这个函数,就叫做Softmax函数。

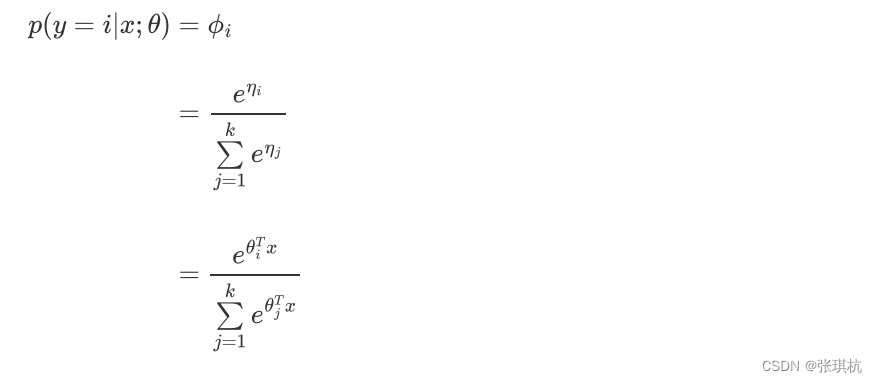

引用广义线性模型的假设3,即 是 x 的线性函数,带入Softmax函数可以得到:

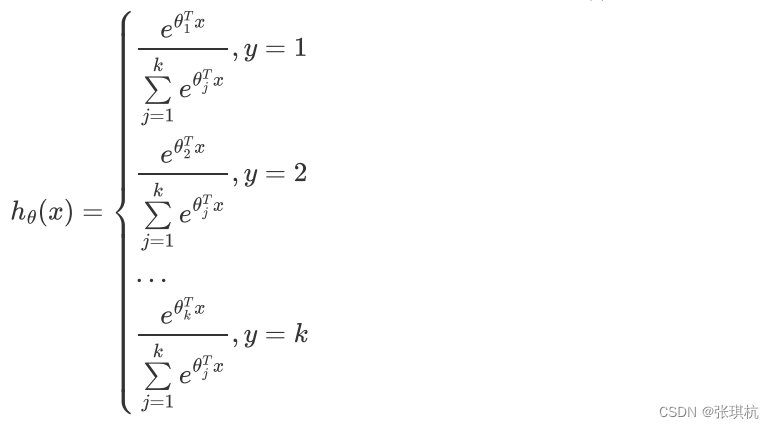

这个模型被应用到y = {1, 2, ..., k}就称作Softmax回归,是逻辑回归的推广。最终可以得到它的假设函数 :

举例说明:

6. 逻辑回归与Softmax回归对比

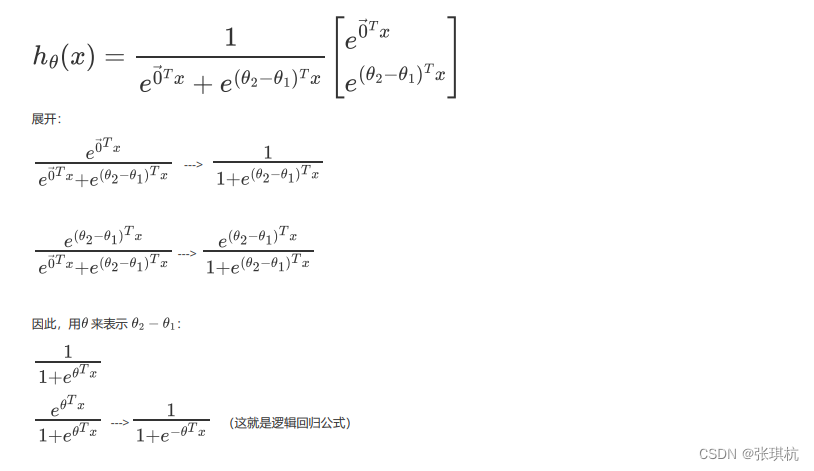

1、逻辑回归是Softmax回归特例证明

逻辑回归可以看成是 Softmax 回归的特例,当k = 2 时,softmax 回归退化为逻辑回归,softmax 回归的假设函数为:

利用softmax回归参数冗余的特点,我们令 并且从两个参数向量中都减去向量 ,得到:

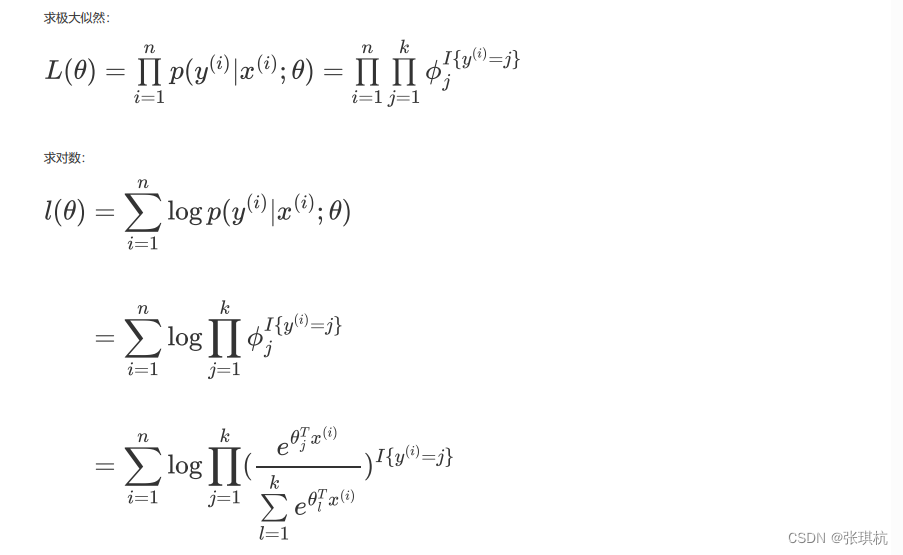

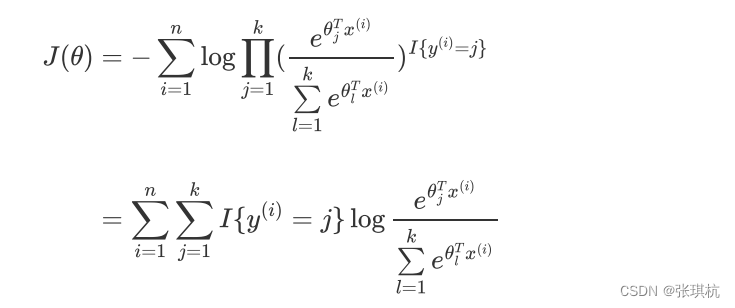

2、Softmax损失函数

取反,损失函数是:

都看到这里了点个赞再走呗!

3305

3305

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?