1.数据集标注

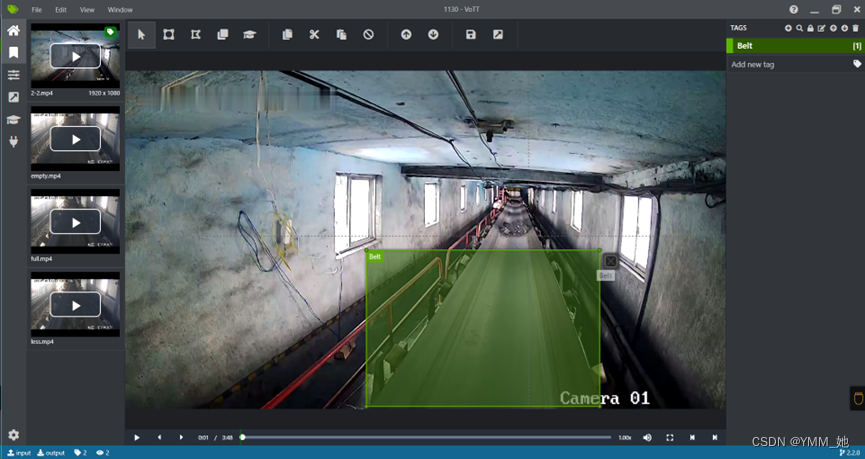

我们使用VOTT对图像数据集进行标注:

1. 将数据集拷贝到目标文件夹中,并创建结果文件夹。

2. 打开VOTT对数据集中的目标进行标注。

3. 全部标注结束后将文件导出。我们会得到标注的图片和对应的XML标注文件。

2.格式转化

1. 因为YOLO系列训练需要TXT格式的标注文件,所以我们需要将XML标注文件转化为·TXT文件。

我们首先创建转化make_txt.py代码。

# -*- coding: utf-8 -*-

import xml.etree.ElementTree as ET

import os

from os import getcwd

sets = ['train', 'val', 'test']

classes = ["Belt"] # 改成自己的类别

abs_path = os.getcwd()

print(abs_path)

def convert(size, box):

dw = 1. / (size[0])

dh = 1. / (size[1])

x = (box[0] + box[1]) / 2.0 - 1

y = (box[2] + box[3]) / 2.0 - 1

w = box[1] - box[0]

h = box[3] - box[2]

x = x * dw

w = w * dw

y = y * dh

h = h * dh

return x, y, w, h

def convert_annotation(image_id):

in_file = open('data/Annotations/%s.xml' % (image_id), encoding='UTF-8')

out_file = open('data/labels/%s.txt' % (image_id), 'w')

tree = ET.parse(in_file)

root = tree.getroot()

size = root.find('size')

w = int(size.find('width').text)

h = int(size.find('height').text)

for obj in root.iter('object'):

difficult = obj.find('difficult').text

# difficult = obj.find('Difficult').text

cls = obj.find('name').text

if cls not in classes or int(difficult) == 1:

continue

cls_id = classes.index(cls)

xmlbox = obj.find('bndbox')

b = (float(xmlbox.find('xmin').text), float(xmlbox.find('xmax').text), float(xmlbox.find('ymin').text),

float(xmlbox.find('ymax').text))

b1, b2, b3, b4 = b

# 标注越界修正

if b2 > w:

b2 = w

if b4 > h:

b4 = h

b = (b1, b2, b3, b4)

bb = convert((w, h), b)

out_file.write(str(cls_id) + " " + " ".join([str(a) for a in bb]) + '\n')

wd = getcwd()

for image_set in sets:

if not os.path.exists('data/labels/'):

os.makedirs('data/labels/')

image_ids = open('data/ImageSets/%s.txt' % (image_set)).read().strip().split()

list_file = open('data/%s.txt' % (image_set), 'w')

for image_id in image_ids:

list_file.write(abs_path + '/data/images/%s.jpg\n' % (image_id))

convert_annotation(image_id)

list_file.close()2. 划分数据集。我们需要训练集、验证集和测试集,所以需要对数据集进行划分.

我们再创建数据集划分代码voc_label.py。

import os

import random

trainval_percent = 0.8

train_percent = 0.8

xmlfilepath = 'data/Annotations'

txtsavepath = 'data/ImageSets'

total_xml = os.listdir(xmlfilepath)

num = len(total_xml)

list = range(num)

tv = int(num * trainval_percent)

tr = int(tv * train_percent)

trainval = random.sample(list, tv)

train = random.sample(trainval, tr)

ftrainval = open('data/ImageSets/trainval.txt', 'w')

ftest = open('data/ImageSets/test.txt', 'w')

ftrain = open('data/ImageSets/train.txt', 'w')

fval = open('data/ImageSets/val.txt', 'w')

for i in list:

name = total_xml[i][:-4] + '\n'

if i in trainval:

ftrainval.write(name)

if i in train:

ftest.write(name)

else:

fval.write(name)

else:

ftrain.write(name)

ftrainval.close()

ftrain.close()

fval.close()

ftest.close()

3.模型训练

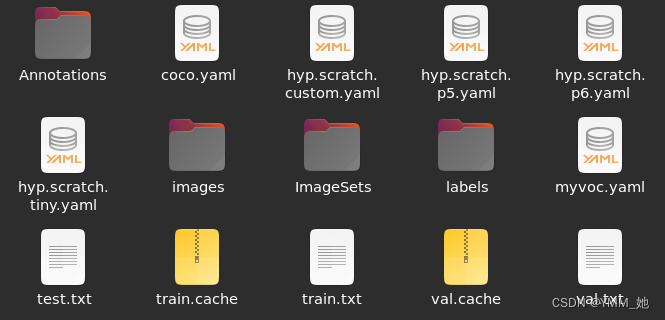

1. 首先创建数据配置文件。在YOLOV7的data数据集下创建myvoc.yaml配置文件。在文件里面写入训练集和验证集的路径、标注目标类别的数量以及标注类别的名称。

train: /home/11/yolov7/data/train.txt

val: /home/11/yolov7/data/val.txt

# number of classes

nc: 1

#class names

names: ["Belt"]

2. 然后对cfg/training文件下的yolov7.yaml文件进行修改。根据实际目标类别数量在该文件里面将number of classes进行修改。

![]()

3. 准备训练模型

第一步:我们将前面标注得到的图片和标注文件拷贝到YOLOV7的data数据集下。并创建一个新的文件夹取名ImageSets。

然后在YOLOV7文件夹下打开终端输入:

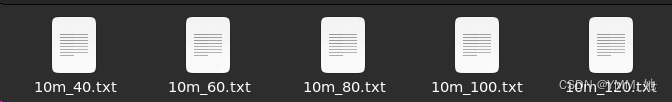

python make_txt.py我们会得到label文件夹,里面就是转换得到的txt文件。

然后再次运行

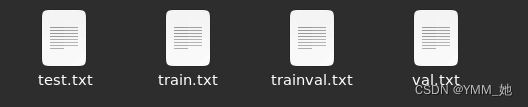

python voc_label.py我们会在ImageSets里面得到这四个文件。

当这些准备工作完成后将data下的JPEGImages文件夹改名为images。然后准备训练。

我们在刚才的终端中输入:

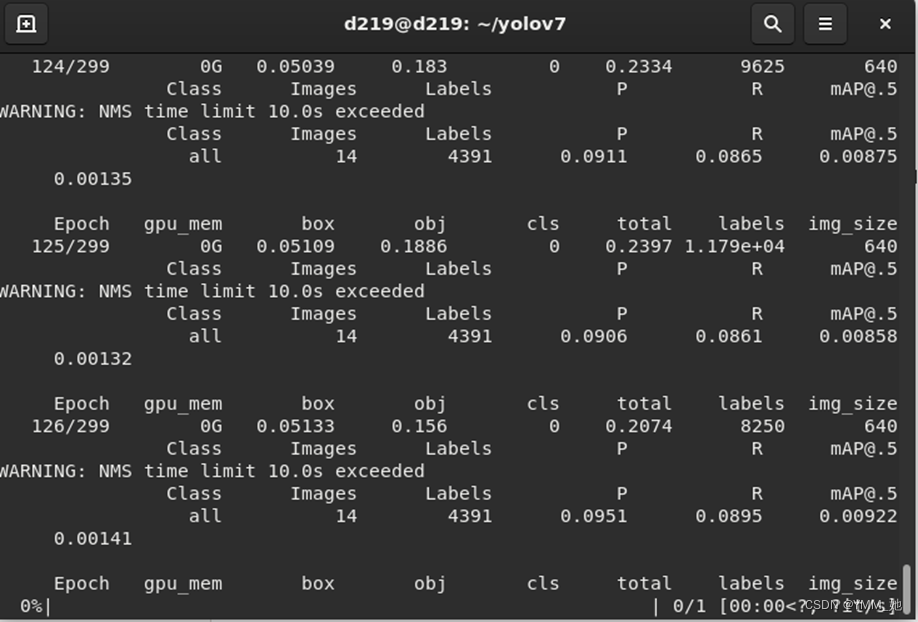

python train.py --cfg cfg/training/yolov7.yaml --weights yolov7.pt --data data/myvoc.yaml --batch-size 32 --epochs 300

模型开始训练

训练结束后会得到pt文件。然后我们需要将pt文件进行转化,因为只有转化为ONNX文件和Engine文件才能用TensorRT调用服务器GPU进行加速。

4. 部署

1. 下载DeepStream-Yolo-master项目文件。直接点击进入下载界面。

2. 找到DeepStream-Yolo-master/utils文件夹下的export_yoloV7.py文件并将该文件复制到YOLOV7的根目录处。该程序的主要目的就是将我们训练得到的模型文件转化为ONNX文件。

3. 模型转化,我们运行export_yoloV7.py文件,会将模型文件转换为ONNX文件。还是刚才的终端窗口我们输入:

python export_yoloV7.py --weight best_belt.pt

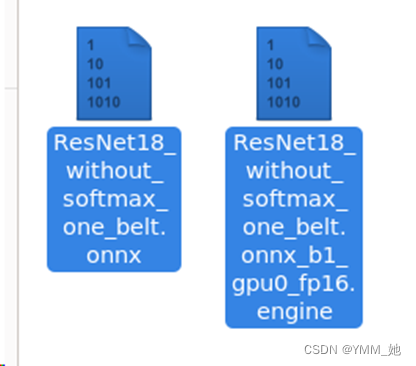

这个best_belt.pt是我们刚才训练得到的pt文件。我们就会得到这么一个ONNX文件。

5. DeepStream模型调用

1. 我们将前面下载的DeepStream-Yolo-master文件夹复制到Deepstream的source文件夹下。

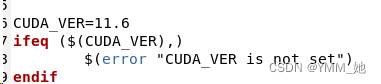

2. 打开DeepStream-Yolo-master/nvdsinfer_custom_impl_Yolo文件夹,根据服务器的CUDA版本对Makefile进行修改。

3. 命令行输入make进行编译。

make4. 对配置文件进行更改。打开deepstream_app_config.txt文件,将primary-gie文件进行更改。改为YOLOV7的配置文件。

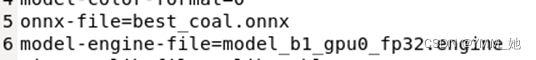

5. 打开config_infer_primary_yolov7.txt对onnx-file进行更改。将我们之前得到的onnx文件移动到该文件夹下,并用新的得到的onnx文件的名称替换onnx-file。

6. 在命令行运行Deepstream就会得到对应的Engine文件。

deepstream-app -C deepstrea_app_config.txt

有了这两个文件就能对视频进行推理。

2772

2772

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?