概述

本节教程讲述ComfyUI生成的方式之一StableVideoDeiffusion,注意:以下需要官网下载的相关资源,幽络源这里已提供网盘链接整理好了=>https://pan.quark.cn/s/f1c7501f2022

步骤1:下载SVD模型

进入官网,https://huggingface.co/collections/stabilityai/video,如下图

stabilityai/stable-video-diffusion-img2vid 是基础版

stabilityai/stable-video-diffusion-img2vid-xt 是增强版

stabilityai/stable-video-diffusion-img2vid-xt-1-1 是较新的一版

上面的sv3d和sv4d分别是用于3D和4D图像生成的

幽络源这里下载stabilityai/stable-video-diffusion-img2vid 基础版进行测试

如图,这里只需下载svd.safetensors即可

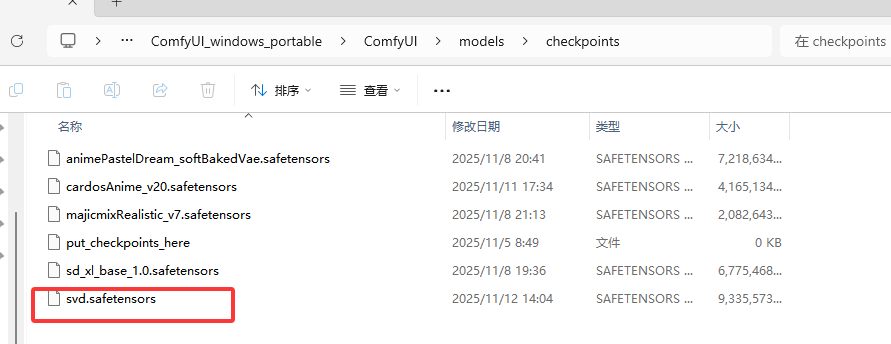

然后将模型放入ComfyUI_windows_portable\ComfyUI\models\checkpoints,如图

步骤2:下载ComfyUI-VideoHelperSuite

进入ComfyUI_windows_portable\ComfyUI\custom_nodes目录,cmd执行如下命令

git clone https://github.com/Kosinkadink/ComfyUI-VideoHelperSuite克隆后,再cmd进入VideoHelperSuite目录,下载依赖

利用ComfyUI自带的python环境下载对应所需依赖,幽络源这里是将ComfyUI放置于D盘的,因此下载依赖命令如下

D:\ComfyUI_windows_portable\python_embeded\python.exe -m pip install -r requirements.txt步骤3:导入工作流进行视频生成

概述中幽络源的网盘链接中已提供工作流,导入即可进行使用,测试如下

结语

以上是幽络源的“ComfyUI进行AI视频生成方式之一 StableVideoDiffusion”教程,如有疑问或感兴趣可通过下方名片加入我们交流学习

1100

1100

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?