本文提供的方法主要用于缓解国内访问GitHub不稳定导致安装出现错误,以及通过使用国内的镜像提升安装包的安装速度,同时尽可能不影响原本的安装过程和使用体验。

注:作者目前仅在Windows平台且有NIVIDA GPU的环境下部署,理论上Linux平台同样适用。若有问题,欢迎留言。

注:由于stable-diffusion-webui官方的手动安装教程落后于版本,因此不建议遵照手动安装教程进行安装。

stable-diffusion-webui 介绍

stable-diffusion-webui 是一个基于Gradio库的Stable Diffusion的浏览器界面,可以说是AI绘画集合体,支持目前主流的开源AI绘画模型,例如 NovelAi/Stable Diffusion,有了它,我们就可以很方便地配置和生成AI绘画作品,并且进行各种精细地配置。

stable-diffusion-webui 界面

Python环境配置以及基础包安装

安装Anaconda,同时配置好清华镜像,以及Pypi镜像,方法略,网上资料比较多。

Anaconda安装完成后,运行如下命令创建并激活python3.10的环境

conda create -n sdwebui python=3.10

conda activate sdwebui

stable-diffusion-webui 的源文件下载和配置

找个空间比较大的硬盘,执行下面的命令,下载stable-diffusion-webui 的源文件。(以下命令已经过镜像加速,但可能会失效,如有问题,请给我留言)

git clone https://github.moeyy.xyz/https://github.com/AUTOMATIC1111/stable-diffusion-webui.git

下载完成后,用任何编辑器打开launch.py文件,进行修改,但凡出现 https://github.com 的地方,在它的前面加上https://github.moeyy.xyz/ 即可,修改完成后的结果参考如下:

gfpgan_package = os.environ.get('GFPGAN_PACKAGE', "git+https://github.moeyy.xyz/https://github.com/TencentARC/GFPGAN.git@8d2447a2d918f8eba5a4a01463fd48e45126a379")

clip_package = os.environ.get('CLIP_PACKAGE', "git+https://github.moeyy.xyz/https://github.com/openai/CLIP.git@d50d76daa670286dd6cacf3bcd80b5e4823fc8e1")

openclip_package = os.environ.get('OPENCLIP_PACKAGE', "git+https://github.moeyy.xyz/https://github.com/mlfoundations/open_clip.git@bb6e834e9c70d9c27d0dc3ecedeebeaeb1ffad6b")

xformers_windows_package = os.environ.get('XFORMERS_WINDOWS_PACKAGE', 'https://github.moeyy.xyz/https://github.com/C43H66N12O12S2/stable-diffusion-webui/releases/download/f/xformers-0.0.14.dev0-cp310-cp310-win_amd64.whl')

stable_diffusion_repo = os.environ.get('STABLE_DIFFUSION_REPO', "https://github.moeyy.xyz/https://github.com/Stability-AI/stablediffusion.git")

taming_transformers_repo = os.environ.get('TAMING_TRANSFORMERS_REPO', "https://github.moeyy.xyz/https://github.com/CompVis/taming-transformers.git")

k_diffusion_repo = os.environ.get('K_DIFFUSION_REPO', 'https://github.moeyy.xyz/https://github.com/crowsonkb/k-diffusion.git')

codeformer_repo = os.environ.get('CODEFORMER_REPO', 'https://github.moeyy.xyz/https://github.com/sczhou/CodeFormer.git')

blip_repo = os.environ.get('BLIP_REPO', 'https://github.moeyy.xyz/https://github.com/salesforce/BLIP.git')

Stable Diffusion 2.0/2.1模型的下载和配置

根据官方的信息,2.1版本模型结构和2.0版本一致,因此,两个版本的配置文件是通用的。

2.0版本:

512-base-ema.ckpt (model,config).

2.1版本:

v2-1_768-ema-pruned.ckpt(model,config)

v2-1_512-ema-pruned.ckpt(model,config)

将下载的模型文件和配置文件放到 models/Stable-Diffusion 文件夹中(没有则自行创建)

修改模型文件和配置文件名,确保对应文件名相同,例:如果模型名为768-v-ema.ckpt,则配置文件名应为768-v-ema.yaml

启动安装

上述配置完成后,执行如下命令开始进行安装:

python .\launch.py --xformers

在经历了一段时间的等待,中途可能还会出现网络错误,没关系,多试几次,最终会出现如下的一个地址:

Running on local URL: http://127.0.0.1:7860

To create a public link, set `share=True` in `launch()`.

这就说明本地已经部署成功,打开浏览器,输入上述地址,即可在本地进行AI绘画创作啦。

根据本地电脑显卡的性能强弱,出图速度会有所不同,但是,毕竟是自己电脑,所以慢点也是可以接受的。

关于AI绘画技术储备

学好 AI绘画 不论是就业还是做副业赚钱都不错,但要学会 AI绘画 还是要有一个学习规划。最后大家分享一份全套的 AI绘画 学习资料,给那些想学习 AI绘画 的小伙伴们一点帮助!

👉[[CSDN大礼包:《StableDiffusion安装包&AI绘画入门学习资料》免费分享]](安全链接,放心点击)

对于0基础小白入门:

如果你是零基础小白,想快速入门AI绘画是可以考虑的。

一方面是学习时间相对较短,学习内容更全面更集中。

二方面是可以找到适合自己的学习方案

包括:stable diffusion安装包、stable diffusion0基础入门全套PDF,视频学习教程。带你从零基础系统性的学好AI绘画!

1.stable diffusion安装包 (全套教程文末领取哈)

随着技术的迭代,目前 Stable Diffusion 已经能够生成非常艺术化的图片了,完全有赶超人类的架势,已经有不少工作被这类服务替代,比如制作一个 logo 图片,画一张虚拟老婆照片,画质堪比相机。

最新 Stable Diffusion 除了有win多个版本,就算说底端的显卡也能玩了哦!此外还带来了Mac版本,仅支持macOS 12.3或更高版本。

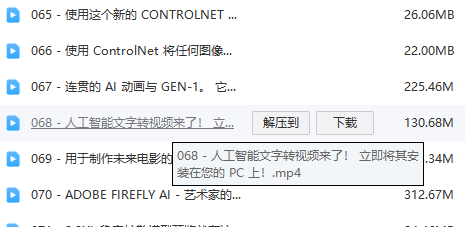

2.stable diffusion视频合集

我们在学习的时候,往往书籍源码难以理解,阅读困难,这时候视频教程教程是就很适合了,生动形象加上案例实战,一步步带你入坑stable diffusion,科学有趣才能更方便的学习下去。

3.stable diffusion模型下载

stable diffusion往往一开始使用时图片等无法达到理想的生成效果,这时则需要通过使用大量训练数据,调整模型的超参数(如学习率、训练轮数、模型大小等),可以使得模型更好地适应数据集,并生成更加真实、准确、高质量的图像。

4.stable diffusion提示词

提示词是构建由文本到图像模型解释和理解的单词的过程。可以把它理解为你告诉 AI 模型要画什么而需要说的语言,整个SD学习过程中都离不开这本提示词手册。

5.SD从0到落地实战演练

如果你能在15天内完成所有的任务,那你堪称天才。然而,如果你能完成 60-70% 的内容,你就已经开始具备成为一名SD大神的正确特征了。

这份完整版的学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?