文章目录

前言

今天我们要聊聊如何通过cpolar内网穿透技术,把国产笔记软件思源和本地的大语言模型Ollama连接起来,轻松实现远程辅助写作。希望这篇文章能给你带来一些实用的启发,帮助你更高效地利用技术提升写作质量!

现在,越来越多的小伙伴在工作和学习中都开始用笔记软件来管理知识和创作。而在这些软件中,思源笔记凭借其强大的编辑功能、灵活的整理方式和丰富的插件支持,成为了大家的心头好。

不过,写作的时候,灵感和创意的激发往往需要大语言模型的助力。大语言模型可以根据海量文本数据生成高质量的内容,为你提供有价值的参考和启发。但传统的在线大语言模型服务可能会面临数据隐私泄露、网络延迟等问题,让一些用户却步。

那么,解决这个问题的办法是什么呢?我们可以考虑将国产软件思源与本地部署的大语言模型Ollama进行对接。Ollama是一款高性能的大语言模型,能够为你提供准确、快速的文本生成服务。但如何实现远程访问和对接,确实是个挑战。

别担心,cpolar内网穿透技术来救场了!cpolar是一种基于反向代理的内网穿透工具,可以将本地计算机的服务暴露到公网上,让外部网络轻松访问。通过cpolar,我们就能把本地部署的Ollama大语言模型服务暴露给远程的思源笔记软件,实现远程对接,助力你的写作之旅!准备好了吗?让我们一起开启这段AI辅助写作的新旅程吧!

1. 下载运行Ollama框架

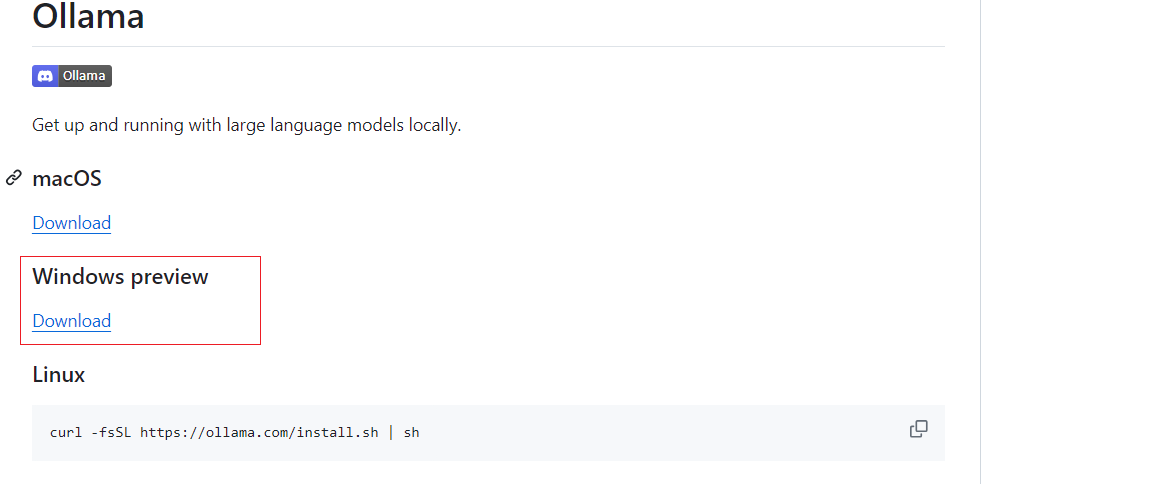

进入Ollama Github 界面:https://github.com/ollama/ollama?tab=readme-ov-file ,我们选择Windows版本下载

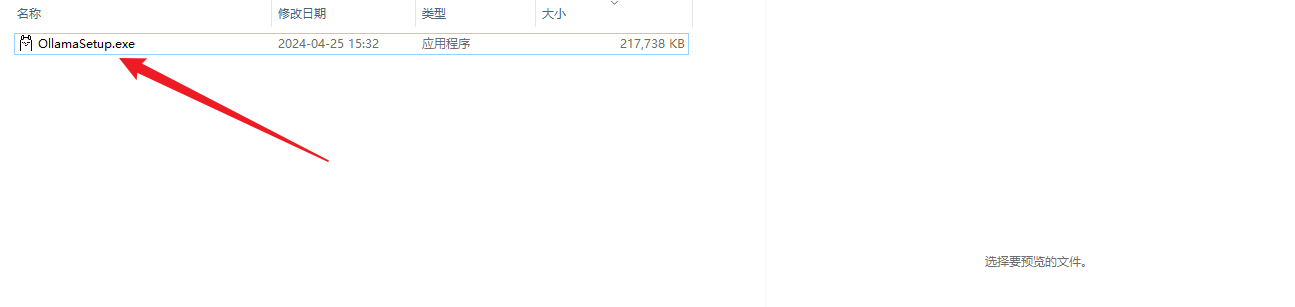

下载后,双击进行安装,默认会安装到C盘,然后等待安装完成,安装完成后正常会自动运行,如果没有运行,可以去应用列表双击运行即可

然后打开命令窗口,输入:ollama -v,可以看到版本信息

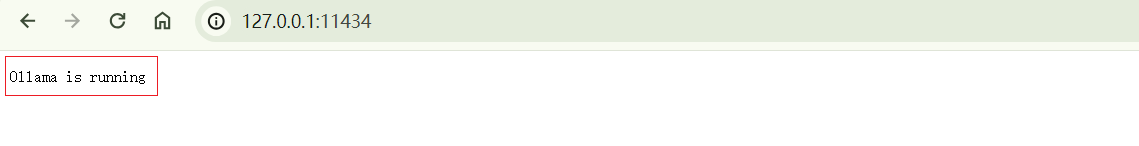

同样,在浏览器输入http://127.0.0.1:11434/访问ollama服务,即可看到,运行的字样,表示本地运行成功了,下面进行安装大语言模型.

2. Ollama下载大语言模型

ollama安装完成后,下面进行下载运行大语

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1922

1922

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?