在这篇文章中,我们将探索如何使用新版的IP-Adapter和ComfyUI软件为人物进行换装。

整个过程非常简单,仅需要两张图片:一张服装图片和一张人物图片。

通过一系列节点的操作,ComfyUI就会把这个服装换到人物身上,并利用FaceDetailer节点来修复任何细微的服装问题。

准备工作流

首先,请确保你已经下载并导入了工作流到你的ComfyUI。需要的小伙伴到文章末尾下载!

如果在导入过程中遇到节点显示为红色色块,并且有弹窗提示缺失特定节点。

请按照以下步骤解决:

1️⃣ 更新ComfyUI: 在开始之前,请确保你的ComfyUI是最新版本,以免下载到过时的IP-Adapter版本。

2️⃣ 安装缺失节点: 打开ComfyUI管理器,选择“安装缺失节点”,并安装以下三个节点:

- ComfyUI Impact Pack

- ComfyUI IPAdapter Plus

- segment anything

3️⃣ 重启ComfyUI: 安装完节点后,点击界面下方的重启按钮。如果重启后一些节点仍显示为红色,不必担心,只需简单刷新一下网页即可解决。

导入和准备图像

为了充分利用提供的工作流并实现人物换装,让我们一步步在ComfyUI中构建所需的操作。我将详细指导你如何加载图像、创建服装遮罩,并最终生成预览图像。

步骤一:加载人物图像

- 打开ComfyUI界面: 进入ComfyUI的主界面。

- 导入图像加载节点: 双击打开搜索栏,输入

load,从搜索结果中选择并导入Load Image节点(加载图像)。 - 上传人物图片: 点击

upload按钮,上传你希望换装的人物图片。

步骤二:创建服装遮罩

- 导入语义分割节点: 双击搜索栏,输入

grounding,选择并导入GroundingDinoSAMSegment节点。 - 加载SAM模型: 需要为语义分割节点提供模型支持。双击并搜索

sammodel,选择SAMModelLoader(SAM模型加载器),然后将这两个节点相连。 - 配置模型: 点击模型名称,在弹出的选项中根据你电脑的配置选择适当的模型。确保设置模型输入词以特定于你要分割的物体(例如“裙子”),以便正确分割。

- 连接图像输入: 将

Load Image节点的输出端口连接到GroundingDinoSAMSegment的图像输入端口。

步骤三:遮罩细化和预览

- 遮罩羽化处理: 为了使遮罩边缘更加自然,双击搜索

feather,导入FeatherMask(遮罩羽化)节点,并将其连接到GroundingDinoSAMSegment。 - 转换遮罩为图像: 为了可视化遮罩效果,双击搜索

convert,选择Convert Mask to Image(遮罩转图像),并将其连接到FeatherMask。 - 生成并查看预览图像: 从

Convert Mask to Image节点拉出PreviewImage(预览图像)节点,生成遮罩图像并查看效果。

完成上述步骤后,你将看到遮罩的图像,它将展示出裙子的具体形状。这个遮罩将用于下一阶段的换装过程,确保新的服装可以精确覆盖在原图的对应部分。

配置IP-Adapter

接下来,我们将详细介绍如何搭建IP-Adapter模块,使用另一张裙子的图片进行人物换装。这部分包含安装必要的模型、导入和连接各种节点,以确保换装过程的顺利进行。

安装必要的模型

- 打开ComfyUI管理器: 进入管理器界面。

- 安装IP-Adapter模型: 点击“安装模型”按钮,搜索“ipadapter”。找到包含“sdxl”字样的三个模型,并点击安装。

- 关闭管理器并刷新界面: 模型安装完成后,关闭管理器并在主界面点击“刷新”按钮以更新设置。

导入服装图片

类似于加载人物图片的步骤,搜索并导入Load Image节点,上传你选择的新服装图片。

设置IP-Adapter

- 导入IP-Adapter节点: 搜索并导入

IPAdapter Advanced节点。 - 导入模型加载器: 搜索

unified,导入IPAdapter Unified Loader,选择“PLUS”预设。 - 连接Checkpoint加载器: 导入并连接Checkpoint加载器到IP-Adapter模型加载器,选择SDXL模型。

配置关注层遮罩和CLIP模型

- 连接遮罩: 将

FeatherMask的MASK输出端口连接到IPAdapter Advanced的attn_mask(关注层遮罩)输入端。这样做是为了明确告诉IP-Adapter应该关注图像中的哪个部分,即在本例中是服装的区域。 - 导入CLIP视觉加载器: 从ComfyUI的节点库中拖出

CLIP Vision Loader(CLIP视觉加载器)。 - 安装CLIP模型:

- 如果尚未安装所需的CLIP模型,打开ComfyUI管理器。

- 在搜索框中输入

clip,搜索相关模型。 - 找到包含

laion2B字样的模型,并进行安装。通常,这些模型针对不同的视觉任务进行了优化,选择合适的模型可以提升处理效果。

- 刷新界面: 安装完毕后,返回主界面并刷新,以确保新安装的模型能够被加载器识别和使用。

- 选择合适的模型: 在CLIP视觉加载器中选择模型名称末尾包含

b79k的模型,这通常表示该模型在特定的数据集或任务上有更好的表现。

设置K采样器与CLIP文本编码器

-

配置K采样器: 在高级版的IP-Adapter节点的模型输出端口拖出一个基础版的K采样器。K采样器在这里用于根据模型指示调整图像的特定区域。

-

连接CLIP文本编码器:

- 从K采样器的"positive"和"negative"输入端拖出两个"CLIP Text Encoder"(CLIP文本编码器),并使用不同颜色标记以便区分。

- 将这些编码器连接到"Load Checkpoint",这一步骤是必要的以确保文本编码器能够加载和处理相关的文本提示,进而影响图像生成过程。

配置VAE编码器和解码器

-

设置VAE编码器:

- 从"latent_image"(潜空间图像)的输出端拖出"用于局部重绘的VAE编码器"。

- 连接此编码器的"pixels"端口到"Load Image",“vae"到"Load Checkpoint”,以及"mask"到"FeatherMask"。这样设置是为了用之前生成的遮罩告诉这个编码器哪个部分需要去噪。

-

激活VAE解码器:

- 从"Latent"端口拖出VAE解码器。

- 将"vae"端口连接到"Load Checkpoint",确保解码器能够正确解析并重建图像。

完善VAE解码过程

- 从K采样器的"LATENT"输出端拖出"VAE Decode"(VAE解码)节点。

- 将解码器的"vae"连接到"Load Checkpoint",以确保能够加载和应用模型参数。

- 从解码器的图像端口拖出"Preview Image"(预览图像)节点,以便生成并查看最终的图像。

应用提示词以精细化控制

- 添加提示词: 在IP-Adapter的相关设置中添加描述服装的提示词,例如"blue dress with floral print"(印花图案的蓝色裙子)。这样做可以帮助模型更精确地理解和实现所需的服装样式和图案。

评估和调整权重类型

1️⃣ 初次评估:

- 生成并查看图像,注意裙子的视觉效果。如果发现裙子显得太平,不具备应有的立体感,这时需要调整权重类型。

2️⃣ 调整权重类型:

- 样式迁移(Style Transfer): 切换到样式迁移权重,再次生成图像以查看改进后的立体感。

- 弱输入(Weak Input): 若立体感仍不足,尝试弱输入权重,这通常使得图案细节更加突出,但可能牺牲一些立体感。

引入FaceDetailer修复服装细节

为了进一步提升换装效果,特别是增强服装的立体感和细节表现,我们将引入"FaceDetailer"节点和服装区域检测功能。以下步骤将指导您如何安装必要模型、配置相关节点,并最终评估优化效果。

安装和配置DeepFashion模型

打开ComfyUI管理器,搜索并安装"DeepFashion"模型,该模型专为服装相关的图像处理优化。

配置FaceDetailer节点

-

导入FaceDetailer节点:

- 导入"FaceDetailer"节点,通常用于修复面部细节,但也适用于服装的细节优化。

-

连接图像和Checkpoint:

- 将"FaceDetailer"的图像端口连接到"VAE Decoder"输出的图像,以接收之前生成的图像。

- 连接"Load Checkpoint"以加载所需的模型参数。

-

配置CLIP文本编码器:

- 可以复用之前用于K采样器的CLIP文本编码器,或者导入新的编码器专用于"FaceDetailer"。使用专用编码器的好处是可以通过定制化的提示词进一步优化服装的视觉效果。

配置服装区域检测节点

-

导入并配置检测器:

- 使用"UltralysticsDetectorProvider"节点来检测服装区域,这有助于精确应用图像处理效果。

- 连接模型并选择"deepfashion"作为源,确保检测精度。

-

设置SAM模型加载器:

- 从"sam_model_opt"端口拖出"SAMLoader(Impact)",选择适合你计算能力的模型配置。

-

导入和配置图像预览节点:

- 导入预览图像节点,以便在处理后直接查看效果。

生成和比较图像

-

生成修复后的图像:

- 运行整个配置,生成经过"FaceDetailer"优化后的图像。

-

对比优化效果:

- 将优化前后的图像并排展示,评估立体感和细节的改善,特别是服装的花朵图案和整体质感。

通过这些步骤,您不仅能够解决原始换装图像中存在的问题,还能显著提升服装的立体感和细节表现,使其看起来更加自然和逼真。

结论

通过以上步骤,你可以成功地为人物换装,并通过IP-Adapter的高级配置实现更自然和精确的视觉效果。这个工作流的构建不仅涉及基本的图片加载和节点连接,还包括对高级模型和编解码器的深入配置,使得整个过程既详细又具有教育意义。

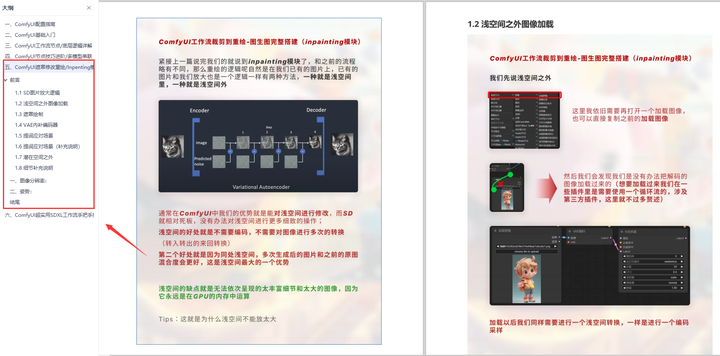

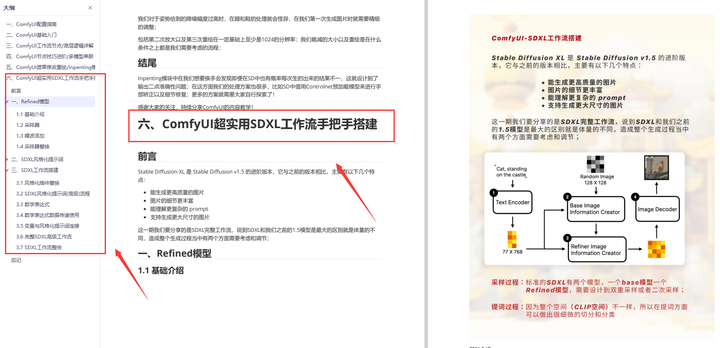

为了帮助大家更好地掌握 ComfyUI,我在去年花了几个月的时间,撰写并录制了一套ComfyUI的基础教程,共六篇。这套教程详细介绍了选择ComfyUI的理由、其优缺点、下载安装方法、模型与插件的安装、工作流节点和底层逻辑详解、遮罩修改重绘/Inpenting模块以及SDXL工作流手把手搭建。

这份完整版的资料我已经打包好,点击下方添加即可免费领取!

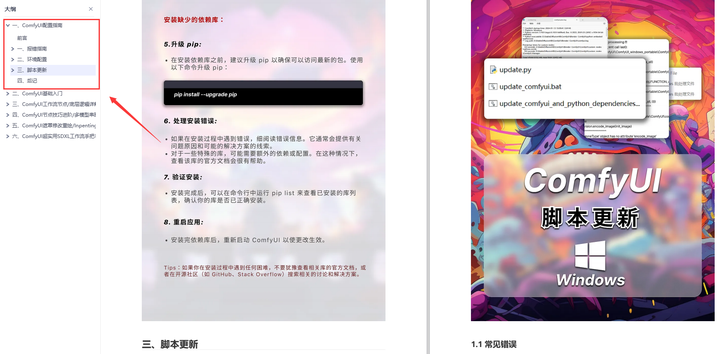

一、ComfyUI配置指南

- 报错指南

- 环境配置

- 脚本更新

- 后记

- …

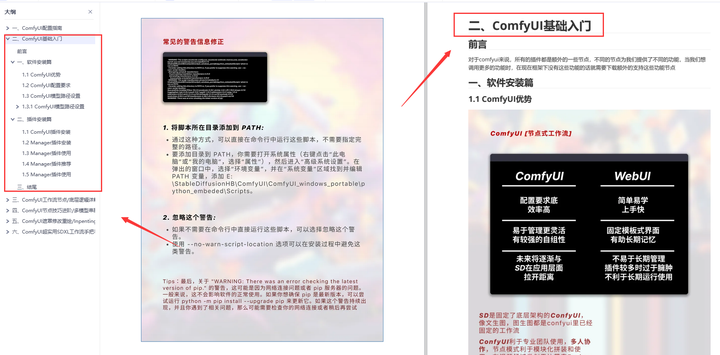

二、ComfyUI基础入门

- 软件安装篇

- 插件安装篇

- …

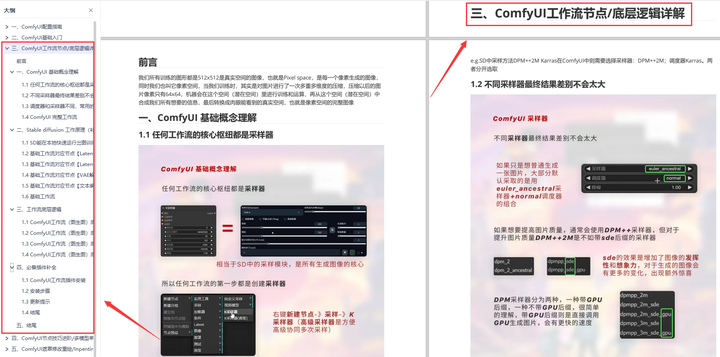

三、 ComfyUI工作流节点/底层逻辑详解

- ComfyUI 基础概念理解

- Stable diffusion 工作原理

- 工作流底层逻辑

- 必备插件补全

- …

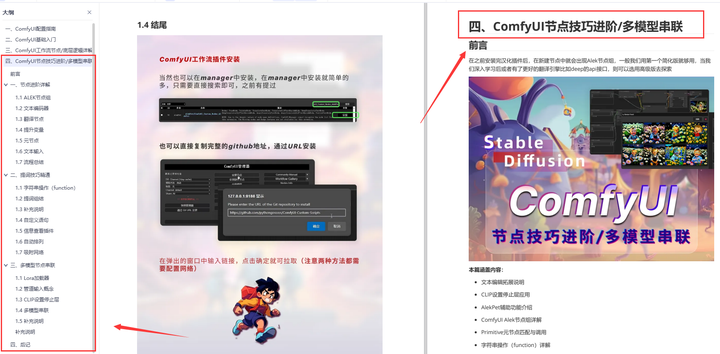

四、ComfyUI节点技巧进阶/多模型串联

- 节点进阶详解

- 提词技巧精通

- 多模型节点串联

- …

五、ComfyUI遮罩修改重绘/Inpenting模块详解

- 图像分辨率

- 姿势

- …

六、ComfyUI超实用SDXL工作流手把手搭建

- Refined模型

- SDXL风格化提示词

- SDXL工作流搭建

- …

这份完整版的资料我已经打包好,点击下方添加即可免费领取!

2368

2368

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?