关注公众号,发现CV技术之美

本文转自机器之心。

该论文作者均来自于新加坡南洋理工大学 S-Lab 团队,包括博士后胡涛,博士生洪方舟,以及计算与数据学院刘子纬教授(《麻省理工科技评论》亚太地区 35 岁以下创新者)。S-Lab 近年来在顶级会议如 CVPR, ICCV, ECCV, NeurIPS, ICLR 上发表多篇 CV/CG/AIGC 相关的研究工作,和国内外知名高校、科研机构广泛开展合作。

三维数字人生成和编辑在数字孪生、元宇宙、游戏、全息通讯等领域有广泛应用。传统三维数字人制作往往费时耗力,近年来研究者提出基于三维生成对抗网络(3D GAN)从 2D 图像中学习三维数字人,极大提高了数字人制作效率。

这些方法往往在一维隐向量空间建模数字人,而一维隐向量无法表征人体的几何结构和语义信息,因此限制了其生成质量和编辑能力。

为了解决这一问题,来自新加坡南洋理工大学 S-Lab 团队提出结构化隐空间扩散模型(Structured Latent Diffusion Model)的三维数字人生成新范式 StructLDM。该范式包括三个关键设计:结构化的高维人体表征、结构化的自动解码器以及结构化的隐空间扩散模型。

StructLDM 是一个从图像、视频中学习的前馈三维生成模型(Feedforward 3D Generative Model),相比于已有 3D GAN 方法可生成高质量、多样化且视角一致的三维数字人,并支持不同层级的可控生成与编辑功能,如局部服装编辑、三维虚拟试衣等部位感知的编辑任务,且不依赖于特定的服装类型或遮罩条件,具有较高的适用性。

论文标题:StructLDM: Structured Latent Diffusion for 3D Human Generation

论文地址:https://arxiv.org/pdf/2404.01241

项目主页:https://taohuumd.github.io/projects/StructLDM

实验室主页:https://www.ntu.edu.sg/s-lab

方法概览

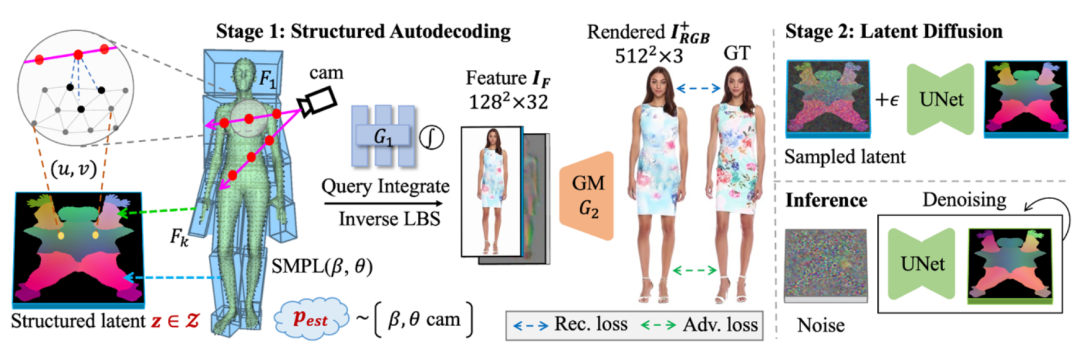

StructLDM 训练过程的包含两个阶段:

结构化自动解码:给定人体姿态信息 SMPL 和相机参数,自动解码器对训练集中每个人物个体拟合出一个结构化 UV latent。该过程的难点在于如何把不同姿态、不同相机视角、不同着装的人物图像拟合到统一的 UV latent 中,为此 StructLDM 提出了结构化局部 NeRF 对身体每个部位分别建模,并通过全局风格混合器把身体各部分合并在一起,学习整体的人物外观。此外,为解决姿态估计误差问题,自动解码器训练过程中引入了对抗式学习。在这一阶段,自动解码器把训练集中每个人物个体转化为一系列 UV latent。

结构扩散模型:该扩散模型学习第一阶段得到的 UV latent 空间,以此学习人体三维先验。

在推理阶段,StructLDM 可随机生成三维数字人:随机采样噪声并去噪得到 UV latent,该 latent 可被自动解码器渲染为人体图像。

实验结果

该研究在 4 个数据集上进行了实验评估:单视角图像数据集 DeepFashion [Liu et al. 2016],视频数据集 UBCFashion [Zablotskaia et al. 2019],真实三维人体数据集 THUman 2.0 [Yu et al. 2021], 及虚拟三维人体数据集 RenderPeople。

3.1 定性结果比较

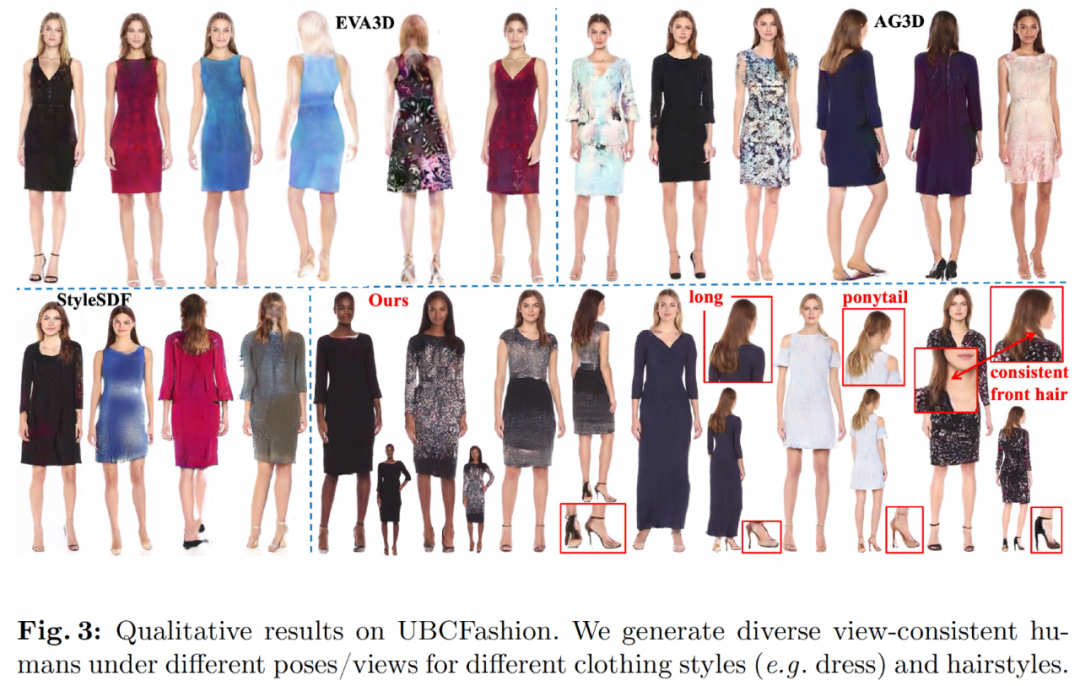

StructLDM 在 UBCFashion 数据集上与已有 3D GAN 方法做了对比,如 EVA3D、 AG3D 及 StyleSDF。相比于已有方法,StructLDM 可生成高质量、多样化、视角一致的三维数字人,如不同肤色、不同发型,以及服饰细节(如高跟鞋)。

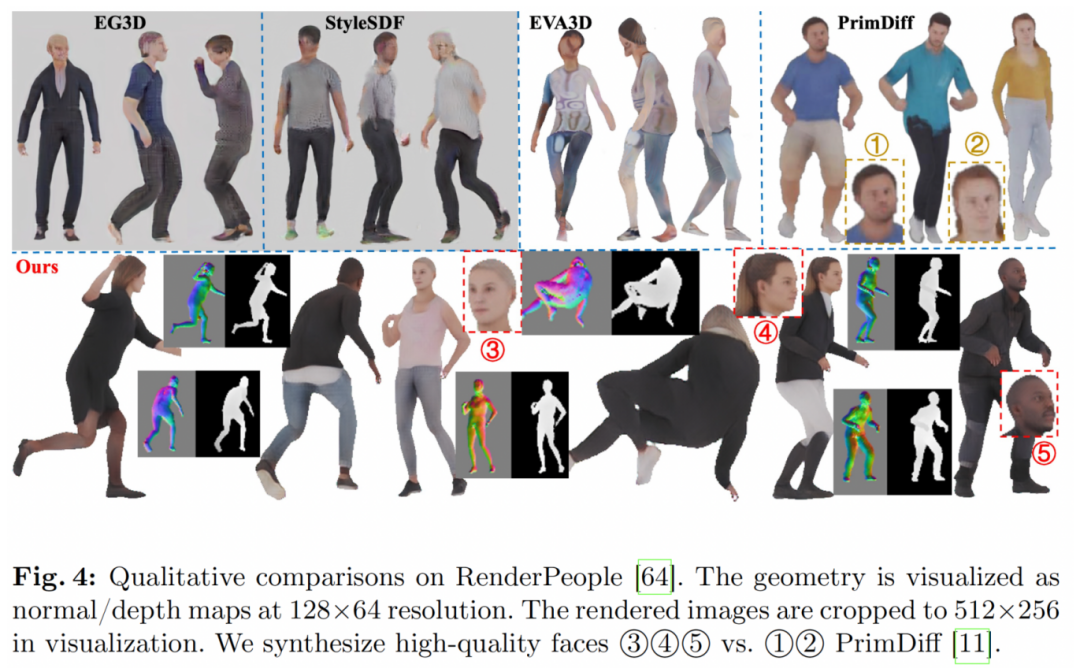

StructLDM 在 RenderPeople 数据集上与已有 3D GAN 方法(如 EG3D, StyleSDF, 及 EVA3D)及扩散模型 PrimDiff 对比。相比于已有方法,StructLDM 可生成不同姿态、不同外观的高质量三维数字人,并生成高质量面部细节。

3.2 定量结果比较

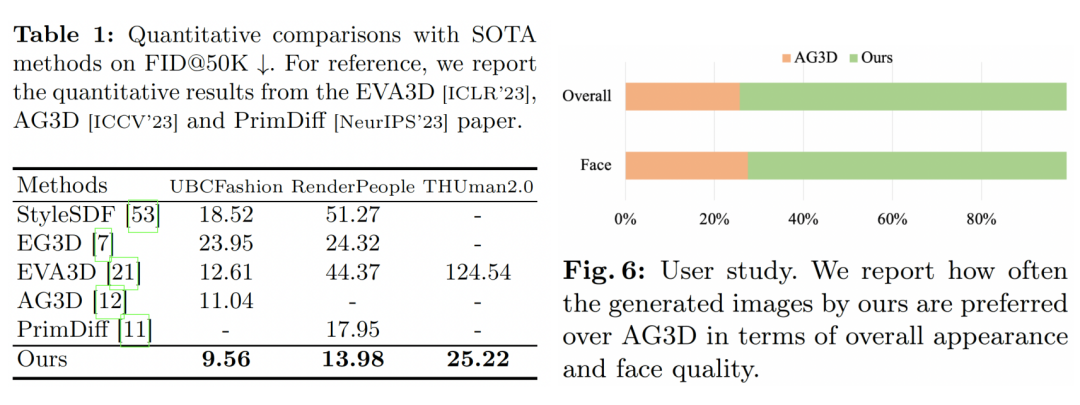

研究者在 UBCFashion, RenderPeople,及 THUman 2.0 上与已知方法做了定量结果比较,在每个数据集上随机选取 5 万张图像计算 FID ,StructLDM 可大幅降低 FID。此外,User Study 显示大约 73% 的用户认为 StructLDM 生成的结果在面部细节和全身图像质量上比 AG3D 更有优势。

3.3 应用

3.3.1 可控性生成

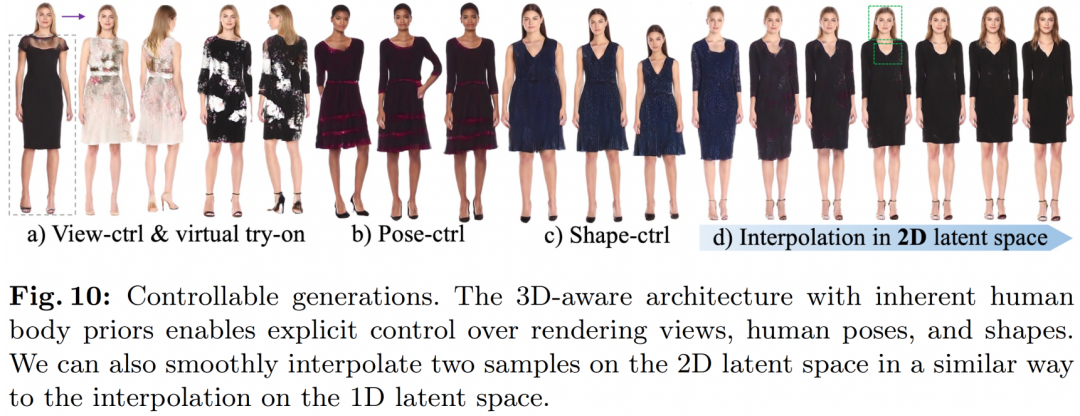

StructLDM 支持可控性生成,如相机视角、姿态、体型控制,以及三维虚拟试衣,并可在二维隐空间插值。

3.3.2 组合式生成

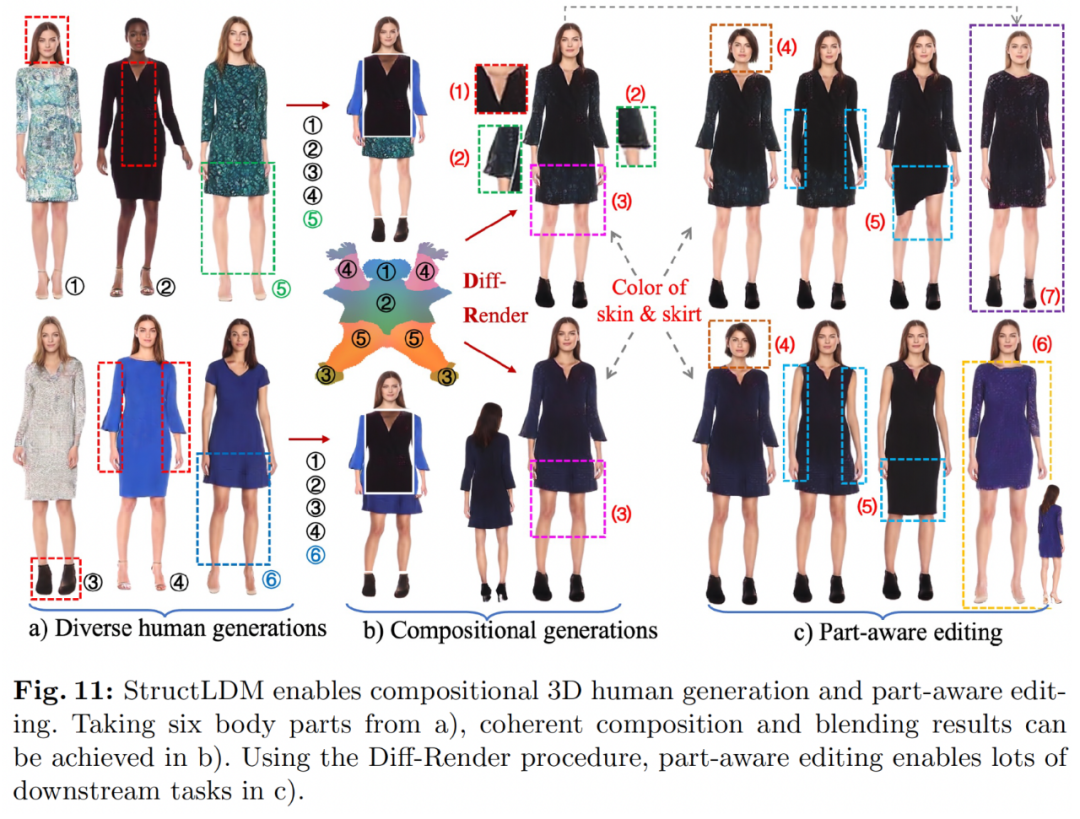

StructLDM 支持组合式生成,如把①②③④⑤部分组合起来可生成新的数字人,并支持不同的编辑任务,如身份编辑、衣袖(4)、裙子(5)、三维虚拟试衣(6)以及全身风格化(7)。

3.3.3 编辑互联网图片

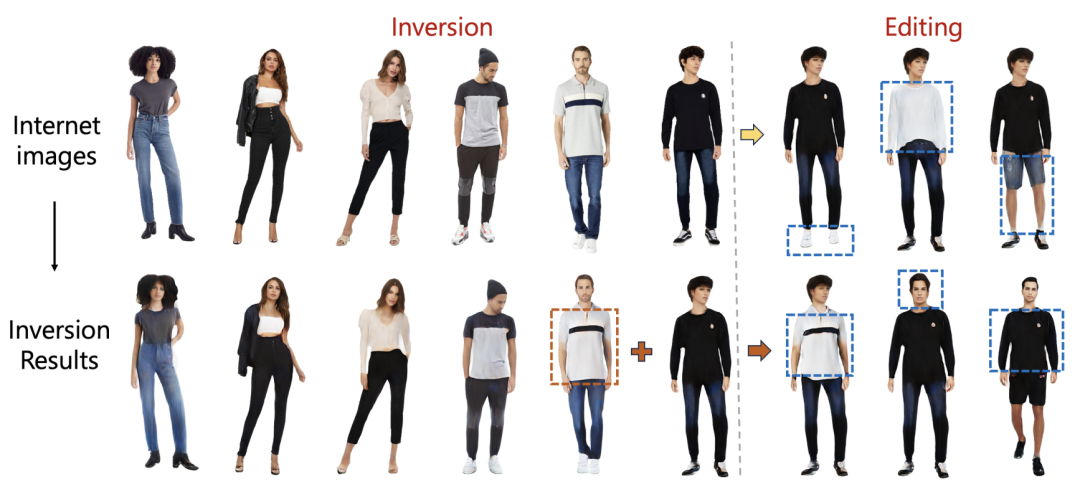

StructLDM 可对互联网图片进行编辑,首先通过 Inversion 技术得到对应的 UV latent,然后通过 UV latent 编辑可对生成的数字人进行编辑,如编辑鞋、上衣、裤子等。

3.4 消融实验

3.4.1 隐空间扩散

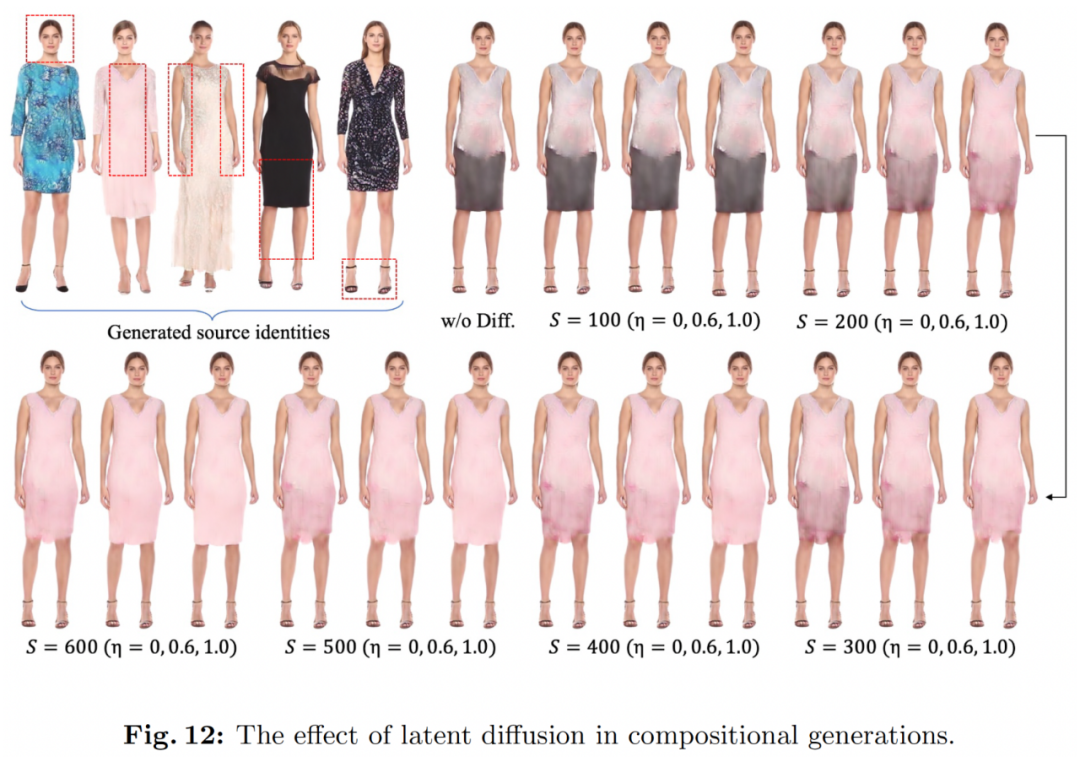

StructLDM 提出的隐空间扩散模型可用于不同编辑任务,如组合式生成。下图探究了扩散模型参数(如扩散步数和噪声尺度)对生成结果的影响。StructLDM 可通过控制扩散模型参数来提高生成效果。

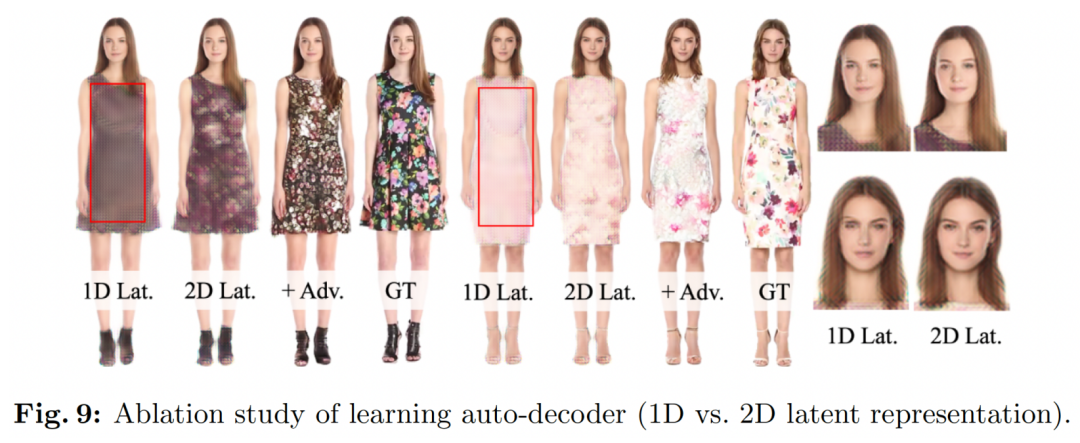

3.4.2 一维与二维人体表征

研究者对比了一维与二维 latent 人体表征效果,发现二维 latent 可生成高频细节(如衣服纹理及面部表情),加入对抗式学习可同时提高图片质量和保真度。

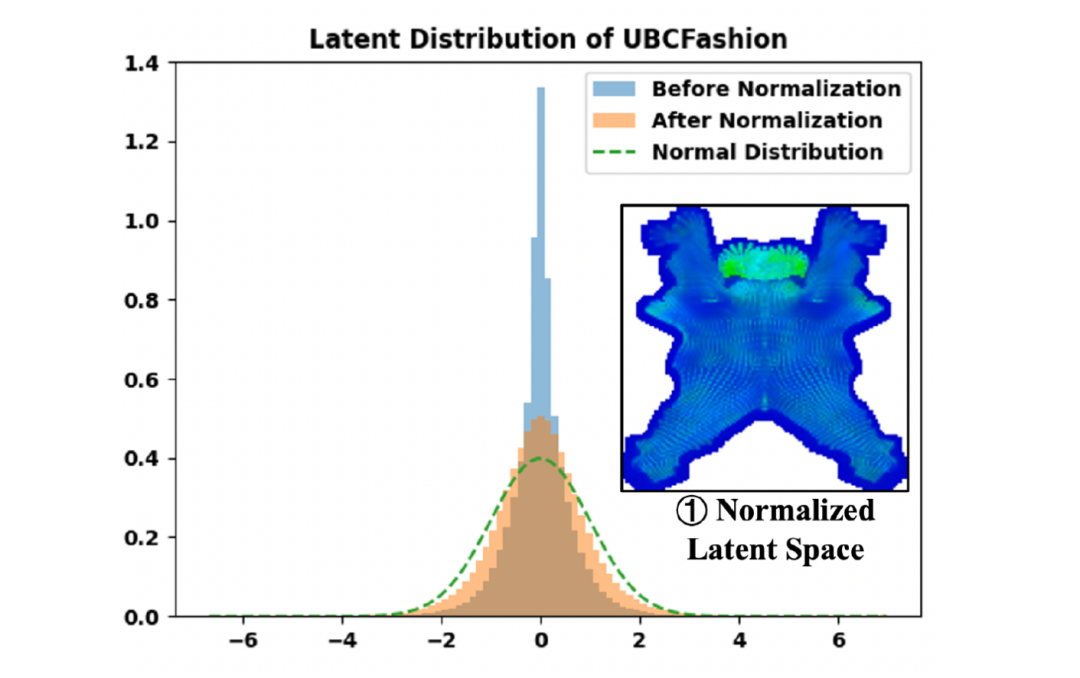

3.4.3 结构感知的归一化

为提高扩散模型学习效率,StructLDM 提出了结构感知的 latent 归一化技术 (structure-aligned normalization),即对每个 latent 做逐像素归一化。研究发现,归一化后的 latent 分布更接近于高斯分布,以此更利于扩散模型的学习。

END

欢迎加入「人体合成」交流群👇备注:人体

4386

4386

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?