L o L_o Loonie:Compressing COINs with Lo-constraints

Note:Loonie is a colloquial name for the Canada one dollar coin

科研狗真的很有意思,人家用COIN你用Loonie,我该用什么?钢蹦子?

Paper:https://arxiv.org/abs/2207.04144

Code:https://github.com/juan43ramirez/l0onie

2022/7/13:附录之类的后面有空再补吧,写的感觉乱七八糟的,难道是我的问题吗?

Abstract

内隐神经表征(INR)的发展推动了领域不可知论压缩技术的研究。这些方法通过训练神经网络来逼近目标,然后存储训练后模型的权值。例如,给定一幅图像,训练网络学习从像素位置到RGB值的映射。在本文中,我们提出了一种稀疏性约束的COIN压缩方法的扩展L0onie。稀疏性允许利用过度参数化网络的更快学习,同时保留较小模型的理想压缩率。此外,我们的约束公式确保最终模型遵守预先确定的压缩率,免去了昂贵的架构搜索的需要。

1. Introduction

隐式神经表示(INRs)训练神经网络映射坐标(如像素位置)到特征(如RGB值),以便近似给定的对象。INRs已广泛应用于音频[23]、图像[24]、视频[16]、3D场景等多种数据模式和温度场[7]。INRs为数据压缩提供了一个新的视角:与其处理对象的“原始”特征,不如训练INR来近似对象并存储学习模型的参数。COIN[5]首创了这种图像压缩方法。

基于inr的压缩是一项新兴技术。与特定领域的编解码器相比,COIN表现出较差的性能和更密集的计算成本。此外,它通常需要架构搜索来平衡模型容量与重构质量之间的关系。尽管在音频或图像压缩等研究领域,这些技术还不能与已有的编解码器竞争,但像COIN这样的方法更大的希望在于它们能够提供几乎适用于任何数据模式的压缩标准。

最近的研究[6,14,22]专注于通过元学习方法改进COIN,在这种方法中,基础网络在大量数据点集合上(预先)训练,以便快速找到与实例相关的INRs。编码单个实例的任务被转换为搜索基本架构上的调制[21]。

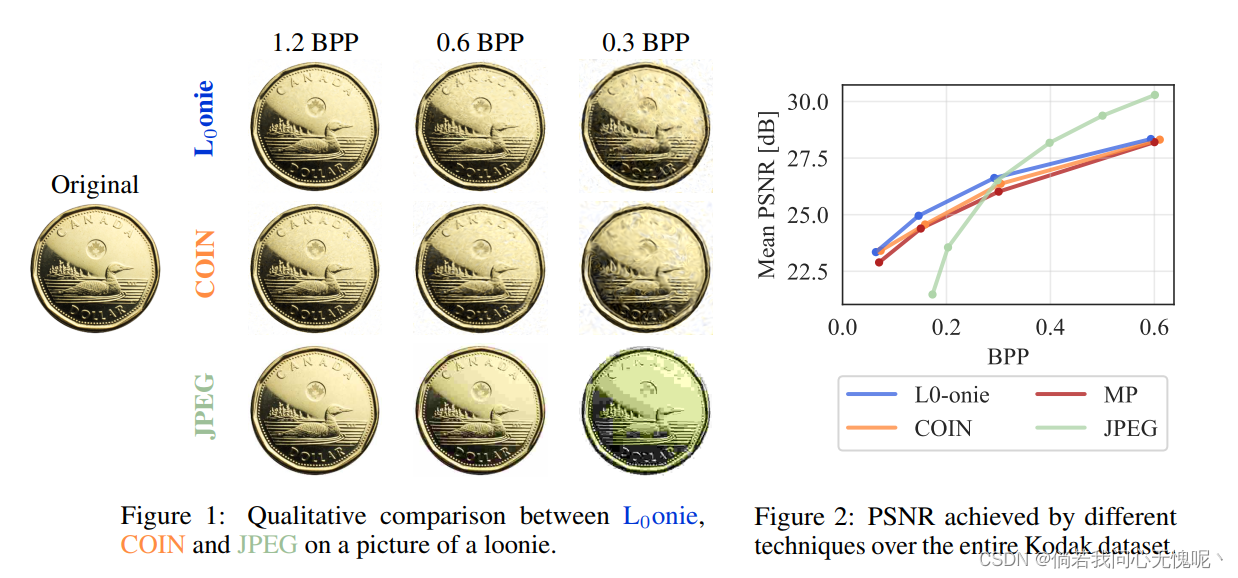

在这项工作中,我们集中在模型大小之间的相互作用,其表征能力和所需的训练时间。在L0onie*中,我们将“过度参数化”的COIN模型与稀疏Louizos等人的再参数化方法相结合。**这使我们能够利用更大模型的能力,实现更好、更快的重建;而不需要承诺他们不期望的压缩率。我们利用这些较大模型中固有的冗余,并在训练过程中对其进行稀疏化,以达到预先指定的压缩率。我们的约束公式提供了对结果压缩率的直接控制,并消除了昂贵的超参数调优或架构搜索的需要。**图1提供了L0onie,COIN和JPEG在不同Bpp下的压缩概况。

2. Implicit Neural Representations

为了简单起见,我们使用图像处理术语来描述INRs。然而,我们强调,INRs原则上与手头的“数据类型”无关。(请注意,模型体系结构和激活函数的选择可能不适用于所有数据模式)将被压缩的图像视作坐标点的集合

x

p

∈

[

−

1

,

1

]

2

x_p \in [-1,1]^2

xp∈[−1,1]2和相应RGB像素强度的集合

y

p

∈

[

0

,

1

]

3

y_p \in [0,1]^3

yp∈[0,1]3,对离散像素集合P进行索引。

考虑一个神经网络族

f

θ

:

R

2

→

R

3

f_\theta: \R^2 \to \R^3

fθ:R2→R3,其参数为

θ

\theta

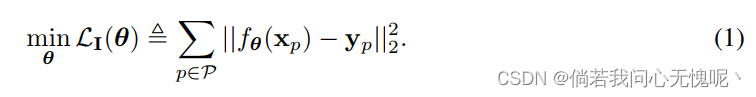

θ。图像I的隐式神经表示(INR)可以以下监督学习问题的一个解:

在解决优化问题后,可以通过在像素位置

P

P

P处求函数

f

θ

f_\theta

fθ来(近似)重构原始图像。模型族的选择对重建性能有很大的影响,是一个活跃的研究领域。最近的建议将全连接模型与位置嵌入[25]或正弦激活函数[23]结合起来。

Dupont等人[5]提出了COIN作为一种创造性的图像压缩方法:在压缩图像I时,存储I的一个INR的权重,而不是RGB值。在这项工作中,我们遵循COIN使用正弦激活函数选择的MLPs。率-失真权衡涉及到平衡大型模型较高的表达能力与更多的模型参数对压缩率的不利影响。在保持低失真的同时实现特定的压缩率可能涉及耗时的架构搜索。

2.1 Sparsifying INRs

考虑到使用COIN压缩图像已经比标准方法需要更多的时间,比如JPEG(几个数量级),取消对架构搜索的需求是朝着更广泛采用基于inr的压缩迈出的重要一步。稀疏技术是解决这个问题的自然方法。基于幅度的剪枝可用于获得特定的压缩率,但即使在微调后也会导致次优性能(参见第3节)。在其他机器学习任务中流行的基于启发式的稀疏性方法所做的假设可能不能很好地转移到INRs的环境中。(Note:基于幅度的剪枝依赖于低范数参数对最终预测的影响较小的思想。这已经在图像分类任务中得到了经验证明,在这些任务中,模型预测了离散数量的类中的一个标签[15,8]。我们假设,量级剪枝在我们的实验中表现欠佳可能是由于模型中使用了正弦激活和目标的连续性。)

Louizos等人[17]提出了一种学习稀疏模型的框架,方法是对模型权重进行可微的重新参数化 θ = θ ^ ⊙ z \bf{\theta}=\hat{\theta} \odot z θ=θ^⊙z,其中 θ ^ \hat{\theta} θ^是自由(有符号)参数幅值, z \bf{z} z是表示某个参数是否激活的随机门。这个门函数遵循含有参数 ϕ \phi ϕ的Hard-concrete分布。然后,作者用门函数的期望L0范数给出的附加惩罚来增强通常的训练目标,以鼓励模型中的稀疏性。

我们建议将MLPs与COIN的正弦激活与L0重新参数化相结合。这种稀疏性视角为训练“过度参数化”的模型打开了大门,从而可以实现更好的性能,更快的[1]。此外,在训练过程中学习稀疏模式可以避免完全密集模型的低压缩率。

同样的重新参数化也用于Schwarz和Teh[22]的并行工作,尽管其动机不同。虽然作者就元学习管道中的稀疏性集成提供了有价值的见解,他们忽略了调整超参数 λ p e n \lambda_{pen} λpen的挑战,这决定了稀疏项的相对重要性。调整λpen以实现特定的压缩率可能与执行架构搜索一样令人望而却步[2,10]。

请注意,随机再参数化诱导了模型的分布。由于实际原因,在解码时使用单一模型是很方便的。我们使用门中位数 z ^ ( ϕ ) ∈ [ 0 , 1 ] \hat{\bf{z}}(\phi) \in [0,1] z^(ϕ)∈[0,1]来构建该模型。由于Hard-concrete分布中的“拉伸”,中位数可能恰好是0或1,而不仅仅是小数。详见附录A。

2.2 L 0 L_0 L0-constrained formulation

Gallego-Posada等人[10]认为,在学习稀疏神经网络时,与常用的惩罚方法相比,约束公式可以提供更好的超参数可解释性和可控性。作者利用Louizos等人[17]的重新参数化考虑了参数的期望l0范数的约束。我们通过使用代理约束[4] 来扩展它们的约束公式来直接控制结果模型的压缩率(参见附录B)。

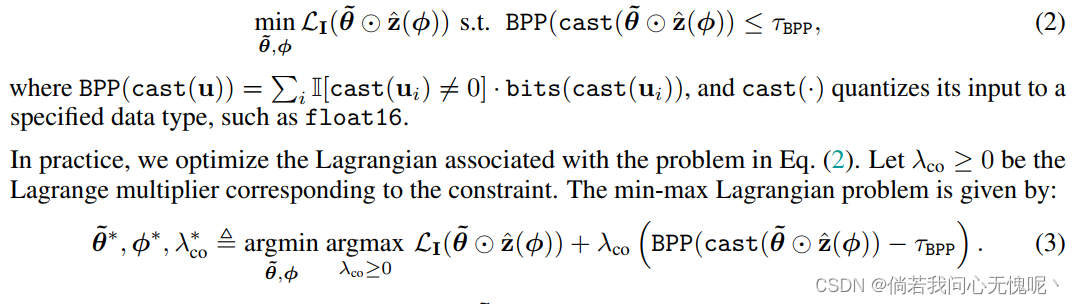

在给定压缩率的约束条件下,我们考虑为一个图像寻找一个稀疏INR的问题,该约束条件以每像素的预算

τ

B

P

P

\tau_{BPP}

τBPP比特表示。我们观察到在使用随机门蒙特卡洛样本进行训练时性能下降,就像Louizos等人[17]所做的那样。因此,我们使用门中值训练一个确定性模型。此设置与上述解码时间模型一致。(这一段没有看懂是什么意思,上述解码时间是在哪里说了)形式上,我们考虑以下约束优化问题:

(BPP(cast())计算所有经过门函数影响后的参数所占用的bpp,计算一个平均的bpp满足条件,cast()也将参数量化到float16。公式2的问题可以使用拉格朗日乘数法,使

λ

c

o

≥

0

\lambda_{co} \geq 0

λco≥0,则该问题变为一个min-max拉格朗日问题。)

我们使用同步 ( θ ~ , ϕ ) (\tilde{\theta},\phi) (θ~,ϕ)梯度下降和 λ c o \lambda_{co} λco投影( R + \R^+ R+)梯度上升。(这一句也没有看懂,没有经过评审的英文文章看起来真的太难受了。)注意,与惩罚式(约束的乘数因子是固定的)不同,这里的乘数因子在整个优化过程中是动态调整的。如附录B所述,当中位数在0或1处饱和时,它们面临可微性问题。因此,我们采用预期 B P P ( θ ~ ⊙ z ˉ ( ϕ ) ) BPP(\tilde{\theta} \odot \bar{\bf{z}}(\phi)) BPP(θ~⊙zˉ(ϕ))作为代理约束[4]来计算原始参数更新的梯度。

我们的约束公式赋予了对最终模型的压缩率的直接控制。这提供了一种算法方法来保持最佳性能并实现特定目标BPP,而不需要对超参数 λ p e n \lambda_{pen} λpen或模型架构进行搜索。

3. Experiments

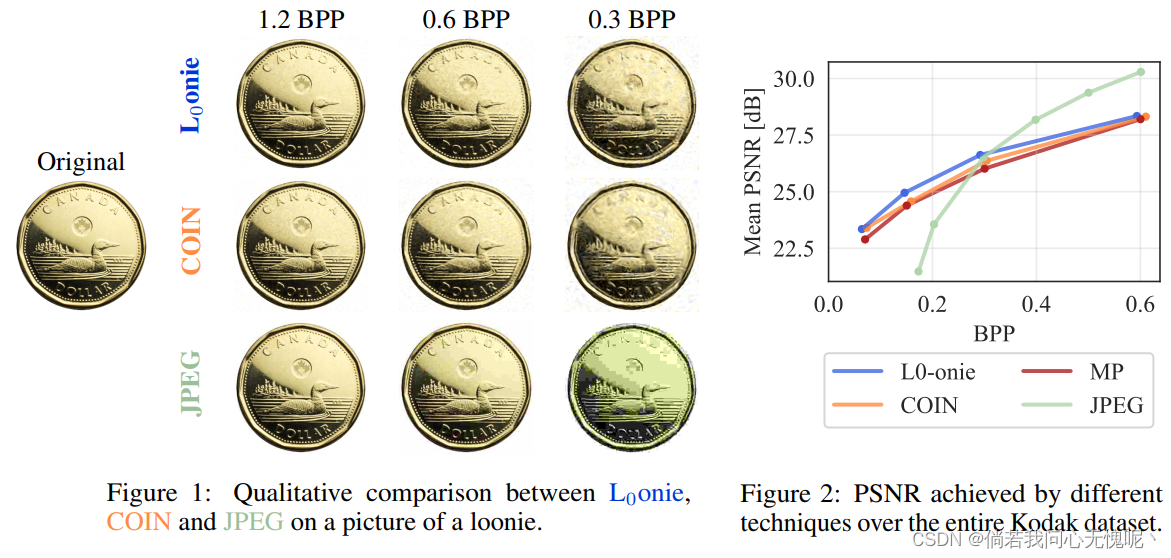

我们在24张大小为768×512的柯达图像数据集[13]上进行实验。我们比较了我们的方法与各种图像压缩技术:COIN[5],非结构化幅度剪枝与微调和JPEG[26]。关于实现和超参数配置的详细信息可以在附录c中找到。附录D给出了综合实验和定性比较。

我们使任务的难度在各种技术中相等。例如,对于BPP预算为0.3的情况,我们训练维度为2-10x[28]-3的COIN模型。因此,COIN模型是完全密集的,并且有一个固定的BPP在训练。由于L0onie和量级修剪删除了一些参数,我们从较大的模型中初始化它们,并要求它们交付一个BPP为0.3的最终模型。每个预算的实验设置在附录C中提供。

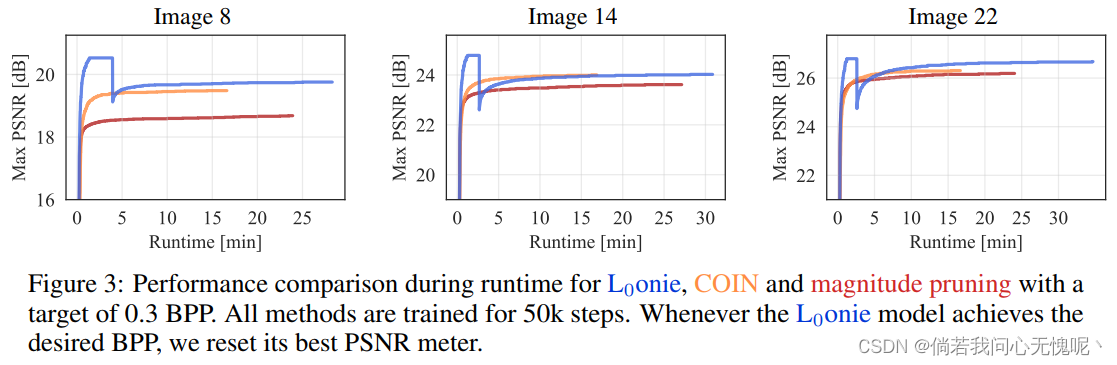

基准性能: 图2显示了在不同BPP预算下所有方法的性能,幅度剪枝的性能始终低于所有其他方法,都是在修剪之后立即进行的(见图3)和微调后。考虑到我们从一个更大的、完全训练的COIN模型中初始化大小修剪,这是值得注意的。L0onie的表现略高于COIN。另一方面,虽然JPEG在高压缩率下挣扎,但它在较大的bpp上显然占主导地位;与其他技术相比,它的压缩时间可以忽略不计。

图3显示了压缩模型的PSNR作为训练时间的函数。正如预期的那样,更大的L0onie模型能更快地实现更好的重建。然而,回想一下原始L0onie模型的压缩率更差。为了确保公平的比较,一旦L0onie实验满足BPP约束,我们就会刷新PSNR指标——这标志着最大PSNR指标的下降。(就是说Loonie其实开始是在一个更大的模型上跑的,然训练过程中先达到一个好的训练结果,然后进行一次稀疏化模型减小,然后再微调得到结果。)

一旦L0onie模型变得可行,它们就会迅速匹配甚至超越COIN的性能。尽管对于更大的Loonie模型每个单独的梯度步骤需要更多的时间,L0onie方法还是达到了相比COIN更快的训练速度和更好的PSNR。请注意,对于与COIN相同的实际时间预算,L0onie在遵循BPP约束的情况下实现了可比或更高的PSNR。

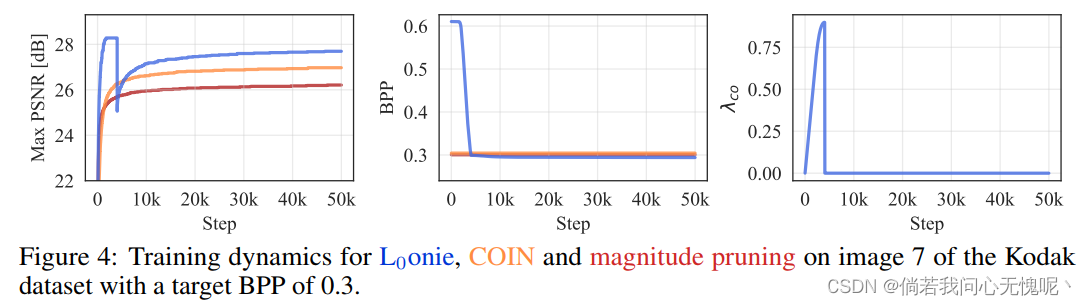

训练动态: 图4说明了所有方法的训练动态。我们将COIN和幅度剪枝实验作为基线,其BPP在训练过程中是固定的。这些技术表现出类似的行为,快速的初始增长,随后是一个缓慢的饱和期。

L0onie从一个具有不可行的BPP的模型初始化。这就产生了训练之初拉格朗日乘数的增长。反过来,不断增长的乘数发挥作用,导致优化权衡重构性能,以降低模型的BPP。注意,这种可行性在训练中相对较早地获得。在PSNR最初下降后,现在可行的模型可以专注于优化重构性能。我们观察到一旦可行,L0onie模型的PSNR很快恢复并超过了COIN模型。

注意,在达到可行性后,L0onie模型的BPP统计数据几乎没有变化。因此,优化是有效地发生在一个特定的子网。在这个阶段修剪网络和“融合”门和重量可以允许更有效的训练。当使用结构化稀疏性时,这些收益可能会特别显著,这超出了我们的工作范围。(就是在单次优化后模型就固定下来了,再修剪网络,网络变小了训练起来会更快。这里没有使用结构化稀疏性,作者说做结构化稀疏性可能能达到更好的效果。)

4. Limitations and Future work

最近的研究通过考虑元学习框架提高了COIN的效率[6,14]。正如Schwarz和Teh[22]所证明的,稀疏性和元学习是改善基于inr压缩的互补途径。尽管我们的约束方法具有可控性优势,但需要进一步的研究来理解INRs的优化动态,包括在约束和无约束的设置。

为了简单起见,我们在本工作中集中讨论了非结构化稀疏情况。然而,由结构化稀疏性(例如,在共享门下分组与输入神经元相关的所有权值)产生的压缩增益可能更“臭名昭著”,更容易实现。在训练过程中,这一点尤为重要:一旦INR变得稀疏,它的未使用参数可以被删除,以实现更快的训练。

最后,我们的稀疏性约束公式可以支持模型的渐进稀疏化,以达到不同的压缩率。一旦一个模型达到了预期的BPP,这个模型就可以以一种直接的方式作为起点,获得具有更高压缩率的INRs。目前还不清楚如何使用普通COIN模型或惩罚L0配方实现这种逐步稀疏化,同时可靠地控制产生的压缩率。

5. Conclusion

我们提出L0onie,一种使用约束公式训练的COIN模型的稀疏扩展。我们的方法允许利用超参数化网络的更快学习,同时尊重所需的压缩率,而不需要昂贵的超参数调优或架构搜索。

14万+

14万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?