作者利用人工智能创建的图像

在长篇故事格式中,你必须为你的角色设置一个图表。——Sunil Grover

大型语言模型 (LLM)已经展现出令人难以置信的能力,这些能力最近已经扩展到文本之外。一方面,我们已经见证了多模态模型(例如,视觉语言模型);另一方面,我们见证了模型能力扩展到需要推理比如我们现在有专门用来解决数学问题或者编写代码的模型。

然而,最近另一种类型的数据引起了研究人员的注意。事实上,现实世界中的大量数据都可以用图形的形式表示。例如,社交网络就是以图形形式构建的数据,因为表示各种实体之间的关系非常重要。这不是唯一的例子:在生物医学中,通常用图形表示分子和蛋白质之间的相互作用。然而,LLM 和图形之间的相互作用是最近的历史。最近的一系列研究表明知识图谱(或潜在的其他图形)如何用于检索增强生成 (RAG)框架,在该框架中可以找到实体和关系并将其用作 LLM 的输入。

图形和矢量 RAG 的融合:信息检索的新时代

利用混合模型的力量来转变人工智能驱动的知识系统

GraphRAG:结合检索和摘要

增强大型语言模型,以便在大量文本语料库中回答复杂的问题

尽管图谱越来越重要,但关于 LLM 如何理解图谱数据的研究却落后了。人们更关注 LLM 与知识图谱 (KG) 的交集,而不是 LLM 对图谱数据的理解。

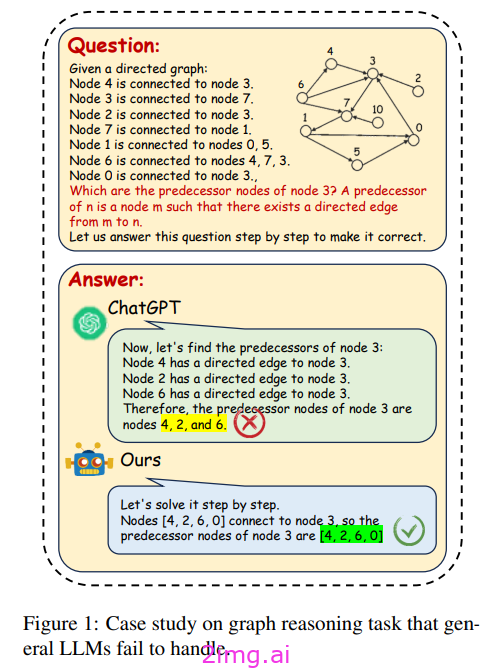

图片来源:[6]

先前的研究表明,LLM 在结构理解方面表现不佳,以至于在遇到表格时表现不佳。然而,图表增加了一个额外的复杂性维度。

LLM 如何处理图表?他们能够理解结构信息吗?

例如,这项研究 [1] 指出 LLM 在基本图形任务上表现不佳(尤其是当 LLM 必须确定是否存在循环或是否存在边时)。LLM 的表现比他们选择的基线更差。原因之一是不同的图形编码函数对 LLM 推理有显著影响。这是因为 LLM 本身并不将图形作为输入。因此,将提示中的图形编码为邻接矩阵有利于模型对某些任务的推理,但会削弱其对其他任务的能力。事实上,每种不同的编码都允许模型访问影响其推理能力的不同结构信息。

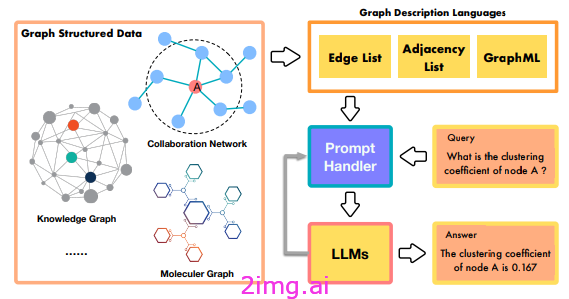

图片来源:[2]

Graph ML:图形的简单介绍

深入了解这些神秘的生物。

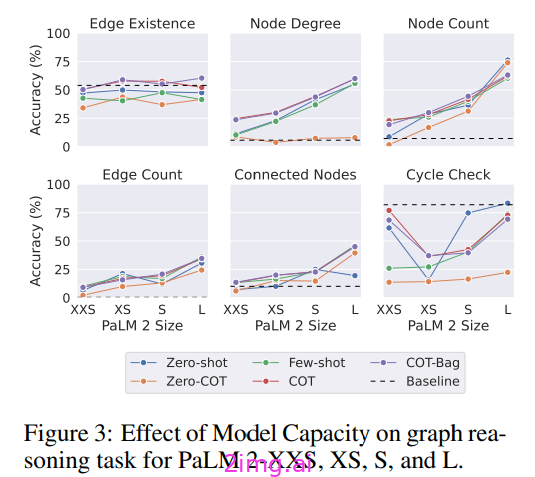

另一方面,不同的提示工程技术可以提高 LLM 解决某些图形任务的能力。因此,诸如思路链或小样本提示之类的技术可以帮助提高性能。然后,可以为图形任务设计特定的提示以进一步改进 [1–2]

图片来源:[1]

这些提示技术对于简单问题仍然有效,但对于复杂问题,其效果会大大降低。因此,一些作者尝试在图数据上微调模型 [7–8]。虽然这些方法很有前景,但结果仍有待显著改善。

为什么法学硕士 (LLM) 会面临结构性问题?

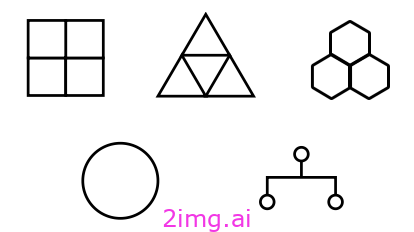

我们真的不知道。一种假设是,LLM 难以理解空间概念。对于动物和人类来说,构建思维导图以与物理世界互动非常重要。人类使用这些认知地图来规划路线、寻找捷径或决定如何与外界互动。此外,这些地图代表抽象知识和推理。LLM 不与物理世界互动,但根据一种理论,人类只是从一系列观察中学习这些地图 [3–5]。在这项研究 [3] 中,他们研究了 LLM 的空间理解能力,设计了需要准确表示底层空间关系(正方形、六边形和三角形、环和树形拓扑)的导航任务。LLM 展示了对空间地图的一些隐性理解,但在处理复杂布局时遇到困难。事实上,该模型有时不理解相对位置(如何解释“左”或“右”)。其次,LLM 是在大量文本上进行训练的,而这些文本不太强调空间意识。

图片来源:[3]

缺乏空间理解直接影响了他们理解图形的能力,尤其是在理解节点排列或距离至关重要的任务中。反过来,这限制了他们理解复杂图形结构的能力,因此在图形拓扑或空间定位对于准确分析至关重要的任务中表现不佳

问题仍然悬而未决。其中一个问题是我们没有图推理和 LLM 的基准。要获得良好的基准数据集,我们需要两个主要因素:各种不同的拓扑结构和各种不同的任务。事实上,我们不仅想测试我们的模型是否能解决任务,还想测试它们对图拓扑的理解。

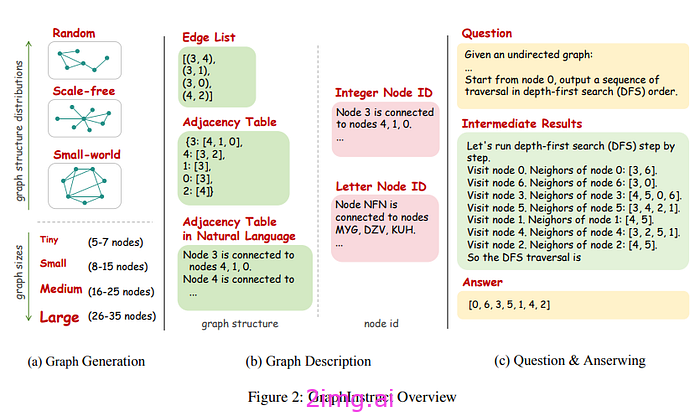

最近,一些基准测试已经开发出来,可用于评估 LLM 的图推理。在这项工作 [6] 中,他们提出了一个新的数据集,试图使拓扑结构和可能的任务数量多样化。然后,作者使用不同的方法生成数据集中的图(随机网络、小世界网络、无标度网络)。他们还改变了图的不同属性,例如方向(间接、直接)、尺度(小、中、宽)以及图的不同描述(边列表、邻接表和自然语言中的邻接表)

图片来源:[6]

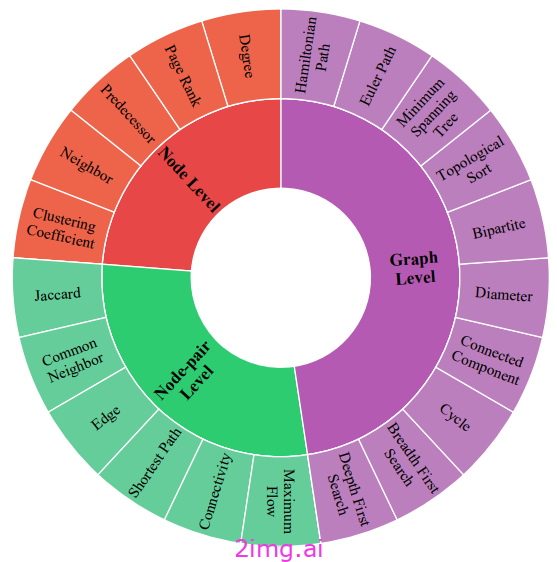

无数的图推理任务都是可能的。例如,一些任务可以在节点级别定义(邻居、节点重要性、聚类系数等),也可以在边缘级别和图级别定义,总共 21 个任务。此外,还生成了推理中间体来帮助具有 CoT 提示的模型。

图片来源:[6]

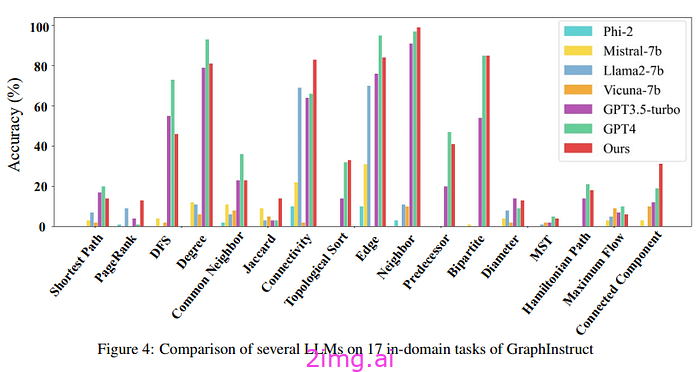

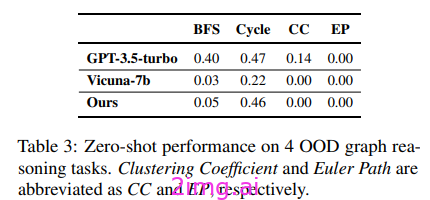

因此作者决定对该数据集进行 LLM 微调。有趣的是,他们决定将数据集分为域内任务和域外任务。简而言之,他们决定在数据集中除四个(域外任务)之外的几乎所有任务上训练模型。所选的四个任务具有挑战性,需要模型具有图理解和推理能力才能解决它们。此外,作者选择了四个不同的任务,涵盖节点、边和图级别方面。因此,该模型在一组任务上进行训练,但随后也会在它从未见过的任务上进行测试,并且只有在图理解训练期间获得才能解决。他们将微调后的模型与其他同等大小或闭源的模型进行了比较。

实验显示了一些有趣的结果:

- 较小的 LLM(约 7B)在基准数据集中表现不佳。这意味着图形数据容量不足。

- 经过微调后,模型有了实质性的改进,性能明显优于小模型,且优于大模型。

- GPT4在某些任务上表现良好,但在其他任务上却不尽人意,表现出对图形数据有一定理解的同时也存在严重的困难。

图片来源:[6]

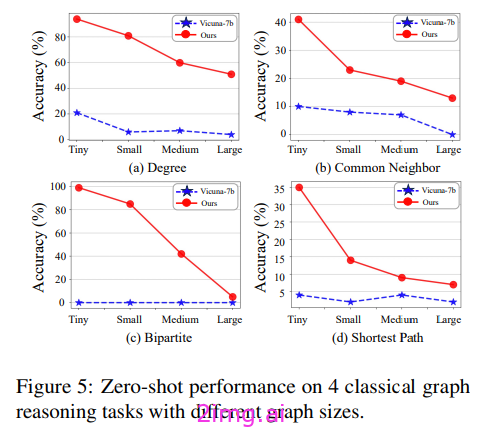

作者还研究了 LLM 与图形数据的泛化能力。在训练期间,模型只看到小图(少量节点和很少的复杂拓扑)。当模型遇到更复杂的网络时,性能会随着图大小函数而线性下降。更复杂的图会带来更大的推理难度。在微调期间接触图形数据的模型比未接触图形数据的模型表现更好。

图片来源:[6]

尽管取得了这些令人鼓舞的结果,但该模型未能推广到领域外的任务。因此该模型无法在已见数据之外进行推广,从而显示出严重的推理局限性。

图片来源:[6]

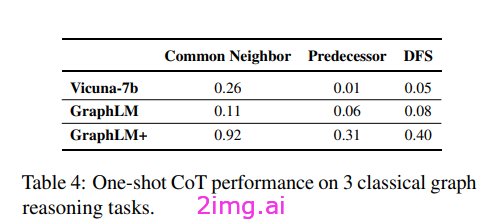

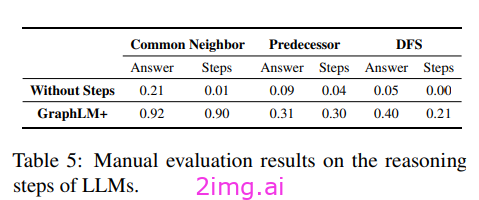

因此,作者认为,提供图形数据可以让模型获得一些图形理解。到目前为止,该模型只在图形和最终答案上进行了训练。在这个最后的实验中,他们为每个问题添加了推理中间体,并询问这是否会提高模型的理解能力。他们还添加了一个掩码,使他们希望模型从中间步骤中学习的信息更加突出。这些中间体的加入表明,该模型在以前难以完成的任务上有了明显的进步。

图片来源:[6]

此外,当使用中间步骤训练模型时,可以产生正确的推理(不仅是正确的答案,而且是正确的中间步骤)。据作者介绍,当不提供这些推理步骤时,模型只能获得对图数据的浅显理解,但无法产生正确的推理或对过程的解释。

图片来源:[6]

从生物学到金融,从汽车路径到社交网络,图无处不在。更重要的是,如今图和法学硕士的关系越来越密切。知识图谱越来越多地被用作法学硕士的背景来源。尽管如此,我们对法学硕士对图的了解程度知之甚少。

最近的研究表明,LLM 对图的理解很少,并且在图推理方面也不出色。我们可以强调造成这些限制的两个主要原因。第一个原因是模型以自回归的方式在大量文本上进行训练。然而,学习大量文本的空间关系非常困难。人类通过与周围世界的互动来学习驾驭诸如图之类的抽象概念。这使他们能够创建和内化思维导图,这些思维导图以后将在物理世界之外使用。第二个原因是训练数据集中的图数据很少。在训练数据集中提供训练数据图可以让模型提高其图理解能力。为它们提供推理能力使 LLM 能够显著提高其解决图推理任务的能力。

LLM 在分布外任务中失败的事实意味着仍有一些方面尚不清楚。其次,我们仍然不知道如何解决其泛化能力的这种限制。随着知识图谱和 LLM 之间的这种协同作用越来越紧密,应该在训练数据集中添加更多图数据的比例,从而培养更好的图推理能力。同时,深化 LLM 的图理解也很重要。

958

958

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?