引言:

随着人工智能技术的迅猛发展,AI大模型已成为当前研究的热点领域。这些大模型具备强大的学习和推理能力,能够在各种任务中表现出色。然而,AI大模型的学习并非一蹴而就,背后有着丰富的理论基础支撑。本文将探讨AI大模型学习的理论基础,包括深度学习、神经网络结构和训练方法等。

目录

一、深度学习

深度学习是AI大模型学习的核心理论基础之一。它模拟了人脑神经元的工作原理,通过构建多层神经网络实现对数据的表示和学习。深度学习的基本思想是通过多个层次的非线性变换,逐渐提取输入数据的高级特征表示,从而实现对复杂模式的建模能力。深度学习的关键在于反向传播算法,它通过梯度下降的方式不断调整网络参数,使得网络能够逐渐优化并拟合训练数据。

二、神经网络结构

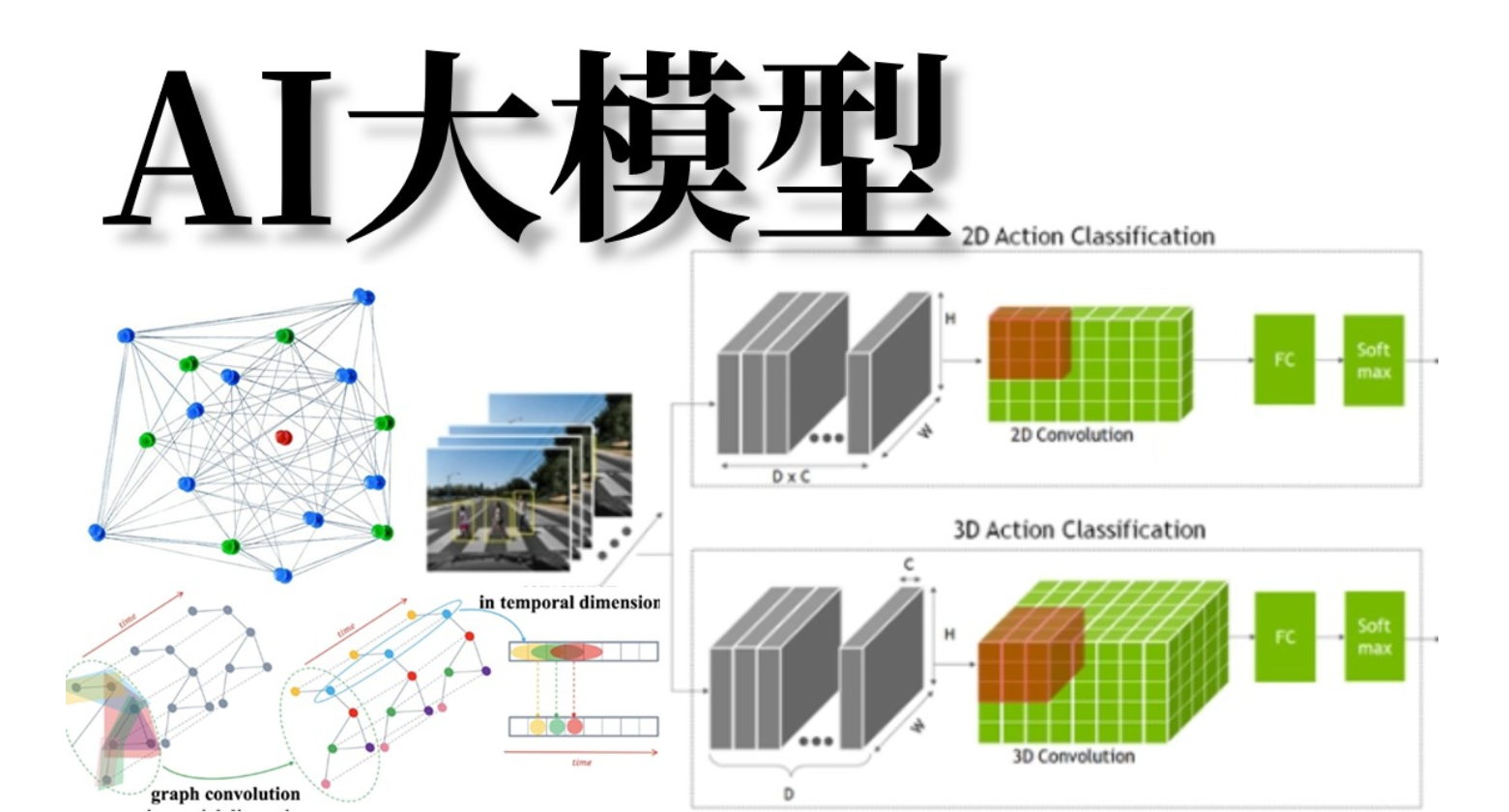

神经网络结构是AI大模型学习的另一个重要理论基础。神经网络通常由多层神经元组成,包括输入层、隐藏层和输出层。其中隐藏层可以有多个,每个隐藏层包含多个神经元,神经元之间通过连接权重进行信息传递。常见的神经网络结构包括前馈神经网络(Feedforward Neural Network)、循环神经网络(Recurrent Neural Network)和卷积神经网络(Convolutional Neural Network)等。不同的神经网络结构适用于不同类型的任务,例如前馈神经网络适用于分类和回归问题,循环神经网络适用于序列数据建模,卷积神经网络适用于图像和语音处理等。

三、训练方法

AI大模型的训练方法也是其学习的重要理论基础之一。常用的训练方法包括监督学习、无监督学习和强化学习。监督学习是指通过给定输入和对应的输出标签来训练模型,使其能够预测未知输入的输出。无监督学习是指在没有标签的情况下,通过对数据的内在结构进行建模和学习。强化学习则是通过智能体与环境的交互来学习最优的行为策略。这些训练方法可以单独或结合使用,根据具体任务和数据类型选择适合的方法进行训练。

四、优化算法

优化算法在AI大模型学习中起着至关重要的作用。深度学习中常用的优化算法包括随机梯度下降(Stochastic Gradient Descent,SGD)及其变种,如动量法(Momentum)、自适应学习率方法(Adaptive Learning Rate Methods)和自适应梯度修剪(Gradient Clipping)等。这些优化算法通过调整学习率、权重更新等策略来加速训练过程和提高模型性能。

随机梯度下降(SGD)

import torch

import torch.optim as optim

# 假设我们有一个简单的模型

model = torch.nn.Linear(10, 2)

optimizer = optim.SGD(model.parameters(), lr=0.01)

# 模拟一个训练步骤

optimizer.zero_grad() # 清空梯度

loss = ... # 计算损失,这里省略了损失计算的过程

loss.backward() # 反向传播计算梯度

optimizer.step() # 更新模型参数

动量法(Momentum)

在PyTorch中,SGD优化器支持动量参数,可以很容易地实现动量法。

# 使用SGD优化器并开启动量

optimizer = optim.SGD(model.parameters(), lr=0.01, momentum=0.9)

# 训练步骤与SGD相同

optimizer.zero_grad()

loss = ...

loss.backward()

optimizer.step()自适应学习率方法

常见的自适应学习率方法有Adam和RMSprop。以下是使用Adam优化器的示例:

# 使用Adam优化器

optimizer = optim.Adam(model.parameters(), lr=0.001)

# 训练步骤与前面相同

optimizer.zero_grad()

loss = ...

loss.backward()

optimizer.step()梯度修剪(Gradient Clipping)

梯度修剪不是一种优化算法,而是一种用于防止梯度爆炸的技术,通常与上述优化算法结合使用。在PyTorch中,你可以在optimizer.step()之前手动实现梯度修剪。

# 假设我们已经计算了损失并进行了反向传播

loss = ...

loss.backward()

# 对模型参数的梯度进行修剪

torch.nn.utils.clip_grad_norm_(model.parameters(), max_norm=1.0)

# 然后应用优化步骤

optimizer.step()在这个例子中,clip_grad_norm_函数将模型参数的梯度裁剪到给定的max_norm范数之内。这是一种防止梯度过大导致训练不稳定的有效方法。

这些代码片段是示意性的,并且假设你已经有一个计算损失的函数和一个需要优化的模型。在实际应用中,你需要根据你的数据和模型来调整学习率、动量参数等。

五、正则化方法

正则化方法是防止AI大模型过拟合的重要手段。过拟合是指模型在训练数据上表现良好,但在未见过的数据上表现较差的现象。常用的正则化方法包括L1正则化、L2正则化和dropout等。L1正则化通过在损失函数中引入权重的绝对值之和作为正则化项,促使模型学习稀疏权重表示;L2正则化通过在损失函数中引入权重的平方和作为正则化项,使得模型的权重分布更加平滑;dropout则是在训练过程中以一定概率随机将部分神经元的输出置为零,以减少神经元之间的依赖关系,从而提高模型的泛化能力。

六、迁移学习

迁移学习是AI大模型学习中的重要技术之一。它通过将已经在一个任务上训练好的模型的部分或全部知识迁移到另一个相关任务上,从而加速新任务的学习过程并提高性能。迁移学习可以通过调整模型的参数、微调神经网络层或使用预训练模型等方式实现。这种方式能够充分利用已有的大规模数据和模型的泛化能力,对于数据量不足或新任务复杂度较高的情况下尤为有效。

结论:

AI大模型学习的理论基础涵盖了深度学习、神经网络结构、训练方法、优化算法、正则化方法和迁移学习等方面。这些理论基础的不断发展和创新推动了AI大模型的进步,使其成为解决复杂任务和实现人工智能的重要工具。未来,随着研究的深入和技术的不断突破,AI大模型学习的理论基础将进一步完善和扩展,为人工智能领域带来更多的突破和创新。

3万+

3万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?