InfiniBand:赋能高性能计算网络的卓越引擎

InfiniBand作为一种先进的内网计算平台,已成为驱动高性能计算(HPC)、人工智能(AI)以及超大规模云基础设施演进的核心力量,其展现出无可比拟的性能优势。专为满足服务器级连接需求而设计,InfiniBand在服务器间的高速通信、存储设备与网络设施之间的高效互联中扮演着至关重要的角色。这一技术凭借其卓越性能和可靠表现,不仅被InfiniBand行业协会广泛接纳并积极推广,更是在全球超级计算机500强榜单(TOP500 list)中占据了主导地位,成为首选互连解决方案。

在TOP500系统排名中,高达44.4%的系统选择InfiniBand作为核心互连技术,显著领先于以太网的40.4%。接下来,我们将深度探讨InfiniBand与以太网的差异性及其在高性能网络环境中的独特价值。

AI算力研究:英伟达B200再创算力奇迹,液冷、光模块持续革新

InfiniBand与以太网的对比分析

InfiniBand技术概述

InfiniBand,作为由IBTA制定的通信规范标准,致力于打造适用于数据中心服务器、通讯基础设施、存储解决方案及嵌入式系统间互连的交换体系。其对标准化的高度重视,确保了在高性能计算网络环境中,各组件能实现无缝集成和高效信息传输,从而提升整体性能。

InfiniBand凭借其显著的高带宽及低延迟特性而闻名遐迩,目前支持诸如FDR 56Gbps、EDR 100Gbps、HDR 200Gbps乃至NDR 400Gbps/800Gbps(通过4x链路宽度连接时的数据传输速率),并有望在未来进一步提升速度阈值。此外,InfiniBand具备出色的可扩展性,可在单个子网内轻松支持数万个节点,因此成为高性能计算(HPC)环境的理想选择。

同时,借助服务质量(QoS)和故障转移功能,InfiniBand成为了非易失性内存快速结构化接口(NVMe-oF)存储协议以及包括以太网、光纤通道(FC)和TCP/IP在内的多种网络架构中的关键组件。对于追求卓越性能与极致扩展性的数据中心而言,采用InfiniBand无疑是明智之举。

以太网技术概述

源自施乐公司、英特尔公司和DEC共同构思的以太网标准,已经成为全球范围内使用最为广泛的局域网(LAN)数据传输通信协议。自20世纪70年代起,以太网作为一种有线通信技术被开创出来,用于连接各种局域网(LAN)或广域网(WAN)内的设备。得益于其极高的适应性,无论是打印机还是笔记本电脑等不同类型的设备都能够通过以太网实现相互连接,应用场景广泛覆盖建筑楼宇、居民住宅乃至小型社区。用户友好的配置方式使得只需通过路由器和以太网连线即可简便构建LAN网络,进而整合各类如交换机、路由器和个人计算机等设备。

尽管无线网络在众多场合得到广泛应用,但以太网凭借其卓越的稳定性和抗干扰能力,仍在有线网络领域占据主导地位。经过多年的发展和改进,以太网不断提升和完善自身功能。目前,IEEE旗下802.3标准组织已发布了100GE、200GE、400GE和800GE等多个以太网接口标准,这充分展示了业界对以太网技术的持续推动和优化的决心与努力。

InfiniBand与以太网在高性能网络环境中的对比分析

InfiniBand技术,最初为解决高性能计算环境中的数据传输瓶颈而生。如今,它已发展为一种广泛应用的互连标准,完美适应现代多样化需求。与以太网相比,InfiniBand在带宽、延迟、网络可靠性及架构等方面具有显著优势。

网络带宽

InfiniBand的飞速发展,尤其在优化高性能计算和减轻CPU负担方面表现突出。相较之下,以太网尽管在终端设备连接中被广泛使用,但在应对高带宽需求时,其迫切性并不如InfiniBand显著。

网络延迟性

InfiniBand运用Cut-Through交换技术,将数据传输延时压缩至100纳秒以下,显著加速网络响应。相较之下,以太网由于在交换机中加入IP、MPLS、QinQ等服务,增加了处理环节,致使转发延时相对较高。

网络可靠性

InfiniBand,凭借其第1层至第4层的明确协议设计及端到端流控制机制,确保了无损网络通信,为高性能计算领域带来卓越的可靠性。相较之下,以太网缺乏此类基于调度的流控制机制,依赖更大的芯片缓存区暂存消息,不仅成本上升,还加剧功耗。

网络管理

InfiniBand借鉴了软件定义网络(SDN)理念,使其网络架构更为简洁高效。每个第二层网络内部都配备了一个子网管理器,用于配置节点并智能计算转发路径信息。与此相反,以太网需要依赖MAC地址条目、IP协议以及ARP协议等多个层次实现网络互联,从而增加了网络管理的复杂性。此外,以太网依靠定期发送更新包来维护路由表,并通过VLAN机制划分虚拟网络边界,限制网络规模;然而这种机制可能导致环路等问题出现,因此通常还需要STP等额外协议来进行环路避免。

深入解析InfiniBand产品系列

InfiniBand 交换机和光纤网卡

对比分析表明,相较于以太网,InfiniBand网络在高性能计算领域展现出了无可比拟的优势。对于计划在高级数据中心部署InfiniBand交换机的用户而言,有必要深入了解其详细性能特点和迭代历程。

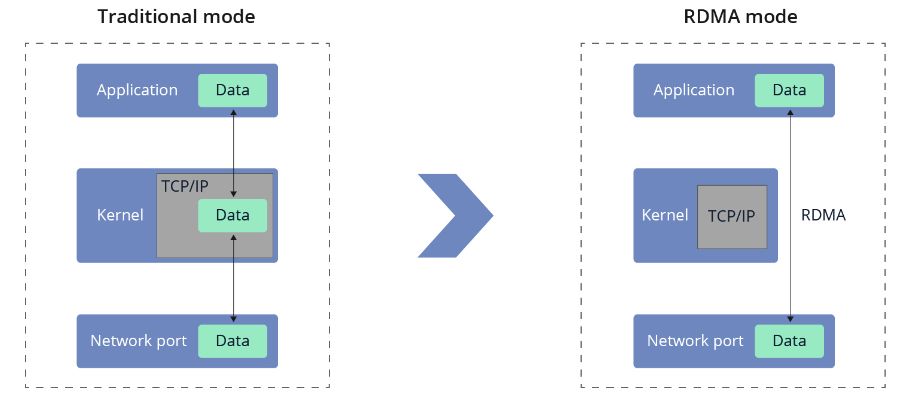

历经多年快速发展,InfiniBand标准已从最初的SDR 10Gbps、DDR 20Gbps、QDR 40Gbps,逐步演进到FDR 56Gbps、EDR 100Gbps,并进一步发展为HDR 200Gbps及NDR 400Gbps/800Gbps等更高速率规格,这些重大突破得益于RDMA(远程直接内存访问)技术的集成应用。

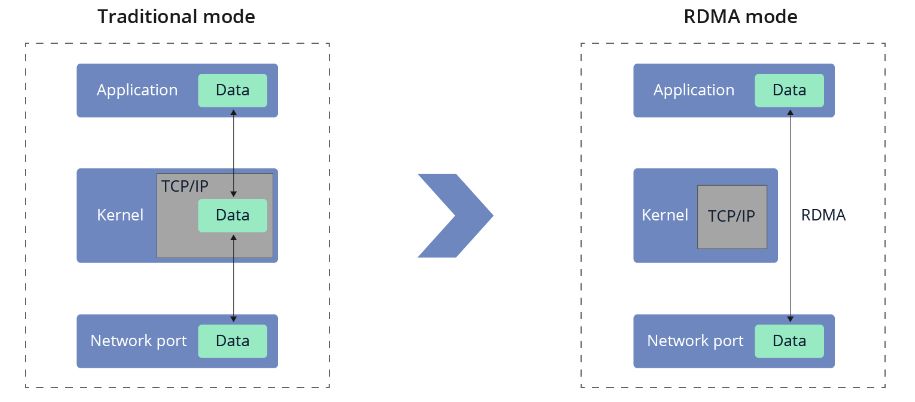

飞速(FS)为此提供了一系列先进InfiniBand解决方案,其中包括NVIDIA Quantum™-2 NDR InfiniBand 400G数据中心交换机以及NVIDIA Quantum™ HDR InfiniBand 200G数据中心交换机,这两款产品均支持管理型和非管理型两种配置模式,以满足不同客户对灵活性的需求。此外,为了确保全方位服务支持,针对400G交换机,飞速(FS)还提供了为期一年、三年或五年的服务选项,旨在帮助用户实现高效稳定的数据中心运行环境。

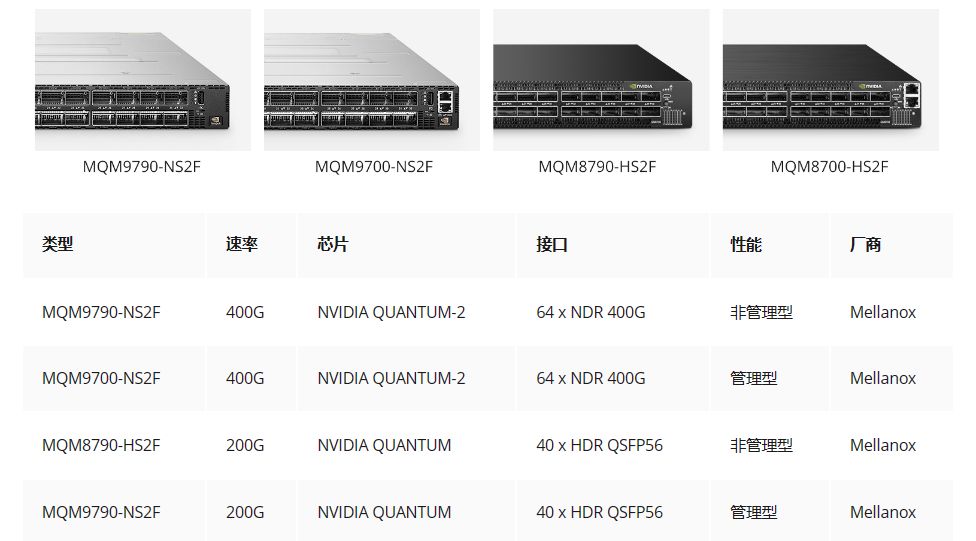

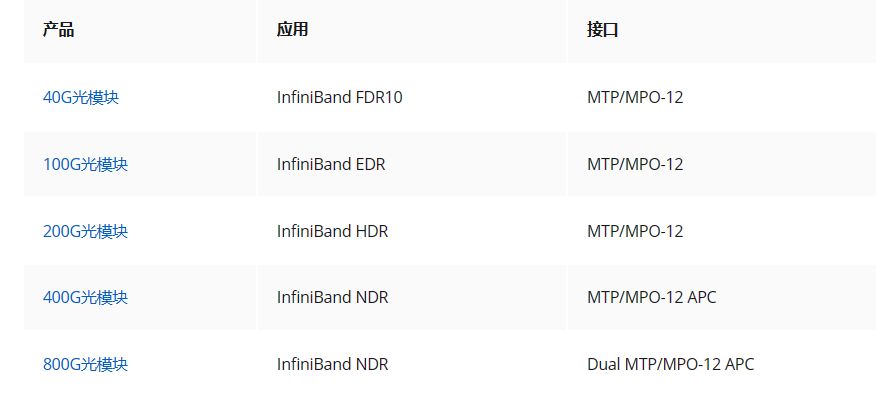

InfiniBand光模块

InfiniBand DAC高速线缆

InfiniBand AOC有源光缆

InfiniBand技术标准概览及优势分析

InfiniBand NDR(下一代数据速率)

InfiniBand NDR系列,包含400Gbase/800Gbase传输速率的光收发器与DAC,专为Mellanox NDR 400Gb交换机如MQM9700/MQM9790系列打造。在GPU加速计算环境下,这些组件能提供卓越的性能连接,并有潜力节省高达50%的成本。它们尤其适合高性能计算(HPC)、云计算、模型渲染以及基于InfiniBand 400Gb/800Gb网络的存储应用。

InfiniBand HDR(高数据速率)

飞速(FS)推出的InfiniBand HDR产品线涵盖了多样化的高速互联产品,例如200Gb/s和400Gb/s QSFP56 IB HDR多模光纤(MMF)有源/无源光缆(AOC)、有源/无源直连铜缆(DAC)、光学收发器路由器以及200G交换机等。这些模块和电缆能够无缝衔接MQM8700/MQM8790等交换机与NVIDIA GPU(如A100/H100/A30)和CPU服务器,以及ConnectX-5/6/7 VPI等存储网络适配器。此类解决方案不仅可实现最高达50%的成本节约,而且在涉及GPU加速的高性能计算(HPC)集群应用——包括模型渲染、人工智能(AI)、深度学习(DL)以及InfiniBand HDR环境下的NVIDIA应用网络通信时表现出卓越性能。

InfiniBand EDR(增强数据速率)

InfiniBand EDR系列为您呈现100Gbase QSFP28 EDR AOC、EDR DAC、AOC及光收发器,专为GPU加速计算量身定制。高效经济且性能卓越,满足您的多元需求。让我们共同探索无限可能,开启智能互联新篇章。

InfiniBand FDR(十四倍数据速率)

InfiniBand FDR系列涵盖40Gbase QSFP+ FDR10 AOC、DAC及光模块,以及56Gbase QSFP+ FDR DAC和AOC。所有产品皆可与Mellanox EDR交换机完美融合,实现无缝连接。

InfiniBand在网络高效能计算中的显著优势

随着数据通信、互联网技术和可视化展示需求不断提升,计算能力、存储容量和网络效率的需求也日益增长。在此背景下,InfiniBand网络凭借其高带宽服务、低延迟特性以及将协议处理和数据移动从CPU转移到互连层以降低计算资源消耗的独特优势,成为高性能计算数据中心的理想选择。此技术已广泛应用于Web 2.0、云计算、大数据处理、金融服务、虚拟化数据中心和存储应用等领域,实现了显著的性能提升效果。

在速度领域,InfiniBand已超越100G以太网的界限。其支持从100G/200G到400G/800G的灵活InfiniBand交换机配置,完美满足HPC架构对高性能的需求。通过高带宽、高速率和低延迟的协同作用,InfiniBand交换机显著提升了服务器性能和应用运行效率。

InfiniBand拥有卓越的扩展性,能在网络层2上支持高达48,000个节点。与以太网相比,其降低了对ARP广播机制的依赖,有效避免了广播风暴并减少额外带宽浪费。更值得一提的是,多个子网能灵活地与交换机关联,从而进一步提升网络的灵活性。

飞速(FS)深知高性能计算的关键性,因此推出了一系列基于Quantum InfiniBand交换设备构建的InfiniBand产品。这些产品支持高达16Tb/s的无阻带宽,且端口间延迟低于130ns,确保HPC数据中心的高可用性和多服务支持。尽管以太网网络通过跨设备分配工作负载仍具有高效的数据传输能力,但FS还提供一系列多速率以太网交换机,协助客户打造灵活且高效的网络环境。

选择合适的网络

在挑选网络技术时,InfiniBand和以太网各有千秋,各擅胜场。若着眼于显著提升数据传输速度、优化网络资源利用效率,以及有效降低CPU在网络数据处理上的负担,InfiniBand网络凭借其核心技术优势,在高性能计算领域独树一帜,成为关键的解决方案。

在数据中心环境中,如果通信延迟并非关键,且更看重网络的灵活性和扩展性,那么以太网网络将提供一种稳定且高度适应的基础设施支持。

InfiniBand网络,凭借其卓越的性能和创新的架构设计,为HPC数据中心用户开启了前所未有的业务效能优化新篇章。它消除了多层级结构带来的延迟问题,确保关键计算节点能无缝升级接入带宽,从而在提升整体运营效率上发挥了决定性作用。随着其应用范围的持续扩大和技术认可度的不断提升,我们预期,未来的InfiniBand网络将在更多复杂且要求严苛的应用场景中,得到广泛应用和部署。

-对此,您有什么看法见解?-

-欢迎在评论区留言探讨和分享。-

1020

1020

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?