文章目录

目标

1. 能够说出循环神经网络的概念和作用

2. 能够说出循环神经网络的类型和应用场景

3. 能够说出LSTM的作用和原理

4. 能够说出GRU的作用和原理

提示:以下是本篇文章正文内容,下面案例可供参考

一、循环神经网络的介绍

为什么有了神经网络还需要循环神经网络?

在普通的神经网络中,信息的传递是单向的,这种限制虽然使得网络变得更容易学习,但在一定程度上减弱了神经网络模型的能力,特别是在很多现实任务中,网络的输出不仅和当前时刻的输入相关,也和过去一段时间的输出相关。此外,普通网络难以处理时序数据,比如视频、语音、文本等,时序数据的长度一般是不固定的,而前馈神经网络要求输入和输出的位数都是固定的,不能任意改变。因此,当处理这一类时序相关问题时,就需要一种能力更强的模型。

循环神经网络(Recurrent Neural Network,RNN)是一类具有短期记忆能力的神经网络。在循环神经网络中,神经元不但可以接收其他神经元的信息,也可以接收自身的信息,形成具有环路的网络结构。换句话说:神经元的输出可以在下一时间步直接作用到自身(作为输入)。

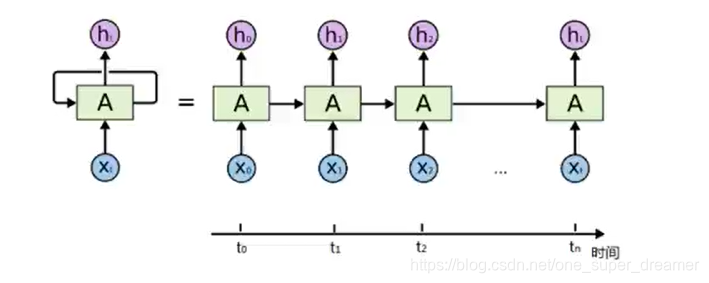

通过简化图,我们看到RNN比传统的神经网络多了一个循环圈,这个循环表示的就是在下一时间步(time step)上返回作为输入的一部分,我们把RNN在时间点上展开,得到的图形如下:

或者是:

在不同的时间步,RNN的输入都与之前的时间状态有关,

t

n

tn

tn时刻网络的输出结果是该时刻的输入和所有历史共同作用的结果,这就达到了对时间序列建模的目的。

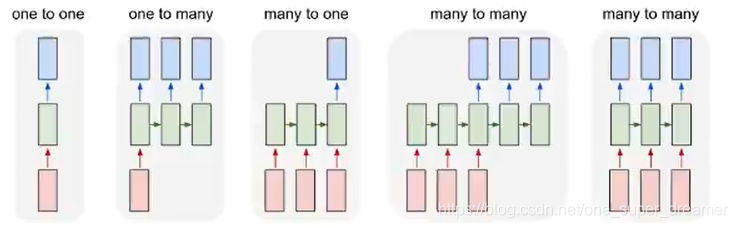

RNN的不同表示和功能可以通过下图看出:

- one-to-one(固定长度的输入和输出):图形分类

- one-to-many(序列输出):图像转文字

- many-to-one(数列输入):文本分类

- 异步的mant-to-many:文本翻译

- 同步的many-to-many:视频分类

二、LSTM和GRU

2.1 LSTM的基础介绍

对于一些长度较大的句子来说。随着词语之间的间隔的增啊及可能会导致真实的预测值对结果的影响变的非常小,而无法非常好的进行预测(RNN中的长期依赖问题),那么为了解决这个问题需要LSTM,它是一种RNN特殊的类型,可以学习长期依赖信息,在很多问题上得到了广泛的应用。

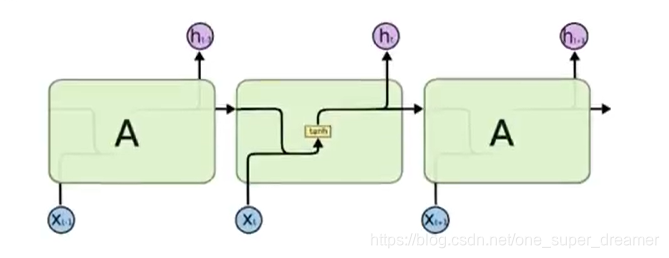

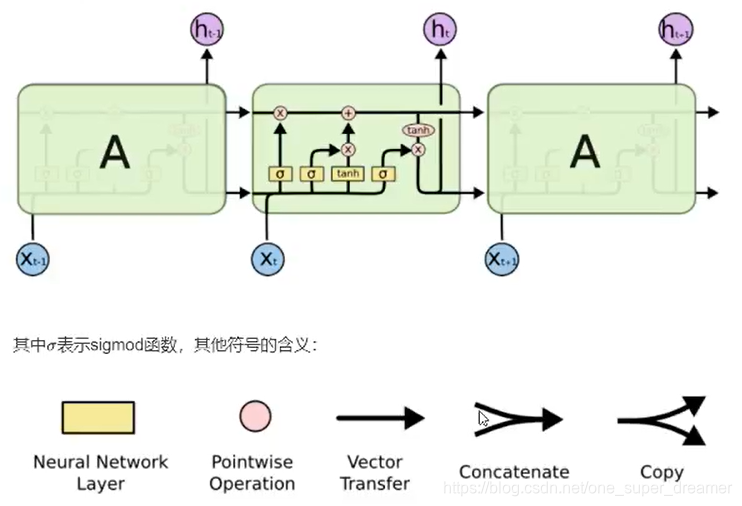

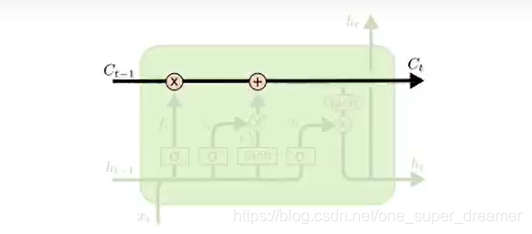

一个LSTM单元如下所示:

2.2 LSTM的核心

LSTM的核心在于单元(细胞)中的状态,也就是上图中最上面的那根线。

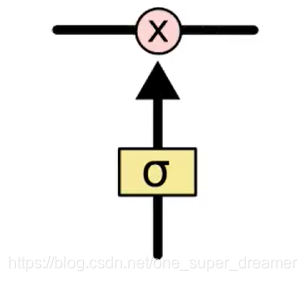

但吐过只有上面那一条线,那么就没有办法实现信息的增加或者删除,所以在LSTM是通过一个叫做门的结构实现,门可以选择让信息通过或者不通过。

这个门主要是通过sigmoid和点乘(pointwise multiplication)来实现的。

如何实现增加或者删除:

s

i

g

m

o

i

d

sigmoid

sigmoid的取值范围是在(0,1)之间,如果接近0表示不让任何信息通过,如果接近1表示所有的信息都会通过。

2.3 LSTM中门结构

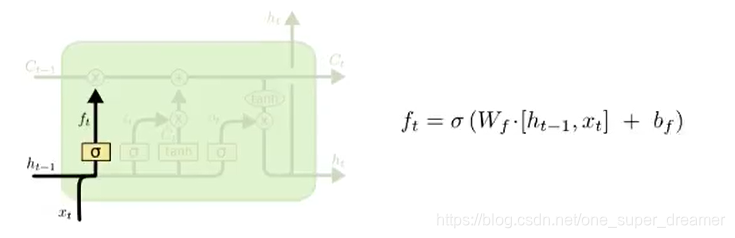

2.3.1 遗忘门

遗忘门通过sigmoid来决定哪些信息会被遗忘。在下图就是

h

t

−

1

h_t-_1

ht−1(上一时间的输出)和

x

t

x_t

xt(当前时间的输入)进行合并(concat)之后乘上权重和偏置,通过sigmoid函数,输出0-1之间的一个值,这个值会和前一次的细胞状态(

C

t

−

1

C_t-_1

Ct−1)进行点乘,从而决定遗忘或者保留。

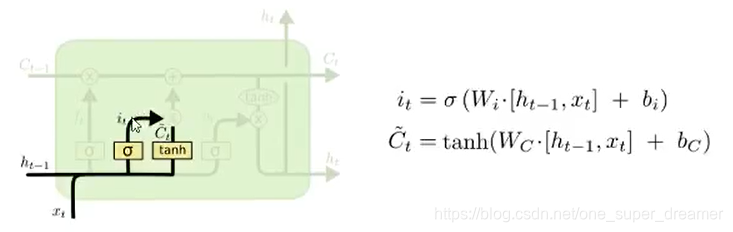

2.3.2 输入门

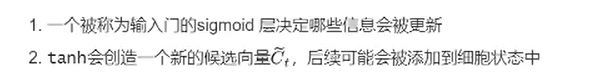

下一步就是决定哪些新的信息会被保留,这个过程有两步:

上面第一步会决定输入多少比例信息,第二步中新的候选向量中包含的是新输入的信息。

例如:我昨天吃了苹果,今天我想吃菠萝。在这个句子中,通过遗忘门可以遗忘苹果,同时更新新的主语为菠萝。

现在就可以更新旧的细胞状态

C

t

−

1

C_t-_1

Ct−1为

C

t

C_t

Ct了。

更新的构成很简单:

- 旧的细胞状态和遗忘门结果相乘

- 然后加上输入门和tanh相乘的结果

2.3.3 输出门

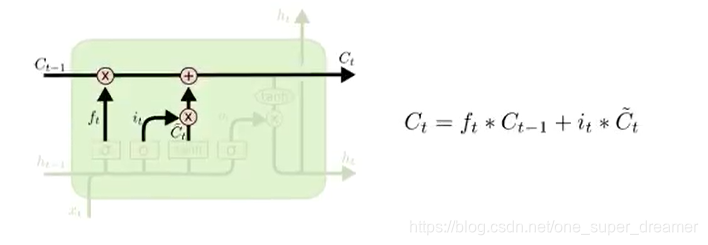

最后,我们需要决定什么信息会被输出,这个输出经过变换之后会通过sigmoid函数的结果来决定哪些细胞状态会被输出。

步骤如下:

- 前一次的输出和当前时间步的输入的组合结果通过sigmoid函数进行处理得到 O t O_t Ot

- 更新后的细胞状态 C t C_t Ct会经过tanh层的处理,把数据转化到(-1,1)的区间

- tanh处理后的结果和 O t O_t Ot进行相乘,把结果输出同时传到下一个LSTM的单元

输入和输出:

输入:

h

i

d

d

e

n

−

s

t

a

t

e

,

X

t

,

C

t

−

1

hidden-state,X_t,C_t-_1

hidden−state,Xt,Ct−1

输出:

h

t

,

h

t

,

C

t

h_t,h_t,C_t

ht,ht,Ct

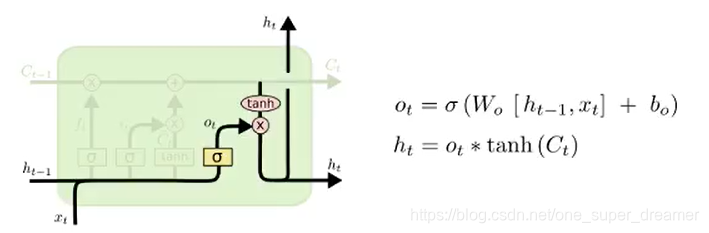

2.4 GRU,LSTM的变形

GRU(Gated Recurrent Unit),是一种LSTM的变形版本,它将遗忘和输入门组合成一个“更新门”。它还合并了单元状态和隐藏状态,并进行了一些其他更改,由于他的模型比标准LSTM模型简单,所以较受欢迎。

两个输出:

h

i

d

d

e

n

−

s

t

a

t

e

,

h

i

d

d

e

n

−

s

t

a

t

e

hidden-state,hidden-state

hidden−state,hidden−state

两个输入:

x

t

,

h

i

d

d

e

n

−

s

t

a

t

e

t

−

1

x_t,hidden-state_t-_1

xt,hidden−statet−1

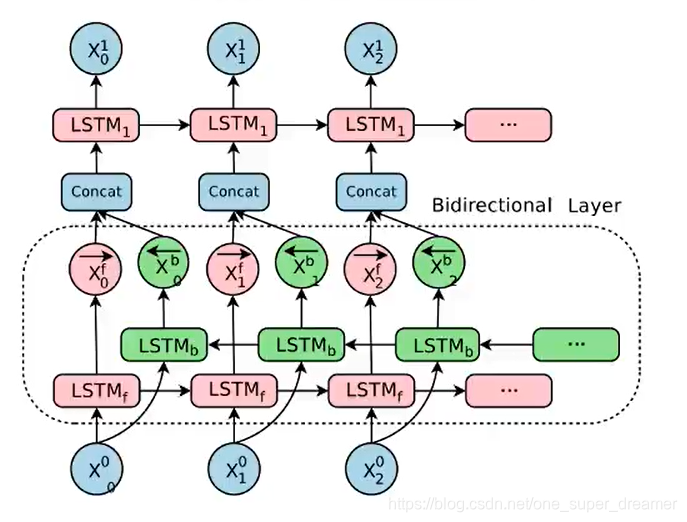

2.5 双向LSTM

单向的RNN,是根据前面的信息推出后面的,但有时候只看前面的词是不够的。可能需要预测的词语和后面的内容也相关,那么此时需要一种机制,能够让模型不仅能够从前往后具有记忆,还需要从后往前需要记忆。此时双向LSTM帮忙解决了这个问题。

由于是双向LSTM,所以每个方向的LSTM都会有一个输出,最终的输出会有2部分,所以往往需要concat的操作。

7071

7071

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?