sklearn里的官方文档里的代码如下(分类任务):

from sklearn.datasets import load_iris

from sklearn import tree

iris = load_iris()//加载数据集

X, y = iris.data, iris.target//设定特征值和标签

clf = tree.DecisionTreeClassifier()//建立决策树模型

clf = clf.fit(X, y)//训练

tree.plot_tree(clf)//可视化

输出结果:

输出分为两个部分,上面是文本输出结果,下面是将文本结果转化为图像结果。

第一部分是文本输出结果,每一行text()相当于下面图像里的一个方框(节点),这个节点的作用就是设定了一个分类标准,然后根据这个标准就可以将当前节点的输入数据进行划分,划分结果只有两种,符合标准和不符合标准。

分析text()内容:以第一行为例:

Text(167.4, 199.32, 'X[2] <= 2.45\ngini = 0.667\nsamples = 150\nvalue = [50, 50, 50]')

开头两个数字作用是为了之后的绘制决策树图像用的,相当于为了确定下面图像里的方框位置,第三个元素x[2]<=2.45是当前节点的分类标准,第四个元素ngini代表基尼系数,整个决策树模型的建立就是通过不断提出分类标准将数据集进行分类,而每次的分类结果好坏的评判标准就是当前数据集的基尼系数,基尼系数越低代表数据集内的类别越趋近于一类,说明分类结果越好,第五个元素nsamples表示当前节点输入数据集的样本大小,第六个元素nvalue表明当前数据集中有三个类别的样本,而且样本数各自为50,50,50。注意这里只是代表当前数据集内有三个类别,而不是数据集被分为了三个类别,也就是说当前节点经过分类后被分为了两类而不是三类。

第二行:Text(141.64615384615385, 163.07999999999998, 'gini = 0.0\nsamples = 50\nvalue = [50, 0, 0]')

可以看到这一行比上一行少了一个分类标准,并且基尼系数为0,代表当前节点已经到达了叶节点(不需要再进行分类)。

进一步理解决策树模型可以查看官方文档里的DecisionTreeClassifier()方法:

class sklearn.tree.DecisionTreeClassifier(*, criterion='gini', splitter='best', max_depth=None, min_samples_split=2, min_samples_leaf=1, min_weight_fraction_leaf=0.0, max_features=None, random_state=None, max_leaf_nodes=None, min_impurity_decrease=0.0, min_impurity_split=None, class_weight=None, presort='deprecated', ccp_alpha=0.0)

其中参数如上,我们可以重新设定参数来对模型进行调整,其中几个重要的参数如下:

-

criterion:评价分类结果的参数,可选“gini”, “entropy”,“log_loss”,默认“gini”。其实这就是对应的几个不同版本的决策树模型(CART,C4.5,ID3),这几个版本的主要区别就是选取了不同的参数来对分类结果进行评价。

-

splitter:用于在每个节点上选择拆分的策略。可选“best”, “random”,默认“best”。关于具体拆分策略的实现过程,我找到了sklearn在github上的源代码文件,具体实现过程在下面链接里,恕笔者能力有限,只能推测个大概意思,如有错误欢迎指出,大概意思就是遍历了每个特征的每个可能切分点,每次遍历计算切分前后基尼系数的变化大小,记录变化最大值作为最佳切分点。https://github.com/scikit-learn/scikit-learn/blob/f07e0138bfee41cd2c0a5d0251dc3fe03e6e1084/sklearn/tree/_splitter.pyxhttps://github.com/scikit-learn/scikit-learn/blob/f07e0138bfee41cd2c0a5d0251dc3fe03e6e1084/sklearn/tree/_splitter.pyx

-

max_depth:树的最大深度。如果为None,则将节点展开,直到所有叶子都是纯净的(只有一个类),或者直到所有叶子都包含少于min_samples_split个样本。默认是None。通过设定这个参数可以实现预剪枝,防止过拟合现象。

-

min_samples_split:拆分内部节点所需的最少样本数:如果为int,则将min_samples_split视为最小值。如果为float,则min_samples_split是一个分数,而ceil(min_samples_split * n_samples)是每个拆分的最小样本数。默认是2。通过设定这个参数可以实现预剪枝,防止过拟合现象。

-

min_samples_leaf:在叶节点处需要的最小样本数。仅在任何深度的分割点在左分支和右分支中的每个分支上至少留下min_samples_leaf个训练样本时,才考虑。这可能具有平滑模型的效果,尤其是在回归中。如果为int,则将min_samples_leaf视为最小值。如果为float,则min_samples_leaf是分数,而ceil(min_samples_leaf * n_samples)是每个节点的最小样本数。默认是1。通过设定这个参数可以实现预剪枝,防止过拟合现象。

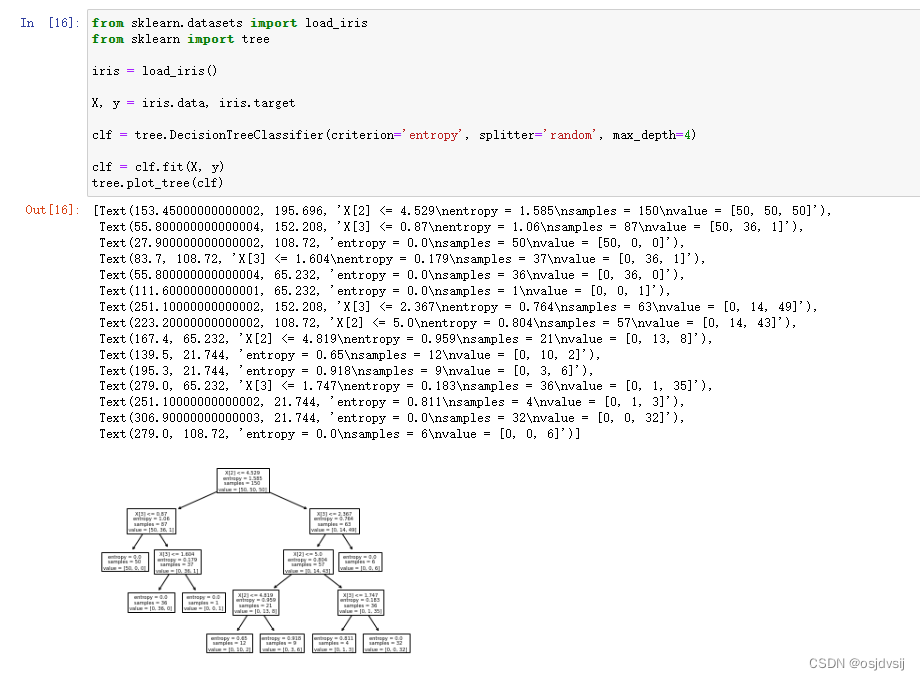

试着更改参数:

clf = tree.DecisionTreeClassifier(criterion='entropy', splitter='random', max_depth=4)

输出结果如下:

可以看出来,对应的分类标准和结果都发生了改变。

2万+

2万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?