从chatgpt风靡全球以来,大语言模型都被认为是有推理能力的。但大语言模型的“推理能力”本质上只是联想,和人类的推理有质的区别。普通老百姓分不清联想和推理的区别情有可原。但研究者分不清楚联想和推理,或者故意把联想说成推理,就不应该了。

一、我们先看看什么是联想。

联想思维简称联想,是人们经常用到的思维方法;是一种由一事物的表象、语词、动作或特征联想到其它事物的表象、语词、动作或特征的思维活动。 通俗地讲, 联想一般是由于某人或者某事而引起的相关思考,人们常说的 “由此及彼”、“由表及里”、“举一反三” 等就是联想思维的体现。

需要注意的是:

1.联想和语言的关系不是必然的。动物不懂语言也会联想。联想的起点可以是人或动物看到、听到、想到的任何信息。

2.联想是发散的。从一个事物可以联想到多个事物。联想没有方向性,也没有边界,一层层的联想会形成一个树状结构。联想没有终点,可以无限延伸。

3.联想是从一个已知事物联想到另一个已知事物。并不能凭空创造出未知事物。

4.联想没有对错。

5.从同一个起点出发,不同的个体联想到的结果千差万别。西方人想象中的“鬼”和东方人就完全不一样。而每个东方人心目中的“鬼”又是不一样的。联想是想象的基础。

二、再让我们看看什么是推理。

从网上搜的推理的定义是:推理是由一个或几个已知的判断推出一个新的判断的思维形式;推理的形式有直接推理、间接推理等。单看这句话,似乎联想也是推理。其实就误解了推理的真正意义。推理是逻辑学的一种形式。而联想不属于逻辑学的概念。推理按推理过程的思维方向划分,主要有演绎推理、归纳推理和类比推理。

演绎推理是由普遍性的前提推出特殊性结论的推理。比如由“鸟都会飞”和“鹈鹕是一种鸟”演绎出来“鹈鹕会飞”。演绎推理有三段论、假言推理和选言推理等形式。

归纳推理是由特殊的前提推出普遍性结论的推理。比如由“100个苹果都是红色的”归纳出来“苹果都是红色的”。归纳推理有以下几种类型:1.完全归纳法 2.不完全归纳法 3.简单枚举法 4.科学归纳法 5.挈合法(求同法)6.差异法(求异法)7.共变法 8.剩余法

类比推理是从特殊性前提推出特殊性结论的一种推理,也就是从一个对象的属性推出另一对象也可能具有这属性。例如,火星和地球都是太阳系的行星,并且质量大小类似,因为地球上存在生命,所以火星上也存在生命。

推理是逻辑的一部分。语言是逻辑的基础。推理与概念、判断一样,同语言密切联系在一起。推理的语言形式为表示因果关系的复句或具有因果关系的句群。常用“因为……所以……”“由于……因而……”“因此”、“由此可见”、“之所以……是因为……”等作为推理的系词。

要注意的是:

1.推理得到的结论不一定是正确的,它只是人的一种思维工具。人类综合利用多种思维工具得出正确的结论。但推理本身就是一种对和错的思考。当我们推理时,就假设我们推理得出的结论是正确的。当不能从其他方面证明我们推理的结论是错误的,我们就认为我们推理的结论是正确的。

2.推理的基础是语言。不能理解语言的语义,就无法进行推理。动物不懂人类语言就没有推理能力。但动物具有联想能力。只会说“爸爸”“妈妈”“吃”这样简单词汇的小孩子也没有推理能力。

3.推理计算是线性的,并且是单线的,结论是唯一的。一步步的推理形成了推理链。推理是有明确的方向性的,必然要有一个结论。结论是推理的终点。得出结论,推理就结束了。

4.推理是无中生有,从已知推理出来未知。

5.推理可以发现规律,揭示事物的本质。推理是人类大部分知识的来源,是建立认识体系的基础。

为什么我们会分不清楚联想和推理呢?

联想和推理都是思维的一种方法,但两者有着本质的不同。但为什么人们经常分不清联想和推理呢?

以下是大语言模型给的答案:

联想和推理确实是两种不同的思维方式,它们在认知过程中起着不同的作用,但人们常常难以区分它们,这主要源于以下几个原因:

- 认知过程的模糊性:

-

在实际的思维活动中,联想和推理往往是交织在一起的。联想可能触发推理过程,而推理也可能包含联想的元素。这种交织使得区分两者变得困难。

-

大脑在处理信息时,往往不是严格按照逻辑顺序进行的,而是同时运用多种思维方式,这使得区分联想和推理变得模糊。

-

- 日常用语中的混淆:

-

在日常交流中,“联想”和“推理”这两个词可能被用来描述相似的思维过程,导致人们在理解上存在混淆。

-

语言表达的多样性也可能导致对这两个概念的误解。例如,“我联想到这件事可能是因为…”这样的表述,实际上可能包含了推理的成分。

-

- 个体认知差异:

-

每个人的思维方式都是独特的,有些人可能更倾向于联想,而有些人则更擅长推理。这种个体差异可能导致人们对联想和推理的理解存在差异。

-

认知风格的不同也可能影响人们对这两种思维方式的区分能力。

-

- 教育和文化背景的影响:

-

教育体系中对于逻辑思维的训练程度不同,可能导致人们对推理的理解和应用存在差异。

-

文化背景也可能影响人们对联想和推理的认知。在某些文化中,联想可能被视为一种重要的思维方式,而在其他文化中则可能更注重推理。

-

- 缺乏明确的定义和区分标准:

-

在学术上,虽然联想和推理有明确的定义,但在实际应用中,这些定义可能变得模糊。

-

缺乏一个明确的、可操作的区分标准也使得人们难以准确区分联想和推理。

-

综上所述,人们分不清联想和推理的原因是多方面的,包括认知过程的模糊性、日常用语中的混淆、个体认知差异、教育和文化背景的影响以及缺乏明确的定义和区分标准。为了更准确地理解和运用这两种思维方式,我们需要深入学习和理解它们的本质特征和应用场景。

我觉得这个答案挺好的。但我觉得还需要补充一点。

人工智能研究者一直想模拟人类思维,他们当时并没有对人类思维进行深入研究,并没有分析联想和推理的区别。他们把所有一步步思考的过程都叫推理,忽略了推理原本的含义。他们理所当然把自己程序一步步的计算说成是推理。这个传统一直持续到了现在。不管联想还是推理都是一步步进行的。它们看起来几乎一样,但还是有本质不同的。在人类思考的过程中,这两者也是同时都发挥了重要的作用。

三、生成式AI只是联想不是推理。

对于这个推论,大语言模型的解释是这样的:

要证明生成式AI只是联想而非推理,需要深入分析生成式AI的工作原理、能力表现以及与人类推理过程的对比。以下是一些关键的考虑点和论据:

(一)生成式AI的工作原理

- 数据驱动:生成式AI通过大量数据的训练,学习数据的统计特征和内在规律,从而能够生成新的、与训练数据相似的内容。这一过程主要依赖于记忆和模式匹配,而非逻辑推理。

- 潜在空间表示:生成式AI将数据映射到一个潜在空间中,这个空间表示了数据的高维特征压缩。模型通过在这个潜在空间中操作来生成新的内容。这种操作更多是基于数据的统计特性,而非逻辑结构。

(二)生成式AI的能力表现

- 在熟悉任务上的表现:生成式AI在训练过的领域内表现出色,能够生成高质量的内容。然而,这种表现主要依赖于记忆和模式匹配,而非真正的推理能力。

- 面对新问题的局限性:当面对全新的挑战或需要真正的推理能力时,生成式AI的优势便不再明显。例如,在十进制算术方面表现优异的GPT-4,在其他进制下却难以应对。这表明生成式AI缺乏灵活的逻辑推理能力。

(三)与人类推理过程的对比

- 推理的定义:推理是以已有若干判断为前提,逻辑推出新判断的思维过程。它涉及概念、判断和推理的相互作用,以及逻辑结构的运用。

- 生成式AI的局限性:生成式AI虽然能够生成看似合理的输出,但其内部机制主要基于统计和模式匹配,而非逻辑推理。它缺乏真正的意图和理解能力,无法像人类一样进行复杂的逻辑推理和判断。

- 人类推理的复杂性:人类的推理过程涉及多个层面的认知活动,包括理解问题的本质、分析问题的结构、运用逻辑规则进行推理等。这些过程需要高度的认知能力和灵活性,是生成式AI目前所无法比拟的。

(四)结论

综上所述,虽然生成式AI在某些方面表现出强大的生成能力,但其内部机制主要基于记忆和模式匹配,而非逻辑推理。因此,可以认为生成式AI更多地是一种联想工具,而非推理工具。它在熟悉的任务上表现出色,但在面对全新的挑战或需要真正的推理能力时,其局限性便显露无遗。这一结论是基于对生成式AI工作原理、能力表现以及与人类推理过程的深入分析和对比得出的。

这的确比我写得好。

我要补充的是:

1.理解语义是推理的基础。生成式AI并没有真正理解语义,不可能完成推理。(这个观点我在别的文章里已经论述了,这里不重复了。)

2.虽然生成式AI根据概率预测也能得出来看起来像推理的结果,但计算的过程完全不一样。生成式AI的计算过程要复杂很多,而且要消耗更多的能量。比如,从“鸟都会飞”和“鸵鸟是一种鸟”演绎出来“鸵鸟会飞”,这个过程在人类大脑里只需要一步就能完成。因为这就是个既定的推理模型。而生成式AI,甚至不能得出“鸵鸟会飞”的结论。(虽然“鸵鸟会飞”是错的,但在这个逻辑推理的过程里,“鸵鸟会飞”是对的。)

3.生成式AI是根据向量距离计算的,结果是相对的且并不唯一。而逻辑推理的结果是确定的。比如向大模型提问“从凤凰、龙、蝙蝠、大雁、蟋蟀中间找出一个不会飞的。必须找出一个,且只能找出一个。请问它是谁?”它给的答案是“蟋蟀”。当我们把“蟋蟀”这个选项去掉以后,它给的答案是“龙或者凤凰”。显然它给的是相近的答案。

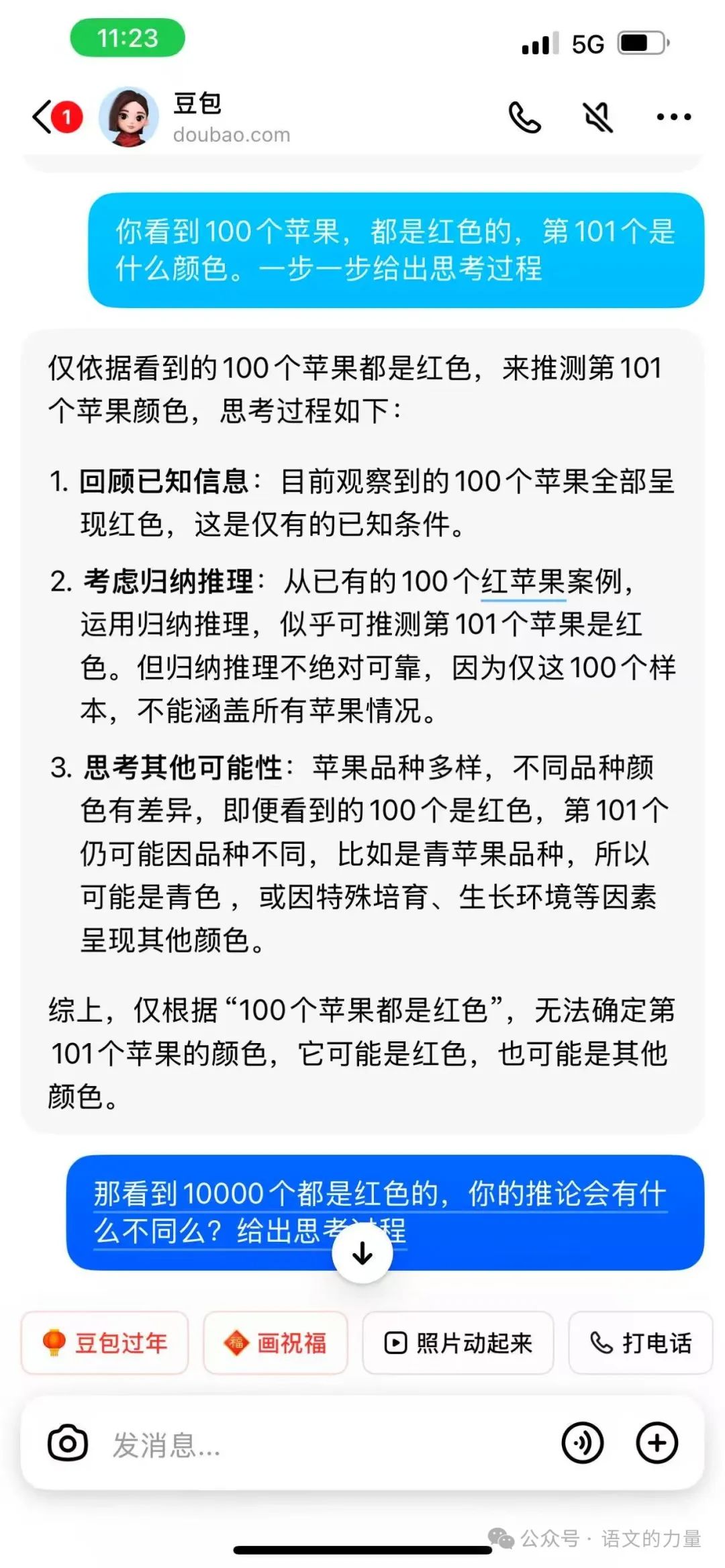

有人用以下图片来否定我的观点:

他认为这个聊天记录证明生成式AI具有逻辑推理能力。咱们仔细看这个聊天记录,就算换各种说法大模型始终不敢肯定回答“第101个苹果的颜色是红色的”,恰恰证明大语言模型没有归纳能力。虽然根据“100个苹果是红色的”推理出来“第101个苹果也是红色的”不严谨,但这就是逻辑推理。

从另一方面讲,这个聊天记录其实展示的是生成式AI的生成结果,而不是计算过程。把结果当成过程,也太不专业了。

正是因为生成式AI是联想,所以幻觉问题对于生成式AI是无解的。联想和幻想之间并没有边界。

逻辑推理虽然也有错误,但不会产生幻觉。要证明这个判断,我又得写一长篇文章。本文就不讨论了。

四、结论

虽然各家大模型公司都号称自己的模型有推理能力,有的甚至专门推出了能做数学应用题的推理模型,但本质上这些模型都不理解语义,不是真正的推理;只是根据统计概率进行联想。

2025.2.2

7883

7883

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?