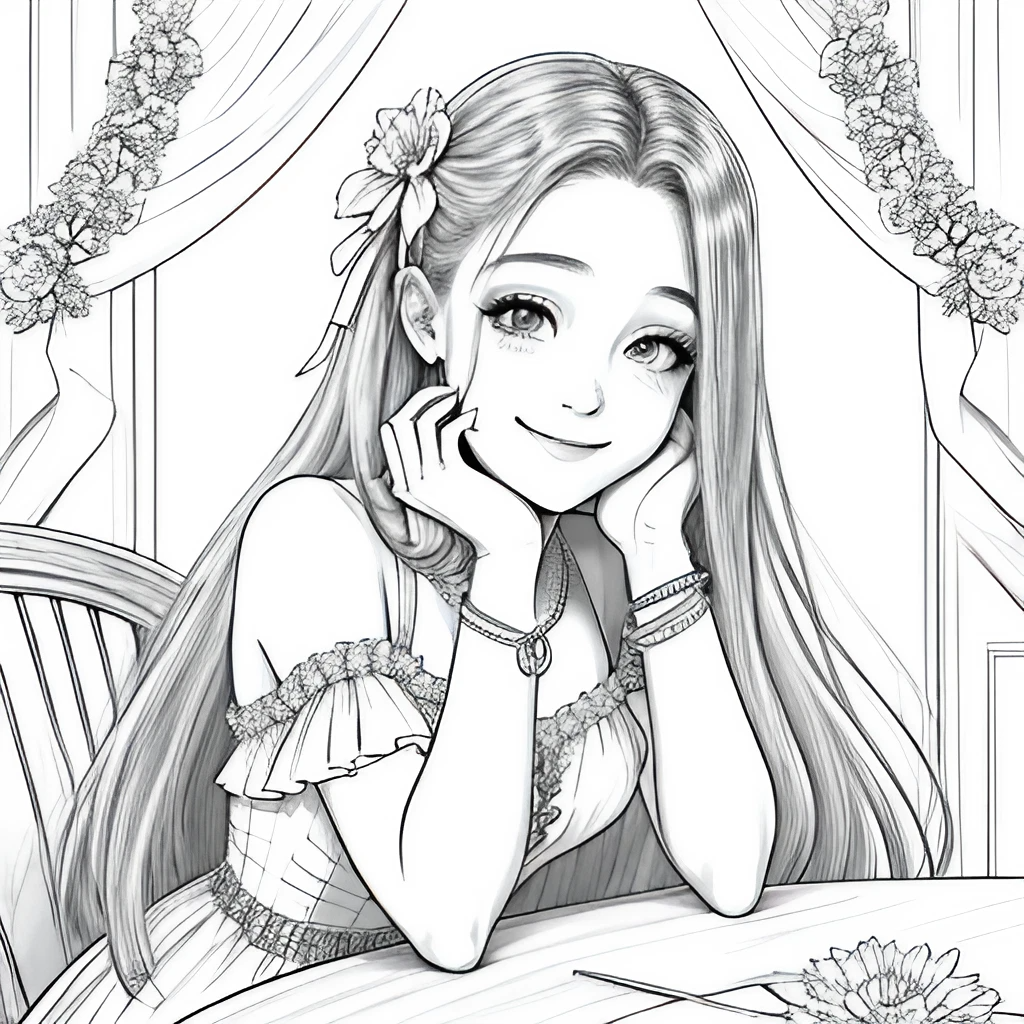

解放双手,画了一个线稿,又不想花时间上色,用AI提高效率,把我们时间花在创意上面,把重复的事情给AI,让它打黑工话不多说,先上一个对比图

一、用SD生成黑白线稿

首先使用正面和反面提示词生成一张黑白线稿图(也可以自己画或者是直接上传已有的)

正面提示词:masterpiece, best quality, 1girl, solo, long_hair, looking_at_viewer, smile, dress, ribbon, jewelry, very_long_hair, hair_ribbon, flower, bracelet, two_side_up, hand_on_own_face, head_rest, hand_on_own_cheek, lineart, monochrome, lora:animeoutlineV4_16:1

负面提示词:EasyNegative, badhandv4

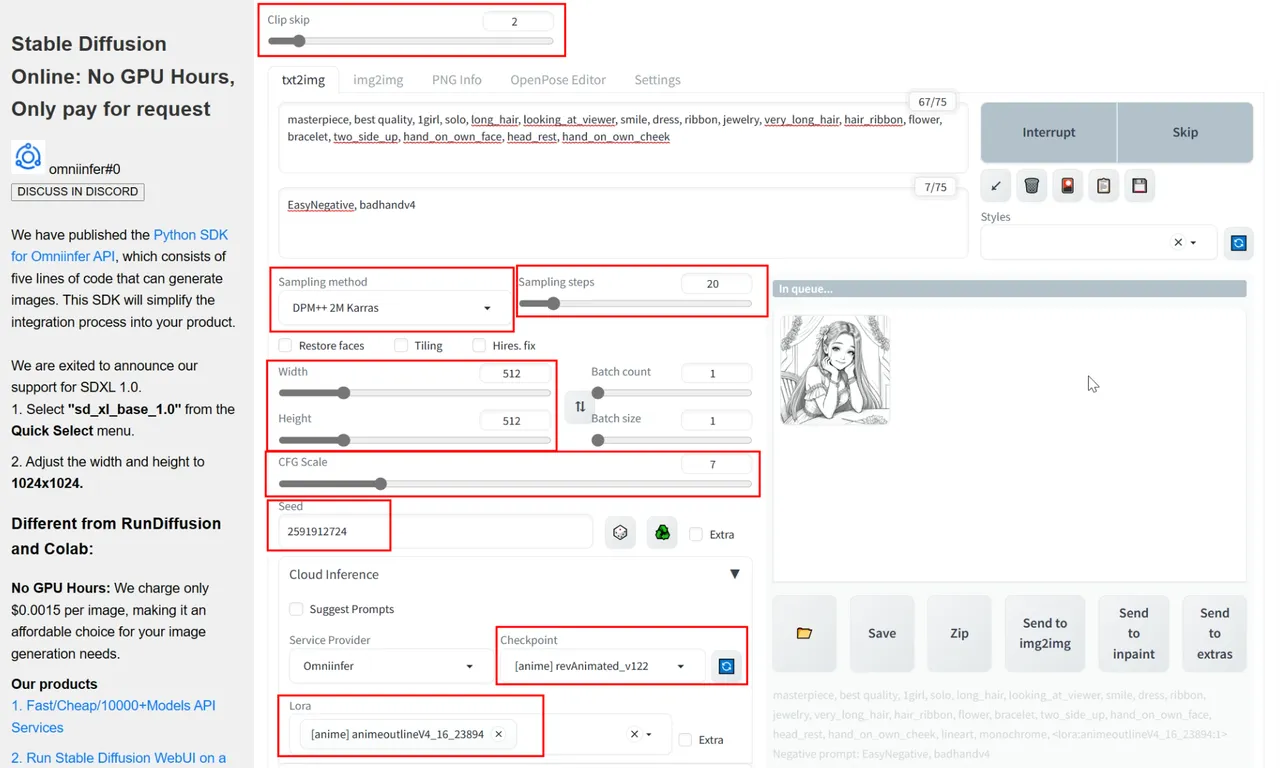

其他的信息(Other information):

Clip skip:2

Sampling method: DPM++ 2M Karras

Sampling Steps: 20

Size: 512x512

CFG scale: 7

Seed: 2591912724

Checkpoint: revAnimated_v122

Lora:animeoutlineV4_16_23894

生图工具:

Free NO GPU WebUI

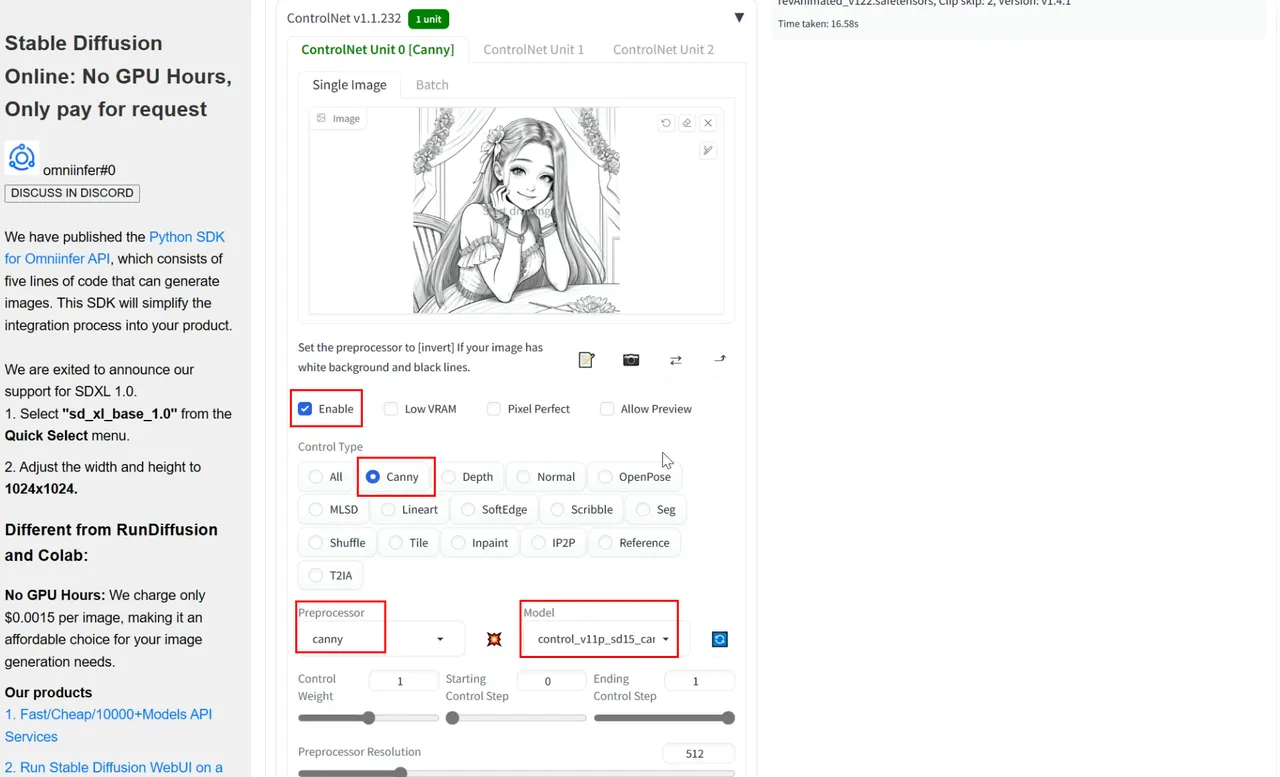

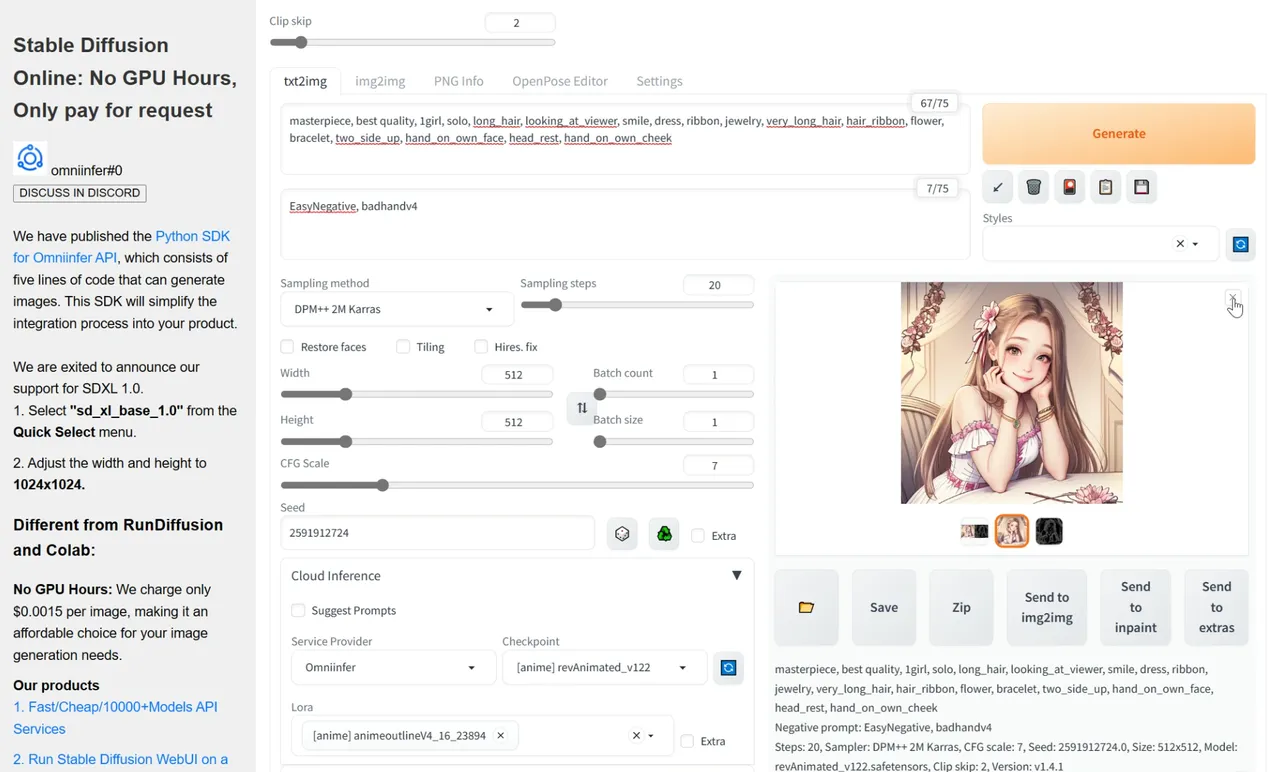

二、给黑白线稿上色

打开ControlNet插件,上传生成的黑白线稿,点击启用,选择控制模型canny,接着会对应生成预处理器canny,模型control_v11p_sd15。其他的参数可以保持默认。最后点击生成即可给黑白线稿上色。

题外话

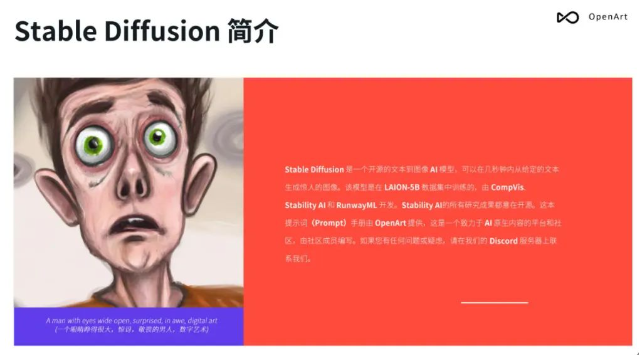

Stable Diffusion 最强提示词手册

- Stable Diffusion介绍

- OpenArt介绍

- 提示词(Prompt) 工程介绍

- …

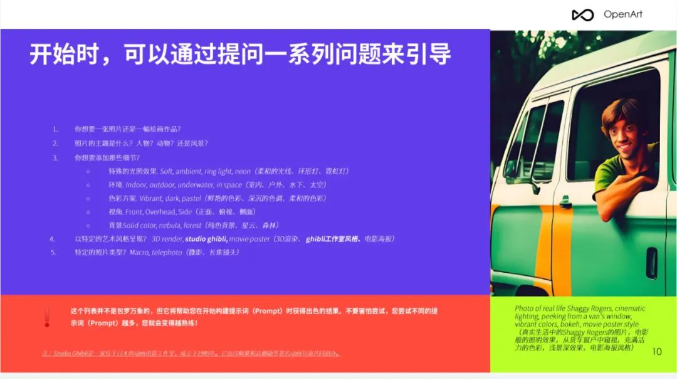

第一章、提示词格式

- 提问引导

- 示例

- 单词的顺序

- …

有需要的朋友,可以点击下方卡片免费领取!

第二章、修饰词(Modifiers)

- Photography/摄影

- Art Mediums/艺术媒介

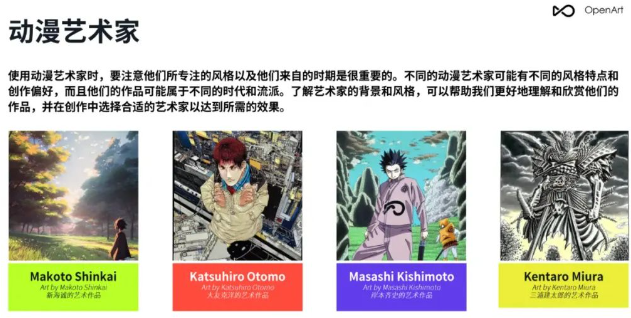

- Artists/艺术家

- Illustration/插图

- Emotions/情感

- Aesthetics/美学

- …

第三章、 Magic words(咒语)

- Highly detailed/高细节

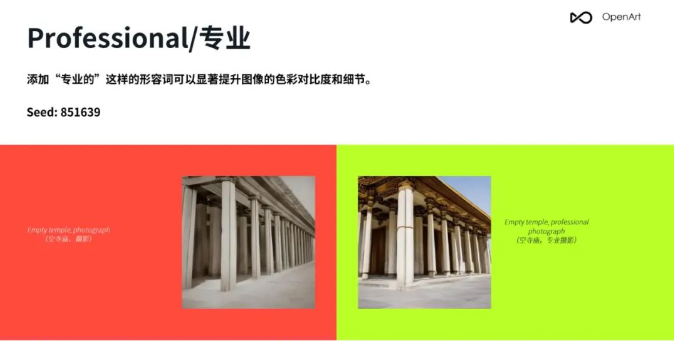

- Professional/专业

- Vivid Colors/鲜艳的颜色

- Bokeh/背景虚化

- Sketch vs Painting/素描 vs 绘画

- …

第四章、Stable Diffusion参数

- Resolution/分辨率

- CFC/提词相关性

- Step count/步数

- Seed/种子

- Sampler/采样

- 反向提示词(Prompt)

第5章 img2img(图生图),in/outpainting(扩展/重绘)

- 将草图转化为专业艺术作品

- 风格转换

- lmg2lmg 变体

- Img2lmg+多个AI问题

- lmg2lmg 低强度变体

- 重绘

- 扩展/裁剪

- …

第6章 重要提示

- 词语的顺序和词语本身一样重要

- 不要忘记常规工具

- 反向提示词(Prompt)

- …

第7章 OpenArt展示

- 提示词 (Prompt)

- 案例展示

- …

篇幅有限,这里就不一一展示了,有需要的朋友可以扫描下方的卡片进行领取!

426

426

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?