文章和代码下载地址:

STRCF: Feng Li, Cheng Tian, Wangmeng Zuo, Lei Zhang, Ming-Hsuan Yang. "Learning Spatial-Temporal Regularized Correlation Filters for Visual Tracking." CVPR (2018). [paper] [github]

一、创新点

1、加入了时间正则项,防止模型的腐败

2、使用ADMM迭代求解,获得实时性

二、原理

1、revisit SRDCF

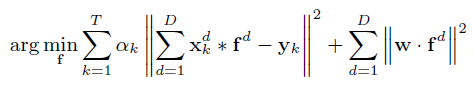

SRDCF提出求解滤波器f的公式如下:

是样本权重,一般都是全部设置为1,可以不用管。

表示卷积,w是一个空间权值函数,参照SRDCF,是用来解决边界效应的。SRDCF使用Gauss-Seidel迭代函数来求解滤波器f,速度约4FPS,实时性不高。

2、STRCF

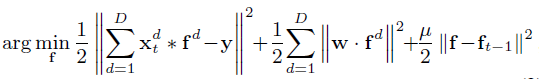

对比着来看,STRCF就是比SRDCF多了最后一项。表示前一帧学习到滤波器,

是时间正则因子。

最小化这个公式道理很简单,就是保证求得的f与历史的滤波器尽可能地相似,防止模型的腐败,对抗遮挡也能起到不错的作用。个人认为加入时间正则项比通过固定学习率来更新模型有效一些,因为作者把这种更新约束直接加到了滤波器的求解当中,而不是独立的通过学习率来更新。

3、ADMM求解

引入了辅助变量g,转化为两个子问题,通过ADMM迭代求解。标准的ADMM解法,过程就不赘述了,可以参考:相关滤波跟踪算法中ADMM的使用_博博有个大大大的Dream-CSDN博客_admm算法

5499

5499

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?