一、软件准备

默认java开发环境是安装了的,不会的自己去查找。准备安装软件:scala(spark需要scala环境),spark,hadoop。

二、安装Scala

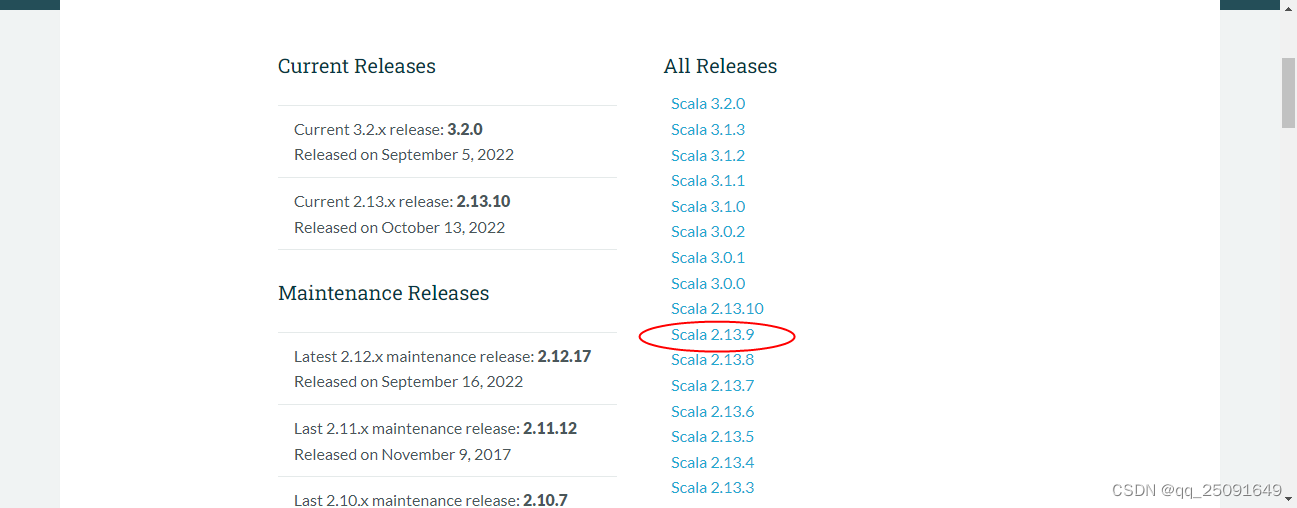

下载地址:[http://www.scala-lang.org/download/all.html]

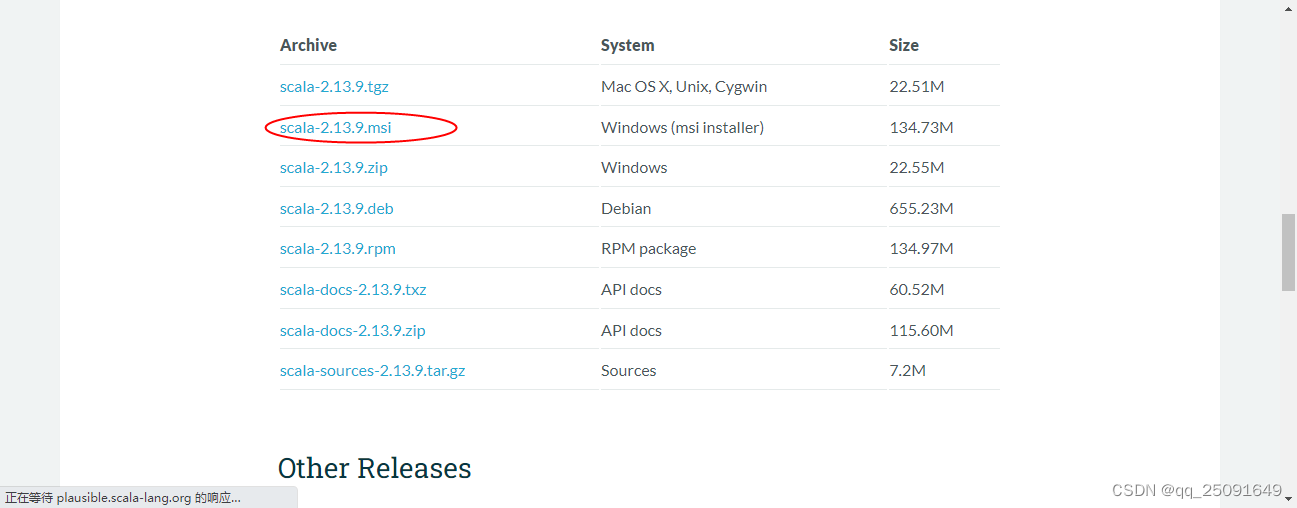

我下载的是2.13.9版本的。点进去后下载如下图文件:

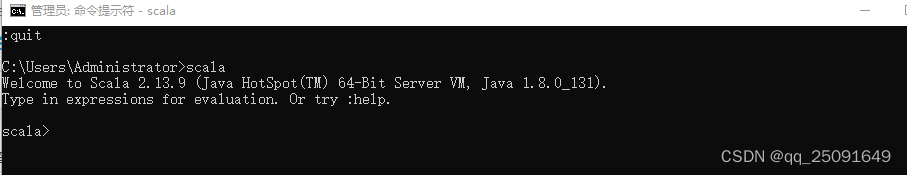

下载好后,点击安装文件直接安装。Scala安装好之后呢,它会自动在环境变量PATH里面配置。我们不需要进行手动配置了。下面就打开cmd输入Scala看下安装后控制台的输出效果。

三、安装hadoop

1.hadoop下载

hadoop我选择的版本是3.1.0,windows安装还需要winutils,下载地址:链接:https://pan.baidu.com/s/1brUBXJvXlPG7KU4lXDcrZA

提取码:wqd9

里面有两个文件:hadoop-3.1.0.tar.gz,apache-hadoop-3.1.0-winutils-master.zip

2.安装

1.解压文件

解压hadoop-3.1.0.tar.gz,我的hadoop-3.1.0解压后文件夹的路径为E:\hadoop-3.1.0;在解压apache-hadoop-3.1.0-winutils-master.zip文件将bin文件夹复制到E:\hadoop-3.1.0替换该目录下的bin。

2.配置环境变量

在新建系统变量中:变量名填HADOOP_HOME,变量值填hadoop-3.1.0对应的路径(比如我的是E:\hadoop-3.1.0)

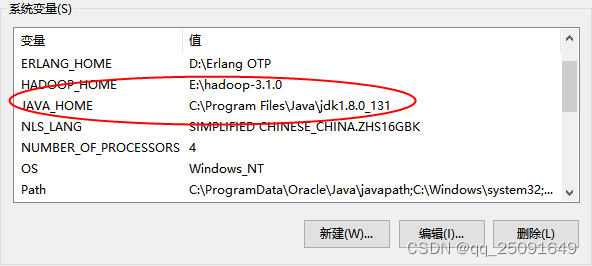

顺便可以检查一下JAVA_HOME有没有配置好,后面会用到

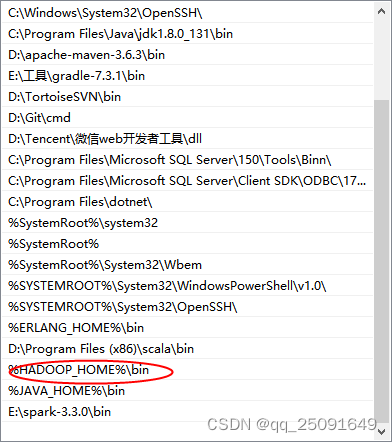

然后点击Path变量进行编辑,在最前面加上%HADOOP_HOME%\bin,配置完后如图所示:

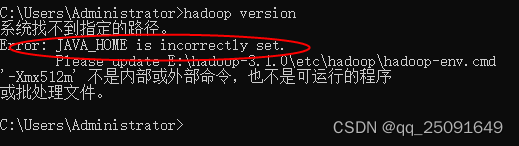

3.检查环境变量是否配置成功

配置好环境变量后,win+R 输入cmd打开命令提示符,然后输入hadoop version,按回车,如果出现如图所示版本号,则说明安装成功。我在安装过程中,敲入命令后发现报错:

如果JAVA_HOME环境变量配置也没问题,则说明是错误提示中的配置文件中的JAVA_HOME配置有问题。

如果JAVA_HOME环境变量配置也没问题,则说明是错误提示中的配置文件中的JAVA_HOME配置有问题。

该目录下的配置文件中的JAVA_HOME目录是:C:\Program Files\Java\jdk1.8.0_131

因为Program Files中间存在空格,所以出现错误,只需要用PROGRA~1代替Program Files即可。

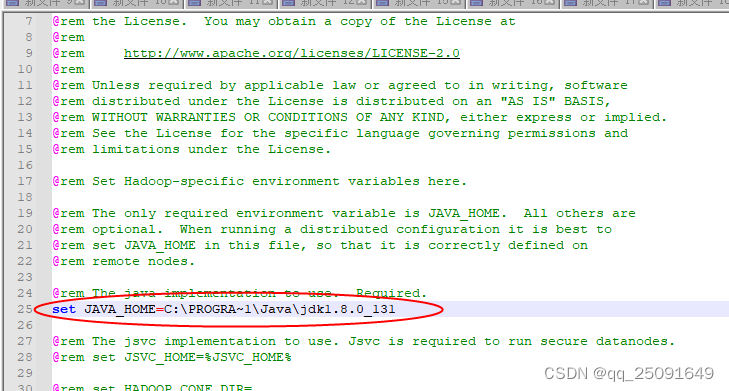

4.报错的解决方法

1.方法一:修改E:\hadoop-3.1.0\etc\hadoop\hadoop-env.cmd配置文件的JAVA_HOME目录改为:set JAVA_HOME=C:\PROGRA~1\Java\jdk1.8.0_131

2.方法二:把jdk安装到根目录或者不存在空格的目录下即可。

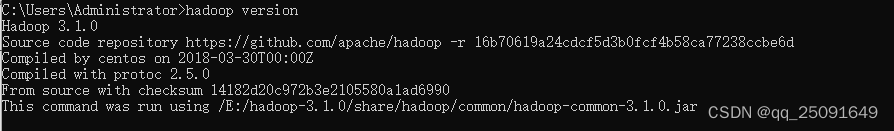

我采用的第一个方法。修改后,在运行命令,检验结果:

四、安装Spark

1.下载

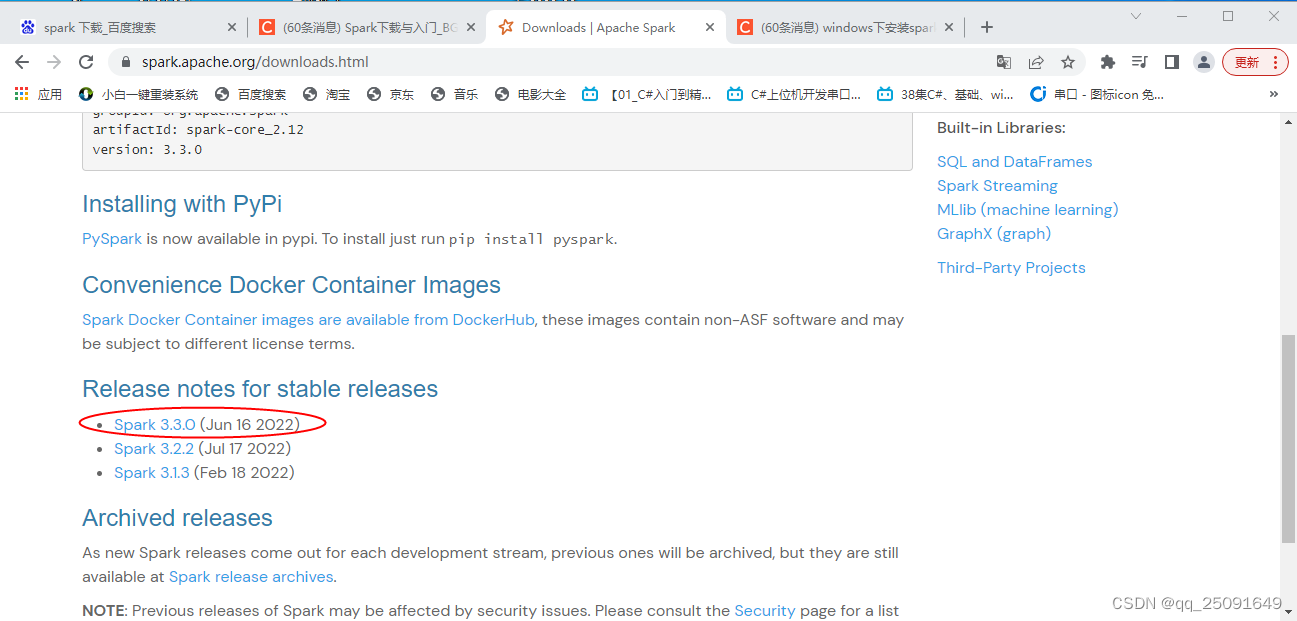

下载地址:https://spark.apache.org/downloads.html

我下载的是Spark 3.3.0版本。

2.安装

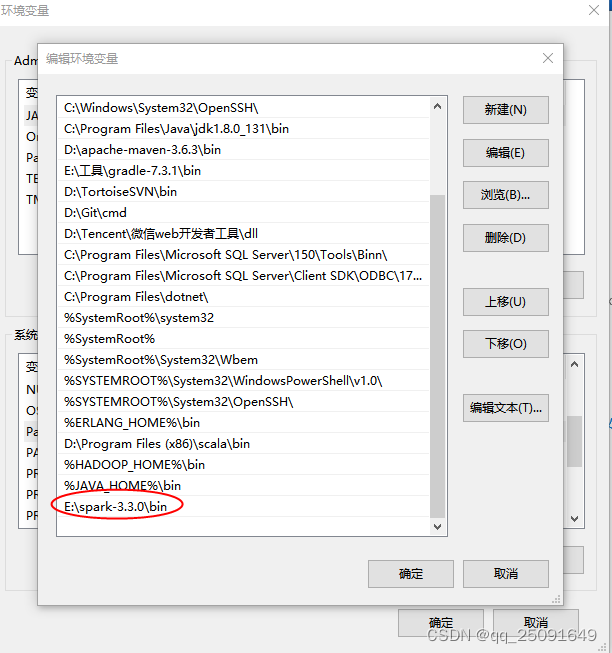

解压下载好的spark-3.3.0-bin-hadoop3.tgz到E:\spark-3.3.0,然后配置一下Path环境变量就可以了

注:解压目录根据自己实际解压目录来。

3.验证

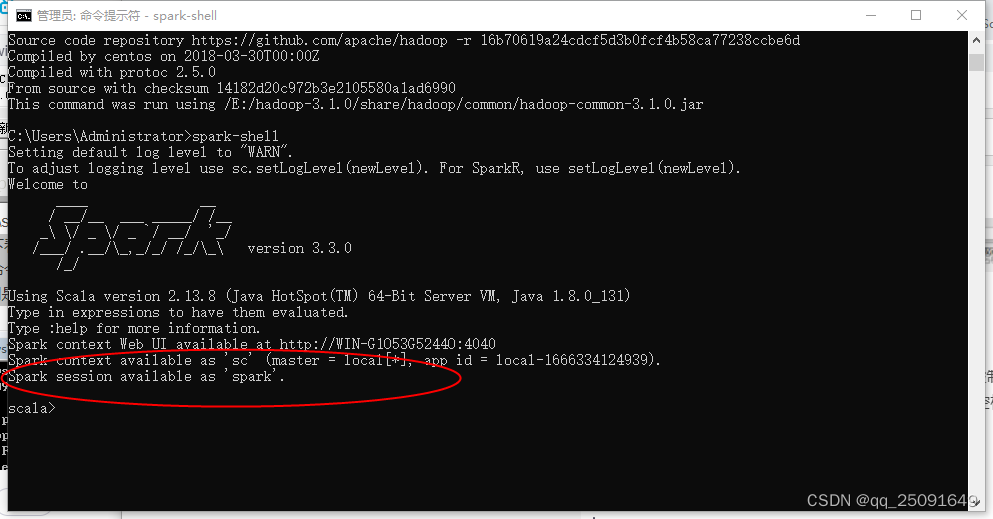

下面我们来验证一下看spark是否能正常启动。 在控制台输入下命令:spark-shell 注意spark-shell之间是没有空格的,千万不要输错了。 情况看图片

至此,windows下搭建spark环境完成。

744

744

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?