经过了这么多这么多铺垫,终于可以进入正题了!

使用ACL接口在NPU上推理

目前在ACL中我们一般使用aclmdlExecuteAsync[1]接口调用NPU做推理,下面是调用的流程[2]:

- 调用aclmdlQuerySize接口查询模型需要的内存大小。

- 调用aclrtMalloc为模型分配device memory。

- 调用aclmdlLoadFromFileWithMem将模型从文件加载到device memory中,并且得到一个model id

- 调用aclmdlGetDesc根据model id获得对应model的信息,如:model输入输出buffer个数,每个buffer大小。

- 用户预先分配好输入输出buffer并且将输入数据准备好,使用aclmdlDataset系列接口[3]配置输入输出dataset。

- 调用aclmdlExecuteAsync启动推理。

- 调用aclrtSynchronizeStream等待推理完成,读取输出buffer的数据。

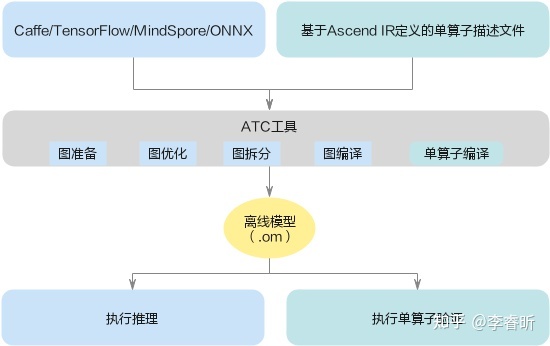

生成离线模型

简单来说生成离线模型就是把现在AI框架的prototxt/pb/onnx等模型文件编译成NPU能运行的om文件,详细介绍请参考文档[4]。我也提供了一个简单的yolov3模型转换的例子:

生成离线模型需要使用atc工具,atc工具需要一台PC安装CANN的开发环境,配置开发环境比较复杂,我写了一份Dockerfile,有需要的人可以使用这个脚本直接构建镜像,节省时间。

AIPP

AIPP是一个对模型输入做预处理的模块,比如NPU的输入是视频解码的YUV420SP格式的图片,然而神经网络模型需要的RGB格式的输入,这个时候就需要使用AIPP完成这个YUV->RGB格式的转换。AIPP文档

参考

- ^aclmdlExecuteAsync aclmdlExecuteAsync_昇腾CANN社区版(5.0.2.alpha003)(推理)_应用开发(C++)_AscendCL API参考_模型加载与执行_华为云

- ^acl_model.cpp https://github.com/lenLRX/Atlas_ACL_E2E_Demo/blob/master/src/acl_model.cpp

- ^aclmdldataset接口 aclmdlCreateDataset_昇腾CANN社区版(5.0.2.alpha003)(推理)_应用开发(C++)_AscendCL API参考_数据类型及其操作接口_aclmdlDataset_华为云

- ^atc介绍 基础知识_昇腾CANN社区版(5.0.2.alpha003)(推理)_ATC模型转换_华为云

393

393

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?