近来研究通过RNN的Seq2Seq模型处理文本正则化(Text Normalization)时准备用到注意力机制,因此拜读了注意力机制在自然语言处理的神经机器翻译(以下简称NMT)的两篇论文:

- 《NEURAL MACHINE TRANSLATION BY JOINTLY LEARNING TO ALIGN AND TRANSLATE》

- 《Effective Approaches to Attention-based Neural Machine Translation》

首先是第一篇《NEURAL MACHINE TRANSLATION BY JOINTLY LEARNING TO ALIGN AND TRANSLATE》,这篇论文算是在自然语言处理(NLP)中第一个使用attention机制的工作,将attention机制用到了神经网络机器翻译(NMT),NMT其实就是一个典型的Seq2Seq模型,也就是一个encoder to decoder模型,传统的NMT使用两个RNN,一个RNN对源语言进行编码,将源语言编码到一个固定维度的中间向量,再使用一个RNN进行解码翻译到目标语言:

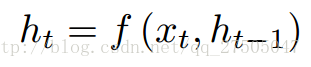

按照论文所述,encoder中的每个隐层单元的计算公式为:

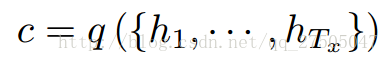

encoder的输出语义编码向量c为:

而decoder通过将联合概率p(y)分解成有序条件来定义翻译y的概率:

本文探讨了注意力机制在神经机器翻译(NMT)中的应用,主要涉及两篇论文。第一篇提出将注意力机制引入Seq2Seq模型,通过加权源语言向量计算期望值来提高翻译准确性。第二篇论文扩展了注意力机制,提出了全局和局部注意力模型,其中全局模型考虑所有输入单词,而局部模型在固定窗口内进行计算,降低了计算成本。实验表明局部模型的效果优于全局模型。

本文探讨了注意力机制在神经机器翻译(NMT)中的应用,主要涉及两篇论文。第一篇提出将注意力机制引入Seq2Seq模型,通过加权源语言向量计算期望值来提高翻译准确性。第二篇论文扩展了注意力机制,提出了全局和局部注意力模型,其中全局模型考虑所有输入单词,而局部模型在固定窗口内进行计算,降低了计算成本。实验表明局部模型的效果优于全局模型。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?