大模型智能|原创

作者 | 小夏

跨语言大模型(MLLMs)能够利用强大的大型语言模型处理和回应多种语言的查询,在多语言自然语言处理任务中取得了显著的成功。尽管取得了这些突破,但仍然缺乏一份全面的调查总结该领域现有方法和最新发展。因此,在本文中,我们进行了深入的综述,并提供了一个统一的视角,总结了多语言大型语言模型领域的最新进展和新兴趋势。本文的贡献可以总结如下:(1)首次综述:据我们所知,我们首次按照多语言对齐的方式对MLLMs研究领域进行了深入综述;(2)新分类法:我们提供了一个新的统一视角,总结了MLLMs的当前进展;(3)前沿与挑战:我们重点介绍了几个新兴领域并讨论了相应的挑战;(4)丰富资源:我们收集了丰富的开源资源,包括相关论文、数据语料库和排行榜。我们希望我们的工作能够推动MLLMs领域的突破性研究。

https://arxiv.org/pdf/2404.04925.pdf

01

跨语言对齐

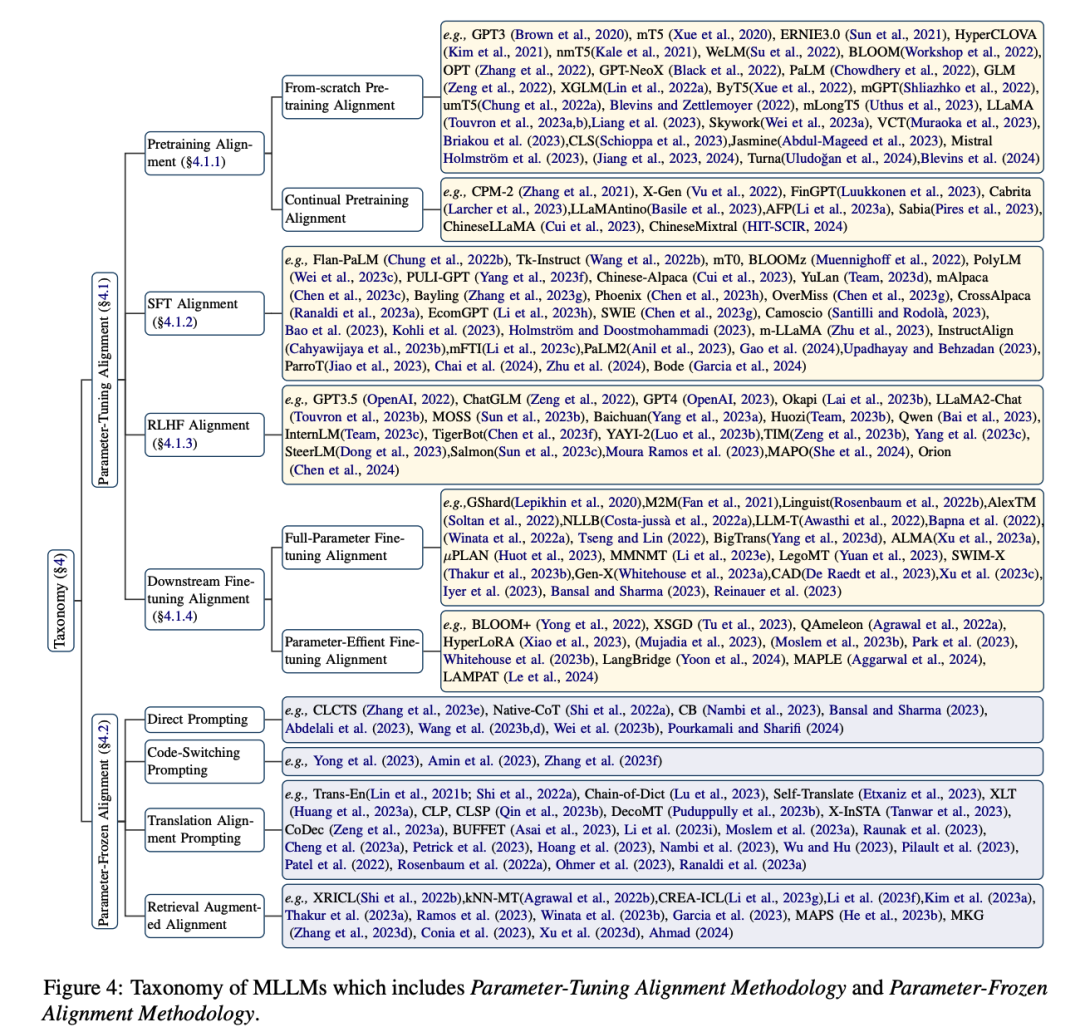

本文从预训练对齐、指令微调对齐以及下游任务微调对齐分别进行了详细的归纳和介绍:

在每个对齐中,又分为Parameter-Tuning对齐与Parameter-Frozen对齐,具体示例图如下:

Parameter-Tuning对齐

Parameter-Frozen对齐

02

未来方向

该综述探讨了目前跨语言大语言模型潜在的未来研究方向,主要包括:

1、跨语言大模型中的幻觉问题

2、跨语言大模型中的知识编辑问题

3、跨语言大模型中的安全性问题

4、跨语言大模型中的公平性问题

5、跨语言大模型中的语言扩展问题

6、跨语言大模型中的模态扩展问题

03

网站

在这项工作中,作者们还提供了一个网站来整理跨语言大模型的相关进展,地址为:https://multilingual-llm.net/

相关的GitHub地址如下:https://github.com/LightChen233/Awesome-Multilingual-LLM

备注:昵称-学校/公司-方向/会议(eg.ACL),进入技术/投稿群

id:DLNLPer,记得备注呦

本文详细介绍了跨语言大模型MLLMs的研究进展,包括预训练对齐、微调策略,以及面临的幻觉、知识编辑等挑战。作者还提出了未来研究方向,并提供了相关资源链接。

本文详细介绍了跨语言大模型MLLMs的研究进展,包括预训练对齐、微调策略,以及面临的幻觉、知识编辑等挑战。作者还提出了未来研究方向,并提供了相关资源链接。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?