CVPR2020: VectorNet:编码高清地图和代理动态从矢量化表示

Jiyang Gao1∗ Chen Sun2∗ Hang Zhao1 Yi Shen1 Dragomir Anguelov 1 Congcong Li1 Cordelia Schmid 2 1Waymo LLC 2 Google Research

摘要

动态多智能体系统中的行为预测是自动驾驶汽车环境中的一个重要问题,因为道路组件的复杂表示和相互作用,包括移动代理(例如行人和车辆)和道路上下文信息(例如车道,交通灯)。VectorNet是一种层次图神经网络,它首先利用向量表示的单个道路组件的空间局部性,然后对所有组件之间的高阶相互作用进行建模。最近的方法是将移动主体的轨迹和道路环境信息呈现为鸟瞰图,并用卷积神经网络(ConvNets)对其进行编码,与此相反,我们的方法是在矢量表示上操作的。通过对矢量化的高清地图和智能体轨迹进行操作,我们避免了有损渲染和计算密集型的卷积神经网络编码步骤。为了进一步提高VectorNet在学习上下文特征方面的能力,我们提出了一种新的辅助任务,基于上下文来恢复随机屏蔽的地图实体和智能体轨迹。我们在内部行为预测基准和最近发布的Argoverse预测数据集上评估了VectorNet。我们的方法在两个基准测试中实现了与竞争渲染方法相当或更好的性能,同时节省了70%以上的模型参数,FLOPs降低了一个数量级。它在Argoverse数据集上的表现也超过了目前的水平

1. Introduction

本文主要研究复杂多智能体系统中的行为预测问题,如自动驾驶汽车。核心兴趣是找到一个统一的表示,将感知系统(如对象检测和跟踪)获得的代理动态与场景上下文(通常以高清(HD)地图的形式作为先验知识提供)集成在一起。我们的目标是建立一个系统来学习预测车辆的意图,这些车辆被参数化为轨迹。

传统的行为预测方法是基于规则的,即根据路线图中的约束条件生成多个行为假设。最近,许多基于学习的方法被提出[5,6,10,15];它们提供了对不同行为假设的概率解释的好处,但需要建立一个表示来编码地图和轨迹信息。

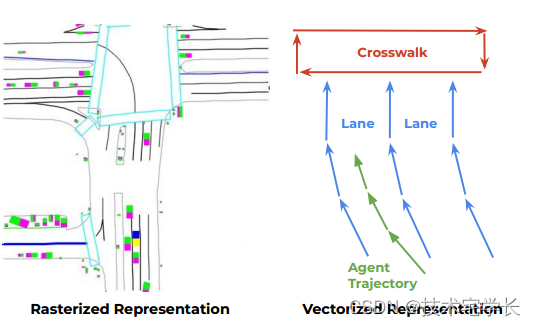

有趣的是,虽然高清地图是高度结构化的,组织为具有位置(如车道)和属性(如绿色交通灯)的实体,但大多数方法选择将高清地图呈现为颜色编码属性(图1,左),这需要手动规范;并使用接受域有限的卷积神经网络对场景上下文信息进行编码。这就提出了一个问题:我们能否直接从结构化的高清地图中学习到有意义的上下文表示?

图1所示。栅格化渲染(左)和矢量化方法(右)的说明,以表示高清地图和智能体轨迹。

我们建议直接从多智能体的矢量化形式学习多智能体动态和结构化场景上下文的统一表示(图1,右)。道路特征的地理范围可以是地理坐标中的点、多边形或曲线。例如,车道边界包含多个控制点,这些控制点构建样条;人行横道是由几个点定义的多边形;停车标志由一个点表示。所有这些地理实体都可以近似为由多个控制点及其属性定义的折线。类似地,移动代理的动力学也可以通过基于其运动轨迹的折线来近似。所有这些折线都可以表示为向量集。

我们使用图神经网络(gnn)来合并这些向量集。我们将每个向量视为图中的一个节点,并将节点特征设置为每个向量的起始位置和结束位置,以及其他属性(如折线组id和语义标签)。来自高清地图的上下文信息,以及其他移动代理的轨迹,通过GNN传播到目标代理节点。然后,我们可以使用与目标智能体对应的输出节点特征来解码其未来的轨迹。

具体来说,为了学习与gnn的竞争表示,我们观察到基于节点的空间和语义接近性来约束图的连通性是很重要的。因此,我们提出了一种分层图架构,将具有相同语义标签的属于相同折线的向量连接并嵌入到折线特征中,然后所有折线相互完全连接以交换信息。我们用多层感知器实现了局部图,用自关注[30]实现了全局图。我们的方法概述如图2所示。

最后,由于最近从顺序语言[11]和视觉数据[27]中成功地进行自监督学习,我们在行为预测目标之外提出了一个辅助的图完成目标。

更具体地说,我们随机屏蔽掉属于场景上下文或智能体轨迹的输入节点特征,并要求模型重建被屏蔽的特征。

直觉是鼓励图网络更好地捕捉代理动态和场景上下文之间的交互。

总之,我们的贡献是:

•我们首次展示了如何直接将矢量化的场景上下文和智能体动态信息结合起来进行行为预测。

•提出了层次图网络VectorNet和节点补全辅助任务。

•我们在我们的内部行为预测数据集和Argoverse数据集上评估了提出的方法,并表明我们的方法在竞争性渲染基线上实现了同等或更好的性能,节省了70%的模型大小,并降低了FLOPs的数量级。我们的方法在Argoverse上也实现了最先进的性能。

2. Related work

自动驾驶行为预测。移动智能体的行为预测在自动驾驶应用中变得越来越重要[7,9,19],高保真地图已被广泛用于提供上下文信息。例如,IntentNet[5]提出联合探测车辆,并根据激光雷达点和渲染的高清地图预测其轨迹。Hong等人[15]假设提供了车辆检测,并通过使用卷积神经网络编码实体交互来关注行为预测。

类似地,MultiPath[6]也使用ConvNets作为编码器,但是采用预先定义的轨迹锚(trajectory anchors)来回归多个可能的未来轨迹。PRECOG[23]试图通过基于流的生成模型捕捉未来的随机性。与[6,15,23]类似,我们也假设代理检测是由现有的感知算法提供的。

然而,与这些方法都使用卷积神经网络来编码渲染的道路地图不同,我们建议直接编码矢量化的场景上下文和智能体动态。

预测多智能体交互Forecasting multi-agent interactions。在自动驾驶领域之外,更普遍的兴趣是预测交互代理的意图,例如行人[2,13,24],人类活动[28]或体育运动员[12,26,32,33]。其中,Social LSTM[2]将单个智能体的轨迹建模为独立的LSTM网络,并根据智能体的空间接近度聚合LSTM隐藏状态来建模它们之间的相互作用。

社会GAN[13]简化了交互模块,并提出了一个对抗性鉴别器来预测不同的未来。

Sun等[26]将图网络[4]与变分rnn[8]相结合,对多种交互进行建模。社会互动也可以从数据中推断出来:Kipf等人将这种互动视为潜在变量;图注意网络[16,31]应用自注意机制对预定义图中的边进行加权。我们的方法更进一步,提出了一个统一的分层图网络来联合建模多个智能体之间的交互,以及它们与来自路线图的实体之间的交互。

实体集合的表示学习Representation learning for sets of entities。传统的机器感知算法一直专注于高维连续信号,如图像、视频或音频。一个例外是3D感知,其输入通常是由深度传感器给出的无序点集。例如,Qi等人提出了PointNet模型[20]和PointNet++[21],用于对学习到的点嵌入应用排列不变操作(例如最大池化)。与点集不同,高清地图上的实体和代理轨迹形成封闭形状或定向,它们也可能与属性信息相关联。因此,我们建议通过向量化输入来保留这些信息,并将属性编码为图中的节点特征。

自监督上下文建模Representation learning for sets of entities。最近,NLP领域的许多工作都提出了一种自监督的方式来建模语言上下文[11,22]。他们学习的表征在转移到下游任务时取得了显著的性能提高。受这些方法的启发,我们提出了一种用于图表示的辅助损失方法,该方法学习从其邻居中预测缺失的节点特征。目标是激励模型更好地捕获节点之间的交互。

3.VectorNet方法

本节介绍我们的VectorNet方法。我们首先描述了如何对智能体轨迹和高清地图进行矢量化。接下来,我们提出了分层图网络,它从单个折线聚合局部信息,然后在所有轨迹和地图特征上进行全局聚合。这个图可以用于行为预测。

3.1. 表示轨迹和地图

3.1. Representing trajectories and maps

高清地图上的大多数注释都是样条(如车道)、封闭形状(如十字路口区域)和点(如交通灯)的形式,并带有额外的属性信息,如注释的语义标签及其当前状态(如交通灯的颜色、道路的速度限制)。对于智能体,它们的轨迹是关于时间的有向样条的形式。

所有这些元素都可以近似为向量序列:对于地图特征,我们选择一个起始点和方向,在相同的空间距离上从样条中均匀地采样关键点,并将相邻的关键点依次连接成向量;对于轨迹,我们可以用固定的时间间隔(0.1秒)采样关键点,从t = 0开始,并将它们连接到向量中。

给定足够小的空间或时间间隔,得到的折线作为原始地图和轨迹的近似值。

我们的矢量化过程是连续轨迹、映射注释和向量集之间的一对一映射,尽管后者是无序的。这允许我们在向量集之上形成一个图表示,它可以通过图神经网络编码。更具体地说,我们将属于折线Pj的每个向量vi视为图中的一个节点,其节点特征由

![]()

其中d1和d1是矢量的起点和终点的坐标,d本身可以表示为(x, y)对于二维坐标或(x, y, z)对于三维坐标;Ai对应于属性特征,例如对象类型、轨迹的时间戳、道路特征类型或车道的速度限制;j为Pj的整数id,表示vi∈Pj。

为了使输入节点特征与目标智能体的位置保持不变,我们将所有向量的坐标归一化,使其在目标智能体的最后一个观测时间步的位置为中心。未来的工作是共享所有相互作用的代理的坐标中心,这样它们的轨迹可以并行预测。

3.2. 构造折线子图

3.2. Constructing the polyline subgraphs

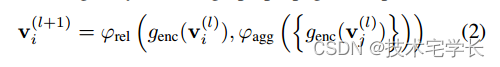

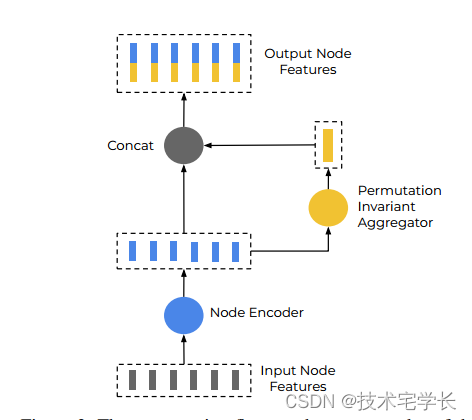

为了利用节点的空间和语义局部性,我们采用分层方法,首先在向量级构造子图,其中属于同一折线的所有向量节点彼此连接。考虑一条折线P,其节点为{v1, v2,…, vP},我们将单层子图传播操作定义为

式中,v (l) I为子图网络第l层的节点特征,v (0) I为输入特征vi。函数genc(·)对单个节点的特征进行变换, agg(·)对所有相邻节点的信息进行聚合, rel(·)是节点vi与其相邻节点之间的关系运算符。

在实践中,genc(·)是一个多层感知器(MLP),其权重在所有节点上共享;具体来说,MLP包含一个完全连接的层,然后是层归一化[3],然后是ReLU非线性。

ϕagg(·)是maxpooling操作,而ϕrel(·)是一个简单的连接。图3显示了一个示例。我们将子图网络的多个层堆叠起来,其中genc(·)的权重是不同的。最后,通过计算得到折线水平特征

其中,ϕagg(·)也是maxpooling。

我们的折线子图网络可以看作是PointNet[20]的泛化:当我们设d s = d e,并令a和l为空时,我们的网络具有与PointNet相同的输入和计算流程。然而,通过将排序信息嵌入到向量中,基于折线分组约束子图的连通性,并将属性编码为节点特征,我们的方法特别适合编码结构化地图注释和智能体轨迹。

图3。同一折线的矢量节点上的计算流程。

3.3. 高阶交互的全局图

3.3. Global graph for high-order interactions

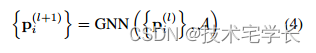

我们现在考虑在折线节点特征{p1, p2,…, pP},具有全局交互图:

其中{p (l) i}为折线节点特征集,GNN(·)对应图神经网络的单层,a对应折线节点集的邻接矩阵。

邻接矩阵A可以提供一个启发式,例如使用节点之间的空间距离[2]。

为简单起见,我们假设A是一个全连通图。

我们的图网络被实现为一个自关注操作[30]:

其中P为节点特征矩阵,PQ、PK、PV为其线性投影。

然后,我们从移动代理对应的节点解码未来的轨迹:

式中,Lt为GNN层总数,;;;;;;为简单起见,我们使用MLP作为解码器函数。更高级的解码器,如来自MultiPath[6]的基于锚点的方法,或变分rnn[8,26]可用于生成不同的轨迹;这些解码器与我们的输入编码器是互补的。

在我们的实现中,我们使用了单一的GNN层,因此在推理期间,只需要计算目标代理对应的节点特征。然而,我们也可以在需要时堆叠多层GNN(·)来建模高阶相互作用。

为了鼓励我们的全局交互图更好地捕获不同轨迹和地图折线之间的交互,我们引入了一个辅助的图补全任务。

在训练期间,我们随机屏蔽掉一部分折线节点的特征,例如pi。然后我们尝试恢复其被掩盖的特征为:![]()

其中,节点(·)是作为MLP实现的节点特征解码器。在推理期间不使用这些节点特征解码器。

回想一下,pi是全连接无序图中的一个节点。为了识别一个单独的折线节点,当其对应的特征被遮挡时,我们从它的所有所属向量中计算起始坐标的最小值,以获得嵌入p id i的标识符。输入节点的特征变成

![]()

我们的图补全目标与自然语言处理中广泛成功的BERT[11]方法密切相关,BERT[11]方法基于离散和顺序文本数据的双向上下文预测缺失标记。我们将这个训练目标推广到无序图。与最近几种将BERT目标推广到具有预先计算的视觉特征的无序图像补丁的方法(例如[25])不同,我们的节点特征是在端到端框架中共同优化的。

3.4. Overall framework

一旦构建了层次图网络,我们就针对多任务训练目标进行优化

![]()

其中Ltraj是groundtruth未来轨迹的负高斯对数似然,Lnode是预测节点特征和groundtruth屏蔽节点特征之间的Huber损失,α = 1.0是平衡两个损失项的标量。为了通过降低节点特征的大小来避免Lnode的琐碎解,我们在将折线节点特征馈送到全局图网络之前对它们进行了L2归一化。

我们预测的轨迹被参数化为每步坐标偏移,从最后一个观测位置开始。

我们根据目标车辆在最后观察位置的航向旋转坐标系。

4. Experiments

在本节中,我们首先描述实验设置,包括数据集、度量和栅格化+ ConvNets基线。其次,对栅格化基线和VectorNet进行了综合消融研究。第三,我们比较和讨论了计算成本,包括浮点数和参数数。最后,我们将性能与最先进的方法进行比较。

4.1. Experimental setup

4.1.1 Datasets

我们报告了两个车辆行为预测基准测试的结果,即最近发布的Argoverse数据集[7]和我们内部的行为预测数据集。

Argoverse motion forecasting[7]是一个基于轨迹历史的车辆行为预测数据集。有333K个5秒长的序列分为211K的训练序列,41K的验证序列和80K的测试序列。创建者通过挖掘有趣和多样的场景来管理这个数据集,例如为合并的车辆让路,穿过十字路口等。以10Hz的频率对轨迹进行采样,(0,2)秒用于观测,(2,5)秒用于轨迹预测。每个序列都有一个“有趣的”代理,其轨迹是预测目标。除了车辆轨迹外,每个序列还与地图信息相关联。给出了测试集的未来轨迹。除非另有说明,我们的消融研究报告了验证集上的性能。

In-house dataset 是为行为预测而收集的大规模数据集。它包含来自自动内部感知系统的高清地图数据、边界框和跟踪注释,以及手动标记的车辆轨迹。

列车和测试组的车辆轨迹总数分别为2.2M和0.55M。每条轨迹的长度为4秒,其中(0,1)秒是用作观测的历史轨迹,(1,4)秒是要评估的目标未来轨迹。这些轨迹是从现实世界车辆的行为中采样的,包括静止、直行、转弯、变道和倒车,并且大致保留了驾驶场景的自然分布。对于高清地图功能,我们包括车道边界,停车/让行标志,人行横道和减速带。

对于这两个数据集,输入历史轨迹都来自自动感知系统,因此是有噪声的。

Argoverse的未来轨迹也是由机器生成的,而 In-house则手动标记未来轨迹。

4.1.2 Metrics

对于评估,我们采用广泛使用的整个轨迹计算的平均位移误差(ADE)和t (DE@ts)度量的位移误差,其中t∈{1.0,2.0,3.0}秒。位移是以米为单位测量的。

4.1.3栅格化图像的基线

4.1.3 Baseline with rasterized images

我们渲染N个连续的过去帧,其中内部数据集的N为10,Argoverse数据集的N为20。每一帧是一个400×400×3图像,其中包含路线图信息和检测到的对象边界框。在内部数据集中,400像素对应100米,在Argoverse数据集中对应130米。渲染是基于自动驾驶车辆在最后一个观测帧中的位置;自动驾驶车辆在内部数据集中的坐标位置为(200,320),在Argoverse数据集中的坐标位置为(200,200)。所有N帧叠加在一起形成400×400×3N图像作为模型输入。

我们的基线使用ConvNet对光栅化图像进行编码,其架构与IntentNet[5]相当:我们使用ResNet-18[14]作为ConvNet骨干。与互联网不同,我们不使用激光雷达输入。为了获得以车辆为中心的特征,我们从卷积特征图中裁剪目标车辆周围的特征块,并对裁剪后的特征图的所有空间位置进行平均池,得到单个车辆特征向量。我们根据经验观察到,使用更深的ResNet模型或基于目标车辆标题旋转裁剪的特征并不能带来更好的性能。然后将车辆特征输入到一个完全连接的层(如IntentNet所使用的),以并行预测未来的坐标。该模型在8个gpu上进行优化,并进行同步训练。我们使用Adam优化器[17],每5个epoch将学习率衰减0.3倍。我们以0.001的初始学习率训练模型共25个epoch。

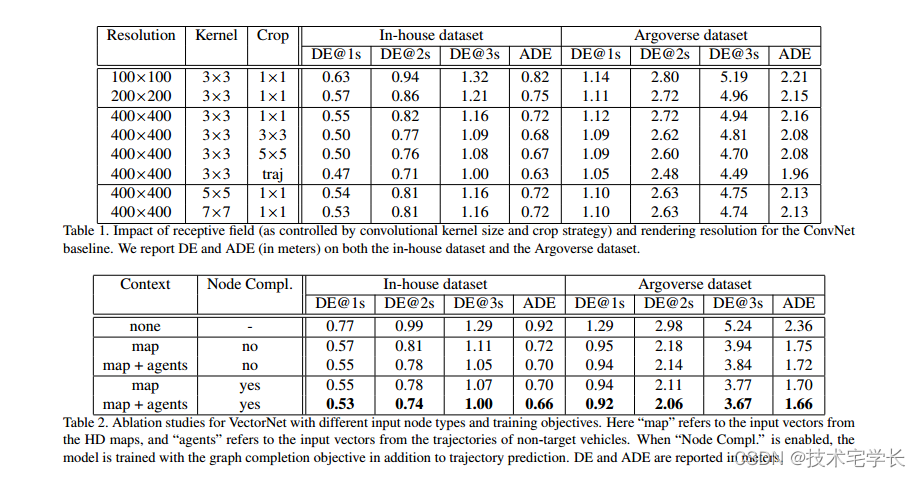

为了测试卷积感受野和特征裁剪策略对性能的影响,我们对网络感受野、特征裁剪策略和输入图像分辨率进行了消融研究

4.1.4矢量化表示的VectorNet

4.1.4 VectorNet with vectorized representations

为了确保公平的比较,矢量化表示采用与栅格化表示相同的信息作为输入。具体来说,我们提取的地图特征与渲染时完全相同。我们还确保目标代理的可见道路特征向量与栅格化表示中的相同。然而,矢量化表示确实具有包含更复杂的道路特征的好处,这些特征对于渲染来说是非琐碎的。

除非另有说明,我们为折线子图使用三个图层,为全局交互图使用一个图层。所有mlp中的隐藏单位数量固定为64。mlp之后是层归一化和ReLU非线性。我们将矢量坐标归一化,使其在最后一个观测时间步长以目标车辆的位置为中心。与栅格化模型类似,VectorNet在8个gpu上与Adam优化器同步训练。学习率每5个epoch衰减0.3倍,我们训练模型共25个epoch,初始学习率为0.001。

为了了解组件对VectorNet性能的影响,我们对上下文信息的类型进行了研究,即是否只使用地图或其他代理的轨迹,以及图层数对折线子图和全局交互图的影响。

4.2. ConvNet基线的消融研究

我们对卷积神经网络接收野、特征裁剪策略和栅格化图像分辨率的影响进行了消融研究。

感受野的影响。由于行为预测通常需要捕获长距离道路环境,因此卷积接受野可能对预测质量至关重要。我们评估了不同的变体,以了解接收域的两个关键因素,卷积核大小和特征裁剪策略如何影响预测性能。结果如表1所示。通过在400×400分辨率下比较内核大小3、5和7,我们可以看到,较大的内核大小可以略微提高性能。然而,这也导致了计算成本的二次增长。我们还比较了不同的种植方法,通过增加作物大小或种植沿车辆轨迹在所有观察到的时间步长。从表1的第3行到第6行,我们可以看到更大的裁剪尺寸(3 vs . 1)可以显著提高性能,并且沿着观察到的轨迹进行裁剪也会带来更好的性能。当栅格化图像被用作输入时,这一观察证实了接受野的重要性。它也突出了它的局限性,在需要精心设计裁剪策略的地方,通常以增加计算成本为代价。

渲染分辨率的影响。我们进一步改变栅格化图像的分辨率,看看它如何影响预测质量和计算成本,如表1的前三行所示。我们测试了三种不同的分辨率,包括400 × 400(每像素0.25米)、200 × 200(每像素0.5米)和100 × 100(每像素1米)。可以看出,随着分辨率的提高,性能普遍提高。然而,对于Argoverse数据集,我们可以看到,将分辨率从200×200增加到400×400会导致性能略有下降,这可以通过固定3×3内核的有效接受场大小减少来解释。我们将在第4.4节讨论这些设计选择对计算成本的影响。

4.3. VectorNet的消融研究

输入节点类型的影响。我们研究了在VectorNet中结合地图特征和代理轨迹是否有帮助。表2中的前三行对应于只使用目标车辆的过去轨迹(“none”上下文),只添加地图折线(“map”),最后添加轨迹折线(“map + agents”)。

我们可以清楚地看到,添加地图信息显著提高了弹道预测性能。

结合弹道信息进一步提高了性能。

节点完成丢失的影响。表2的最后四行比较了添加节点完成辅助目标的影响。我们可以看到,添加这个目标始终有助于提高性能,特别是在较长的时间范围内。

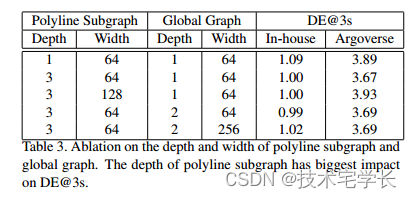

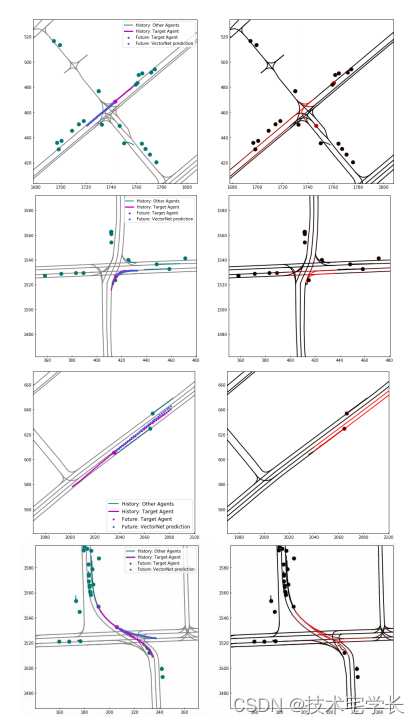

对图架构的影响。在表3中,我们研究了图层深度和宽度对轨迹预测性能的影响。我们观察到,对于折线子图,三层给出了最好的性能,而对于全局图,只需要一层。使mlp更宽并不会带来更好的性能,而且对Argoverse不利,可能是因为它的训练数据集更小。图4显示了预测轨迹和车道注意的一些可视化示例。

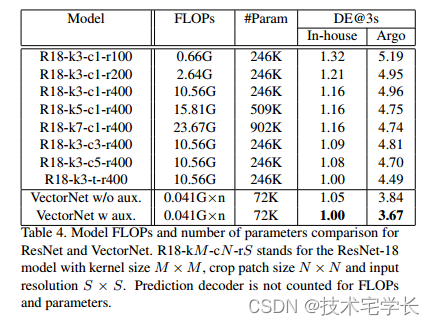

与ConvNets的比较。最后,我们将我们的VectorNet与表4中最好的ConvNet模型进行比较。对于内部数据集,我们的模型达到了与最好的ResNet模型相当的性能,同时在模型大小和FLOPs方面更加经济。对于Argoverse数据集,我们的方法显著优于最佳ConvNet模型,DE@3减少了12%。我们观察到,内部数据集由于其驾驶场景的自然分布而包含大量静止车辆;这些情况都可以很容易地用卷积神经网络解决,因为卷积神经网络善于捕捉局部模式。然而,对于只保留“有趣”案例的Argoverse数据集,VectorNet的表现远远超过了最好的ConvNet基线;大概是由于它能够通过分层图网络捕获远距离上下文信息。

表1。接受野(由卷积核大小和裁剪策略控制)和渲染分辨率对ConvNet基线的影响。我们在内部数据集和Argoverse数据集上报告DE和ADE(以米为单位)。

表2。不同输入节点类型和训练目标下VectorNet的消融研究。这里的“map”指的是来自高清地图的输入向量,“agents”指的是来自非目标车辆轨迹的输入向量。当“Node Compl.”,则除了进行轨迹预测外,还对模型进行图形完成目标的训练。DE和ADE以米为单位报告。

表3。对折线子图和全局图深度和宽度的消融。折线子图的深度对DE@3s的影响最大

表4。ResNet和VectorNet的模型FLOPs和参数数目比较。R18-kM-cN-rS为ResNet-18模型,内核大小M × M,作物补丁大小N × N,输入分辨率S × S, FLOPs和参数不计算预测解码器。

4.4. FLOPs和模型尺寸的比较

现在,我们比较了卷积网络和矢量网络之间的FLOPs和模型大小,以及它们对性能的影响。结果如表4所示。预测解码器不计算FLOPs和参数数量。

我们可以看到,卷积神经网络的FLOPs随核大小和输入图像大小呈二次增长;参数的数量随着内核大小呈二次增长。

由于我们以自动驾驶汽车为中心渲染图像,因此特征图可以在多个目标之间重复使用,因此骨干部分的FLOPs是一个常数。但是,如果渲染的图像以目标为中心,则FLOPs会随着目标的数量线性增加。对于VectorNet, FLOPs取决于场景中矢量节点和折线的数量。对于内部数据集,路线图折线的平均数量为17条,包含205个向量;道路代理折线的平均数目为59条,包含590个矢量。我们根据这些平均值计算flop。请注意,由于我们需要为每个目标重新标准化矢量坐标并重新计算VectorNet特征,FLOPs随着预测目标的数量(表4中的n)线性增加。

将R18-k3-t-r400 (ConvNets中最好的模型)与VectorNet进行比较,VectorNet的性能明显优于ConvNets。在计算方面,对于单个代理,ConvNets比VectorNet多消耗200多倍的FLOPs (10.56G vs 0.041G);考虑到场景中车辆的平均数量在30辆左右(来自内部数据集),VectorNet的实际计算消耗仍然比ConvNets小得多。同时,VectorNet需要ConvNets的29%的参数(72K vs 246K)。通过比较,我们可以看到,VectorNet在显著提升性能的同时,也显著降低了计算成本。

图4。(左)预测的可视化:灰色表示车道,绿色表示非目标代理,粉色表示目标代理的地面真实轨迹,蓝色表示预测轨迹。(右)道路和代理人的注意力可视化:红色越亮,注意力得分越高。可以看出,当智能体面临多个选择(前两个例子)时,注意机制能够关注正确的选择(第二个例子中的两个右转弯车道)。第三个例子是变道代理,参与的车道是当前车道和目标车道。在第四个例子中,虽然预测不准确,但注意力仍然在正确的车道上产生合理的分数。

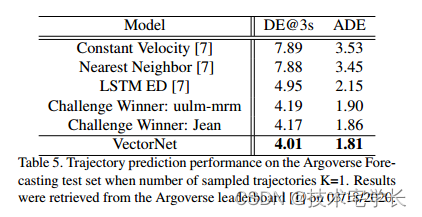

表5所示。当轨迹采样个数K=1时,Argoverse Forecasting测试集上的轨迹预测性能。结果来自Argoverse排行榜[1],日期为2020年3月18日。

4.5. 与最先进方法的比较

最后,我们将VectorNet与几种基线方法[7]和Argoverse[7]测试集上的一些最先进的方法进行比较。我们在表5中报告了K=1的结果(最可能的预测)。基线方法包括恒速基线、最近邻检索和LSTM编码器。最先进的方法是Argoverse预测挑战的获胜者。可以看出,当K=1时,对于DE@3s指标,VectorNet将最先进的性能从4.17提高到4.01。

5. 结论及未来工作

我们提出用矢量化表示高清地图和智能体动态。我们设计了一种新的分层图网络,其中第一级聚合了折线内向量之间的信息,第二级建模了折线之间的高阶关系。在大型内部数据集和公开可用的Argoverse数据集上的实验表明,所提出的VectorNet优于ConvNet,同时大大降低了计算成本。VectorNet在Argoverse测试集上也达到了最先进的性能(DE@3s, K=1)。下一步自然是将VectorNet编码器与多模态轨迹解码器(例如[6,29])结合起来,以生成不同的未来轨迹。

2284

2284

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?