文章目录

- ocr常用数据集介绍

- Chinese Text in the Wild (CTW data)

- ICPR WTMI2018中文数据集(天池比赛数据集)

- ICDAR数据集

- Reading Chinese Text in the Wild(RCTW-17)

- Chinese Text in the Wild(CTW)

- Total-Text

- Caffe-ocr中文合成数据

- Synthetic Data for Text Localisation

- MSRA-TD500

- COCO-TEXT

- Google FSNS(谷歌街景文本数据集)

- SynthText in the Wild dataset

- Text in Videos

- The Uber Text dataset

- The Chars74K dataset

- 参考链接:

ocr常用数据集介绍

由于项目进展需要用到ocr技术, 因此对现有公开的数据集进行整理和记录,其中部分内容转载于参考链接中的地址,感兴趣的可自行查看.

Chinese Text in the Wild (CTW data)

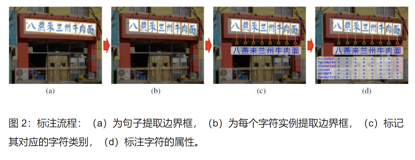

清华大学与腾讯共同推出了中文自然文本数据集(Chinese Text in the Wild,CTW)——一个超大的街景图片中文文本数据集,为训练先进的深度学习模型奠定了基础。目前,该数据集包含 32,285 张图像和 1,018,402 个中文字符,规模远超此前的同类数据集。这些图像源于腾讯街景,从中国的几十个不同城市中捕捉得到,不带任何特定目的的偏好。由于其多样性和复杂性,使得该数据集的收集很困难。它包含了平面文本、凸出文本、城市街景文本、乡镇街景文本、弱照明条件下的文本、远距离文本、部分显示文本等。图像大小2048*2048,数据集大小为31GB。以(8:1:1)的比例将数据集分为训练集(25887张图像,812872个汉字),测试集(3269张图像,103519个汉字),验证集(3129张图像,103519个汉字)。对于每张图像,数据集中都标注了所有中文字符。对每个中文字符,数据集都标注了其真实字符、边界框和 6 个属性以指出其是否被遮挡、有复杂的背景、被扭曲、3D 凸出、艺术化,和手写体等。

文献链接:

数据集下载地址:

数据集下载以及数据说明参考链接:

数据对应的baseline model地址

ICPR WTMI2018中文数据集(天池比赛数据集)

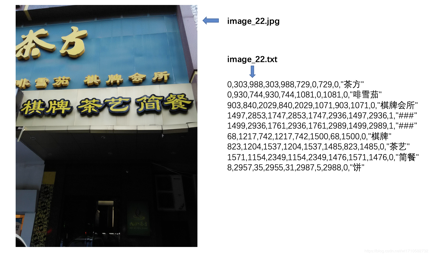

大赛提供20000张图像作为数据集,其中50%作为训练集,50%作为测试集。主要由合成图像,产品描述,网络广告构成。该数据集数据量充分,中英文混合,涵盖数十种字体,字体大小不一,多种版式,背景复杂。文件大小为2GB。

这些图像是网络上最常见的图像类型。每一张图像或者包含复杂排版,或者包含密集的小文本或多语言文本,或者包含水印,这对文本检测和识别均提出了挑战。

对于每一张图像,都会有一个相应的文本文件(.txt)(UTF-8编码与名称:[图像文件名] .txt)。文本文件是一个逗号分隔的文件,其中每行对应于图像中的一个文本串,并具有以下格式:X1,Y1,X2,Y2,X3,Y3,X4,Y4,“文本”其中X1,Y1,Y2,X2,X3,X4,Y3,Y4分别代表文本的外接四边形四个顶点坐标。而“文本”是四边形包含的实际文本内容。

数据集具体介绍链接以及下载地址

ICDAR数据集

ICDAR是进行场景文本检测和识别(Scene Text Detection and Recognition)任务最知名和常用的数据集。

其中ICDAR 2017 RCTW[1](Reading Chinest Text in the Wild),由Baoguang Shi等学者提出。RCTW主要是中文,共12263张图像,其中8034作为训练集,4229作为测试集。使用四边形框标注文本行。

数据集绝大多数是相机拍的自然场景,一些是屏幕截图;包含了大多数场景,如室外街道、室内场景、手机截图等等。

数据集下载链接

训练集图像和标注(8034,7.6G):百度网盘下载 | hust.edu.cn下载

测试集图像(4229,4.1G):谷歌网盘下载 | host.edu.cn下载

图像分辨率:

图像分辨率大小不等,小则300+,大则3000+

图像清晰程度不一,绝大多数背景和文字很清晰,极少数模糊

适用场景:

街道场景:主要是建筑、标志牌、条幅等带有文字的图像,这类场景占据大多数

截图:主要是网络上带有文字的图像截图、手机上带有文字的图像截图、带文字的表情包图像

室内:主要是商场、墙壁等带有文字的图像

证件类:主要是车牌照、驾驶证、身份证等带有文字的图像

文本:

方向(multi-oriented):图像中的文本方向水平、垂直、倾斜均有,绝大多数是水平方向,弯曲方向极少数

大小(multi-scale):由于图像拍照远近,图像有近距离或远距离的,因此文本大小不等,有较多的长文本

质量:少数文本存在模糊、光照不均匀、低分辨率等情况

字体:绝大多数字体为楷书,极少数艺术字,几乎没有手写字体

遮挡:绝大多数文本没有遮挡,极少数有遮挡

标注:

数据集的标注保存在<image_nam>.txt文件中,其中格式如下:

x1,y1,x2,y2,x3,y3,x4,y4,<识别难易程度>,<“文本”>

x1,y1,x2,y2,x3,y3,x4,y4,<识别难易程度>,<“文本”>

x1,y1,x2,y2,x3,y3,x4,y4,<识别难易程度>,<“文本”>

…

注:x1,y1,x2,y2,x3,y3,x4,y4分别为左上、右上、右下、左下四个坐标,值为像素值。

注:<识别难易程度>以0或1表示,0表示容易识别,即图像中文本清晰可见;1表示很难识别,即图像中文本较小或模糊不清楚。

注:<“文本”>中如果有不清楚的字符,以#表示;如果文本完全不清楚,很难识别(对应<识别难易程度>=1),则以"###"表示。

部分文章介绍和数据集下载链接:

ICDAR2003

paper:ICDAR 2003 Robust Reading Competitions

数据库下载

ICDAR2011

paper:ICDAR 2011 Robust Reading Competition Challenge 2 Reading Text in Scene Images

ICDAR2011官网下载(需要注册, task介绍

ICDAR2013/ICDAR2015-Focus

paper:ICDAR 2013 Robust Reading Competition

paper:ICDAR 2015 Competition on Robust Reading

ICDAR2013官网下载(需要注册)

ICDAR2015-Incidental

paper:ICDAR2015 Competition on Incidental Scene Text Understanding

ICDAR2015官网下载(需要注册)

ICDAR2015比赛

Reading Chinese Text in the Wild(RCTW-17)

该数据集包含12263张图像,训练集8034张,测试集4229张,共11.4GB。大部分图像由手机相机拍摄,含有少量的屏幕截图,图像中包含中文文本与少量英文文本。图像分辨率大小不等。

下载地址

文献

Chinese Text in the Wild(CTW)

数据集介绍:主要包括3万多幅街景图像中注释的3850个独特的中文文本数据集,其中约有100万个汉字。这是一个具有挑战性的数据集,具有良好的多样性,包括平面文本、凸起文本、弱光下文本、远处文本、部分遮挡文本等。

数据集下载链接

Total-Text

该数据集共1555张图像,11459文本行,包含水平文本,倾斜文本,弯曲文本。文件大小441MB。大部分为英文文本,少量中文文本。训练集:1255张 测试集:300

下载地址

[文献](http:// arxiv.org/pdf/1710.10400v)

Caffe-ocr中文合成数据

数据利用中文语料库,通过字体、大小、灰度、模糊、透视、拉伸等变化随机生成,共360万张图片,图像分辨率为280x32,涵盖了汉字、标点、英文、数字共5990个字符。文件大小约为8.6GB

下载地址

Synthetic Data for Text Localisation

在复杂背景下人工合成的自然场景文本数据。包含858750张图像,共7266866个单词实例,28971487个字符,文件大小为41GB。该合成算法,不需要人工标注就可知道文字的label信息和位置信息,可得到大量自然场景文本标注数据。

下载地址

文献

Code(英文版)

Code(中文版1)

Code(中文版2)

MSRA-TD500

MSRA文本检测500数据库(MSRA-TD500)包含500幅自然图像,这些图像是使用袖珍相机从室内(办公室和商场)和室外(街道)场景拍摄的。室内图像以标牌、门牌、警示牌为主,室外图像以复杂背景下的导板、广告牌为主。图像的分辨率从1296x864到1920x1280不等。由于文本的多样性和图像中背景的复杂性,数据集是具有挑战性的。文本有不同的语言(中文、英文或两者的混合)、字体、大小、颜色和方向。背景可能包含植被(如树木和灌木丛)和重复的图案(如窗户和砖块),这些图案与文本没有太大的区别。数据集分为训练集和测试集两部分,训练集包含从原始数据集中随机选择的300个图像,其余200个图像构成测试集,此数据集中的所有图像都已完全注释。

数据集下载链接

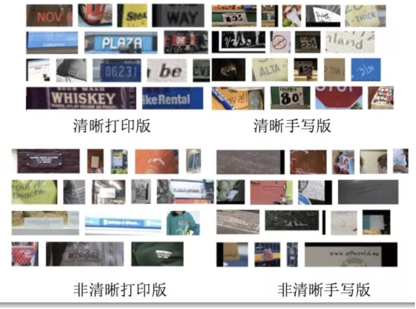

COCO-TEXT

该数据集,包括63686幅图像,173589个文本实例,包括手写版和打印版,清晰版和非清晰版。文件大小12.58GB,训练集:43686张,测试集:10000张,验证集:10000张

文献

下载地址

Google FSNS(谷歌街景文本数据集)

该数据集是从谷歌法国街景图片上获得的一百多万张街道名字标志,每一张包含同一街道标志牌的不同视角,图像大小为600*150,训练集1044868张,验证集16150张,测试集20404张。每个图像包含同一街道名称标志的四个视图。路标上的文字最多可以跨越三行。每一个路标都有一个规范的抄本。

下载地址

[文献](http:// arxiv.org/pdf/1702.03970v1)

SynthText in the Wild dataset

数据集介绍:一个综合生成的数据集,其中单词实例放置在自然场景图像中,同时考虑场景布局。数据集由大约80万个合成词实例的800万个图像组成。每个文本实例都使用其文本字符串、字级和字符级边界框进行注释。

数据集下载链接

Text in Videos

数据集介绍:基于不同的短序列(10秒到1分钟长),通过不同类型的摄像机进行选择,使它们代表广泛的现实生活场景。数据集涵盖不同的脚本和语言(西班牙语、法语、英语),将在每一帧的单词级别提供本地化的基本事实。

数据集下载链接

The Uber Text dataset

数据集介绍:包含了从车载传感器采集的街道级图像和由图像分析团队注释的Ground Truth。

该数据集的特点包括:

(1)街道图像及其文本区域多边形和相应的文本

(2)9个类别表示商业名称文本、街道名称文本和街道编号文本等

(3)一组包含超过110k个图像

(4)平均每个图像4.84个文本实例

数据集下载链接

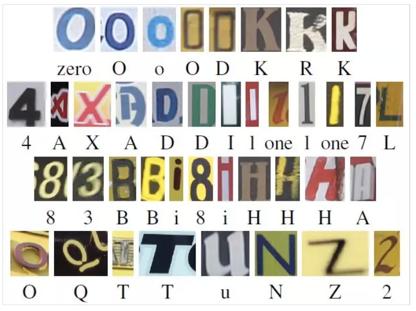

The Chars74K dataset

数据集介绍:

• 包括64类(0-9、A-Z、A-Z)

• 自然图像7705个字符

• 使用平板电脑绘制3410个手写字符

• 62992个计算机字体合成的字符

• 共提供了超过74K个图像(解释了数据集的名称)。

数据集下载链接

参考链接:

https://www.sohu.com/a/224777048_129720

https://blog.csdn.net/u011489887/article/details/79804498

https://mp.weixin.qq.com/s/86UQwumtV0pnAlFhUUvnLA

https://mp.weixin.qq.com/s/P08W5zecG3oghLT6Ip9Xfg

https://www.sohu.com/a/224777048_129720

https://mp.weixin.qq.com/s/UHeZ9BCRDqPO1IvbmPPtaA

https://www.sohu.com/a/212109803_99963310

https://www.cnblogs.com/lillylin/p/6893500.html

https://github.com/JarveeLee/SynthText_Chinese_version

1068

1068

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?